In den letzten Jahren hat die Diskussion um große Sprachmodelle, auch bekannt als LLMs, stark an Fahrt aufgenommen. Von Hypes bis zu tiefgreifenden Ängsten darüber, dass diese Technologien menschliche Arbeitskräfte ersetzen könnten, ist viel die Rede. Dabei wird häufig übersehen, wie LLMs tatsächlich funktionieren und welche Begrenzungen sie besitzen. Es ist an der Zeit, die Fantasie von der Realität zu trennen – insbesondere, wenn es um die Frage geht, ob LLMs Menschen in Berufsfeldern wie Programmierung, Kundenservice oder kreativen Berufen ersetzen können. Um das besser zu verstehen, lohnt sich ein Vergleich mit einer der berühmtesten technischen Illusionen der Geschichte: dem sogenannten Mechanischen Türken aus dem 18.

Jahrhundert. Dieser „Automat“ sollte eine Maschine sein, die selbstständig Schach spielt. Doch tatsächlich befand sich ein menschlicher Schachmeister im Inneren, der den Zug steuerte. Diese Täuschung faszinierte die Menschen damals, weil niemand die Technik dahinter verstand und glauben wollte, was unmöglich schien. Ähnlich verhält es sich heute mit LLMs.

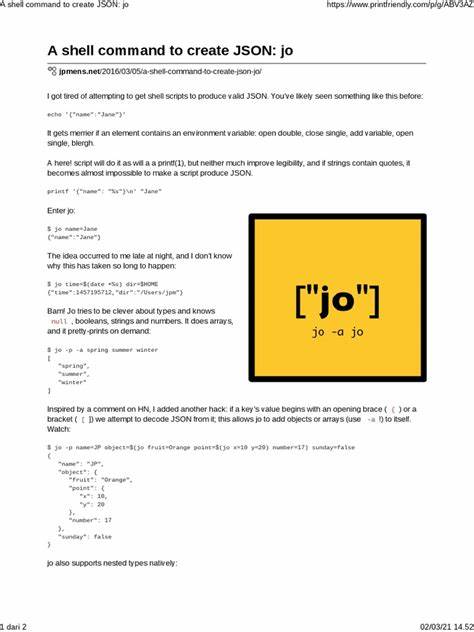

Viele sehen sie als magische Systeme, obwohl sie in Wahrheit auf komplexen, aber doch nachvollziehbaren Algorithmen basieren. LLMs sind im Grunde riesige neuronale Netzwerke, die darauf trainiert sind, Muster in Textdaten zu erkennen und neue Texte zu generieren. Dabei zerlegen sie Eingaben in sogenannte Tokens – keine Wörter, sondern kleinere Bestandteile, die zu Zahlen übersetzt werden. Diese Zahlen werden durch das Netzwerk geleitet, das dann durch statistische Wahrscheinlichkeiten die plausibelste Antwort ermittelt. Das Ergebnis sieht dann für den Nutzer aus, als ob der Computer „versteht“, was gesagt wird, tatsächlich ist es aber nur ein sehr ausgeklügelter Ratespiel-Algorithmus.

Entscheidend ist, dass LLMs kein wirkliches Verständnis von Sprache besitzen. Sie haben keine eigenen Erfahrungen, keine Meinungen und kein Bewusstsein. Sie reagieren ausschließlich auf Muster, die sie in großen Mengen an Textdaten erkannt haben, ohne den Inhalt selbst zu interpretieren. Dies bedeutet auch, dass sie nicht lernen oder sich weiterentwickeln, sobald das Modell trainiert und „eingefroren“ wurde. Anders als Menschen sind sie nicht fähig, kontextbezogen zu denken oder Schlussfolgerungen zu ziehen.

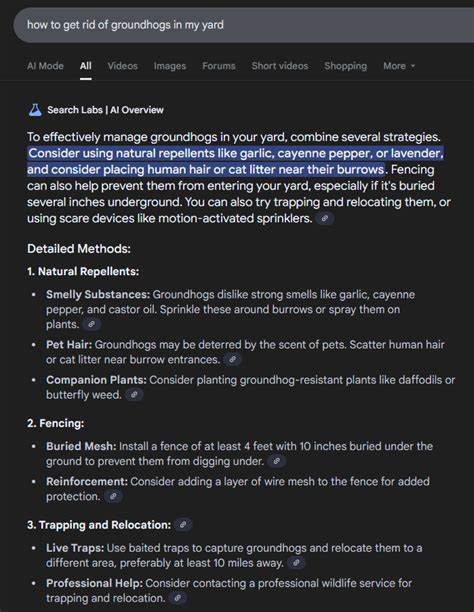

Ein weiterer oft missverstandener Aspekt ist die sogenannte „Randomness“ oder Zufälligkeit, die in LLMs eingebaut ist. Sie ist wichtig, um Antworten abwechslungsreich und natürlich wirken zu lassen. Doch diese zufälligen Elemente können auch zu Fehlern oder sogenannten „Halluzinationen“ führen – bei denen das Modell Fakten falsch darstellt oder unsinnige Antworten gibt. Das erklärt, warum LLMs trotz ihres beeindruckenden Outputs niemals als verlässliche Quelle spotgenauer Informationen gelten können. Aufgrund dieser inhärenten Beschränkungen haben Firmen, die in LLMs investieren, bisher kaum ernsthafte wirtschaftliche Vorteile durch den vollständigen Ersatz menschlicher Arbeit erzielen können.

Studien zeigen, dass der Einsatz von KI-gestützten Chatbots in der Arbeitswelt oft keine messbare Steigerung von Produktivität oder Gewinn bringt. Unternehmen wie Klarna, die versuchten, große Teile ihres Personals durch KI zu ersetzen, mussten ihre Strategie teilweise zurücknehmen, da die Qualität der Arbeit darunter litt. Besonders in komplexen Bereichen wie Programmierung zeigt sich, dass LLMs bestenfalls als Hilfsmittel dienen können. Programmiercode erfordert logisches Denken, Kontextverständnis, die Fähigkeit zur Fehlerbehebung und kreatives Problemlösen – Fähigkeiten, die LLMs schlichtweg fehlen. Sie können Vorschläge machen oder einfache Aufgaben übernehmen, doch das erfordert immer eine qualifizierte menschliche Überwachung und Nachbearbeitung.

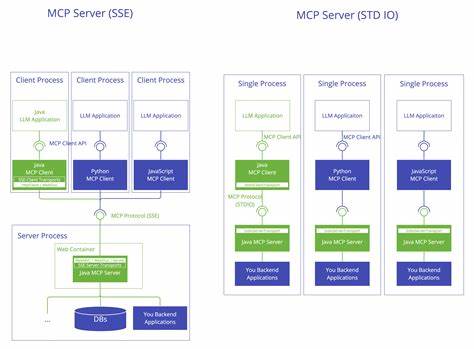

Vermehrt entstehen daher sogenannte Agentensysteme, bei denen mehrere KI-Modelle zusammenarbeiten, um komplexere Aufgaben zu bewältigen. Diese Systeme versuchen, den Output einzelner Modelle zu managen und zu verbessern. Doch auch hier gilt, dass die KI nur basierend auf Wahrscheinlichkeiten arbeitet, was keine absolute Zuverlässigkeit garantiert. Die „Zufälligkeit“ und fehlende echte Intelligenz bleiben zentrale Limitationen. Hinzu kommt die Problematik der Datenqualität, die für das Training der Modelle essenziell ist.

Diese Daten setzen sich meist aus dem öffentlichen Internet zusammen, das zunehmend von KI-generierten Inhalten überschwemmt wird. Dies führt zu einem Phänomen namens „Model Collapse“, bei dem sich Fehler und Ungenauigkeiten in den Trainingsdaten vermehren und die Modelle mit der Zeit an Leistungsfähigkeit verlieren. Die Zukunft der Entwicklung von LLMs hängt deshalb stark davon ab, wie gut es gelingt, qualitativ hochwertige, menschlich erstellte Daten zu sammeln und zu nutzen. Eine oft unterschätzte Komponente sind die menschlichen Arbeitskräfte, die in den letzten Trainingsphasen von LLMs eingesetzt werden. Durch Reinforcement Learning from Human Feedback (RLHF) werden die Modelle anhand menschlicher Bewertungen korrigiert und sozial verträglicher gemacht.

Diese Arbeit, meist von Menschen in kostengünstigen Arbeitsmärkten ausgeführt, ist essentiell, um der KI unangemessene oder gefährliche Antworten zu entziehen. So wie damals der Mechanische Türke ohne einen menschlichen Spieler im Inneren keine Illusion erzeugen konnte, sind auch moderne LLMs ohne menschliche Steuerung nicht in der Lage, zuverlässig zu funktionieren. Für Anwender bedeutet dies, dass der verantwortungsvolle Umgang mit LLMs entscheidend ist. Es gilt, die Technologie als ein Werkzeug zu verstehen, das kreative und kritische menschliche Fähigkeiten ergänzt, aber keineswegs ersetzt. Der Fokus auf kontinuierliches Lernen, kritisches Denken und tiefergehendes Fachwissen bleibt unverzichtbar.

Wer sich nur darauf verlässt, dass eine KI den Großteil der Arbeit erledigt, läuft Gefahr, seine beruflichen Fähigkeiten zu verlieren oder zu degradieren. Zusammenfassend lässt sich sagen, dass große Sprachmodelle beeindruckende technologische Errungenschaften sind, die viele neue Möglichkeiten eröffnen. Doch trotz der Verbreitung und der starken Investitionen in den Bereich bleibt die Vorstellung, LLMs würden den Menschen ersetzen, eine übertriebene Angst. Die Unterschiede zwischen menschlicher Intelligenz und KI sind fundamental. Während Menschen Denken, Lernen und Argumentieren können, basieren LLMs ausschließlich auf Wahrscheinlichkeiten, Mustererkennung und raten – und das auf der Basis historischer Daten, die sie nicht aktiv erweitern können.

Damit besteht kein Grund zur Panik, sondern vielmehr zur Besonnenheit. LLMs werden unsere Arbeitswelt verändern und unterstützen, doch die menschliche Expertise ist und bleibt essentiell. Die Zukunft gehört denen, die ihre Fähigkeit zur Problemlösung, zum kritischen Denken und zur kreativen Anwendung von Wissen weiterentwickeln – und LLMs als hilfreiche, aber begrenzte Werkzeuge verstehen. Abschließend ist es wichtig, die Faszination für neue Technologien mit gesundem Skeptizismus und fundiertem Wissen zu verbinden. Nur so lässt sich das volle Potenzial von LLMs sinnvoll nutzen – ohne die Illusion zu verfolgen, Maschinen könnten den Menschen vollständig ersetzen.

Die „magische“ KI der Gegenwart zeigt uns vor allem eines: Menschliche Intelligenz bleibt unersetzlich.