Die rasante Entwicklung künstlicher Intelligenz (KI) hat in den letzten Jahren zahlreiche innovative Konzepte hervorgebracht, die das Spielfeld der Softwareentwicklung neu definieren. „Lambda the Ultimate AI Agent“ ist eines dieser bahnbrechenden Konzepte, das den Umgang mit Agenten und Tools in KI-Systemen grundlegend hinterfragt und neu interpretiert. Anstatt Agenten und Tool-Calls lediglich als einfache Funktionseinheiten zu betrachten, schlägt dieser Ansatz vor, die Interaktion als ein Verhältnis zwischen Programmierern und Programmfragmenten zu verstehen. Dieses Paradigma verschiebt den Fokus hin zu einem flexibleren, leistungsfähigeren Design, das die offensichtlichen Schwächen traditioneller Agent-Strukturen adressiert und eine erweiterte Entwicklererfahrung (DX) anbietet. Historische Wurzeln und Inspirationsquelle Der Titel baut auf einer Tradition wissenschaftlicher Arbeiten auf, die auf den Informatik-Pionieren Gerald Sussman und Guy Steele zurückgeht.

In den 1970er und 1980er Jahren veröffentlichten sie Studien, die mithilfe des Lambda-Kalküls – einem universellen Modell für Berechnung – Probleme der Programmierung wie Nebenwirkungen, Subroutinen oder deklarative Programmierparadigmen elegant erklärten. Ihre Arbeiten prägten das Verständnis dafür, wie scheinbar komplizierte Programmiermuster als Varianten fundamentaler mathematischer Strukturen interpretiert werden können. „Lambda the Ultimate“ wurde so zum Synonym für Forschungen, die bestehende Programmierparadigmen durch die Brille des Lambda-Kalküls kritisch hinterfragen und weiterentwickeln. Im Kontext der modernen KI-Entwicklung nimmt das Konzept „Lambda the Ultimate AI Agent“ diese Tradition auf, um die oft verwirrenden Elemente von Agenten und deren Werkzeugaufrufen (Tool Calls) verständlicher und effektiver zu gestalten. Es zielt darauf ab, die Logik dahinter neu zu definieren und zeigt auf, wie diese Umdeutung zu deutlich verbesserten Modellen für agentenbasierte KI-Systeme führen kann.

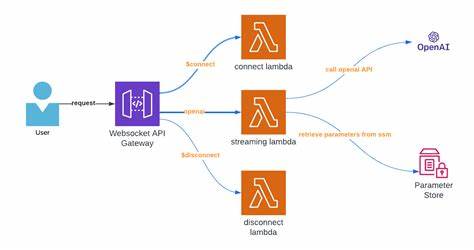

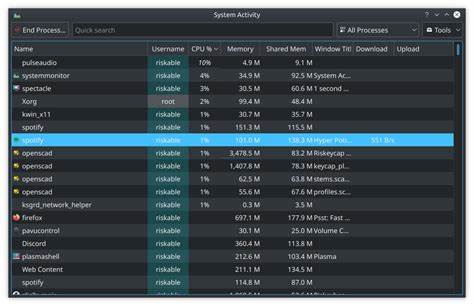

Die Herausforderung traditioneller Tool Calls In der Praxis haben Entwickler, die erste Erfahrungen mit Agenten-basierten Anwendungen sammeln, oft Schwierigkeiten, die Architektur hinter Tool Calls korrekt zu verstehen. Üblicherweise formuliert ein Entwickler eine Liste verfügbarer Tools, definiert deren Parameter und Rückgabetypen und entwickelt dann eine Art Prompt für das Large Language Model (LLM), das entscheidet, welches Tool als nächstes im Zusammenhang mit dem aktuellen Anwendungsstatus aufgerufen werden soll. Die eigentliche Ausführung erfolgt dann in einer sogenannten While-Schleife, die wiederholt das LLM befragt, ein Tool auswählt, dieses ausführt, und die erhaltenen Ergebnisse einem Protokoll hinzufügt. Das Ganze läuft so lange, bis das LLM signalisiert, dass keine weiteren Calls notwendig sind. Diese Struktur ist zunächst intuitiv, führt jedoch zu einem Blob von Boilerplate-Code, der nicht nur den entwicklerseitigen Aufwand erhöht, sondern auch schwer zu warten und zu erweitern ist.

Insbesondere die Aufteilung in zahlreiche einzelne Tool-Aufrufe sorgt für eine fragmentierte Programmlogik. Entwickler empfinden die manuelle Orchestrierung in der While-Schleife als unnatürlich, da klassische Programmiertechniken wie Funktionsaufrufe und Verkettung von Zwischenergebnissen hier nicht adäquat abgebildet werden können. Die Kehrseite klassischer Tool-Ansätze zeigt sich auch im mangelnden Kompositionsvermögen der Aufrufe. Im Gegensatz zu klassischen Remote Procedure Calls (RPC), bei denen Funktionen klar abgegrenzt, typisiert und direkt verkettet werden können, stehen bei Tool Calls nur sequenzielle Logs mit abwechselnden Befehlen und Ergebnissen zur Verfügung. Diese Form der „defunktionalisierten“ Kommunikation führt zu einem Verlust an Ausdruckskraft und Zuverlässigkeit.

Agenten als Programmierer verstehen Um die beschriebenen Herausforderungen zu bewältigen, schlägt das Konzept von „Lambda the Ultimate AI Agent“ vor, Agenten nicht als einfache Ausführungsprogramme zu betrachten, sondern als eigenständige Programmierer, die Programmfragmente – also Tools – intelligent zusammenfügen. Diese Metapher hilft, die Architektur von Agenten neu auszurichten und eröffnet Möglichkeiten, komplexere und flexiblere Steuerungsmodelle für KI-Agenten zu entwerfen. In diesem Sinne entsprechen Tool Calls klassischen RPCs, und der Agent wirkt wie ein Programmierer, der über ein Netzwerk verteilte Funktionen orchestriert. Die bisher übliche While-Schleife wird zur Laufzeitumgebung, und die Kontextliste der bisherigen Tool-Aufrufe bildet eine Art Variablen-Stack ab. Das Fehlen echter Variablenbindung oder Funktionsdefinitionen im Agentic System zeigt den Nachholbedarf im Programmiermodell auf.

Indem man diese Analogie weiterdenkt, wird deutlich, dass die bisherige Agenten-Lösung eigentlich eine rudimentäre, teilweise unkomfortable Schnittstelle für eine komplexere Programmierung darstellt. Entwickler verbringen viel Zeit mit der Implementierung von Infrastrukturkomponenten, anstatt sich auf die Geschäftslogik zu konzentrieren. Würden Agenten aber in der Lage sein, ganze Programmfragmente zu schreiben und auszuführen, könnte diese Last verringert werden. Erweiterte Tools als Programmfragmente Im Gegensatz zu isolierten Einzelschritten könnten komplexe Tool-Typen geschaffen werden, die wiederum andere Tools zusammensetzen können. Diese „Compound Tools“ erlauben es, ganze Workflows und Abläufe als eigenständige Programme innerhalb der Agentenstruktur abzubilden.

Damit wird die Steuerung weit flexibler und das Programmiermodell deutlich mächtiger. Beispielsweise könnte ein Agent Werkzeuge zur Verfügung haben, die Wetterdaten abrufen, Termine planen, Dokumente suchen oder Nachrichten senden. Anstatt jeden dieser Schritte einzeln via LLM aufrufen zu müssen, könnten zusammengesetzte Werkzeuge Sequenzen dieser Einzelschritte abbilden, sie iterieren, auswerten und sogar Variablen zuweisen. So entstehen Werkzeuge wie eine Sequenzfunktion, eine Iterationsfunktion oder eine Zuweisungsfunktion – allesamt Elemente, die den Unterschied zwischen einem einfachen RPC-Aufruf und einem echten Programm ausmachen. Diese Art der Komposition entfernt den menschlichen Entwickler aus der heißen Schleife, in der der Agent ständig neu entscheiden und starten muss.

Stattdessen kann der Agent Fortgeschrittenes planen, implementieren und ausführen, ohne bei jedem Zwischenschritt menschliches Eingreifen oder neue Kontextprüfungen zu benötigen. Die Frage der Modellfähigkeit Ein möglicher Einwand gegen diese Erweiterung ist die Frage, ob moderne LLMs überhaupt die nötige Fähigkeit besitzen, um komplexe Programme als zusammenhängende Werkzeuge zu schreiben und zu orchestrieren. Schließlich erfordert dies umfassendere Fähigkeit zur strukturierten Ausgabe, logischem Denken und Programmieren als einfache Einzelschritte. Erste Experimente geben jedoch Anlass zur Hoffnung. Tests mit zwei- oder mehrstufigen Planungsaufgaben zeigten, dass aktuelle Modelle durchaus in der Lage sind, mehrschichtige Programmelsätze zu generieren und koordiniert einzusetzen.

So konnten multifunktionale Meetingplanungen erfolgreich automatisiert und sogar generalisiert umgesetzt werden. Die nächsten Herausforderungen werden vor allem in der Entwicklung geeigneter Benchmarks und Testverfahren bestehen, um die Qualität und Zuverlässigkeit solch komplexer Tool-Kompositionen systematisch zu messen. Außerdem ist die Benutzerführung durch Typprüfungen und syntaktische Korrekturen ein wichtiger Aspekt, damit Agenten iterativ bessere Programme erzeugen und ausführen können. Konsequenzen und Ausblick Die Abbildung des Agenten als Programmierer und der Tools als Programmfragmente stellt eine fundamentale Verschiebung im Denken über Agenten und KI-Systeme dar. Sie eröffnet Wege, den Entwicklungsprozess für AI-gesteuerte Anwendungen grundlegend zu verbessern und die Entwicklererfahrung auf ein neues Level zu heben.

Im Kern bedeutet dies, ein besseres, ausdrucksstärkeres Domain-Specific Language (DSL) für Agenten zu schaffen. Dies würde nicht nur die Effizienz und Zuverlässigkeit der Systeme steigern, sondern auch die Komplexität beherrschbar machen und das volle Potential moderner KI-Modelle ausschöpfen. Zudem erlaubt ein solcher Ansatz, den Agent programmatisch zu entlasten, indem komplexe Abläufe ohne ständige Rückkopplungsschleifen autonom ausgeführt werden können. Die iterative Werkzeugentwicklung mit Linting, Typprüfung und Fehlermeldungen trägt dazu bei, dass Agents lernen, stabilere und effektive Programme zu schreiben. Letztlich handelt es sich hierbei nicht nur um technische Neuerungen.

Es ist auch ein Aufruf zur Diskussion darüber, wie die zukünftige Zusammenarbeit zwischen menschlichen Entwicklern und KI-Agenten aussehen kann. Welche Hilfsmittel sind optimal, um AIX – die Developer Experience für künstliche Intelligenzen – zu gestalten? Wie viel latentes Potenzial in aktuellen LLMs kann so gehoben werden? Diese und weitere Fragen stehen im Zentrum zukünftiger Forschungen und Entwicklungen. Die Vision von „Lambda the Ultimate AI Agent“ ist damit keineswegs abgeschlossen, sondern lädt Entwickler, Forscher und Unternehmen ein, gemeinsam an der Evolution intelligenter, flexibler und effektiver Agentensysteme mitzuwirken und so den nächsten Schritt in der KI-Entwicklung zu gestalten.