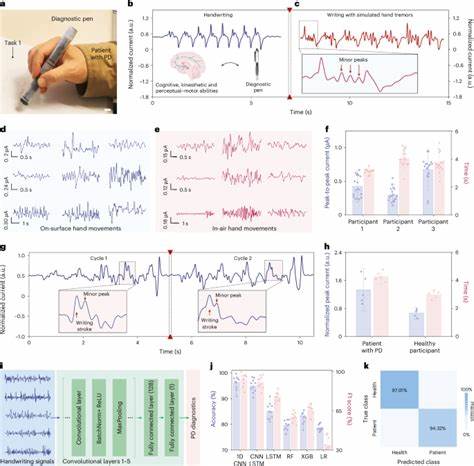

Im Verlauf der letzten Jahre hat der Einsatz von künstlicher Intelligenz (KI) in verschiedenen Bereichen der Regierungsarbeit zugenommen – so auch bei der Überprüfung von Verträgen innerhalb des US-amerikanischen Department of Veterans Affairs (VA). Unter der Trump-Administration initiierte das Department of Government Efficiency (DOGE) ein Projekt, mit dessen Hilfe ein KI-basiertes System kritisch für die restriktive Überprüfung von Verträgen im Gesundheitswesen von Veteranen eingesetzt werden sollte. Die Idee dahinter war, ineffiziente, vermeidbare oder „weiche“ Dienstleistungen zu identifizieren, um die Budgets zu kürzen und den Fokus auf direkte, patientenorientierte Pflege zu legen. Was jedoch folgte, war eine Reihe von Fehlern und Fehlinterpretationen, die tiefgreifende Auswirkungen auf die Versorgung und Unterstützung von Veteranen haben könnten. Dieses KI-System – liebevoll als „Munching“-Tool bezeichnet, da es Verträge automatisch als „munchable“, also zum Wegstreichen bestimmt, klassifizierte – beruhte auf einer Reihe von Problemfeldern, die sowohl technischer als auch konzeptioneller Natur waren.

Eines der größten Probleme war, dass die verwendeten Sprachmodelle veraltet waren und die Komplexität der Verträge und der entsprechenden medizinischen Dienste schlichtweg nicht bewältigen konnten. Die KI bekam widersprüchliche und unzureichende Anweisungen, was als „direkt unterstützende Patientenversorgung“ zu gelten hat und was nicht. So führte die Ambiguität in den Eingabeprompts dazu, dass wichtige Verträge, die beispielsweise Internetdienste für Veteranen oder relevante IT-Infrastruktur betrafen, fälschlicherweise als unnötig aussortiert wurden. Ein zentraler Schwachpunkt lag darin, dass die KI lediglich die ersten 10.000 Zeichen der Verträge analysierte, was bei Dokumenten, die oft umfangreiche Ergänzungen und Details enthalten, nicht ansatzweise ausreichte.

Diese Limitierung führte dazu, dass wesentliche Informationen über die Bedeutung oder den Umfang von Verträgen verloren gingen und die Maschine oft „halluzinierte“ – also falsche oder aus dem Kontext gerissene Zahlen und Angaben erfand, wie zum Beispiel fälschlicherweise veranschlagte Milliardenwerte für kleinere Verträge. Die Konzeption des Systems enthielt außerdem politische Voreinstellungen. So wurden Verträge, die mit Diversity-, Equity- und Inclusion-Initiativen (DEI) zusammenhingen, grundsätzlich als zu streichend angesehen, ohne dass klare Definitionen oder eine fundierte Prüfung der tatsächlichen Bedeutung dieser Projekte erfolgte. Dies spiegelte den politischen Willen der damaligen Regierung wider, DEI-Maßnahmen abzuschaffen, aber ohne die nötige Transparenz und Fakten- basierte Entscheidungsprozesse, die für die komplexe Verwaltung solcher Programme notwendig sind. Experten kritisierten, dass das KI-Modell keine verlässlichen Bewertungsgrundlagen hatte, um zwischen unverzichtbaren und austauschbaren Dienstleistungen trennen zu können.

Darüber hinaus wurden viele Verträge, die administrative und unterstützende Tätigkeiten betrafen, in einen Topf mit nicht wesentlichen Dienstleistungen geworfen. Dies reichte von medizinischer Technologieverwaltung bis zu Datenmanagement, von Büroverwaltungsfunktionen bis zu IT-Support. Viele dieser Dienstleistungen sind zwar nicht direkt am Patientenbett angesiedelt, sind aber essenziell, um eine effiziente und funktionierende Gesundheitsversorgung zu gewährleisten. Die einseitige Sichtweise, dass solche „Soft Services“ leicht intern durch Verwaltungsangestellte ersetzt werden könnten, ignorierte, dass die VA oft unter erheblichem Personalmangel und strengen Hiring-Freezes litt. Ein besonderes Beispiel dafür ist die Kennzeichnung von Verträgen für die Wartung lebenswichtiger technischer Geräte wie Deckenlifte, die dazu dienen, Patienten sicher zu positionieren.

Obwohl die KI erkannte, dass diese Wartung wichtig für die Sicherheit von Patienten und Mitarbeitern ist, klassifizierte sie derartige Verträge dennoch fälschlich als „munchable“. Diese Fehleinschätzungen zeigen die enorme Gefährdung, die durch inadäquate KI-Anwendungen in sensiblen Bereichen der öffentlichen Versorgung entstehen kann. Offenbar wurde der gesamte Prozess sehr schnell und unter Zeitdruck umgesetzt. Die Trump-Regierung forderte eine Überprüfung aller VA-Verträge innerhalb kurzer Fristen, was zu einem hektischen Einsatz der Technologie führte. Der verantwortliche Entwickler selbst räumte Fehler durch Zeitmangel sowie unzureichende Werkzeuge und Kenntnis über die Komplexität der Materie ein.

Die Vorstellung, dass eine solche KI-Lösung die endgültigen Entscheidungen treffen sollte, wurde durch eine zumindest theoretische Kontrolle durch Fachpersonal relativiert, doch die Gefahr von Fehlstreichungen war dennoch erheblich. Die Kritik von Experten an dem Vorhaben war vielschichtig. Zum einen wurde bemängelt, dass veraltete, allgemeine Sprachmodelle verwendet wurden, die nicht auf die speziellen Anforderungen des Gesundheitswesens im Veteranenkontext zugeschnitten waren. Zum anderen wurden die zugrundeliegenden Definitionen und Kriterien als viel zu vage und uneindeutig empfunden, was zu einer fehleranfälligen Automatisierung führte. Die Nutzung der KI für eine so wichtige Aufgabe ohne angemessene Daten, kontextuelles Wissen und Transparenz wurde als „fauler Weg“ der Informationsbeschaffung bezeichnet, der Geschwindigkeit dem korrekten Ergebnis vorzieht.

Darüber hinaus fehlt der KI das notwendige tiefergehende Verständnis, um komplexe Entscheidungen zu den Bedürfnissen von Veteranen, medizinischer Versorgung und notwendigen Verwaltungsstrukturen treffen zu können. Die KI ist nicht in der Lage, die institutionellen und personellen Gegebenheiten der VA zu bewerten oder den Einfluss von Kürzungen auf die Versorgung realistisch abzuschätzen. Dieses Missverhältnis zwischen technischen Möglichkeiten und inhaltlicher Tiefe zieht sich wie ein roter Faden durch das gesamte Projekt. Trotzdem steht das VA hinter dem Einsatz von KI und sieht in dieser Herangehensweise eine richtungsweisende und „gesunden Menschenverstand“ verkörpernde Methode. Es wird aktiv nach weiteren Einsatzgebieten der KI zur Verbesserung von Bearbeitungszeiten für Veteranenansprüche gesucht – ein Bereich, in dem teilweise bereits kleine Erfolge verbucht werden konnten.

Dennoch stellen ethische, rechtliche und fachliche Fragen nach Kontrolle, Verlässlichkeit und Menschlichkeit der Automatisierung im staatlichen Kontext weiterhin eine große Herausforderung dar. Insgesamt zeigt der Fall DOGE und des AI-Prompts zur „Munch“-Analyse von Veteranenverträgen exemplarisch die Risiken, die durch die unreflektierte und schlecht vorbereitete Einführung künstlicher Intelligenz in sensiblen Bereichen der öffentlichen Verwaltung entstehen können. Die negativen Folgen reichen von Fehlentscheidungen und Gefährdung wichtiger Versorgungsleistungen bis zur politischen Instrumentalisierung technischer Werkzeuge zur Durchsetzung ideologischer Ziele. Die öffentliche Debatte und die Forderungen von Senatoren nach Transparenz und Verantwortlichkeit sind deshalb mehr als berechtigt. Es braucht dringend eine klare Regulierung, umfassende Tests und fundierte Kontrolle bei der Anwendung von KI in Regierung und Verwaltung, insbesondere in so wichtigen Feldern wie dem Gesundheitswesen für Veteranen.