Im Zeitalter der Künstlichen Intelligenz dominieren Schlagworte wie Sprachmodelle, Fine-Tuning und Open-Source-Funktionalitäten die Diskussionen. Während jeder über neue, smarte AI-Agenten spricht, die nahtlos Funktionen ausführen können, bleibt ein entscheidender Faktor häufig unbeachtet: die Datensatzvorbereitung. Obwohl dieser Prozess auf den ersten Blick langweilig und unspektakulär erscheinen mag, ist er doch das Fundament, auf dem jedes erfolgreiche Funktionstooling basiert. Die Qualität und Struktur der Trainingsdaten bestimmen maßgeblich, wie performant und verlässlich ein KI-System funktioniert. Gerade im Bereich der Funktionserkennung und -ausführung trennt sich hier die Spreu vom Weizen.

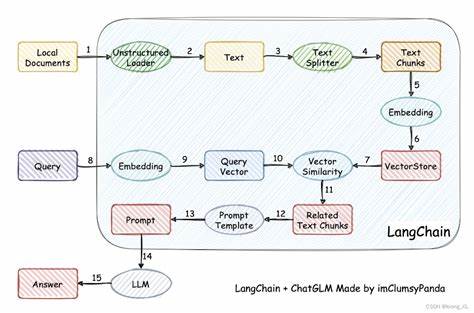

Funktionstooling ist kein bloßes Abrufen von Informationen aus Kontexten, sondern ein komplexes Zusammenspiel von Interpretation, logischem Schlussfolgern und strukturiertem Verhalten. Während viele Entwickler versuchen, mittels Retrieval-Augmented Generation (RAG) erste einfache Lösungen zu kreieren, zeigen Erfahrungen und Untersuchungen, dass RAG für funktionale Aufgaben an seine Grenzen stößt. Ein RAG-basiertes System kann zwar schnell Antworten aus existierendem Wissen zusammenstellen, scheitert jedoch oft daran, komplexe Funktionen zuverlässig auszuführen oder die richtigen Parameter zu übergeben. Hier setzt Fine-Tuning an, das sich jedoch nicht ohne solide Datengrundlage realisieren lässt. Eine aktuelle Studie zeigt, dass mehr als 70 Prozent der Unternehmen verstärkt auf Fine-Tuning zurückgreifen, statt sich auf RAG oder gar vollständige Neuentwicklungen zu verlassen.

Die Menge an benötigten Trainingsbeispielen variiert hier stark und hängt vom jeweiligen Ziel ab. Beispielsweise benötigt eine domänenspezifische Anpassung erheblich mehr Daten als ein rein aufgabenbezogenes Feintuning. Bei Funktionstooling sind 10.000 bis 100.000 sorgfältig strukturierte und qualitativ hochwertige Beispiele essenziell, um ein KI-Modell zu befähigen, natürliche Sprachbefehle in zuverlässige Funktionsaufrufe umzuwandeln.

Der Einstieg in die Datensatzvorbereitung sollte niemals mit Code beginnen. Vielmehr steht die klare Definition des Problems und der gewünschten Systemfunktion im Fokus. Die Frage, welche Aufgaben der KI-Agent lösen soll, bestimmt die Auswahl und Gestaltung der Daten. Ein Beispiel: Ein Kundenservice-Bot, der einfache FAQs beantwortet, kann mit RAG gut bedient werden. Soll der Agent jedoch komplexe Aktionen auf einem Gerät ausführen, wie Mikrofon stummschalten oder Kalender öffnen, ist Fine-Tuning mit einem maßgeschneiderten Datensatz oft unumgänglich.

Der erste Schritt in der Datensatzentwicklung ist die Definition der Funktionsbibliothek. Diese Bibliothek bildet das Herzstück des Systems und besteht nicht nur aus einfachen JSON-Beschreibungen, sondern aus klar formulierten, ausführbaren Funktionen. Jede Funktion benötigt einen eindeutigen Namen, eine verständliche Beschreibung, eine Liste von Parametern mit Typangaben, Beispielwerte für diese Parameter und naturalsprachliche Vorlagen, wie Benutzer diese Funktion anfragen könnten. Die sorgfältige Abbildung dieser Funktionen und deren Eigenschaften dient mehreren Zwecken. Zum einen ermöglicht sie die automatisierte Erstellung von Trainingsdaten durch Variationen der Vorlagen.

Zum anderen fungiert sie als Referenz für die KI, um semantisch korrekte und strukturierte Funktionsaufrufe zu erstellen. Solche Definitionen bilden die Brücke zwischen Benutzeranfrage und maschinenlesbarem Code. Nach der Funktionsdefinition folgt die Erzeugung des Datensatzes, wobei die Qualität der Beispiele über reine Quantität entscheidet. Anfangs werden einfache, einzelfunktionale Beispiele generiert, die das Basisverhalten des Agenten abbilden. Diese Beispiele entstehen durch das Kombinieren der Vorlagen mit den entsprechenden Parameterwerten.

Sie sind essenziell für das Modellverständnis der einzelnen Funktion. Im nächsten Schritt steigt die Komplexität durch Mehrfach-Funktionsbeispiele. Dies simuliert reale Szenarien, in denen ein Nutzer mehrere Aktionen in einer Anweisung kombiniert. Der KI wird hier vermittelt, wie sie komplexere Absichten zergliedert und mehrere Funktionen korrekt ausführt. Die Erstellung solcher Beispiele erfolgt mittels spezieller Prompting-Techniken, bei denen große Sprachmodelle natürliche und kohärente Kommandos generieren, die anschließend verifiziert werden.

Ebenso wichtig ist die Einführung von Beispielen mit unbekannten oder nicht unterstützten Anfragen. Diese negativen Beispiele lehren das Modell, wann es keine Aktion ausführen soll, um gefährliche Fehlreaktionen oder Halluzinationen von Funktionsaufrufen zu vermeiden. Durch diese Abgrenzung wird die Verlässlichkeit im produktiven Einsatz enorm gesteigert. Ein weiteres kraftvolles Instrument ist das Paraphrasieren der User-Anfragen. Menschliche Sprache ist vielschichtig und vielfältig.

Um ein KI-System robuster gegen Variationen und unterschiedliche Formulierungen zu machen, werden Datensätze so erweitert, dass dieselbe Funktion in vielen unterschiedlichen Varianten abgefragt wird, ohne die zugrundeliegende Bedeutung zu verändern. Dies geschieht durch gezieltes Umschreiben mit Hilfe von großen Sprachmodellen, die semantisch identische, aber sprachlich verschiedene Versionen erstellen. Doch erst die Verifikation setzt den Standard für Qualität. Ein Datensatz muss nicht nur formal korrekt sein, sondern auch inhaltlich und strukturell einwandfreie Beispiele enthalten. Dies umfasst umfassende Prüfungen auf doppelte Einträge mittels semantischer Ähnlichkeitsalgorithmen, Schemavalidierungen und vor allem die tatsächliche Ausführung der Funktionsaufrufe in einer kontrollierten Umgebung.

Nur so kann verhindert werden, dass das Modell Fehler erlernt, die zu Fehlfunktionen führen. Neben der Datengenerierung und -validierung gewinnt das Management der Datensätze zunehmend an Bedeutung. Daten entwickeln sich weiter. Neue Tools, veränderte Anforderungen oder Verbesserungen in der Datenqualität führen zu unterschiedlichen Versionen. Ein solides Versionierungssystem mit Metadaten zu Modell-Versionen, Zeitpunkten und Veränderungen ist essenziell, um Nachvollziehbarkeit, Transparenz und Kontrollmöglichkeiten zu garantieren.

So lassen sich regressionsbedingte Fehler schnell identifizieren und gegebenenfalls zurückgenommen. Auch die Kostenkontrolle ist ein nicht zu vernachlässigender Aspekt. Die Erzeugung synthetischer Trainingsdaten mit großen Sprachmodellen schlägt finanziell zu Buche. Eine genaue Erfassung des Tokenverbrauchs und der damit verbundenen Kosten ermöglicht eine effiziente Ressourcenplanung und stellt sicher, dass das Projektbudget nicht unkontrolliert überschritten wird. Abschließend spielt das Monitoring der Datenqualität eine zentrale Rolle für die langfristige Zuverlässigkeit des Systems.

Indikatoren zur Datengesundheit, darunter Diversität, Abdeckung und Fehlerquoten, geben Aufschluss über den aktuellen Zustand des Datensatzes und zeigen Handlungsbedarf auf. Eine Automatisierung dieser Messungen unterstützt bei der kontinuierlichen Qualitätskontrolle und erleichtert Updates und Erweiterungen. Die vermeintlich langweilige Datensatzvorbereitung ist damit das eigentlich harte Herzstück vieler moderner KI-Anwendungen. Sie entscheidet darüber, ob ein System nur gut klingt oder tatsächlich zuverlässig funktioniert. Erfolgreiches Funktionstooling beruht auf einem tiefgreifenden Verständnis der Zielaufgaben, einer sorgfältigen Planung und Ausführung der Datengenerierung sowie einem stringenten Qualitätssicherungsprozess.

Insgesamt ist die Arbeit mit hochwertigen, exakt abgestimmten Trainingsdatensätzen kein einfacher Job, aber unverzichtbar auf dem Weg zu robusten und realistisch einsetzbaren KI-Agenten. Der Aufwand lohnt sich, denn nur so wird aus sprachlichen Anfragen echte Aktion, und aus einem Modell ein hilfreicher Begleiter im Alltag, der komplexe Aufgaben auf dem Gerät oder in der Cloud mühelos bewältigt.