Große Sprachmodelle, auch bekannt als Large Language Models (LLMs), revolutionieren seit Jahren die Art und Weise, wie Maschinen menschliche Sprache verstehen und generieren. Im Mittelpunkt dieser Modelle steht die Fähigkeit, aus einer gegebenen Eingabe sogenannte Logits zu erzeugen – Vektoren, die als Grundlage für die Wahrscheinlichkeitsverteilung über die nächste mögliche Token-Generation dienen. Trotz der Bedeutung der Logits fehlt häufig eine klare geometrische oder analytische Beschreibung, die das Spektrum aller möglichen Ausgaben eines Modells einschließt. Das Konzept der Geometrie von LLM-Logits schafft hier Abhilfe und zeigt, wie man ein äußeres analytisches Bound, einen sogenannten Außenbereich, definieren kann, der alle erreichbaren Logit-Vektoren umfasst. Dabei wird ein innovativer geometrischer Rahmen namens Ellipsotope vorgestellt, der auf der Minkowski-Summe von Ellipsoiden basiert und damit die Struktur der Logits in einem hohen dimensionalen Raum präzise beschreibt.

Die Ausgangsbasis für das Verständnis der Logit-Geometrie ist die Residual-Stream-Repräsentation innerhalb von Transformer-Architekturen. Jeder Transformer-Block modifiziert einen Vektor im so genannten Residualstrom, der die Informationen durch die Schichten des Modells trägt. Die Dimension dieses Vektorraums, üblicherweise als d bezeichnet, bestimmt die Breite des Residualstroms, während die Anzahl der Transformer-Blöcke mit L bezeichnet wird. Am Ende des letzten Blocks wird die Summe dieser Updates durch eine affine Abbildung – bestehend aus einer Multiplikation mit einer sogenannte un-embedding Matrix WU und Hinzufügen eines Bias-Vektors b – in den Logit-Raum der Vokabulargröße V transformiert. Das bedeutet, dass die Logits in einem V-dimensionalen Raum leben, was sie zu Vektoren großer Komplexität macht, die jedoch einer klar definierten geometrischen Form unterliegen.

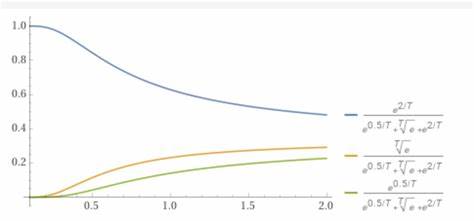

Eine zentrale Erkenntnis ist, dass jeder Update-Vektor, der von einem einzelnen Transformer-Block erzeugt wird, innerhalb eines Ellipsoids liegt – einer symmetrischen, abgeflachten Kugelform in einem mehrdimensionalen Raum. Diese Ellipsoide entstehen durch die Wirkung von LayerNorm und Lipschitz-stetigen Nichtlinearitäten wie GELU oder SiLU, die eine obere Schranke für die Normen der Updates garantieren. Man kann sich das als eine Form von geometrischer Beschränkung vorstellen, die definiert, wie weit ein Block die Repräsentation im Residualstrom nach jeder Transformation verschieben darf. Die Größe und Form dieser Ellipsoide hängen dabei von lernbaren Parametern ab, die in jedem Block unterschiedlich sein können und die natürliche Balancierung und Skalierung des Informationenflusses im Modell widerspiegeln. Wichtig ist, dass aufgrund der additiven Natur der Residual-Verbindungen die Gesamtsumme der Updates über alle L Blöcke in der Minkowski-Summe dieser Ellipsoide liegt.

Die Minkowski-Summe kann man als eine geometrische Operation auffassen, die die Formen der einzelnen Ellipsoide zu einer neuen, komplexeren Form zusammenfügt. Dadurch entsteht ein Gesamtbereich, in dem der finale Residualstrom vor der letzten linearen Transformation liegt. Das ist eine elegante und mächtige Weise, die Gesamtheit aller möglichen Modellzustände in einem geometrischen Objekt zu beschreiben, welches alle realisierbaren Ausgaben innerhalb der Modellarchitektur einschließt. Die Transformation des Residualstroms in den Logit-Raum wird durch eine affine Abbildung vollzogen, welche die Ellipsoide wiederum in Ellipsoide abbildet. Dies folgt aus der Eigenschaft, dass lineare Bilder von Ellipsoiden ebenfalls Ellipsoide sind.

Die Summe dieser transformierten Ellipsoide bildet das geometrische Objekt, welches als Ellipsotop bezeichnet wird. Ein Ellipsotop ist ein affine Verschiebung einer Minkowski-Summe von Ellipsoiden und stellt den analytischen Außenbereich aller erreichbaren Logitvektoren dar. Damit existiert ein konvexes, zentrosymmetrisches Set, das alle möglichen Modelloutputs umfasst, aber theoretisch auch Punkte enthält, die nicht zwangsläufig durch echte Eingabeaufforderungen erreicht werden. Dieses Konzept des Ellipsotops als äußeres Bound hat weitreichende Implikationen. Zum einen bietet es eine Grundlage für geometrie-basierte Kompressionstechniken und Robustheitszertifikate.

Durch die Approximation des Ellipsotops mit einem minimalen Volumen beschreibenden Außenellipsoid lassen sich strenge Norm-basierte Regularisierer entwickeln, die helfen, Modelle gegen Gewichtstransformationen wie Rauschen oder Quantisierung zu stabilisieren. Solche Sicherheitseigenschaften sind besonders relevant, wenn LLMs in sicherheitskritischen Anwendungen eingesetzt werden oder wenn Modelle effizienter und mit geringerem Ressourcenverbrauch betrieben werden sollen. Des Weiteren erlaubt die Zerlegung des Gesamtbereichs in einzelne Ellipsoide je Transformer-Block eine tiefere Layer-Analyse. Man kann genau quantifizieren, welchen Einfluss ein bestimmter Block oder eine bestimmte Schicht auf die Veränderung der Logits hat. Dies ergänzt bestehende Interpretationsmethoden wie Logit-Lens-Analysen und eröffnet neue Wege, um Transformer-Modelle Schritt für Schritt zu verstehen und deren Funktionsweise transparent zu machen.

Die Annahmen hinter diesem Modell sind keineswegs trivial. Die Festlegung auf pre- oder peri-norm Transformermodelle stellt sicher, dass LayerNorm-Anwendungen eine normative Kontrolle über die Eingabevectoren garantieren, was eine Voraussetzung für endliche Schranken in der Update-Größe ist. Die Verwendung von Lipschitz-stetigen Aktivierungen unterstützt die Existenz dieser Grenzen, wobei nicht notwendigerweise eine Schranke für die Aktivierungen selbst vorausgesetzt wird. Modelle, die derartige Normkontrollen nicht implementieren, müssten mit alternativen Methoden untersucht werden. Zusammenfassend schafft die geometrische Analyse der LLM-Logits einen neuen analytischen Rahmen, der komplexe Zusammenhänge im Verhalten von Transformer-Modellen verständlich und greifbar macht.

Dieses Modell liefert nicht nur theoretische Grenzen und Beschreibungen, sondern öffnet auch Türen zu praktischen Anwendungen in Modellkompression, Robustheit und Layer-Interpretation. Zukünftige Forschungsarbeiten könnten sich damit befassen, die Frage der Gleichheit zwischen der Modell-Erreichbarkeit aller Punkte des Ellipsotops und des tatsächlich realisierten Logit-Bereichs zu klären, sowie Wege zu finden, wie sich dieser geometrische Rahmen auf die Verbesserung von Trainings- und Inferenzstrategien auswirken kann. Die Geometrie der LLM-Logits ist somit ein grundlegender Schritt hin zu einem tieferen Verständnis und einer verbesserten Handhabung hochkomplexer Sprachmodelle.