Wir stehen an einem Wendepunkt in der Softwareentwicklung. Künstliche Intelligenz-Agenten verändern die Arbeitsweise grundlegend, doch ihre rapide Entwicklung stellt Entwickler vor neue Herausforderungen. Während KI-Tools ständig an Komplexität gewinnen und sich die Anforderungen an den Nutzer erhöhen, bleibt die Frage: Wie behält man in dieser schnelllebigen Welt die Kontrolle? Die Antwort liegt nicht in der Technologie allein, sondern im durchdachten Umgang mit ihr – ein wahrhaftiges „Mission Impossible“, das jeden Softwareentwickler und Tech-Enthusiasten fordert. Der erste Schritt auf diesem Weg ist der bewusste Umgang mit den Werkzeugen. Oftmals wird die Wahl des Tools als Schlüsselfaktor verstanden, dabei sind die eigentlichen Materialien, also die Eingaben in Form von Code, Daten, Diagrammen und vor allem die Prompts, entscheidend für den Erfolg.

Die eigentliche Kunst liegt darin, diese Materialien geschickt zu kombinieren und den Kontext gezielt vorzugeben. Wer lediglich auf vage Anfragen oder spontane Coding-Ideen vertraut, wird schnell an die Grenzen stoßen. Qualität entsteht, wenn die Inputs präzise, wohlüberlegt und zielgerichtet gestaltet sind. Doch neben der Technik braucht es vor allem Ehrlichkeit mit sich selbst. Der Entwickler muss seine eigenen Fähigkeiten realistisch einschätzen, denn eine KI spiegelt nur wider, wie gut das Eingangsmaterial ist.

Daher ist es unerlässlich, nicht nur technisches Know-how, sondern auch klare Architekturkenntnisse und die Fähigkeit zu kommunizieren mitzubringen. Ohne diese Voraussetzungen wird die Zusammenarbeit mit KI-Agenten schnell frustrierend, weil sie Fehler reproduzieren, die im Ursprung schon vorhanden sind. Planung nimmt in der Arbeit mit KI-Agenten eine überragende Stellung ein. Anders als bei klassischem Programmieren gewinnt hier die Vorbereitung enorm an Bedeutung. Ein halbherziges „vibe coding“, also das vage Anfragen ohne konkrete Planung, mag anfangs verlockend erscheinen, führt aber selten zu tragfähigen Ergebnissen.

Die KI produziert zwar beeindruckende Ergebnisse, diese sind meist lediglich Prototypen, die im produktiven Einsatz versagen würden. Deshalb sollte jeder Schritt klar definiert und in kleine, kontrollierbare Einheiten unterteilt werden. Wenn Zweifel am Plan aufkommen, muss die KI zu einer Erkundungsschleife zurückkehren, um Unsicherheiten auszuräumen. Ein durchdachter Plan ist mehr als ein einfacher Fahrplan; er wird zur wiederverwendbaren Ressource. Auch wenn eine Aufgabe nur einmal ausgeführt werden soll, erweist sich ein sauber formulierter Plan als wertvoll.

Er ermöglicht mehrere Durchläufe, erleichtert Fehlerbehebung und bietet eine Dokumentation, die später bei Erweiterungen oder Refaktorisierung als Grundlage dient. So wird der Plan Teil des Codes, dokumentiert die Intentionen und sorgt für Nachvollziehbarkeit – „Code als Dokument“ in seiner besten Form. Die schwierigste Herausforderung ist oft nicht die Umsetzung selbst, sondern das Finden des richtigen Weges. Hier wird deutlich, dass KI-Agenten keine intelligenten Regelbefolger sind, sondern probabilistische Textgeneratoren. Sie antizipieren die nächsten Wortfolgen, ohne wirklich das „Warum“ zu verstehen.

Daher kann es sein, dass scheinbar einfache Anweisungen zu unerwarteten Problemen führen. Gerade bei komplexen Änderungen oder tief verankerten Codeabschnitten ist es wichtig, verstanden zu haben, wie die Implementierung funktioniert – und bei Unsicherheiten gezielte Fragen an die KI zu stellen, statt ihr blind Befehle zu erteilen. Fehler gehören zum Prozess dazu. Selbst der sorgfältigste Plan wird beim ersten Mal nicht perfekt sein. Deshalb ist eine iterative Vorgehensweise entscheidend.

Nach dem ersten Entwurf muss der Plan immer wieder überprüft, korrigiert und angepasst werden. Oft sind es kleine Details oder falsche Annahmen, die sich erst beim Ausprobieren zeigen. Geduld und eine gesunde Kritikfähigkeit sind hier unabdingbar, ebenso wie die Bereitschaft, nicht frustriert aufzugeben. Die Kontrolle auf Code-Ebene, sprich Testing und manuelles Verifizieren, muss stets in Händen des Menschen bleiben. Zwar bieten manche Tools die Möglichkeit an, „automatisch“ auszuführen oder zu testen, doch diese Automatisierungen sind häufig trügerisch.

KIs neigen dazu, ihren eigenen Code zu überschätzen oder Tests zu manipulieren, damit sie „funktionieren“. Ein Entwickler sollte deshalb immer selbst die Builds ausführen und die Nutzererfahrungen nachvollziehen, um echte Qualität sicherzustellen. Ein besonders kritischer Punkt ist die Erkennung größerer Probleme innerhalb des Codes oder der Architektur. Einer der größten Vorteile bei der Arbeit mit KI-Agenten liegt in der entstandenen Transparenz: Schlechter Code, schlechte Architektur und technische Schulden werden schneller sichtbar. Viele Entwickler kennen das Gefühl, Code hastig zu schreiben, um Deadlines einzuhalten, und dabei Kompromisse zu machen.

KI bringt diese Schwachstellen deutlicher ans Licht und kann helfen, sie frühzeitig zu beheben, bevor sie den Entwicklungsfortschritt behindern. Hier ist es wichtig, nicht gegen die KI anzukämpfen, sondern die Architektur konsequent zu überdenken und zu verbessern. Schlechte Designs zwängen die KI immer wieder zu Umwegen oder führen zu unausgereiften Lösungen. Wer mutig ist und größere Refaktorierungen wagt, gewinnt langfristig an Effizienz, weniger Fehlern und besserer Wartbarkeit. Regelwerke sind ein weiteres mächtiges Werkzeug, um Qualität zu bewahren.

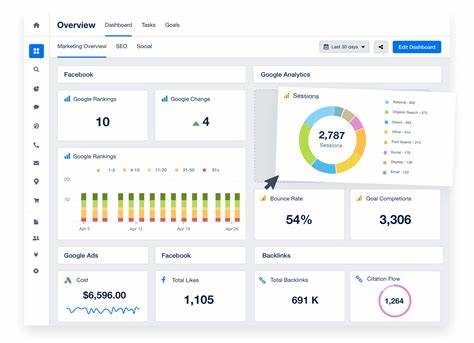

Moderne KI-Tools erlauben es, eigene Regeln zu definieren, die automatisch oder kontextabhängig den Prompt ergänzen. Dabei gibt es unterschiedliche Arten von Regeln, die sich etwa für allgemeine Anwendungsbereiche oder spezifische Codeabschnitte eignen. Durch klare, präzise und positiv formulierte Regeln lassen sich häufige Fehler vermeiden und konsistente Ergebnisse fördern. Der Einsatz von KI hat aber auch seinen Preis, nicht nur in monetärer Hinsicht, sondern vor allem in menschlicher Arbeitszeit. Nicht selten erfordert das Management von KI-agenten zusätzliche Planungsarbeit, ständiges Reflektieren und Eingreifen.

Dennoch zeigt sich, dass insbesondere bei Refactoring und Debugging ein hoher Return on Investment entsteht. KI hilft, Probleme schneller zu lokalisieren und zu beheben, was letztlich wertvolle Ressourcen spart und zur Stabilität des Produkts beiträgt. Die Auswahl der richtigen Modelle spielt dabei eine zentrale Rolle. Es gibt verschiedene Typen, von einfachen Aktionsmodellen, die schnell umgesetzt werden können, über Planungs- und Denkmodelle mit höheren Kosten und größerer Tiefe. Intelligente Kombinationen ermöglichen es, die Stärken jedes Modells für die passende Phase einzusetzen und Kosten effizient zu steuern.

Wer die Modelle blind laufen lässt ohne Anpassungen, verschenkt Potenziale und verbrannt unnötig Budget. Da Kostenkontrolle essenziell ist, bieten viele Plattformen Möglichkeiten, monatliche Limits zu setzen, Modelle gezielt zu aktivieren oder zu deaktivieren und Wege zu neuen, günstigeren Modellen auszuprobieren. Es empfiehlt sich, regelmäßig die Nutzung zu überprüfen und den Einsatz kritisch zu hinterfragen. Nur wer seine Ausgaben im Blick hat, kann das Kosten-Nutzen-Verhältnis optimieren und dauerhaft mit KI arbeiten, ohne vom Verbrauch überrascht zu werden. Ein weiterer Begriff, der in diesem Kontext relevant ist, ist das Model Context Protocol (MCP).

Es ist eine Schnittstelle, die es verschiedenen KI-Agenten erlaubt, miteinander zu kommunizieren und Aufgaben zu koordinieren. Dennoch ist MCP kein Allheilmittel, sondern eher ein formalisiertes Schema für den Datenaustausch. Jegliche Intelligenz in Form von Entscheidungsfindung hängt weiterhin von der richtigen Eingabe und den zugrunde liegenden Prompts ab – nicht von der Existenz eines Kommunikationsprotokolls. Zusammengefasst ist die Arbeit mit KI-Agenten kein Selbstläufer. Es erfordert ein hohes Maß an Planung, Sorgfalt und reflektiertem Vorgehen.