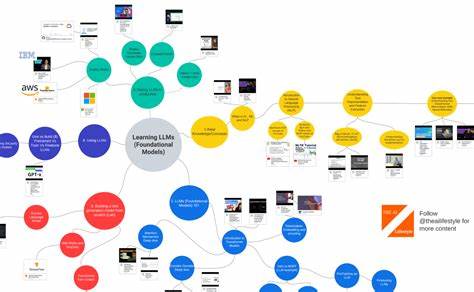

In Zeiten, in denen Künstliche Intelligenz und insbesondere große Sprachmodelle (LLMs) wie ChatGPT unser tägliches Lesen und Schreiben bereichern, wird die Fähigkeit, KI-generierte Texte zu erkennen, immer wichtiger. Diese Fähigkeit ist jedoch alles andere als einfach, denn moderne Algorithmen produzieren Texte, die oft flüssig, kohärent und auf den ersten Blick kaum von menschlichen Autoren zu unterscheiden sind. Klassische Hinweise wie Stil, Ton oder Struktur reichen meist nicht aus, um sicher und eindeutig festzustellen, ob ein Text tatsächlich von einer Maschine oder einem Menschen verfasst wurde. Deshalb lohnt es sich, einen genaueren Blick auf minimale, oft übersehene Artefakte zu werfen, die bei der maschinellen Textgenerierung entstehen – kleine Fehler, Eigenheiten und Eigenheiten, die ein menschlicher Schreiber kaum hinterlassen würde. Diese „TeLLMs“, also kleine „Erkennungszeichen“ großer Sprachmodelle, sind der Schlüssel, um zwischen KI- und menschlich erzeugten Inhalten zu differenzieren.

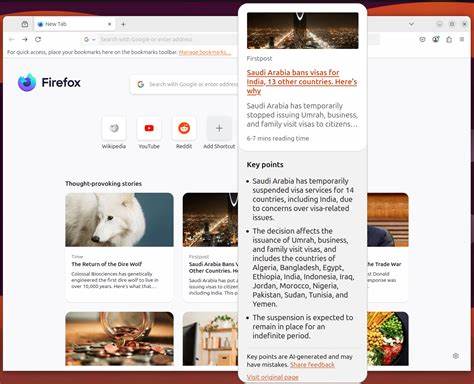

Ein auffälliges Merkmal, das bei KI-Texten häufig auftritt, sind sogenannte UI-Artefakte. Dies sind kleine Überreste aus den Benutzeroberflächen, die die KI-Plattform verwendet, um ihre Ergebnisse anzuzeigen. Ein Beispiel hierfür sind bestimmte Icons oder Symbole, die nach Links oder Textabschnitten angezeigt werden, wie das „✍️“-Symbol, das von der ChatGPT-Benutzeroberfläche stammt. Ebenso finden sich manchmal URLs mit dem Zusatz "source=chatgpt.com".

Solche Überbleibsel entstehen, wenn der KI-generierte Text direkt aus einer Plattform kopiert wird, ohne manuelle Nachbearbeitung. Ein menschlicher Autor hingegen würde diese kleinen technischen Details normalerweise nicht einbauen oder gar bemerken und beseitigen. Neben sichtbaren UI-Spuren gibt es auch sogenannte Zitierfehler, bei denen Referenzen nicht korrekt verlinkt oder formatiert sind. Texte, die von LLMs generiert werden, können noch Reste von Fußnoten oder Querverweisen enthalten wie [1] oder [^1], die allerdings keinen tatsächlichen Verweis im Text oder am Ende des Dokuments aufweisen. Diese ungelösten Referenzzeichen sind menschlich wenig wahrscheinlich, denn Autoren achten in der Regel darauf, Verweise präzise und vollständig zu gestalten.

Solche Fußnotenreste entstehen oft durch maschinelles Textgenerieren, bei dem die KI versuchte, akademisch oder seriös zu wirken, aber keine echten Quellen einfügen konnte. Darüber hinaus treten bei KI-Texten manchmal „Stimmenlecks“ auf. Das bedeutet, dass die KI quasi in der zweiten Person zum Leser spricht oder ihre eigene Verfügbarkeit thematisiert, was ein menschlicher Autor normalerweise nicht tut. Formulierungen wie „Möchten Sie eine Version, die mehr ..

. ist?“ oder „Ich bin gerne bereit, den Text zu überarbeiten, falls Sie möchten“ deuten auf solche maschinellen „Voice Slips“ hin. Diese Stellen wirken in einem normalen journalistischen oder literarischen Text fehl am Platz, da sie die Textoberfläche für den Leser als eine Art Dialog mit der KI offenbaren. Ein menschlicher Autor hätte diese Botschaften, die an die Interaktion mit der Software gebunden sind, so nicht eingebaut. Auch bei der Formatierung können sich Unterschiede zeigen.

Manche KI-generierte Texte enthalten beispielsweise eine ungewöhnliche Anzahl von Leerzeichen zwischen Satzzeichen, unter anderem doppelte oder dreifache Leerzeichen hinter Punkten. Diese historische Anomalie stammt aus Zeiten der Schreibmaschinen, ist aber in modernen Texten längst überholt. Während manche Menschen, insbesondere ältere Generationen, dieses Formatierungsmuster aus nostalgischen Gründen oder Gewohnheit nutzen, ist es eher ungewöhnlich und kann im Kontext von KI-Texten als Hinweis dienen. Ebenso kann die falsche Zuordnung von Codeblöcken zu Programmiersprachen auffallen. So kann ein KI-generierter Beitrag etwa Python-Code in einem als matlab gekennzeichneten Block zeigen, was auf den ersten Blick unsinnig wirkt und in menschlich redigierten Texten selten vorkommt.

Ein weiterer Punkt ist der unerwartete Einsatz typografischer Zeichen. Während Menschen häufig Gedankenstriche oder lange Bindestriche (emdashes) korrekt einsetzen, tut eine KI sich manchmal schwer damit. TeLLMs legen nahe, dass die Nutzung von typografischen Elements wie Bindestrichen, Gedankenstrichen oder Anführungszeichen einen unbewussten Hinweis liefern kann, da KI-Modelle mitunter uneinheitliche oder inkonsequente Zeichen setzen. Interessant ist, dass viele dieser Artefakte nicht aus dem generellen Schreibstil stammen, sondern hauptsächlich aus der Art und Weise, wie KI-Plattformen die Texte technisch erzeugen und präsentieren. Dadurch entstehen für geschulte Augen vergessene Fußnoten, merkwürdige Formatierungen, Sprachübernahmen der KI selbst oder Überbleibsel von UI-Elementen, die als untrügliche Signale dienen.

Wer sich intensiv mit der Detektion von maschinell generierten Inhalten beschäftigt, sollte daher nicht nur auf den Inhalt des Textes achten, sondern besonders solche kleinen, wortwörtlichen Unebenheiten in den Blick nehmen. Natürlich erweitert sich diese Liste mit der Zeit, da KI-Modelle ständig weiterentwickelt werden und immer neue Methoden finden, menschliches Schreiben zu imitieren. Gleichzeitig verbessern Entwickler die Plattformen, damit solche Spuren möglichst entfernt werden. Dennoch bietet die Auseinandersetzung mit TeLLMs einen wertvollen Zugang, um auch in Zukunft KI-Generierung zu identifizieren und den Ursprung eines Textes besser einschätzen zu können. Für Autoren, Journalisten oder auch Unternehmen, die Klarheit über den Ursprung von Inhalten wünschen, bedeuten diese Erkenntnisse einen wichtigen Schritt.

Sie unterstützen nicht nur die Authentizität in der Kommunikation, sondern helfen auch, den verantwortungsvollen Umgang mit KI-Technologie zu gewährleisten. Durch die bewusste Beobachtung kleiner Artefakte können Fehlinformationen vermieden und Qualitätssicherung verbessert werden. Abschließend ist zu sagen, dass das Erkennen von KI-generierten Texten eine spannende und dynamische Herausforderung bleibt. Die kleinen Hinweise, die sich in Form von „TeLLMs“ zeigen, sind sozusagen die unsichtbaren Fingerabdrücke der Künstlichen Intelligenz im Text. Mit jedem neuen Modell und Update werden diese Fingerabdrücke jedoch feiner und schwerer erkennbar.

Daher empfiehlt es sich, neben technischen Tools auch den Blick für diese subtilen menschlichen Unvereinbarkeiten zu schärfen, um die immer komplexer werdende Welt der KI-Textproduktion besser zu verstehen und einzuordnen.