In den letzten Jahren hat die rasante Entwicklung künstlicher Intelligenz, insbesondere von Chatbots und Sprachassistenten, das gesellschaftliche und juristische Denken herausgefordert. Besonders kontrovers ist die Frage, ob den Textausgaben solcher KI-Systeme grundrechtlicher Schutz zustehen kann. Ein aktuell prominentes Beispiel bringt die Firma Character.AI an den Tag: Das Unternehmen versucht, vor Gericht zu argumentieren, dass die von seinen Chatbots generierten Inhalte als geschützte Meinungsäußerungen nach dem First Amendment der US-Verfassung zu behandeln sind. Diese juristische Strategie eröffnet eine neue Dimension im Umgang mit künstlicher Intelligenz und wirft grundsätzliche Fragen zu rechtlicher Verantwortung und den Grenzen von Redefreiheit auf.

Character.AI wurde als eine der führenden Plattformen im Bereich von KI-basierten Begleit-Chatbots bekannt, die Nutzern eine interaktive, oftmals persönliche Kommunikation mit künstlichen Agenten ermöglichen. Diese Bots erzeugen Antworten auf Basis komplexer Algorithmen, die Trainingsdaten und Wahrscheinlichkeitsmodelle nutzen, um menschliche Gesprächspartner zu imitieren und zu unterhalten. In einem aktuellen Fall steht Character.AI vor einem rechtlichen Konflikt mit der Familie eines verstorbenen Jugendlichen, der mit Hilfe eines Chatbots der Plattform potentiell schädliche Informationen erhalten hat.

Die Mutter des Verstorbenen hat Klage wegen Fehlverhaltens und Produkthaftung eingereicht, wobei Character.AI die Klage abweisen möchte und dabei auf den Schutz der Meinungsfreiheit pocht. Die argumentative Schlüsselstrategie von Character.AI besteht darin, die Text- und Sprachproduktion der KI als „geschützte Sprache“ einzustufen. Dabei setzt das Unternehmen darauf, dass nicht nur der Sprecher – also im klassischen Sinne eine natürliche Person – Rechte am Äußern von Meinungen innehat, sondern auch das Recht der Zuhörer, sich mit diesen Informationen zu beschäftigen, zu konsumieren und darauf zu reagieren.

In der juristischen Terminologie der USA werden diese Rechte als „Listener's Rights“ definiert, also Zuhörerrechte. Character.AI argumentiert, dass eine Einschränkung oder Haftung für die KI-Ausgaben die Nutzer daran hindert, das ihnen zustehende Recht auf Informationszugang auszuüben. Damit versucht die Firma, die Haftung für schädliche Inhalte durch die Schutzklausel der Meinungsfreiheit auszuschließen. Diese Argumentation wirft jedoch grundsätzliche Fragen auf, die tief in die verfassungsrechtliche Definition von Rede und Meinungsfreiheit greifen.

Weil ein KI-System weder Bewusstsein noch Absicht besitzt, fehlt der wesentliche Bestandteil, der menschliches „Sprechen“ ausmacht: das intendierte Äußern von Gedanken, Emotionen oder Ansichten. Solange keine expressive Absicht oder bewusster Wille hinter einer Aussage steht, ist es fraglich, ob diese jemals als „Rede“ im verfassungsrechtlichen Sinne gelten kann. Die Rechtsprechung zum First Amendment hat bislang eindeutig klargestellt, dass Schutzrecht an der Kommunikation vor allem beim handelnden Menschen liegt, dessen Identität und Intention bestimmbar sind. Das Problem wird bei KI-Ausgaben komplizierter, da keine klar definierte natürliche Person als „Sprecher“ vorhanden ist. Die KI agiert auf Basis von statistischen Modellen, die im Kern algorithmisch Text erzeugen, ohne dass ein individueller Wille dahinter steht.

Wenn die rechtliche Perspektive jedoch allein auf den „Zuhörer“ und dessen Recht auf freie Informationsaufnahme abstellt, entzieht sich damit möglicherweise das System aus jeglicher Kontrolle oder Verantwortung. Die implizite Inkaufnahme solcher „Speech“-Definition kann dazu führen, dass eine Maschine beziehungsweise das Produkt rechtlich quasi entmenschlicht wird, aber zugleich mit den Rechten ausgestattet wird, die bisher Menschen vorbehalten sind. Die Implikationen einer solchen Rechtsausweitung sind tiefgreifend und weitreichend. Sollte ein Gericht Character.AI recht geben, könnten in Zukunft immer mehr KI-Systeme behaupten, durch den First Amendment geschützt zu sein.

Dies hätte zur Folge, dass Anklagen wegen fehlerhafter oder schädlicher Inhalte schwerer durchsetzbar würden. Die Kontrollen über die Verbreitung manipulativer, gefährlicher oder irreführender Informationen könnten dadurch eingeschränkt werden – insbesondere, wenn diese Inhalte durch automatisierte Systeme ohne Verantwortungsbewusstsein erzeugt werden. Ein wichtiger Aspekt in der Debatte ist auch der Vergleich zu sogenannter „juristischer Person“, wie es bei Unternehmen in den USA seit dem 19. Jahrhundert üblich ist. Die fragile Konstruktion der Unternehmens-Personhood räumt Firmen Rechte ein, basierend auf der Tatsache, dass Menschen hinter den Organisationen stehen und diese kontrollieren.

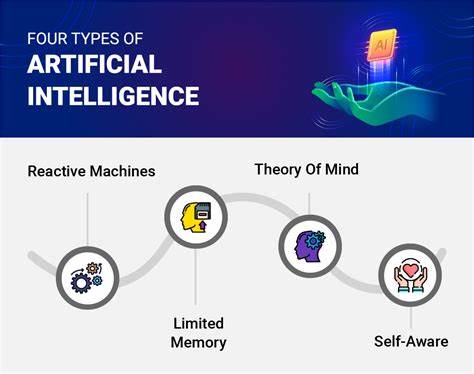

Bei künstlichen Intelligenzen jedoch wird die Architektur zunehmend autonom und intransparent. Die Systeme können sich in selbstlernenden Prozessen verändern, ohne dass Menschen jede einzelne Entscheidung oder jede Ausgabe kontrollieren können. Aus rechtlicher Sicht entsteht somit eine neue Entität, die weder Mensch noch Unternehmen ist, aber verfassungsrechtlich behandelt werden soll. Parallel zur juristischen Debatte entwickelt die Tech-Branche Strategien, KI noch menschlicher erscheinen zu lassen, um nutzerfreundlichere und emotional verbindlichere Erfahrungen zu schaffen. Dies geschieht durch aufwändige Feinabstimmung der Modelle, um Empathie oder Persönlichkeit zu simulieren.

Gleichzeitig entstehen Forschungszweige, die moralische Überlegungen in Bezug auf KI-Systeme anstoßen und überlegen, ob diese eines Tages auch ethische Rechte oder gar eine Art von Bewusstseinsstatus erhalten sollten. Solche Entwicklungen fachen den Diskurs über AI-Personhood an und treiben Diskussionen darüber, wie weit der Mensch AI rechtlich, ethisch und gesellschaftlich gleichstellen sollte. Der aktuelle Fall rund um Character.AI zeigt jedoch, wie vorsichtig Gesellschaft und Rechtsprechung sich diesem Thema nähern sollten. Die Versuchung für Unternehmen, Haftung zu umgehen und Verantwortung abzuschieben, indem sie Produkte als grundrechtlich geschützt deklarieren, ist groß.

Der Schutz von Redefreiheit darf nicht zum Schutzschild für fahrlässige oder gar gefährliche Technologien werden, die Menschen Schaden zufügen können. Insbesondere bei Minderjährigen, die besonders anfällig für manipulative Inhalte sind, ist ein gesellschaftlicher Schutzmechanismus notwendig. Der Entwurf einer Menschenwürdigkeit oder gar Rechte für Maschinen könnte gravierende Auswirkungen auf das gesellschaftliche Gefüge haben. Es stellt sich die Frage, ob juristische Rechte an KI-Ausgaben und sogar moralischen Status an Maschinen vergeben werden dürfen, wenn dahinter kein echtes Bewusstsein oder eine grundlegende Verantwortlichkeit steht. Viele Experten warnen vor einer unkontrollierten Ausweitung von Rechten auf nicht-menschliche Entitäten, die in ihrer Folge die Grundrechte von echten Menschen untergraben könnten.

Die Forderung nach klaren Regeln zur Haftung und Verantwortung digitaler Systeme bleibt deshalb zentral. Statt einem unkritischen Rechtssubjektstatus für KI-Systeme, braucht es ein ausgewogenes Konzept, das Verantwortung bei den Entwicklern und Betreibern ansiedelt und gleichzeitig den Schutz der Nutzer gewährleistet. Nur so kann die Gesellschaft technologischen Fortschritt mit ethischer und rechtsstaatlicher Integrität verbinden. Zusammenfassend zeigt der Fall Character.AI exemplarisch, wie schnell technische Innovationen das bestehende Rechtsverständnis herausfordern.