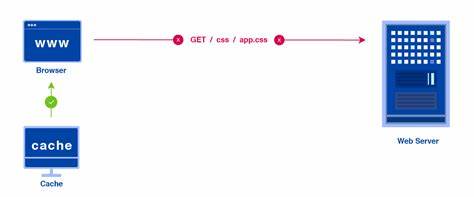

In der heutigen digitalen Landschaft sind Anwendungen zunehmend auf externe APIs angewiesen, um Daten in Echtzeit zu beziehen. Diese Abhängigkeit stellt Entwickler vor zahlreiche Herausforderungen, insbesondere wenn es um Effizienz, Kostenkontrolle und Performance geht. Cache Horse tritt in diesem Kontext als leistungsstarke HTTP-Cache- und Batch-Service-Lösung auf den Plan, die es ermöglicht, API-Anfragen schlank zu bündeln, zu speichern und so den Ressourcenverbrauch signifikant zu reduzieren. API-Nutzungsquoten und Kosten sind für viele Unternehmen eine erhebliche Belastung. Häufig wiederkehrende Anfragen an dieselben Endpunkte ziehen unnötige Kosten nach sich.

Cache Horse bietet eine Möglichkeit, diese mehrfachen Anfragen zu vermeiden, indem es Daten zwischenspeichert und kontrolliert bedient. Durch die gezielte Speicherung von API-Antworten lässt sich nicht nur das Datenvolumen verringern, sondern auch die Ansprechzeiten der Anwendung deutlich verbessern. Unternehmen profitieren somit von einer optimierten Ressourcennutzung und sparen bares Geld durch reduzierten API-Aufrufbedarf. Eine zentrale Innovation von Cache Horse ist die Batch-Funktionalität. Viele moderne Frontend-Anwendungen - sei es mit React, Vue oder Next.

js - generieren parallel eine Vielzahl von API-Anfragen. Diese Vielzahl an asynchronen Prozessen kann schnell zum Flaschenhals werden. Cache Horse ermöglicht hier, mehrere API-Endpunkte in einer einzigen kombinierte Anfrage zu bündeln und die Antworten gesammelt zurückzugeben. Dadurch wird der Verwaltungsaufwand für Entwickler erheblich reduziert. Applikationen können ihren Datenabruf vereinfachen und erhalten gleichzeitig eine höhere Verarbeitungseffizienz.

Darüber hinaus bietet Cache Horse eine umfangreiche Steuerung über die Cache-Dauer und das Refresh-Verhalten an. Entwickler können individuell festlegen, wie lange bestimmte Daten zwischengespeichert werden sollen und wann eine erneute Anfrage an die Quell-API erfolgen muss. Diese Flexibilität erlaubt es, die Balance zwischen Datenaktualität und Systemperformance genau zu bestimmen und somit optimal auf die jeweiligen Anforderungen einzugehen. Neben der Nutzung für externe APIs eignet sich Cache Horse auch hervorragend als Zwischenspeicher für eigene API-Daten. Gerade bei datenintensiven Endpunkten oder Systemen mit häufigen Datenbankabfragen lässt sich die Backend-Belastung durch gezieltes Caching verringern.

Damit verbessert sich die Skalierbarkeit der eigenen Infrastruktur erheblich. Cache Horse fungiert somit als eine Art Content Delivery Network für API-Daten und stellt sicher, dass die Anwendung stets schnell und zuverlässig auf benötigte Informationen zugreifen kann. Ein weiteres praktisches Anwendungsfeld besteht im Umgang mit teuren Drittanbieter-APIs, die etwa Kursdaten, Wetter- oder Umweltdaten liefern. Bei häufigem Abruf dieser Daten schlägt sich das deutlich auf die Betriebskosten nieder. Cache Horse ermöglicht es, diese Informationen nur sporadisch zu aktualisieren und ansonsten auf gecachte Inhalte zurückzugreifen.

Das spart nicht nur Geld, sondern entlastet auch die Netzwerkinfrastruktur und verkürzt die Antwortzeiten spürbar. Ein Blick auf die technischen Details zeigt, wie einfach die Integration von Cache Horse vorgenommen werden kann. Durch eine einfache URL-Struktur, die mehrere API-Endpunkte als Parameter entgegennimmt, können Entwickler in ihrem Code mehrere Requests bündeln und über den Service abwickeln. Die Rückgabe erfolgt gesammelt, was die Komplexität des Datenmanagements im Frontend erheblich mindert. Neben der technischen Flexibilität punktet Cache Horse auch mit einem transparenten und skalierbaren Preismodell.

Es gibt eine kostenlose Einstiegsversion, die bereits unbegrenzte Anfragen an bereits gecachte Endpunkte erlaubt und bis zu drei uncached Endpunkte pro Abruf unterstützt. Für intensivere Nutzungen steht die Pro-Variante zur Verfügung, welche mehr uncached Endpunkte, ausgedehnte Batch-Kapazitäten und Prioritätssupport bietet. Für Unternehmen mit höchsten Anforderungen gibt es eine Enterprise-Lösung mit noch umfangreicheren Möglichkeiten und 24/7-Support. Das Design von Cache Horse orientiert sich klar an den Bedürfnissen von Entwicklern. Ein schlankes, gut dokumentiertes API, einfache Konfigurationsmöglichkeiten und klare Steuerung über das Caching machen den Dienst zu einem praxisnahen und wertvollen Werkzeug.

Gerade Entwickler, die mit mehreren heterogenen Datenquellen arbeiten, finden hier eine Möglichkeit, ihre Infrastruktur zu entlasten und gleichzeitig die User Experience erheblich zu verbessern. Zusammenfassend ist Cache Horse mehr als nur ein weiteres Caching-Tool: Es verbindet effizientes Caching mit intelligenter Batch-Verarbeitung und bietet so eine ganzheitliche Lösung für moderne API-Herausforderungen. Die Kostenersparnis, Geschwindigkeit und Einfachheit sind wesentliche Argumente für den Einsatz in der eigenen Entwicklungsumgebung. Insbesondere für Unternehmen und Entwickler, die auf Drittanbieter-APIs angewiesen sind, stellt Cache Horse eine attraktive Möglichkeit dar, Ressourcen zu schonen und Anwendungen performant zu betreiben. Darüber hinaus zeigt der Service, wie technologische Innovation und Entwicklerfreundlichkeit kombiniert werden können, um Alltagsprobleme im Software-Development elegant zu lösen.

Wer also auf der Suche nach einer Möglichkeit ist, API-Anfragen zu optimieren, sollte einen genaueren Blick auf Cache Horse werfen und das Leistungsangebot ausgiebig testen. Die cloudbasierte Lösung lässt sich leicht in bestehende Projekte integrieren und kann schnell spürbare Verbesserungen in Leistung und Kostenbilanz bringen. Mit Cache Horse reduziert sich die Komplexität von API-Nutzung erheblich. Entwickler können sich fokussierter auf das Wesentliche konzentrieren: die Entwicklung wertvoller Features und die Optimierung der User Experience. Dank der intelligenten Cache- und Batch-Strategie wird der Datenfluss kontrolliert, die Netzwerklast minimiert und die Systemstabilität gestärkt.

Diese Vorteile machen Cache Horse zu einem unverzichtbaren Tool in modernen Webprojekten und API-getriebenen Anwendungen.