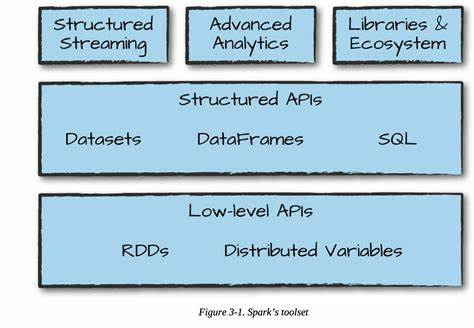

Apache Spark 4.0 repräsentiert einen bedeutenden Meilenstein in der Entwicklung des populären Frameworks für schnelle und leistungsfähige Datenverarbeitung in verteilten Systemen. Die Veröffentlichung dieser Version stellt den Einstieg in die 4.x-Serie dar und wurde von einer lebendigen Open-Source-Community mit über 390 Mitwirkenden und mehr als 5100 bearbeiteten Tickets intensiv vorangetrieben. Dabei schlägt Spark 4.

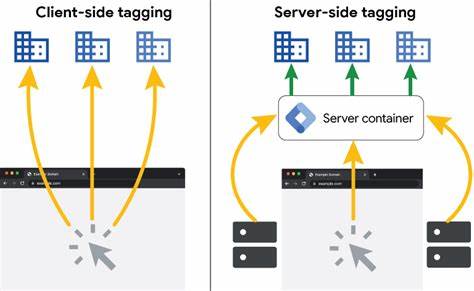

0 eine Brücke zwischen der Stabilität etablierter Technologien und innovativen Konzepten, die die Analyse und Verarbeitung großer Datenmengen revolutionieren sollen. Ein Schwerpunkt von Apache Spark 4.0 liegt auf der Weiterentwicklung von Spark Connect, einem modularen Kommunikationsprotokoll, das zunehmend die Basis für den Zugang zu Spark-Clustern darstellt. Besonders hervorzuheben ist dabei der neue, schlanke Python-Client pyspark-client, der mit nur 1,5 Megabyte wesentlich ressourcenschonender ist als frühere Versionen. Zudem wurde ein eigenständiges Release-Tarball veröffentlicht, in dem Spark Connect standardmäßig aktiviert ist, was die Integration und Nutzung vereinfacht.

Die Java-Client-Bibliothek profitiert von vollständiger API-Kompatibilität, was eine nahtlose Migration und Erweiterung von Anwendungen erleichtert. Schließlich erleichtert die Einführung der Konfigurationsoption spark.api.mode das Ein- und Ausschalten von Spark Connect in bestehenden Anwendungen. Ein weiterer Meilenstein betrifft die Erweiterung der API-Abdeckung von Spark Connect, der direkten Integration von Maschinellem Lernen (ML) und der Veröffentlichung eines neuen Swift-Clients.

Diese Neuerungen erhöhen nicht nur die Vielseitigkeit, sondern fördern auch die plattformübergreifende Entwicklung und Nutzung von Spark in unterschiedlichen Programmiersprachen und Ökosystemen. Im Bereich Spark SQL wurden zahlreiche leistungsstarke Funktionen hinzugefügt, die die Ausdruckskraft und Flexibilität von SQL-Anfragen deutlich steigern. Besonders erwähnenswert ist die Unterstützung des VARIANT-Datentyps, der es ermöglicht, heterogene Datenstrukturen in einer einzigen Spalte zu speichern und zu verarbeiten. Darüber hinaus wurden SQL-Funktionen durch den Einsatz von benutzerdefinierten Funktionen (User-Defined Functions, UDFs) erweitert, die künftig mit noch mehr Komfort und Effizienz betrieben werden können. Session-Variablen, Pipe-Syntax zur Verkettung von SQL-Befehlen sowie stringbasierte Kollationen eröffnen SQL-Nutzern neue Möglichkeiten zur Datenmanipulation und -analyse.

Im Rahmen von PySpark gibt es kontinuierliche Verbesserungen sowohl bezüglich Funktionalität als auch Nutzererfahrung. Eine native Plotting-API ermöglicht es Entwicklern und Datenwissenschaftlern, Visualisierungen direkt aus Spark-Datenrahmen zu erzeugen, ohne auf externe Tools zurückgreifen zu müssen. Mit der neuen Python Data Source API lassen sich Datenquellen einfacher und modularer integrieren. Die Unterstützung für User-Defined Table Functions (UDTFs) in Python erweitert die Möglichkeiten bei der Verarbeitung von Tabellen im Spark-Kontext. Außerdem wurde ein vereinheitlichtes Profiling für PySpark-UDFs eingeführt, das die Performance-Analyse und Optimierung von benutzerdefiniertem Code erleichtert.

Die Structured Streaming-Komponente von Apache Spark hat mit Version 4.0 eine Reihe von bedeutenden Neuerungen erhalten, die den Umgang mit Streaming-Daten flexibler und zuverlässiger machen. Die neue Arbitrary State API Version 2 unterstützt eine vielseitigere Verwaltung von Zuständen in Streaming-Anwendungen, was besonders bei komplexen Echtzeit-Analysen oder längeren Aggregationszeiten hilfreich ist. Zusätzlich wurde der State Data Source eingeführt, der es erlaubt, Zustandsinformationen einfacher zu überwachen und zu debuggen. Python-bezogene Streaming-Funktionalitäten wurden ebenfalls maßgeblich verbessert, unter anderem durch die Einführung eines Python-Streaming-Datenquellen-Workers, der eine performante Einbindung von Python-Logik in Streaming-Workflows ermöglicht.

Im Spark Core Bereich wurde die Unterstützung für Kubernetes weiter verbessert, unter anderem durch Optimierungen beim Kubernetes Operator und der Standalone-Cluster-Verwaltung. Spark setzt künftig standardmäßig auf neuere Technologien und Sicherheitsentwicklungen: So ist Scala 2.13 der neue Standard, während Versionen wie Scala 2.12 und ältere JDK-Versionen (8 und 11) nicht mehr offiziell unterstützt werden – statt dessen ist jetzt JDK 17 Voraussetzung. Diese Updates sichern eine moderne und zukunftsfähige Basistechnologie für Entwickler.

Die Optimierung von Abfragen wurde ebenfalls weiter vorangetrieben. Verbesserungen in der dynamischen Filterung (Dynamic Pruning) und beim Predicate Pushdown sorgen für schnellere Ausführungszeiten komplexer Anfragen. Korrekturen im Adaptive Query Execution (AQE) Prozess beseitigen Probleme wie die Änderung der Ausgabespaltenreihenfolge oder fehlerhafte Ausführungen bei Zwischenspeicherungen. Spark Connectors profitieren ebenfalls von zahlreichen Neuerungen. Das Data Source V2 Framework wurde weiterentwickelt, um unter anderem Clustering-Mechanismen, erweiterte Unterstützung für DML-Operationen sowie neue Catalog-APIs für gespeicherte Prozeduren bereit zu stellen.

Verschiedene Datenformate wie XML, CSV, ORC und Avro werden jetzt noch umfassender unterstützt, was die Integration heterogener Datenquellen erleichtert. Die Standardkompression für ORC-Dateien wurde auf zstd umgestellt und neue Codecs wie Brotli finden Einzug, was Speicher- und Übertragungsgrößen deutlich reduziert. Auch der Avro-Connector wurde grundlegend verbessert, etwa durch Registerung logischer Avro-Typen, erweiterte Typumwandlungen, sowie die Unterstützung von Kompressionsleveln für verschiedene Algorithmen. JDBC wird mit neuen Dialekten für spezifische Plattformen wie Databricks erweitert, und ausgeführte SQL-Abfragen erscheinen im Explain-Output – hilfreich für Debugging und Optimierung. PySpark wurde nicht nur durch neue Funktionalitäten wie lateral Joins, erweiterte Fehlerkontexte bei DataFrame-Operationen und die Eliminierung der JDK-Abhängigkeit im Setup stark aufgewertet, sondern auch hinsichtlich der internen Architektur optimiert.

Die Trennung des Python-Cores in ein eigenes Paket ermöglicht eine bessere Wartbarkeit. Die Unterstützung für User-Defined Table Functions in Python und die Einführung eines neuen Profilings für UDFs erleichtern sowohl die Entwicklung als auch das Performance-Tuning. Die Pandas API on Spark wurde weiter angepasst und bereinigt, veraltete Funktionen wurden entfernt, während neue Methoden für den Export in populäre Datenformate wie HDF, Feather und Stata hinzugekommen sind. Die Kompatibilität und Verlässlichkeit beim Umgang mit Indizes, Datentypen und gruppierten Operationen wurden spürbar verbessert. Im Bereich Machine Learning (Spark ML) wartet Apache Spark 4.

0 mit neuen funktionalen Erweiterungen auf. Viele Transformer und Estimatoren unterstützen jetzt verschachtelte Eingabespalten, was das Handling komplexer Datenstrukturen vereinfacht. Target Encoding wurde als neue Methode in die Feature-Engineering-Bibliotheken integriert, was die Genauigkeit von Vorhersagemodellen verbessern kann. Auch die Benutzererfahrung (Spark UX) wurde durch verschiedenste Verbesserungen optimiert: Thread-Informationen zur besseren Überwachung, die Darstellung von Fehlerzusammenhängen inklusive SQLSTATE-Codes und ein neues DAG-Zeichnungssystem tragen zur übersichtlicheren Gestaltung von Job- und Abfragegraphen bei. Die Spark UI wurde zudem um wichtige Funktionen wie Downloadmöglichkeiten von Thread-Dumps ergänzt und durch Sicherheitsverbesserungen wie das Entfernen von Inline-Skripten sicherer gemacht.

Das Build-System und die Infrastruktur hinter Apache Spark erhalten ebenfalls kontinuierliche Updates. So wurde die Unterstützung für ältere Cluster-Manager wie Mesos und Python 3.8 eingestellt, was moderne und standardkonforme Plattformen fördert. Die Mindestanforderungen für Java und Scala wurden auf aktuelle Versionen (Java 21 und Scala 2.13) angehoben.

Bibliotheken wurden zahlreich aktualisiert und teils durch moderne Alternativen ersetzt, was sich positiv auf Performance, Kompatibilität und Sicherheit auswirkt. Zusammengefasst stellt Apache Spark 4.0 eine essenzielle Neuerung im Bereich großer, verteilter Datenverarbeitung dar. Die Version vereint die Stärken des Frameworks mit innovativen Ansätzen in API-Design, Streaming-Handhabung und maschinellem Lernen. Für Data Engineers, Entwickler und Unternehmen bietet die neue Spark-Generation erhebliche Vorteile: eine schlankere Architektur, mehr Flexibilität bei der Anbindung externer Systeme, verbesserte Entwicklerwerkzeuge und eine gesteigerte Performance, die die Verarbeitung von Datenmengen jeder Größenordnung effizienter gestaltet.

Durch die vielseitigen Verbesserungen bleibt Apache Spark eine führende Lösung für Big Data Analysen und Echtzeit-Datenverarbeitung. Die weitere Integration von Spark Connect und erweiterten ML-Funktionalitäten ebnet den Weg für moderne Anwendungen im Umfeld von Cloud-Plattformen, Data Lakes und Machine Learning Pipelines. Wer im Datenumfeld heute effektiv und zukunftssicher arbeiten möchte, kommt an Apache Spark 4.0 kaum vorbei.