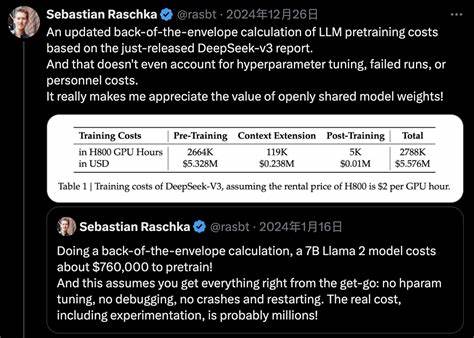

Die rasante Entwicklung großer Sprachmodelle (Large Language Models, LLMs) hat die KI-Landschaft in den letzten Jahren maßgeblich verändert und revolutioniert. Von der Verbesserung der natürlichen Sprachverarbeitung über komplexe Textgenerierungen bis hin zu vielseitigen Anwendungen in Industrie und Forschung – LLMs sind aus moderner KI nicht mehr wegzudenken. Mit steigendem Modellumfang und wachsendem Compute-Bedarf stoßen traditionelle Hardwarearchitekturen jedoch zunehmend an ihre Grenzen. Genau an diesem Punkt setzt DeepSeek-V3 an, ein wegweisendes Projekt, das mithilfe von 2.048 NVIDIA H800 GPUs die Effizienz und Skalierbarkeit von LLMs neu definiert.

Ein Kernproblem der Skalierung großer Modelle liegt in der Balance zwischen Leistungsfähigkeit, Kosten und Energieverbrauch. Während massive parallele Rechenressourcen benötigt werden, um komplexe Modelle zu trainieren und zu betreiben, stellen Speicherengpässe, langsame Kommunikationsverbindungen und ineffiziente Berechnungsverfahren oft eine große Hürde dar. DeepSeek-V3 nutzt eine hardwarebewusste Co-Design-Strategie, bei der die Modellarchitektur und die zugrunde liegende Hardware simultan optimiert werden. Dieses Konzept rückt die Grenzen zwischen Software und Hardware in den Fokus und sorgt für eine bessere Abstimmung beider Bereiche. Eines der herausragenden Merkmale von DeepSeek-V3 ist der Einsatz von Multi-head Latent Attention (MLA).

Diese innovative Mechanik sorgt für eine deutlich gesteigerte Speichereffizienz. Im Vergleich zu klassischen Attention-Mechanismen reduziert MLA den Speicherbedarf beim Training und beim Inferenz-Schritt erheblich, ohne dabei die Modellgenauigkeit einzuschränken. Gerade bei Modellen mit mehreren Milliarden Parametern ist diese Optimierung entscheidend, um die begrenzte Speicherkapazität der GPUs optimal auszuschöpfen und eine reibungslose Verarbeitung sicherzustellen. Parallel dazu setzt DeepSeek-V3 auf Mixture of Experts (MoE) Architekturen, um eine ausgeklügelte Balance zwischen Computation und Kommunikation herzustellen. Bei MoE wird das Modell in Expertenmodule aufgeteilt, die nur bei Bedarf aktiviert werden, was die Rechenlast auf einzelne GPUs verringert.

Diese Strategie ermöglicht es, Ressourcen effizienter zu verteilen und Kommunikationsüberkopf zu minimieren, der bei herkömmlichen Modellen durch intensiven Datenaustausch zwischen den Einheiten entsteht. Die Kombination aus MLA und MoE bildet somit die Grundlage für eine kosteneffektive und skalierbare Modellverarbeitung auf massiv verteilten Systemen. Ein weiterer technologischer Durchbruch ist die Verwendung von FP8-Mixed-Precision Training. Während früher hauptsächlich FP16 oder FP32 bei der KI-Berechnung genutzt wurden, bietet FP8 als niedrigere Präzision Vorteile in Geschwindigkeit und Speicherbedarf. DeepSeek-V3 demonstriert, wie durch den gezielten Einsatz von FP8-Formaten die Hardwarekapazitäten besser ausgenutzt werden und zugleich eine unerlässlich hohe Trainingsstabilität gewahrt bleibt.

Dies führt zu erheblichen Einsparungen bei den Energiekosten und erhöht die Trainingsdurchläufe pro Zeiteinheit. Auch die Netzwerkarchitektur des Clusters spielt eine entscheidende Rolle für den Erfolg von DeepSeek-V3. Das Projekt implementiert eine innovative Multi-Plane Network Topology, die den Datentransfer zwischen den 2.048 GPUs optimiert. Diese Netzwerkstrategie minimiert Latenzen und Engpässe, die in großen verteilten Systemen typischerweise auftreten.

Die verbesserte Netzwerkstruktur sorgt dafür, dass Kommunikationsflüsse effizient gelenkt werden und die Systemkapazitäten voll ausgeschöpft werden können. Aufgrund seiner umfassenden, ganzheitlichen Innovationsansätze ist DeepSeek-V3 ein Paradebeispiel, wie Hardware- und Softwareentwicklung Hand in Hand gehen sollten, um die steigenden Anforderungen moderner KI-Workloads zu bewältigen. Die hierbei gewonnenen Erkenntnisse haben weitreichende Implikationen für die Zukunft der KI-Hardware. So diskutieren Forscher und Industrieexperten verstärkt über die Entwicklung spezieller Low-Precision Recheneinheiten, die sowohl präzise als auch effizient arbeiten. Auch die Verschmelzung von Skalierungsstrategien – sowohl Scale-Up auf leistungsstärkere einzelne Einheiten als auch Scale-Out auf größere verteilte Systeme – stellt einen zentralen Fokus dar.

Eine verbesserte Latenzkommunikation innerhalb von KI-Clustersystemen ist ein weiteres Schlüsselfeld. Fortschritte auf diesem Gebiet könnten nicht nur die Trainingszeiten weiter verkürzen, sondern auch die Kosten drastisch senken und somit die Zugänglichkeit von High-Performance-KI-Technologien erhöhen. DeepSeek-V3 zeigt, dass der Fokus auf eine integrierte Betrachtung von Modellarchitektur und Hardwareinfrastruktur ein Design-Paradigma darstellt, das für zukünftige KI-Generationen richtungsweisend sein wird. Das Projekt verdeutlicht auch, welche Bedeutung Förderinstitutionen, Forschungsinstitute und Industriepartner bei der Entwicklung moderner KI-Systeme innehaben. Die gemeinsame Arbeit ermöglicht die Realisierung von großskaligen Experimenten, bei denen theoretische Konzepte in praxisnahe Lösungen übersetzt werden.

Hier liegt ein großes Potenzial, innovative KI-Methoden mit maximaler Effizienz einzusetzen. Neben den technischen Aspekten bietet DeepSeek-V3 auch wichtige Einblicke in die wirtschaftlichen und ökologischen Herausforderungen, die mit dem Training und Betrieb von LLMs verbunden sind. Durch die Optimierung der Hardwareauslastung und die Reduktion des Energiebedarfs kann das Projekt dazu beitragen, die Umweltauswirkungen großer KI-Systeme zu minimieren – ein zunehmend wichtiger Gesichtspunkt angesichts des globalen Interesses an nachhaltiger Technologieentwicklung. Abschließend lässt sich festhalten, dass DeepSeek-V3 als Meilenstein im Bereich der KI-Skalierung gilt. Die Kombination aus innovativer Modellarchitektur, dedizierter Hardware-Nutzung, fortschrittlichen Trainingstechniken und optimierten Netzwerkverbindungen zeigt exemplarisch, wie zukünftige KI-Systeme gestaltet werden müssen, um immer größere und komplexere Modelle effizient zu verarbeiten.

Die Erkenntnisse aus diesem Projekt ebnen den Weg für eine neue Ära der künstlichen Intelligenz, in der Leistung, Effizienz und Skalierbarkeit nicht mehr im Widerspruch stehen, sondern gemeinsam optimiert werden. Die Zukunft der KI wird maßgeblich von solchen integrierten Ansätzen geprägt werden. Bereits heute kann man sagen, dass DeepSeek-V3 vieles von dem leistet, was in den kommenden Jahren zum Standard in der KI-Forschung und Entwicklung avancieren wird. Für Unternehmen, Entwickler und Forschungseinrichtungen bedeutet dies, sich frühzeitig mit ähnlichen Hardware- und Software-Strategien auseinanderzusetzen, um den Anschluss an die rasante Entwicklung nicht zu verlieren und von den Vorteilen effizient skalierter KI-Modelle zu profitieren.