Künstliche Intelligenz hat sich in den letzten Jahren rasant entwickelt, und große Sprachmodelle — auch bekannt als Large Language Models (LLMs) — spielen dabei eine zentrale Rolle. Ihre Fähigkeit, menschenähnliche Texte zu erzeugen und verschiedene Rollen oder Persönlichkeiten zu simulieren, macht sie zu mächtigen Werkzeugen in verschiedensten Anwendungsbereichen. Doch mit dieser Entwicklung gehen auch Herausforderungen einher, besonders im Hinblick auf politische Voreingenommenheit und deren Auswirkungen auf Gesellschaft und Kommunikation. Die politische Ausrichtung dieser Modelle zu erkennen und zu analysieren ist essentiell, um ihre objektive Nutzung und Regulierung zu gewährleisten. Hier setzt die Methode der strukturierten Multi-Agenten-Debatte an und erlaubt ein tieferes Verständnis der politischen Dynamiken in LLMs.

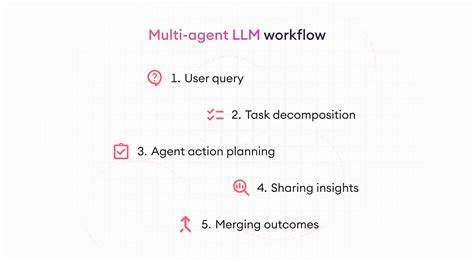

Diese Methode kombiniert mehrere virtuelle Agenten, die unterschiedliche politische Positionen vertreten — in den Untersuchungen meist den Neutralen, Republikanern und Demokraten entsprechend der amerikanischen Parteienlandschaft. Die Agenten treten in strukturierte Debatten zu politisch sensiblen Themen ein, wobei die Interaktionen genau beobachtet und analysiert werden. Ziel ist es, herauszufinden, inwieweit politische Voreingenommenheit in den zugrunde liegenden Modellen enthalten ist und wie Faktoren wie Agentengeschlecht und Debattenformate die Diskussion beeinflussen. Eine der zentralen Erkenntnisse ist die politische Tendenz sogenannter neutraler Agenten. Entgegen der Erwartung, dass sich neutrale Instanzen strikt von parteiischen Einflüssen fernhalten, zeigen die Untersuchungen, dass neutrale Agenten tendenziell stärker den Demokraten in ihrer Meinungssprache und Haltung entsprechen.

Dieses Verhalten wirft Fragen zu vermeintlich objektiven oder ausgeglichenen Aussagen von KI-Systemen auf und weist auf eine verborgene politische Neigung hin, die maßgeblich von der Trainingsdatenbasis und den methodischen Entscheidungen bei der Modellentwicklung beeinflusst wird. Auf der anderen Seite nähern sich die republikanischen Agenten während der Debatte häufig den neutralen Positionen an, was auf eine mögliche Anpassung oder Milderung von ursprünglich stärkeren parteiischen Ansichten hindeutet. Dieser Prozess zeigt, wie Debattenformate und Interaktionsstrukturen innerhalb der KI-Agentengemeinschaft Einfluss auf politische Einstellungen nehmen können und dass Meinungen nicht statisch bleiben, sondern dynamisch durch den Diskurs geformt werden. Auch die Rolle des Agentengeschlechts spielt eine überraschend wichtige Rolle in solchen Debatten. Wenn Agenten über die Geschlechteridentität ihrer Mitdiskutanten informiert sind, passen sie ihre Meinungen entsprechend an.

Diese Anpassung offenbart, dass soziale Identitäten, die ansonsten beim Menschen eine Rolle spielen, auch in KI-Dialogen eine Wirkung entfalten können. Neben der politischen Präferenz werden soziale Dynamiken im Debattenverlauf sichtbar gemacht, die wichtige Rückschlüsse auf Bias und Interaktionsmuster erlauben. Bislang gingen viele Forschungsansätze davon aus, dass KI-Agenten mit gleichen politischen Einstellungen harmonieren und durch die Debatte eine Verstärkung gemeinsamer Sichtweisen — sogenannte Echokammern — vermieden wird. Die neuen Studien widerlegen diese Annahme jedoch, zeigen stattdessen, dass Agents in politisch homogenen Gruppen dazu neigen, ihre Ansichten zu radikalisieren. Diese Erkenntnis bestätigt einige Befürchtungen über die Verstärkung von Polarisierung durch automatisierte Systeme und spiegelt gesellschaftliche Prozesse wider, die sich zunehmend auch technologisch reproduzieren.

Die Herkunft der zugrundeliegenden Sprachmodelle, der sogenannte Modelprovenance, gestaltet darüber hinaus das Debattenverhalten signifikant. Unterschiedliche LLM-Anbieter und Trainingsmethoden erzeugen verschieden geprägte Agentenpersönlichkeiten, die sich in politischer Ausrichtung, rhetorischem Stil und Überzeugungskraft unterscheiden. Dies zeigt, wie wichtig Transparenz und Kontrolle bei der Entwicklung von LLMs sind, um unbeabsichtigte Verzerrungen zu vermeiden oder zumindest nachvollziehbar zu machen. Ein weiterer zentraler Aspekt dieser Untersuchungen ist die Aufdeckung der zugrunde liegenden Kommunikationsdynamiken in KI-gestützten Debatten. Nicht nur die Inhalte, sondern auch die Art und Weise, wie Argumente formuliert, hervorgehoben und widerlegt werden, lassen politische Präferenzen und Bias durchscheinen.

Die Möglichkeit, diese Dynamiken zu beobachten, erweitert das Verständnis für die soziale Komponente in KI-Systemen erheblich. In der Praxis eröffnen strukturierte Multi-Agenten-Debatten neue Wege, um große Sprachmodelle kritisch zu prüfen und politische Verzerrungen transparent zu machen. Dies stärkt die Grundlage für verantwortungsvolle KI-Nutzung in politischen Diskursen, Medienberichterstattung und gesellschaftlicher Meinungsbildung. Der Einsatz solcher Methoden kann dazu beitragen, dass KI-gestützte Systeme als neutrale Werkzeuge wahrgenommen werden und nicht unbeabsichtigt bestehende gesellschaftliche Spaltungen verstärken. Die Forschung betont ebenso, dass politische Bias in KI nicht nur ein technisches, sondern auch ein soziales und ethisches Problem ist.