In den letzten Jahren haben sich große Sprachmodelle (Large Language Models, kurz LLMs) zu einem bedeutenden Werkzeug in vielen wissenschaftlichen Disziplinen entwickelt, darunter auch der Chemie. Die Fähigkeit dieser KI-Systeme, menschliche Sprache zu verstehen und komplexe Aufgaben zu lösen, hat erstaunliche Fortschritte gemacht. Insbesondere mit der Einführung von Frameworks wie ChemBench wurde es möglich, das chemische Wissen und die Denkfähigkeit dieser Modelle systematisch zu evaluieren und mit der Expertise von menschlichen Chemikern zu vergleichen. Große Sprachmodelle sind darauf trainiert, anhand riesiger Textmengen zu lernen und auf dieser Basis neue Informationen zu generieren. Im Kontext der Chemie bedeutet das, dass sie auf eine immense Anzahl von wissenschaftlichen Texten, Forschungsarbeiten und experimentellen Daten Zugriff haben und daraus Wissen extrahieren können.

Der schnelle Fortschritt in ihrer Leistungsfähigkeit hat die Grenzen des Möglichen im Bereich der computergestützten Chemie verschoben – manche Modelle übertreffen in standardisierten Tests bereits die durchschnittliche Leistung von Experten. Doch was macht die Kompetenz eines Chemikers eigentlich aus? Chemische Expertise beruht nicht nur auf der Speicherung großer Wissensbestände, sondern auch auf der Fähigkeit zur logischen Schlussfolgerung, kritischem Denken, intuitivem Verstehen von Reaktionsmechanismen und der Erfahrung im Umgang mit komplexen Problemstellungen. Eine zentrale Frage ist, inwieweit Sprachmodelle diese Qualitäten „nachahmen“ können und ob ihre Antworten tatsächlich tiefes Verständnis oder nur statistisches Nachplappern sind. Mit ChemBench wurde eine umfassende Sammlung von knapp 2.800 Frage-Antwort-Paaren geschaffen, die Themen aller Teilgebiete der Chemie abdecken – von allgemeiner Chemie über organische und anorganische Bereiche bis hin zu physikalischer Chemie und Sicherheitsthemen.

Die Fragen variieren stark im Schwierigkeitsgrad und erfordern verschiedene Fähigkeiten: reines Wissen, komplexes logisches Denken, mathematische Berechnungen oder chemische Intuition. Dadurch eröffnet sich ein differenziertes Bild, sobald die Modelle und menschlichen Experten auf diese Aufgaben treffen. Ergebnisse zeigen, dass derzeitige Spitzenmodelle wie das Modell „o1-preview“ in vielen Bereichen die durchschnittlichen Antworten von Chemikern bei Tests sogar deutlich übertreffen können. Selbst leistungsfähige offene Modelle wie Llama-3.1-405B-Instruct erlauben eine annähernd vergleichbare Leistung.

Besonders bei Fragen, die klassische Wissensabfragen betreffen, punkten die KI-Systeme oft mit präzisen und schnellen Antworten – dank ihrer umfangreichen Trainingsdaten und der Fähigkeit, sie blitzschnell abzurufen. Allerdings gibt es signifikante Einschränkungen: Bei Fragen, die anspruchsvolles chemisches Denken oder strukturbezogenes Verständnis erfordern, schneiden die Modelle schwächer ab. Beispielsweise fällt es den LLMs oft schwer, die Anzahl von Signalen in Kernspinresonanz-Spektren korrekt zu bestimmen, da diese Fähigkeit tiefgehende molekulare Strukturkenntnisse und räumliches Vorstellungsvermögen verlangt. Das liegt auch daran, dass Modelle häufig mit SMILES-Codes (eine textbasierte Darstellung von Molekülen) arbeiten müssen, während menschliche Experten chemische Zeichnungen sehen, die ihnen die visuelle Interpretation erleichtern. Darüber hinaus sind LLMs in der Einschätzung ihrer eigenen Antworten häufig überzuversichtlich.

Die Modelle geben oft mit großer Sicherheit falsche Antworten an, was für Anwender, insbesondere Laien oder weniger erfahrene Nutzer, potenziell gefährlich sein kann. Auch bei sicherheitsrelevanten Fragestellungen, wie der Einschätzung von chemischen Risiken, treten teils problematische Fehlbewertungen auf. Die Fähigkeit, Unsicherheit zu kommunizieren oder Zweifel zu äußern, ist demnach bei aktuellen Modellen noch unzureichend ausgeprägt. Eine weitere Herausforderung stellt die Fähigkeit der Modelle dar, menschliche Präferenzen und Intuition abzubilden – eine Eigenschaft, die insbesondere in der Wirkstoffforschung und Materialentwicklung von großer Bedeutung ist. Experimente zeigten, dass LLMs beim Bewerten von chemischen Präferenzen oft nicht besser als Zufall entscheiden.

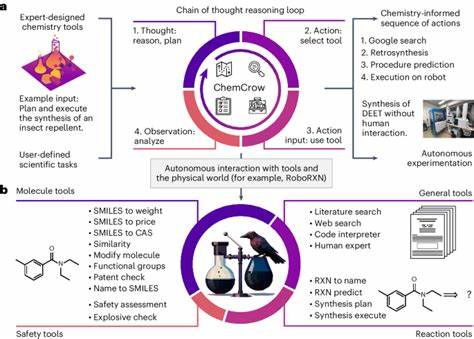

Dies bedeutet, dass das Einbinden von menschlicher Erfahrung und Vorlieben - sogenannte Preference-Tuning-Methoden - ein relevantender Forschungsbereich zur Verbesserung zukünftiger KI-Systeme sein dürfte. Ein wesentlicher Vorteil von LLMs liegt in ihrem Potenzial zur Verarbeitung und Analyse großer Datenmengen – insbesondere der enormen Textflut, die durch wissenschaftliche Publikationen entsteht. Dabei schöpfen sie Insights aus vielen Studien, die alleine von Menschen kaum zu überblicken wären. Dies ermöglicht die Entwicklung intelligenter Assistenzsysteme oder sogenannter Copiloten, die Chemikern bei komplexen Fragestellungen beratend zur Seite stehen und Vorschläge für neue Experimente geben können. Dennoch darf der Einsatz von LLMs in der Chemie nicht unkritisch erfolgen.

Besorgnis erregend ist das Risiko von Fehlinformationen oder sogar missbräuchlicher Nutzung. So könnten beispielsweise toxische oder gefährliche Substanzen gezielt entworfen werden. Daraus erwächst die Notwendigkeit, Sicherheitsmechanismen zu integrieren und den Umgang mit diesen Werkzeugen zu reglementieren. Auch stellt der breitere Nutzerkreis der KI – oft Personen mit weniger chemischem Hintergrund – eine Herausforderung dar, da falsche oder missverständliche Antworten ernsthafte Gefahren bergen können, etwa bei Anwendungen im Sicherheitsmanagement oder im Unterricht. Aus pädagogischer Sicht stellen die Ergebnisse ebenfalls eine Aufforderung dar, die Lehre zu überdenken.

Die Überlegenheit von LLMs bei der bloßen Wissenswiedergabe fordert eine stärkere Gewichtung von kritischem Denken, komplexer Analyse und praktischen Kompetenzen beim Chemieunterricht. Wenn Maschinen Fakten schneller abrufen können, wird die Fähigkeit, sie zu hinterfragen und kreativ anzuwenden, umso wichtiger. Die ChemBench-Studie offenbart darüber hinaus, dass die Modellleistung stark von ihrer Größe und den verfügbaren Trainingsdaten abhängt. Größere Modelle zeigen tendenziell bessere Leistungen, was mit bisherigen Beobachtungen aus anderen Bereichen übereinstimmt. Zugleich liegt darin ein Potenzial für weitere Fortschritte durch skalierte Modelle und gezielte Einbindung fachspezifischer Datenbanken wie PubChem oder Gestis zur Verbesserung der Faktengenauigkeit.

Die etablierte Benchmarking-Infrastruktur von ChemBench stellt einen wichtigen Meilenstein dar, um Fortschritte in der Entwicklung chemischer LLMs zu messen. Sie ermöglicht nicht nur den Vergleich verschiedener KI-Systeme untereinander, sondern auch die Orientierung an menschlichen Expertenleistungen. Diese transparenten Vergleichsmöglichkeiten sind essenziell, um zukünftige Modelle verantwortungsvoller und zielgerichteter zu gestalten. Zusammenfassend lässt sich sagen, dass große Sprachmodelle mittlerweile beachtliche Leistungen in der chemischen Wissensverarbeitung erbringen und in einigen Bereichen menschlichen Experten bereits ebenbürtig oder gar überlegen sind. Dennoch besitzen sie weiterhin signifikante Schwächen in Bezug auf komplexes Denken, die Einschätzung eigener Unsicherheiten und die Interpretation komplexer molekularer Strukturen.

Sie sollten daher als mächtige Werkzeuge betrachtet werden, die Chemikern ergänzend zur Seite stehen, jedoch nicht deren Expertise vollständig ersetzen. Die Verschmelzung von menschlicher Erfahrung mit den enormen Datenverarbeitungsmöglichkeiten der KI verspricht eine neue Ära in der Chemie, in der Entdeckungen beschleunigt und die Forschung effizienter gestaltet werden können. Gleichzeitig bedarf es einer sorgfältigen ethischen und fachlichen Begleitung, um den sicheren und verantwortungsvollen Einsatz dieser Technologien sicherzustellen. ChemBench bildet hier eine wertvolle Basis, um die Qualität und Zuverlässigkeit zukünftiger Systeme kontinuierlich zu evaluieren und zu verbessern.