In der Welt der künstlichen Intelligenz stellt die Neural Turing Machine (NTM) einen bedeutenden Meilenstein dar. Sie verbindet klassische Konzepte der formalen Berechenbarkeit mit den modernen Technologien neuronaler Netzwerke und erweitert damit die Grenzen dessen, was KI-Systeme leisten können. Die NTM ist inspiriert von der historischen Turing-Maschine, die in den 1930er Jahren von Alan Turing entworfen wurde. Diese abstrakte Maschine gilt als Fundament der theoretischen Informatik und definiert die Grenze dessen, was mit einem endlichen Satz von Regeln berechnet werden kann. Die NTM greift dieses Konzept auf und implementiert es als differentielles Modell, das auf neuronalen Netzwerken basiert und lernfähige Speicherzugriffe aufweist.

Dadurch eröffnen sich neue Möglichkeiten, komplexe algorithmische Aufgaben mit Lernverfahren zu bewältigen. Das Interesse an Turing-Maschinen resultiert aus ihrer universellen Rechenfähigkeit. Eine Maschine, die als Turing-vollständig bezeichnet wird, kann prinzipiell jede berechenbare Funktion umsetzen, sofern ausreichend Zeit und Speicher vorhanden sind. Diese Eigenschaft fasziniert nicht nur Theoretiker, sondern auch Praktiker in der Softwareentwicklung, da sie das Potenzial symbolisiert, alle denkbaren Algorithmen auszuführen. In diesem Zusammenhang ist die NTM ein Versuch, die Brücke zwischen der abstrakten Theorie und praktischer Anwendbarkeit in Lernsystemen zu schlagen.

Traditionelle neuronale Netze, insbesondere rekurrente Netzwerke (RNN) wie die LSTM-Architektur, stehen vor Herausforderungen wenn es um das Erlernen langanhaltender Abhängigkeiten und Speicheroperationen geht. Standard-RNNs müssen komplexe Informationen in einem begrenzten internen Zustand komprimieren, was häufig zu Informationsverlust und Schwierigkeiten beim Lernen längerer Sequenzen führt. LSTM-Netzwerke bemühen sich, durch spezialisierte Gate-Mechanismen Zustände über lange Zeiträume stabiler zu halten, doch auch sie stoßen bei extrem langen oder komplizierten Aufgaben an ihre Grenzen. Die Neural Turing Machine erweitert diese Architektur durch ein externes, differentielles Speicherarray, das als Arbeitsspeicher fungiert. Dieser Speicher kann in jeder Zeiteinheit dynamisch und differenzierbar gelesen und beschrieben werden.

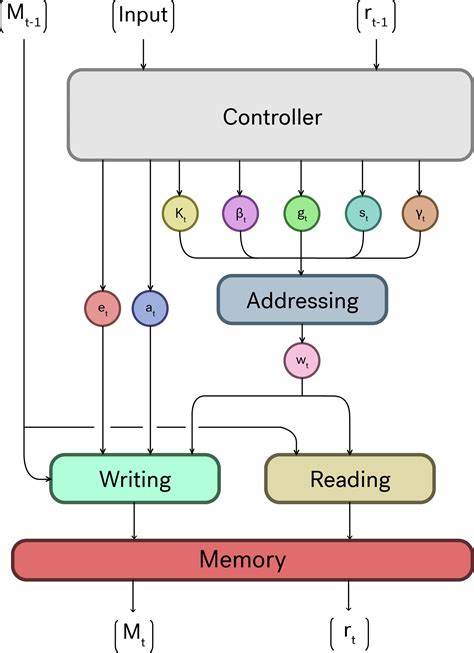

Das Modell enthält sogenannte „Köpfe“, die lesend und schreibend auf die Speicherzellen zugreifen und dabei zunächst gewichtete Adressierungsvektoren erzeugen. Diese Vektoren bestimmen die Aufmerksamkeit auf bestimmte Speicherbereiche, was im Kern dem Mechanismus der heutigen Attention-Modelle ähnelt. Die Fähigkeit, nicht nur auf Inhalte, sondern auch auf Speicherorte zuzugreifen, eröffnet eine flexiblere Steuerung von Datenflüssen als bei klassischen neuronalen Netzen. Ein besonders innovativer Aspekt der NTM liegt in der Kombination von zwei Adressierungsmodi: Inhalt- und positionsbasiertes Adressieren. Das inhaltsbasierte Adressieren ähnelt einem klassischen Suchvorgang, bei dem der Speicherinhalt mit einer Anfragerepräsentation verglichen wird, um relevante Daten zu finden.

Das positionsbasierte Adressieren erlaubt es dem Modell, die Speicherpositionen ringförmig zu verschieben und so sequenzielle wie auch algorithmische Operationen durchzuführen – vergleichbar mit den Zeigern einer Turing-Maschine, die die aktuelle Lese- oder Schreibposition entlang des Bandes definiert. Manche Aufgaben, insbesondere solche mit strikt symbolischem Charakter wie arithmetische Operationen, profitieren stark von dieser Hybridadressierung. Die Trainingsfähigkeit der NTM basiert auf der Differenzierbarkeit des gesamten Systems. Durch Backpropagation lernt das Modell, optimale Lese- und Schreibstrategien zu entwickeln, um vorgegebene Aufgaben zu lösen. Beispiele aus der Ursprungspublikation zeigen, dass NTMs Long-Context-Aufgaben wie das Kopieren langer Datenfolgen oder das Sortieren von Sequenzen deutlich besser bewältigen als reine LSTM-Modelle mit ähnlicher Komplexität.

Dies ist ein wichtiger Schritt hin zu lernfähigen Systemen, die nicht nur aus Beispielen generalisieren, sondern auch algorithmisches Denken simulieren können. Ein weiterführendes Gedankenexperiment vergleicht die Architektur eigentlicher Computer mit denen neuronaler Netze. Die NTM kann als eine Art vereinfachte CPU interpretiert werden, wobei der LSTM-Controller die Register und der externe Memoriespeicher das RAM darstellt. Diese Analogie hilft zu verstehen, wie modulare Systeme mit getrennten Funktionseinheiten effizienter komplexe Aufgaben ausführen können. Für die KI-Forschung bedeutet dies, dass zukünftige Systeme möglicherweise vermehrt hierarchisch und modular aufgebaut sind, um verschiedene Arten von Speicher und Rechenoperationen optimal zu kombinieren.

Trotz ihrer bahnbrechenden Natur bleibt die NTM nicht ohne Kritik. Einige Forscher weisen darauf hin, dass die Speicheradressierung und insbesondere die Positionierungsoperationen in der Praxis unscharfe Verteilungen erzeugen, was zu Schwierigkeiten bei präzisen symbolischen Operationen führt. Dies hat zur Folge, dass die NTM in gewissen Aufgaben Schwierigkeiten hat, explizite und deterministische Algorithmen zu lernen. Dennoch wurden diese Herausforderungen als Antrieb für die Weiterentwicklung neuer Architekturen wie Differentieller Computersysteme oder Memory-Augmented Networks genutzt. Die Bedeutung der NTM zeigt sich nicht zuletzt in ihrem starken Einfluss auf das Entstehen moderner Transformer-Modelle.

Viele Konzepte wie die multiple Aufmerksamkeit (Multi-Head Attention) und das gezielte Abrufen von Kontextinformationen lassen sich als Weiterentwicklung der NTM-Grundidee verstehen. Die Transformer-Architektur behält dabei die Fähigkeit bei, Informationen über große Kontextbereiche zu nutzen, ist jedoch durch parallele Verarbeitung und bessere Skalierbarkeit auf massive Datensätze optimiert. In der Praxis verändern Neural Turing Machines das Verständnis davon, wie Maschinen lernen können, Speicher und Algorithmen zu kombinieren. Sie sind ein Prototyp lernfähiger Modelle, die nicht nur bloße Mustererkennung betreiben, sondern auch algorithmische Prozesse aus Beispieldaten extrahieren können. Vor allem in Bereichen wie maschineller Übersetzung, Sequenzvorhersage oder automatischer Codegenerierung eröffnen sich damit neue Perspektiven.

Darüber hinaus liefert die NTM auch wertvolle Einblicke in die Neurowissenschaften. Das Konzept eines Arbeitsgedächtnisses, das selektiv Informationen speichert, abruft und manipuliert, hat Parallelen zu kognitiven Prozessen des menschlichen Gehirns. Während die exakten biologischen Mechanismen weiterhin erforscht werden, bietet die NTM ein mathematisches Modell, das sowohl algorithmisch plausibel als auch lernbar ist. Für Entwickler und Forscher bedeutet das Arbeiten mit NTMs, sich mit neuen Herausforderungen auseinanderzusetzen. Die Trainingsdynamik ist komplex, und die richtige Balance zwischen Speicheroperationen und Controllerfunktionen muss gefunden werden.

Auch wenn es noch keine weitverbreiteten Frameworks gibt, die direkt NTMs implementieren, dienen sie als Inspiration für eine Reihe von modifizierten Architekturen und hybriden Systemen. Die kontinuierliche Weiterentwicklung von Speicher- und Rechenarchitekturen in neuronalen Netzwerken spiegelt letztlich den Wunsch wider, Maschinen mit menschenähnlicher Flexibilität auszustatten. Neural Turing Machines tragen wesentlich dazu bei, dass KI-Systeme weg von statischer Datenverarbeitung hin zu adaptiver, algorithmischer Intelligenz wachsen können. Auch wenn die NTM selbst nicht die Allzwecklösung darstellt, zeigt sie den Weg auf, wie neuronale Netze und klassische Informatikkonzepte zusammengeführt werden können, um das Potenzial künstlicher Intelligenz grundlegend zu erweitern.