In den letzten Jahren hat die künstliche Intelligenz (KI) enorme Fortschritte gemacht – besonders im Bereich der natürlichen Sprachverarbeitung. Große Sprachmodelle, sogenannte Large Language Models (LLMs), haben dabei auch in der Chemie zunehmend an Bedeutung gewonnen. Sie werden genutzt, um komplexe Fragen zu beantworten, chemische Reaktionen zu analysieren oder gar neue Verbindungen zu entwerfen. Doch wie gut schneiden diese KI-Systeme im Vergleich zu menschlichen Experten ab? Können sie die Fachkompetenz von Chemikern wirklich ersetzen oder ergänzen? Diese Fragestellung gewinnt an Brisanz, denn die Anwendung von LLMs birgt sowohl Potenziale als auch Risiken für die chemische Wissenschaft und ihre Ausbildung. Große Sprachmodelle basieren auf maschinellem Lernen und wurden mit riesigen Textmengen aus unterschiedlichsten Quellen trainiert.

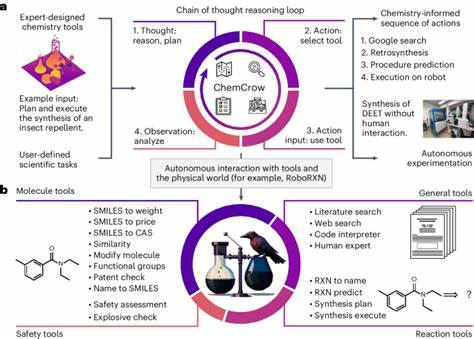

Dabei lernen sie Sprachmuster, Kontextbezüge und sogar implizite Hintergrundinformationen. In der Chemie bedeutet dies, dass sie Wissen aus Fachliteratur, Publikationen, Datenbanken und Lehrmaterialien aufnehmen, um dann auf konkrete Fragestellungen zu reagieren. Die Fähigkeit, komplexe Textinformationen zu verarbeiten und daraus Antworten zu generieren, macht LLMs zu einem vielversprechenden Werkzeug für Forscher und Praktiker. Ein teamübergreifendes Forschungsvorhaben entwickelte das Benchmarking-Framework ChemBench, um chemisches Wissen und die Fähigkeit zum logischen Schlussfolgern von LLMs objektiv zu bewerten. Mit mehr als 2.

700 Fragen aus unterschiedlichen chemischen Disziplinen, welche sowohl auf Faktenwissen als auch auf komplexer Problemlösung basieren, wurde sowohl die Leistung gängiger KI-Modelle als auch die von Fachchemikern verglichen. Die Ergebnisse überraschten: Das leistungsfähigste Modell konnte die besten Chemiker in bestimmten Bereichen sogar übertreffen. Dies verdeutlicht, dass LLMs inzwischen auf einem Niveau agieren, das zuvor nur Experten vorbehalten war. Dabei überrascht die Tatsache, dass einige der Modelle auch mit offenen, quelloffenen Ansätzen mithalten konnten, was die Zugänglichkeit und Weiterentwicklung in der wissenschaftlichen Gemeinschaft erleichtert. Offene Modelle wie Llama-3.

1 zeigen, dass nicht nur proprietäre Systeme wahre Leistungsträger sein können, sondern auch offene Projekte rasch aufschließen und in der Forschung eine wichtige Rolle spielen. Trotz dieser beeindruckenden Erfolge zeigen LLMs weiterhin Schwächen in Grundfertigkeiten und sicherheitsrelevanten Themen. Zum Beispiel ist das Erkennen chemischer Strukturen und deren Symmetrie zur Interpretation von Spektren wie der Kernspinresonanz (NMR) noch immer herausfordernd. Die Modelle arbeiten vorwiegend auf Textbasis und nutzen chemische Strukturen wie SMILES-Codes, jedoch fehlt die intuitive räumliche Vorstellung, die Chemiker aus jahrelanger Ausbildung besitzen. Auch in Bereichen wie chemischer Toxizität und Sicherheit sind die Antworten häufig unsicher oder gar falsch.

Diese Defizite betonen, dass die KI keinesfalls blind vertraut werden darf, sondern immer eine kritische Überprüfung durch Experten notwendig bleibt. Eine weitere Herausforderung ist die übermäßige Zuversicht, mit der manche LLMs ihre Antworten liefern. Untersuchungen zeigten, dass die Modelle oft keine verlässliche Selbsteinschätzung bezüglich ihrer Antwortsicherheit besitzen. So kam es vor, dass Fragen mit falschen Antworten besonders selbstbewusst beantwortet wurden, was gerade bei sicherheitsrelevanten Themen fatal sein kann. Eine mangelnde Kalibrierung der Vertrauenswerte limitiert damit den Einsatz der Modelle in sensiblen Bereichen und unterstreicht die Notwendigkeit, KI-gestützte Systeme mit Mechanismen zur Unsicherheitsabschätzung auszustatten.

Die Geschwindigkeit und Effizienz von LLMs können jedoch nicht ignoriert werden. Sie können innerhalb von Sekunden auf ein enorm breites Spektrum von Fragen reagieren, eine Vielzahl an Literaturquellen verarbeiten und bislang unerschlossene Zusammenhänge erkennen. Dies eröffnet Chancen für eine neue Art von Assistenzsystem – sogenannte Copilot-Systeme –, die Chemikern bei Forschung und Lehre unterstützend zur Seite stehen und administrative oder repetitive Aufgaben übernehmen. Die Integration von LLMs in den wissenschaftlichen Alltag sollte aber unter Berücksichtigung ethischer und sicherheitstechnischer Aspekte erfolgen. Beispielsweise besteht die Gefahr des Missbrauchs, wenn LLMs verwendet werden, um potenziell gefährliche Moleküle zu entwerfen oder irreführende Informationen zu verbreiten.

Daher ist es essenziell, dass die Entwickler solcher Systeme Schutzmechanismen implementieren und klare Anwendungskonzepte definiert werden. Zudem besitzt die breite Nutzerschaft dieser Technologien, zu der auch Studierende und Laien gehören, nur selten die nötige chemische Fachkompetenz, um Fehler zu erkennen. Dies erfordert zusätzliche Maßnahmen zur Benutzeraufklärung und zur Förderung kritisch-reflektierender Kompetenz im Umgang mit KI-gestützten Antworten. Das durch ChemBench etablierte Framework ermöglicht eine systematische Bewertung von LLMs in der Chemie und kann als Standard für zukünftige Entwicklungen dienen. Durch die Kombination von manueller und semi-automatischer Kuratierung beinhaltet dieser Benchmark nicht nur klassische Multiple-Choice-Fragen, wie sie in Prüfungen üblich sind, sondern auch offene, komplexe Aufgaben, die echtes Verständnis und mehrstufige Schlussfolgerungen erfordern.

Diese Vielseitigkeit sorgt für eine authentische Abbildung der chemischen Kompetenz, die weit über bloße Faktenwiedergabe hinausgeht. Der Erfolg von LLMs fordert auch eine Neubewertung der Chemieausbildung. Da sie routinemäßiges Faktenwissen schneller und umfassender abrufen können als Menschen, rückt das Fördern von kritischem Denken, komplexer Problemlösung und kreativer Forschung stärker in den Mittelpunkt. Dies bestätigt den Wert menschlicher Expertise bei der Interpretation, Bewertung und innovativen Nutzung von wissenschaftlichen Erkenntnissen. Darüber hinaus ist die Zusammenarbeit zwischen LLMs und Chemikern vielversprechend.

Während KI-Systeme breite Datenmengen und Fakten effizient verarbeiten, bringen Experten ihre fundierte Erfahrung und Intuition ein, besonders bei schwer messbaren Aspekten wie chemischer Präferenz in der Wirkstoffentwicklung oder beim Umgang mit Unsicherheiten. Erste Untersuchungen zeigten, dass LLMs bisher beim Simulieren menschlicher Präferenzen oft nur zufällig richtig liegen und hier noch großer Forschungsbedarf besteht. Die technische Umsetzung von ChemBench berücksichtigte zudem die Besonderheiten chemischer Informationsdarstellung. Moleküle werden beispielsweise in standardisierten Formaten wie SMILES gekennzeichnet, die durch spezielle Tags vom restlichen Text abgesondert und vom Modell gezielt behandelt werden. Dies ermöglicht eine präzisere Verarbeitung chemischer Inhalte und gewährleistet, dass die Modelle nicht nur Sprachmuster, sondern auch strukturierte wissenschaftliche Daten sinnvoll integrieren können.

Modelle wurden unter Berücksichtigung verschiedener Trainingsgrößen, Architekturtypen und Augmentierungen mit externen Werkzeugen getestet. Die Skalierung der Modelle zeigt den erwarteten positiven Einfluss auf die Leistungsfähigkeit, jedoch nicht in allen Themengebieten gleichermaßen stark. So bleibt gerade in spezialisierten Gebieten wie Sicherheitschemie oder analytischer Chemie zusätzlicher Trainings- und Entwicklungsbedarf. Die laufende Erforschung großer Sprachmodelle im Chemiebereich deutet darauf hin, dass Zielsysteme einerseits den reinen Wissensabruf verbessern, andererseits aber insbesondere bei komplexen Denkprozessen und ethisch sensiblen Anwendungsfällen auf menschliche Expertise angewiesen sein werden. Dabei bleibt es wichtig, dass LLMs nicht als Ersatz, sondern als leistungsfähige Assistenzwerkzeuge verstanden werden.

Auf diese Weise können sie die Produktivität von Forschern erhöhen, Fehlerquellen minimieren und die Kreativität bei der Lösung bislang ungelöster wissenschaftlicher Probleme fördern. Insgesamt zeigt der Vergleich zwischen großen Sprachmodellen und menschlichen Chemikern ein Bild der komplementären Stärken. Die künstliche Intelligenz zeichnet sich durch breite, schnelle Wissensverarbeitung aus, während der Mensch durch tiefes, domänenspezifisches Verständnis und kritisches Urteilsvermögen überzeugt. Die Zukunft der Chemie wird davon geprägt sein, wie gut diese beiden Welten miteinander integriert werden und wie sicher und verantwortungsvoll der Umgang mit künstlicher Intelligenz erfolgt. Das Verständnis der Möglichkeiten und Grenzen von LLMs im chemischen Kontext ist entscheidend, um die Technologie zielgerichtet weiterzuentwickeln und auf dem neuesten Stand der Forschung zu halten.

Frameworks wie ChemBench bieten dazu eine wertvolle Grundlage. Gleichzeitig ruft die rasante Entwicklung der KI zur Reflexion über Ausbildung, Ethik und Sicherheit in der Chemie auf und eröffnet neue Wege für eine innovative, aber zugleich verantwortungsvolle wissenschaftliche Praxis.