Legion ist weit mehr als ein einfaches Softwareprojekt – es ist eine bahnbrechende Forschungsexpedition, die darauf abzielt, das Programmieren von Supercomputern grundlegend zu vereinfachen und gleichzeitig Höchstleistung sowie Skalierbarkeit zu gewährleisten. Die Entstehung und Weiterentwicklung von Legion, eines verteilten, heterogenen Programmierungssystems für Hochleistungsrechner (HPC), ist ein aufschlussreicher Spiegel dafür, wie Forschungsprojekte sich über die Jahre hinweg vermehren, gedeihen und sich überwinden müssen, um letztendlich einen nachhaltigen Einfluss auf die Computerwissenschaften zu haben. Der Intrinsische Wert von Legion liegt in seiner Fähigkeit, technische Komplexität der Parallelprogrammierung zu abstrahieren, indem es eine implizite Parallelität bietet. Anwender müssen sich nicht um die granularen und oft fehleranfälligen Details der Aufgabenverteilung, Datenbewegung oder Synchronisation kümmern, sondern können sich auf die reine Logik ihrer Anwendungen konzentrieren. Dabei zeichnet sich Legion besonders durch seinen außergewöhnlich flexiblen Datenmodellierungsansatz aus, welcher es ermöglicht, Daten in hochgradig anpassbaren Partitionen abzubilden – eine besondere Eigenschaft im Vergleich mit anderen HPC-Systemen.

Die Reise von Legion begann am Stanford University im Jahr 2011, als Elliott Slaughter als Doktorand für das Projekt begeistert wurde. Zu diesem frühen Zeitpunkt existierte bereits ein erster Prototyp, aber die Softwarebasis war alles andere als stabil. Fehler im Code, fehlende Anwendungen und unzureichende Skalierbarkeit prägten die anfängliche Phase. Die laufende Integration von experimentellen Programmen mit der Arbeit an der Runtime sowie der konsistente Dialog zwischen den Entwicklerteams waren entscheidend, um das Fundament zu legen. Wie es oft bei wissenschaftlicher Arbeit der Fall ist, war die Veröffentlichung der Forschungsergebnisse kein linearer oder einfacher Prozess.

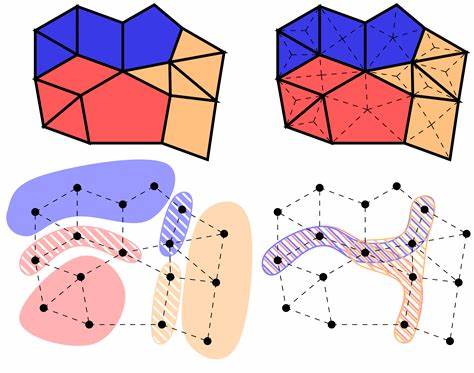

Jedes wissenschaftliche Papier, das über Legion verfasst wurde, durchlief mehrere Ablehnungszyklen. Diese Rückschläge dienten jedoch als wertvolle Lernmomenten, die halfen, die Forschung zu schärfen, Klarheit über die Beiträge zu schaffen und letztlich stärkere Dokumentationen zu liefern. Es zeigt sich damit auch eine weniger oft beleuchtete Seite von Forschung: der Kampf gegen die Unzulänglichkeiten, das Scheitern und die notwendige Beharrlichkeit. Ein Meilenstein war die Einführung des so genannten "Structure Slicing" im Jahr 2014, bei dem die Legion-Laufzeit komplett neu geschrieben wurde. Die Erkenntnis, dass oft nur Teilbereiche von komplexen Datenstrukturen für einzelne Berechnungsschritte benötigt werden, führte zu einer deutlichen Effizienzsteigerung durch gezielten Datenversand.

Diese Neuerung bedeutete gleichzeitig eine neue Dimension an Komplexität, da Legion nun genau nachverfolgen musste, welche Datenfelder wo wann benötigt wurden. Parallel zur fortschreitenden Entwicklung wuchs auch der Wunsch, die programmatische Nutzung von Legion zu vereinfachen. Ursprünglich war Legion ausschließlich über C++ zugänglich, was sich als komplex und fehleranfällig herausstellte. Die Entwicklung der Programmiersprache Regent, die auf Legion aufsetzt, bot einen höheren Abstraktionsgrad, automatisierte viele Optimierungen und vereinfachte die Programmierung. Die Geschichte von Regent ist dabei gezeichnet von Herausforderungen, vor allem durch Performance-Probleme initialer Compiler, die zu einer 10.

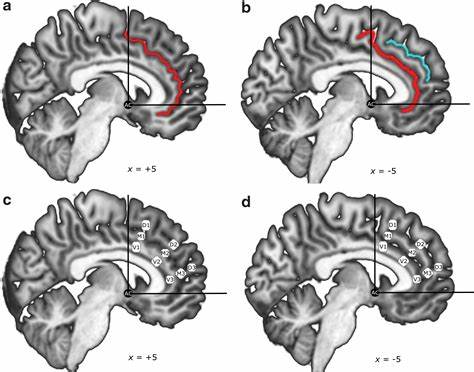

000-fachen Verlangsamung gegenüber konventionellem Code führten. Durch intensive Arbeit konnte diese Performance jedoch drastisch verbessert werden, sodass Regent schließlich eine attraktive Alternative für die HPC-Programmierung wurde. Eine der Kerninnovationen zur verbesserten Skalierbarkeit bei Legion ist die sogenannte "Control Replication". Bis zu ihrer Einführung konnte Legion nur bei sehr spezifischen Anwendungen gut skaliert werden, was eine breite Anwendung erschwerte. Der Optimierungsansatz verwandelt Code so, dass er explizite Parallelität und effizienten Datenaustausch ermöglicht, auch wenn dies die ursprünglich implizite Parallelitätsabstraktion ein Stück weit aufbricht.

Dennoch rettete diese Technik das Projekt, da sie echtes Skalierungspotential eröffnete und Legion die Möglichkeit gab, auf Hunderten von Knoten zu laufen. Nicht weniger beeindruckend ist das Konzept des "Dependent Partitioning" – eine ausgefeilte Datenpartitionierungsmethode, die auf der Idee basiert, dass bestimmte Partitionen aus anderen abgeleitet werden können. Dies erlaubt nicht nur eine erhebliche Vereinfachung der Programmierung, sondern bietet auch Performancegewinne durch automatisierte und parallele Auswertung. Mit zunehmendem Fortschritt sank der Fokus nicht nur auf reine Forschung sondern auch auf Softwarequalität und Nachhaltigkeit. Legion wandelte sich von einem akademischen Prototyp zu einem stabilen Softwareprodukt, das tatsächlich in der Industrie, beispielsweise bei NVIDIA, genutzt wird.

Dies erforderte den Aufbau einer rigorosen kontinuierlichen Integrationsinfrastruktur, automatische Testsuites, fortlaufende Wartung und eine Reduktion von technischem Schuldensaldo. Der Wandel von einem "Forschungsprojekt" hin zu langfristiger Softwareentwicklung ist eine Leistung, die Legion auszeichnet und den Erfolg langfristig sichert. Im Laufe der Jahre konnten zahlreiche innovative Techniken, wie "Dynamic Control Replication" und "Index Launches", eingeführt werden, die Legion weiter optimierten und neue Anwendungsfelder erschlossen. War es anfangs oft eine Herausforderung, die Komplexität der internen Algorithmen und Strukturen so zu kommunizieren, dass Fachkonferenzen diese anerkannten, so wurden die Papiere letztlich immer klarer und erfolgreicher. Dies spiegelt den Lernprozess wider, wie essenziell eine verständliche, klare Darlegung von Ergebnissen neben exzellenter Technik ist.

Die Community von Legion wurde über die Jahre ebenso zu einem tragenden Faktor. Die frühesten Entwickler wie Mike Bauer und Sean Treichler setzten ihre Arbeit über das Studium hinaus fort, was der Kontinuität des Projektes enormen Auftrieb verlieh. Zudem wurden neue Talente eingebunden, die frischen Enthusiasmus und neue Perspektiven einbrachten, wie zum Beispiel junge Studierende, die wichtige Beiträge in späteren Phasen leisteten. Neben den technologischen Errungenschaften spiegelt die Geschichte von Legion auch eine ehrliche und seltene Erkenntnis wider: Forschung und Softwareentwicklung sind keine geradlinigen Prozesse. Ablehnungen, Fehlschläge, Borhungen in der Softwarequalität und das Überwinden fundamentaler Probleme prägen den Weg zum Erfolg.

Diese Realität zeigt, wie hartnäckig und engagiert Forscher sein müssen, um am Ende Meilensteine zu setzen, die nicht nur akademisch, sondern auch praktisch und wirtschaftlich relevant sind. Die strategische Entscheidung, Legion als offenen Entwicklungsprozess mit kontinuierlicher Integration zu betreiben, hat eine nachhaltige Basis geschaffen, die bis heute weiter entwickelt wird. Nicht zuletzt erlaubt dieser Ansatz reibungslose Zusammenarbeit und schnellere Fehlerbehebung, was besonders in komplexen Systemen eine kritische Rolle spielt. Durch die Verbindung differenzierter Kompetenzen in Sprache, Compiler, Laufzeit und HPC-Expertise konnte Legion ein System werden, das theoretische Innovationen mit praktischer Anwendbarkeit vereint. Die neuesten Fortschritte und Forschungen, die bis in 2023 reichen, zeigen, dass die technologische Entwicklung im Bereich verteilte HPC-Systeme noch lange nicht abgeschlossen ist.

Im Gegenteil, Legion läuft heute auf den derzeit leistungsstärksten Supercomputern wie Frontier und beweist damit eindrucksvoll seine Skalierbarkeit und Leistungsfähigkeit in der Praxis. Für die Zukunft kündigt sich für Legion noch viel mehr an. Der Wunsch, weitere Beiträge zur Programmiermodellierung, zur automatischen Optimierung und zur Weiterentwicklung der Softwarebasis zu leisten, bleibt stark. Erfahrene Entwickler und Nachwuchswissenschaftler arbeiten zusammen daran, Legion nicht nur am Puls der HPC-Entwicklung zu halten, sondern auch neue Maßstäbe zu setzen. Unterm Strich ist Legion ein Paradebeispiel für ein Forschungsprojekt, das durch Beharrlichkeit, Innovation und eine enge Verzahnung von Theorie und Praxis die Grenzen wissenschaftlicher und technischer Machbarkeit erfolgreich verschoben hat.

Es unterstreicht die Bedeutung einer offenen Kultur, exzellenter Führung und einer konsequenten Verfolgung einer gemeinsamen Vision. Die persönliche Geschichte von Elliott Slaughter und seinen Kollegen eröffnet einen seltenen Einblick in den langen, intensiven Weg hinter scheinbar mühelosen und erfolgreichen Forschungsresultaten – eine Geschichte, die Inspiration und wertvolle Lektionen für Entwickler, Wissenschaftler und alle Interessierten bereithält, die sich mit komplexer Softwareentwicklung im Bereich Hochleistungsrechnen beschäftigen.