Die Wahl der richtigen Datenbank ist für Unternehmen heute entscheidender denn je. Während einige Projekte auf verteilte Datenbanklösungen setzen, gewinnt PostgreSQL, eine der ältesten und am weitesten verbreiteten relationalen Datenbanken, zunehmend an Bedeutung. Die Migration von komplexen verteilten Systemen wie CockroachDB zu PostgreSQL ist ein Prozess, der zahlreiche technische und betriebliche Fragestellungen aufwirft. In der Praxis zeigt sich, dass auch große Anwendungen von den Vorteilen eines sorgfältig geplanten Wechsels zu PostgreSQL profitieren können. Viele Unternehmen sind anfangs von verteilten Datenbanken fasziniert, vor allem wegen ihrer Skalierbarkeit und hohen Verfügbarkeit über mehrere Regionen hinweg.

CockroachDB beispielsweise stellt genau diese Eigenschaften in den Vordergrund und ist dadurch attraktiv für Projekte, die Datenlokalisierungen und Multi-Region-Setups benötigen. Dennoch kann diese verteilte Architektur speziell für einzelne Regionen und vergleichsweise einfache Transaktionsabfragen mit höherem Kosten- und Komplexitätsaufwand verbunden sein. Ein bedeutender Aspekt beim Umstieg von CockroachDB auf PostgreSQL ist daher das Abwägen zwischen Skalierungsnotwendigkeiten und Betriebskosten. Ein gravierender Treiber für viele Migrationen sind steigende Kosten. Die Abrechnung einer verteilten Datenbank kann mit wachsendem Datenvolumen schnell exponentiell steigen, was sich durch höhere Abfragenlast, größere Datenmengen und zusätzliche Infrastrukturkomplexität weiter verstärkt.

Im Vergleich dazu überzeugt PostgreSQL durch äußerst kosteneffiziente Bereitstellung, selbst bei sehr großen Datenbanken mit mehreren hundert Millionen Datensätzen. Durch den Wegfall verteilter Architekturkomponenten lassen sich außerdem Verwaltung und Betrieb deutlich vereinfachen. Technisch stehen beim Wechsel von CockroachDB zu PostgreSQL vor allem Migrationsprozesse im Fokus, die möglichst reibungslos ablaufen sollten. Eines der größten Probleme bei CockroachDB ist der Umgang mit Datenbankmigrationen. Die ORM-Tools wie Prisma zeigen hier mit zunehmender Datenbankgröße Probleme: Zeitüberschreitungen führen zu langen Blockaden beim Deployment und erfordern oft manuelle Eingriffe mit parallelen Migrationen auf Datenbankebene.

Diese Herausforderungen führen nicht selten zu betriebsbedingten Kompromissen wie dem vermeidenden Einsatz von Features im Datenbanksystem, was letztlich die Entwicklungsgeschwindigkeit hemmt. Im Vergleich dazu erweist sich PostgreSQL bei ähnlichen Migrationen als außerordentlich schnell und zuverlässig. Die gleiche Änderung in einem großen Produktionsdatenbestand ist oft in Sekunden umgesetzt, was zu deutlich kürzeren Wartungsfenstern und geringeren Risiken bei Deployments führt. Diese Effizienzsteigerung erlaubt es Entwicklerteams, Migrationen ohne Angst vor Systemverriegelungen oder Timeouts produktiv einzusetzen. Dies zeigt den praktischen Nutzen einer traditionellen relationalen Datenbank in Bezug auf Stabilität und Entwicklerfreundlichkeit.

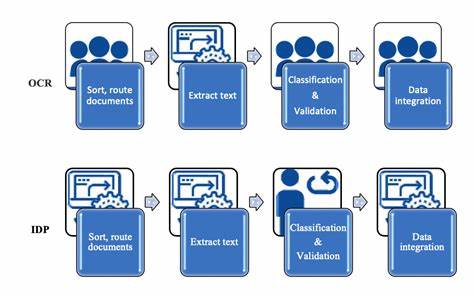

Ein weiterer kritischer Punkt sind ETL-Prozesse (Extract, Transform, Load), die für Datenintegration, Reporting oder Backups unverzichtbar sind. Bei CockroachDB stellen insbesondere zeitgesteuerte ETL-Jobs häufig eine Fehlerquelle dar. Die verfügbare Softwareunterstützung ist stark eingeschränkt, und beispielsweise der offizielle Airbyte-Konnektor befand sich lange Zeit im Alpha-Stadium und war sogar von Speicherlecks betroffen. Dies führte zu Ausfällen und Performanceproblemen im Datenfluss. Die limitierten Tools erschweren zudem die Automatisierung und erhöhen die manuelle Überwachung der Datenpipelines.

Im Gegensatz dazu profitiert PostgreSQL von einer lebendigen Ökosystemlandschaft mit ausgereiften ETL-Lösungen und stabilen Konnektoren, die unzählige Integrationen ermöglichen. Mit Frontends, Analyse-Tools und Frameworks lässt sich eine effiziente Datenverarbeitung etablieren, die auch bei wachsender Last performant und wartbar bleibt. Hinsichtlich der Abfrageperformance offenbaren sich teils überraschende Beobachtungen. CockroachDB punktet zwar bei einigen speziellen Abfragen, deren Optimierungsalgorithmen gut auf verteilte Strukturen abgestimmt sind, jedoch führt die Kombination aus Prisma-generiertem, komplexem SQL und CockroachDBs Query Planner häufig zu äußerst langen Antwortzeiten in der Praxis. Häufig generieren ORMs verschachtelte, ausufernde Abfragen mit zahlreichen Joins und Bedingungen, die bei CockroachDB teilweise einen Full Table Scan erzwingen.

Diese wiederum führen zu deutlichen Performanceeinbußen, die in einigen Beispielen bis zum Zwanzigfachen langsamer als bei PostgreSQL ausfallen. Damit zeigt sich, dass die vermeintliche „Magie“ des CockroachDB-Optimierers in realen Anwendungsszenarien nicht immer zum Tragen kommt und statt Ausführungsgeschwindigkeit ein hoher Ressourcenverbrauch resultiert. PostgreSQL wiederum überzeugt hier durch eine ausgereifte, bewährte Optimierungsarchitektur, die mit komplexem SQL und großen Joins besser fertig wird und so die Antwortzeiten signifikant senkt. Auch die Bedienung und das Management der Systeme spielen eine wichtige Rolle. CockroachDB-Nutzer berichten häufig von einer umständlichen Bedienung des Support-Portals, das getrennt von der Hauptseite läuft und lange Antwortzeiten aufweist.

Komplexe Vorgänge wie das Abbrechen laufender, teurer Queries erfordern einen Login in die Admin-Konsole und sind weniger benutzerfreundlich. Im Gegensatz dazu punktet PostgreSQL mit vielen bekannten und einfach nutzbaren Tools, wie TablePlus oder pgAdmin, die direkte Abbruchfunktionen und Administrative Aufgaben leicht handhabbar machen. Außerdem wurde bei CockroachDB die Stabilität der Netzwerkverbindungen über VPN-Lösungen wie Tailscale immer wieder als problematisch beschrieben. Immer wiederkehrende Fehler bei der DNS-Auflösung führten zu temporären Ausfällen der Datenbankverbindung in verschiedenen Umgebungen – von lokalen Clients bis hin zu CI-Systemen. PostgreSQL hingegen zeigte sich in vergleichbaren Infrastrukturen als deutlich robuster und störungsfreier.

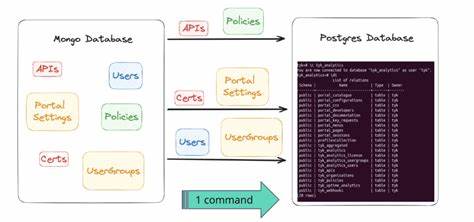

Die eigentliche Migration großer Datenbankbestände stellt einen besonderen Meilenstein dar. Projekte mit über hundert Millionen Datensätzen erfordern effiziente Extrahierungs- und Ladelösungen, die eine Ausfallzeit minimieren. Da es für CockroachDB kaum etablierte ETL-Werkzeuge gibt, mussten eigene Migrationstools entwickelt werden. Moderne Entwicklungen wie scripting mit Bun erlaubten es, die Daten zunächst tabellenweise zu exportieren, diese dann als CSV-Datenströme sequentiell zu lesen und gleichzeitig in PostgreSQL einzuspielen. Dabei trat zutage, dass Datenformate, beispielweise bei JSON- und Array-spalten, zwischen CockroachDB und PostgreSQL nicht 1:1 kompatibel sind.

Es waren zusätzliche Transformationsschritte notwendig, um die Kompatibilität sicherzustellen und Datenintegrität zu gewährleisten. Trotz komplexer Herausforderungen gelang der produktive Cutover mit einer Downtime von unter einer Stunde, was angesichts des Datenvolumens als sehr gute Performance gilt. Nach der Migration zeigte sich unmittelbar eine erhebliche Verbesserung der Gesamtperformance, insbesondere ein deutlicher Rückgang der aggregierten Latenz bei Anfragen. Zusätzlich konnten durch das umfangreiche Postgres Tooling zahlreiche bisher nicht optimierte Abfragen innerhalb weniger Stunden identifiziert und angepasst werden. Finanziell betrachtet sparte der Wechsel zu PostgreSQL wichtige Betriebskosten ein, die sich auf über 110.

000 US-Dollar pro Jahr summierten und mit wachsendem Traffic weiter steigen würden. Auch die Stabilität, einfachere Wartung und eine erheblich bessere Entwicklererfahrung flossen in die Bilanz ein. Für Unternehmen, die heute skalierbare, performante und wirtschaftliche Datenbanklösungen suchen, stellt PostgreSQL eine äußerst attraktive Alternative dar. Die Kombination aus Stabilität, Performance, großer Community und einem reichen Ökosystem macht es möglich, auch sehr große Anwendungen sicher zu betreiben und gleichzeitig Entwicklungsteams mehr Freiheit und Innovationskraft zu geben. Natürlich ist nicht jede Migration trivial und Erfolg setzt eine sorgfältige Planung, gutes Verständnis der Quell- und Zielsysteme sowie Praxiswissen rund um Datenschemata, Transformationsprozesse und Performance-Optimierungen voraus.

Doch zeigt das Beispiel von Motion, wie in einem pragmatischen, iterativen und technisch versierten Prozess ein komplexer Wechsel gelingen kann. Besonders lohnt sich ein genauer Blick auf mögliche Query-Engines, ORMs und die zugrundeliegende SQL-Generierung, da gerade hier viele Performance-Hotspots entstehen. Tools zur Analyse und Monitoring wie PGAnalyze erlauben es, Systemzustände nach der Migration präzise zu bewerten und Optimierungen schnell zu identifizieren. Zusammenfassend kann gesagt werden, dass die Migration von verteilten Systemen wie CockroachDB hin zu PostgreSQL für viele Unternehmen eine Chance darstellt, Kosten zu sparen, Performance zu erhöhen und betriebliche Komplexität zu reduzieren. Wer anspruchsvolle Datenbestände verwaltet und dabei Wert auf Verlässlichkeit, Performance und eine breite Toolpalette legt, findet in PostgreSQL einen zuverlässigen Partner für die Zukunft.

Der Trend zeigt, dass sich Postgres vor allem in Szenarien mit Single-Region Setups, komplexen relationalen Abfragen und hohem Datenvolumen durchgesetzt hat, während verteilte Datenbanken nach wie vor bei global verteilten Anwendungen mit strengen Datenlokalisierungen oder extremen Verfügbarkeitsanforderungen ihre Daseinsberechtigung haben. Unternehmen sollten ihre Anforderungen, Kostenstruktur und vorhandene Expertise sorgsam abwägen, bevor sie sich für den Wechsel entscheiden. Die hier geschilderten Erfahrungen und Erkenntnisse können dabei als wertvolle Orientierung dienen und den Weg zu einer erfolgreichen Migration ebnen.