Die Wahl der richtigen Datenbankplattform ist für moderne Unternehmen von entscheidender Bedeutung und beeinflusst maßgeblich die Performance, Skalierbarkeit sowie die Betriebskosten der Anwendungen. In den letzten Jahren hat CockroachDB als verteilte, skalierbare SQL-Lösung vor allem bei Firmen mit anspruchsvollen Mehrregionen-Anforderungen und hohen Verfügbarkeitsansprüchen an Bedeutung gewonnen. Dennoch treten mit zunehmendem Wachstum der Datenmengen und steigender Komplexität der Abfragen immer mehr Grenzen zutage, die den Einsatz von CockroachDB infrage stellen. Dies zeigt sich vor allem bei hohen Kosten, Performance-Einbußen und schwierigen Migrationen. Ein deutlicher Trend zeichnet sich ab: Der Wechsel zurück zu Postgres als bewährte, leistungsstarke und kosteneffiziente Alternative.

CockroachDB wird häufig für seine mühelose horizontale Skalierbarkeit und hohe Ausfallsicherheit gelobt, welche gerade bei verteilten Multi-Regionen Setups relevant sind. Für Unternehmen, die sich mit komplexen regulatorischen Anforderungen wie der Datenschutz-Grundverordnung (GDPR) auseinandersetzen, war es lange eine passende Wahl. Doch die Realität zeigt, dass in manchen Situationen diese Vorteile weniger ins Gewicht fallen und andere Faktoren eine größere Rolle spielen. Ein Beispiel hierfür ist Motion, ein Unternehmen, das bis Anfang 2022 auf CockroachDB gesetzt hat. Obwohl zu Beginn Zweifel herrschten, ob eine traditionelle Postgres-Datenbank mit einer Multi-Region-Strategie mithalten kann, war der eigentliche Grund für die Migration die explodierende Kostenstruktur und die zunehmenden Schwächen im Betrieb.

Die Kostensteigerung bei Motion war signifikant: Bis 2024 hatten sich die Datenbankausgaben bei CockroachDB auf fünfstellige Summen im mittleren sechsstelligen Bereich vervielfacht. Gleichzeitig zeigte sich, dass die Multi-Region-Attribute der Datenbank nicht wirklich benötigt wurden, da kein Kunde eine explizite Datenlokalisierung verlangte und das System nur in einer Region operierte. Die Abfragen waren eher einfach und transaktional, weshalb das volle Potenzial einer verteilten Datenbank nicht ausgeschöpft wurde. In einem solchen Use-Case lohnte sich der finanzielle und technische Aufwand einer verteilten Architektur zunehmend weniger. Ein entscheidender Faktor für eine reibungslose Umstellung war bei Motion der Einsatz eines Object-Relational Mappers (ORM) namens Prisma.

Dieser ermöglichte es, Migrationsszenarien schnell zu testen und zu vergleichen. Migrationsprozesse auf CockroachDB waren oft von Zeitüberschreitungen geprägt, die Deployments blockierten und den Entwicklungsfluss erheblich einschränkten. Massive Tabellenänderungen, wie etwa das Hinzufügen einer neuen Spalte auf einer stark frequentierten Tabelle, dauerten auf CockroachDB oft zwei Stunden oder länger und zwangen Entwickler manuell eingreifen zu müssen. Im Vergleich dazu zeigte sich Postgres um ein Vielfaches performant: Dieselbe Migration auf einer kontrollierten Datenbankkopie dauerte nur wenige Sekunden. Diese drastischen Unterschiede führten zu betrieblichen Workarounds, etwa dem bewussten Ausweichen auf operationelle Maßnahmen außerhalb der Datenbank, um Sperren und Systemblockaden zu vermeiden.

Weiterhin blockierten die Probleme auch die Aktualisierung von CockroachDB auf neuere Versionen, da längere Migrationsprozesse und Zeitüberschreitungen den Betrieb lähmten. Das Unternehmen entschied sich daher für die Migration zur verlässlicheren Postgres-Datenbank und beließ CockroachDB letztlich in einer alten und nicht mehr unterstützten Version. Auch ETL- und Datenintegrationsprozesse litten unter den Problemen mit CockroachDB. Die begrenzte Verfügbarkeit stabiler ETL-Tools, etwa der noch im Alpha-Stadium befindlichen Airbyte-Connectoren, sorgte für häufige Ausfälle und schlechte Performance. Zudem verursachte der Airbyte-Connector im Produktiveinsatz einen Speicherleck, was zu regelmäßigen Alarmen führte.

Die begrenzte Tool-Unterstützung für Datenreplikationen unter CockroachDB stellte eine erhebliche Belastung dar und bestätigte den Wunsch nach einem Wechsel zu einer bewährten Lösung mit breiter Community und vielfältigen Integrationsmöglichkeiten. Hinsichtlich der Abfragegeschwindigkeit zeigte sich ein gemischtes Bild. Während manche komplexen Abfragen dank des CockroachDB-eigenen Optimierers schneller ausgeführt wurden, stellten sich viele Alltagsabfragen, die mit Prisma generiert wurden, als wesentlich langsamer heraus. Insbesondere durch extrem verschachtelte, von Prisma automatisch erzeugte SQL-Abfragen mit zahlreichen Joins und unnötigen Volltabellenscans kam es zu erheblichen Performanceeinbußen. So wiesen viele typische Team-Task-Tabellen-Abfragen auf CockroachDB eine drei- bis zwanzigfache höhere Latenz im Vergleich zu Postgres auf.

Neben Performance-Problemen führten strukturierte UI- und Bedienungsschwierigkeiten auf Seiten von CockroachDB zu weiteren Herausforderungen. Beispielsweise gab es oft Verwirrung um angeblich ungenutzte Indizes, die tatsächlich weiterhin verwendet wurden. Das Abbrechen laufender, teurer Abfragen gestaltete sich auf CockroachDB extrem kompliziert, da sich das Canceln nicht wie bei herkömmlichen SQL-Datenbanken komfortabel über einen SQL-Client durchführen ließ, sondern man aufwendig im CockroachDB-Cluster und in der Konsole eingreifen musste. Solche Umstände erhöhten die Komplexität und Risiken signifikant. Auch die technische Unterstützung trug zum Unmut bei.

Die Support-Portalstrukturen waren ineinander schlecht integriert, gaben keine einzige Anmeldesitzung preis und erforderten mehrfaches Ausfüllen bereits bekannter Details. Die verspäteten Reaktionszeiten – im Schnitt dauerte eine Antwort auf Anfragen eine Woche – waren besonders kritische Faktoren, sobald zeitnahes Eingreifen erforderlich war, etwa bei produktiven Fehlern. Teilweise erschwert wurde der Betrieb durch instabile Verbindungsprobleme zwischen internen Netzwerken, VPNs und der CockroachDB-Cloud-Umgebung. Diese Unterbrechungen betrafen verschiedenste Komponenten von Airbyte-Connectors über Continuous Integration bis zu lokalen Datenbank-Tools. Trotz intensiver Troubleshooting-Maßnahmen blieben solche Tailscale-Konnektivitätsprobleme ein ungelöstes Problem und traten weiterhin sporadisch auf.

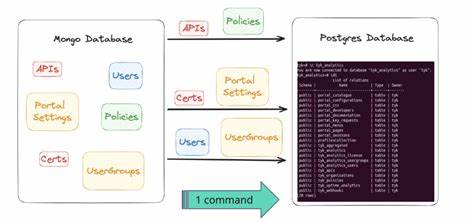

Im Gegensatz dazu erwies sich Postgres in vergleichbaren Umgebungen als deutlich stabiler und verlässlicher. Die eigentliche Migration von CockroachDB zu Postgres verlangte maßgeschneiderte Lösungen, da Standard-ETL-Tools unzureichend waren und der Datenexport aufgrund von unterschiedlichen Datenformatierungen mit JSON- und Array-Spalten hohe Komplexität aufwies. Bei Motion wurde schließlich ein eigenes Extraktions-Transformations-Ladeverfahren (ETL) auf Basis von Bun-Script entwickelt. Dieses Verfahren exportierte Tabelleninhalte in CSV-Dateien, um sie tabellenweise parallel in den neuen Postgres-Cluster einzuspielen. Die Verarbeitung erforderte dabei eine eigens entwickelte CSV-Pipeline, um die Encoding-Unterschiede in JSON- und Array-Datentypen zu transformieren, ohne dabei Nutzerdaten zu verändern.

Den finalen Migrationstag nutzte Motion, um eine leistungsstarke virtuelle Maschine mit 128 CPU-Kernen zu betreiben, die Anwendung in den Wartungsmodus zu versetzen und die komplette Datenbank in nur rund 15 Minuten zu übertragen. Die geplante Downtime betrug knapp eine Stunde, wobei ein Datenverlust vollständig vermieden wurde. Dieses Beispiel demonstriert eindrucksvoll, dass auch hochvolumige Datenbanken mit Hunderten Millionen Datensätzen innerhalb eines vertretbaren Wartungsfensters zu Postgres migriert werden können. Nach der Migration zeigte sich der unmittelbare Nutzen in einer um 33 Prozent reduzierten aggregierten Anfragelatenz. Überdies ermöglichte es das große Postgres-Ökosystem, darunter professionelle Diagnose-Tools wie PGAnalyze, binnen weniger Stunden unzählige ineffiziente Abfragen zu optimieren.

Diese Verbesserungen steigerten nicht nur die Nutzererfahrung, sondern führten auch zu einer jährlichen Kosteneinsparung von über 110.000 US-Dollar bei gleichzeitig konservativer Clusterüberdimensionierung. Der Wechsel zurück zu Postgres steht also für viele Unternehmen für Kostenkontrolle, verlässlichere Performance, bessere Entwicklererfahrung und stabilere Betriebsprozesse. Gleichzeitig unterstreicht er die Bedeutung einer sorgfältigen Vorbereitung, einer fundierten Migrationsstrategie und der Einbindung passender Tools, um reibungslose Datenmigrationen auch bei großen Datenmengen sicherzustellen. Dabei ist es hilfreich, auf bewährte ORMs, optimierte Migrationswerkzeuge und etablierte Datenbankdiagnostik zurückzugreifen.