In der heutigen datengetriebenen Welt ist die effiziente Verwaltung von großen Datenmengen eine der größten Herausforderungen für Unternehmen. Traditionelle Datenarchitekturen stießen häufig an ihre Grenzen: Data Lakes bieten zwar enorme Skalierbarkeit und Kosteneffizienz durch Nutzung von Cloud-Objektspeichern, verloren dabei jedoch an Datenkonsistenz und Abfrageverlässlichkeit. Auf der anderen Seite gewährleisten Data Warehouses eine strukturierte, zuverlässige Datenhaltung, sind jedoch oft teuer und wenig flexibel hinsichtlich Datenquellen und -formaten. Apache Iceberg schafft hier die Brücke, indem es die Vorteile beider Welten vereint und so die Basis für moderne Data Lakehouse-Architekturen bildet. Apache Iceberg ist ein Open-Source-Tabellenformat, das ursprünglich bei Netflix entstand und nun als Projekt der Apache Software Foundation weiterentwickelt wird.

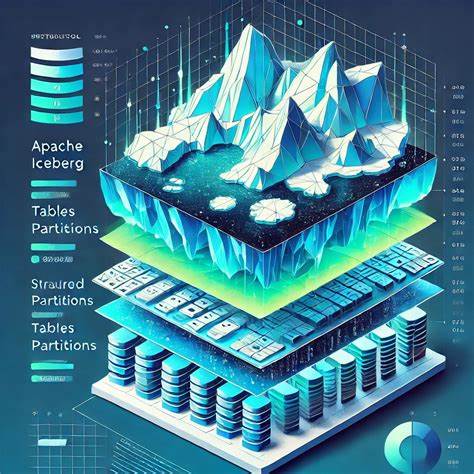

Es fungiert als intelligente Schicht zwischen den rohen Daten, die in Form von Dateien wie Parquet oder ORC abgelegt sind, und den Rechen-Engines, die diese Daten verarbeiten. Dabei sorgt Iceberg für eine einheitliche Sicht auf Daten, unterstützt ACID-Transaktionen, verwaltet Schemata und macht Daten auch bei parallelen Zugriffen verlässlich nutzbar. Die Technologie bietet somit SQL-ähnliche Funktionalitäten auf Datenmengen, die mehrere Petabyte betragen können, und das Ganze auf kostengünstigem Speicher wie Cloud Object Stores. Das Unterscheidungsmerkmal von Iceberg besteht in seiner Fähigkeit, gleichzeitig eine konsistente und performante Datenbasis für verschiedenste Analysewerkzeuge bereitzustellen. Unternehmen können so mit unterschiedlichen Engines wie Apache Spark, Trino, Flink oder sogar lokalen Tools wie DuckDB auf dieselben Daten zugreifen, ohne Daten kopieren oder synchronisieren zu müssen.

Diese Multi-Engine-Interoperabilität befreit Anwender von Vendor-Lock-in und ermöglicht Best-of-Breed-Architekturen für ETL, Streaming, BI und KI/ML-Anwendungen. Ein Kernelement von Iceberg sind seine ACID-Transaktionen, die sicherstellen, dass Datenänderungen atomar und konsistent ausgeführt werden. Dabei erzeugt jeder Schreibvorgang einen neuen Snapshot der Tabelle, der von Lesern isoliert betrachtet werden kann. Das verhindert das Problem sogenannter "Zombie-Daten", die bei fehlender Konsistenz Lesern angezeigt werden könnten. Dank dieser snapshot-basierten Architektur lässt sich außerdem das Feature von Zeitreisen realisieren: Anwender können Datenzustände aus der Vergangenheit per Query rekonstruieren oder bei Fehlern schnell auf vorherige Versionen zurücksetzen, was für Auditing und reproduzierbare Data-Science-Experimente enorm wichtig ist.

Ein weiteres bedeutendes Merkmal ist die automatische und versteckte Partitionierung. Im Gegensatz zu älteren Hive-basierten Ansätzen werden Partitionen nicht als Verzeichnisse im Dateisystem abgebildet, sondern vom Iceberg-Metadatenmanagement intern verwaltet. Dies erlaubt flexibles Ändern von Partitionierungsschemata ohne aufwändige Datenmigrationen und verhindert teure Dateisystem-Listenoperationen, die in Cloud-Umgebungen mit großen Datenmengen oft zu Ausbremsungen führen. Icebergs Metadatenarchitektur ist hier ebenfalls wegweisend: Manifestdateien und Listen davon enthalten präzise Informationen zu allen Datenfiles, inklusive Statistiken über Spaltenwerte. Diese Hierarchie sorgt dafür, dass Abfrage-Engines nur jene Dateien laden müssen, die relevant sind.

Somit werden kostspielige Full-Catalog-Scans vermieden, was vor allem bei Hunderttausenden bis Millionen Dateien einem enormen Performancevorteil entspricht. Die Skalierbarkeit von Iceberg wurde von Anfang an auf petabytegroße Datenmengen ausgelegt. Selbst große Tabellen mit Millionen Dateien können effizient verwaltet werden. Funktionen wie Datei-Kompaktierung helfen, kleine Dateien zusammenzuführen und dadurch die Leselatenz weiter zu verbessern. Die Kombination aus dieser Skalierbarkeit und der Unterstützung von ACID-Transaktionen macht Iceberg speziell für moderne Analytik-Workloads in Unternehmen attraktiv.

Ein spannender neuer Meilenstein ist die Integration von DuckDB mit Apache Iceberg, die im April 2025 vorgestellt wurde. DuckDB ist eine leichtgewichtige, inprozessoranalytik-Datenbank, die sich besonders für Data-Science-Workflows in Python oder Jupyter Notebooks eignet. Durch die Iceberg-Erweiterung kann DuckDB nun direkt Iceberg-Tabellen, sogar remote auf Cloud-Objektspeichern, lesen. Dies ermöglicht Analysten und Data Scientists einen unmittelbaren und unkomplizierten Zugriff auf große Iceberg-Datensätze ohne den Zwang, komplexe Spark- oder Trino-Cluster zu betreiben. Die Integration ist ein starkes Signal für die Offenheit und Vielseitigkeit von Iceberg.

In modernen Lakehouse-Architekturen, welche die Speicherung von Daten in offenen Formaten auf Cloud-Objektspeichern mit einer Vielzahl von spezialisierten Rechen-Engines kombinieren, nimmt Iceberg die Rolle des Verwaltungslayers für Tabellenmetadaten ein. Durch die Entkopplung von Speicher und Compute kann jede Engine ihre spezifische Stärke ausspielen, sei es Batch-ETL mit Spark, interaktive Abfragen mit Trino oder Streaming-Analytik mit Flink. Iceberg sorgt dabei für Konsistenz, Schema-Management und effiziente Datenzugriffe. Cloud-native Umgebungen wie AWS nutzen Iceberg intensiv. So kommen Amazon S3 als Speicher, AWS Glue als Iceberg-Katalog und AWS EMR für Spark-ETL zusammen.

Dazu gesellen sich Dienste wie Athena (auf Trino basierend) und neue Iceberg-native Angebote wie AWS S3 Tables und SageMaker Lakehouse. Durch diese Kombination erhalten Unternehmen eine moderne, bedarfsgerechte Datenplattform, die sowohl für klassische BI- als auch für Machine-Learning-Anwendungen konsistente und performante Daten liefert. Ebenso ermöglicht Iceberg hybride Architekturen, bei denen Daten teilweise On-Premises (z.B. in HDFS) und teilweise in der Cloud verwaltet werden.

Gemeinsame Metadaten in Form von Iceberg-Katalogen erlauben nahtlose Datenbereitstellung über Umgebungen hinweg. So kann etwa LinkedIn Daten aus Kafka gemeinsam in Hadoop (als Iceberg-Tabellen) speichern und parallel in der Cloud mit BigQuery oder Snowflake verarbeiten. Diese Elastizität ist für viele Unternehmen mit verschiedenen Rechenzentren und Cloud-Migrationen entscheidend. Auch im Bereich Streaming zeigt Iceberg sein Potenzial. Apache Flink und Spark Structured Streaming können als Write-Sinks in Iceberg dienen, wobei jeder Commit einen konsistenten Snapshot bildet.

Dieses Verfahren bringt ACID-Sicherheit in Streaming-Landschaften und ermöglicht nahe Echtzeit-Analytik auf dem Datenlake. Flink kann zudem Iceberg-Tabellen als Streaming-Quellen konsumieren, nutzt so Change-Data-Capture-Mechanismen und ermöglicht so komplexe Pipeline-Architekturen auf Basis eines einheitlichen Datenformats. Viele Best-Practice-Beispiele von großen Unternehmen demonstrieren den Mehrwert von Iceberg. Netflix nutzt Iceberg als Kernstück ihrer Datenpipeline, um Inkonsistenzen zu vermeiden und zeitnahe Daten für Analysen und Machine Learning bereitzustellen. Apple verwendet Iceberg für seine AI- und ML-Plattformen, auch im Zusammenhang mit Flink-basierten Streaming-Pipelines.

Airbnb profitierte durch den Umstieg von Hive auf Iceberg von deutlich verbesserten Metastore-Performance und vereinfachter Wartung. LinkedIn, Adobe, Stripe und Expedia setzen Iceberg ebenfalls ein, häufig um ML-Workflows mit konsistenten Datenquellen zu versorgen. Die Integration bei Cloud-Anbietern gewinnt ebenfalls an Fahrt. Snowflake unterstützt externe und von Snowflake verwaltete Iceberg-Tabellen. So können Kunden ihre offenen Datenformate weiterhin mit warehousetypischen Tools nutzen, ohne auf proprietäre Speichersysteme festgelegt zu sein.

Google BigQuery fördert mit BigLake die Nutzung von Iceberg, um gemeinsame Metadaten über Engines hinweg zu realisieren und Cloud- sowie On-Premises-Workloads zu verbinden. Um die Produktivität der Anwender zu erhöhen, erweitert das Iceberg-Ökosystem sich stetig. Metadatenkataloge wie Hive Metastore, AWS Glue oder das Git-ähnliche Nessie bieten skalierbare und nutzerfreundliche Steuerung einzelner Tabellen, Schemata und sogar experimenteller Datenversionen. Neben Unterstützung bei Versionsverwaltung und Branching erleichtern diese Tools die Integration in AI/ML-Experimente und ermöglichen Reproduzierbarkeit. Automatisierte Wartungswerkzeuge kümmert sich um Kompaktierung und Aufräumarbeit, entlasten die Infrastruktur und sichern dauerhaft hohe Performance.