Die rasante Entwicklung von Machine Learning und Deep Learning verändert unsere Welt in nahezu allen Bereichen – von der Medizin über die Finanzwelt bis hin zur autonomen Mobilität. Trotz bemerkenswerter Fortschritte stehen Forscher weiterhin vor fundamentalen Herausforderungen, um das Verhalten und die Leistung neuronaler Netzwerke besser zu verstehen. In diesem Kontext eröffnet die neuroalgebraische Geometrie einen vielversprechenden neuen Ansatz, der algebraische Geometrie und Deep Learning verbindet und so eine tiefere Einsicht in die mathematischen Strukturen von Lernmodellen ermöglicht. Neuroalgebraische Geometrie ist ein interdisziplinäres Forschungsfeld, das die klassische algebraische Geometrie auf Funktionräume anwendet, die durch neuronale Netzwerke mit spezifischen Aktivierungsfunktionen parametrisiert werden. Insbesondere konzentrieren sich Wissenschaftler auf neuronale Netzwerke mit polynomialen Aktivierungen, deren resultierende Funktionsräume als halb-algebraische Varietäten beschrieben werden können.

Diese Verknüpfung erlaubt es, geometrische und algebraische Eigenschaften dieser Varietäten – wie Dimension, Grad und Singularitäten – mit wichtigen Aspekten des Lernens, beispielsweise der Ausdruckskraft, der Trainingsdynamik und der Komplexität der Modelle, zu korrelieren. Ein zentraler Vorteil dieses Ansatzes besteht darin, dass viele neuronale Netzwerke, insbesondere jene mit polynomiellen Aktivierungen, in einem algebraischen Rahmen analysierbar sind. Algebraische Geometrie bietet dafür einen reichen Werkzeugsatz zur Untersuchung komplexer, oft hochdimensionaler geometrischer Objekte. Die Studierenden und Forscher können so Einblicke gewinnen, die über herkömmliche numerische Methoden hinausgehen. Die Dimension einer Varietät stellt in diesem Kontext die Freiheitsgrade des entsprechenden neuronalen Modells dar, während der Grad beispielsweise mit der Komplexität der Funktionen in Beziehung steht.

Singularitäten wiederum können auf besondere Eigenschaften des Modells hinweisen, wie beispielsweise instabile Punkte in der Trainingslandschaft oder spezielle Formen des impliziten Bias. Impliziter Bias beschreibt die Eigenschaft von Trainingsalgorithmen, bestimmte Lösungen gegenüber anderen zu bevorzugen, auch wenn diese Lösungen mathematisch äquivalent sind. Die Untersuchung von Singularitäten in Varietäten könnte helfen, zu verstehen, warum neuronale Netzwerke bestimmte Lösungen bevorzugen und wie sich das auf Generalisierung und Robustheit auswirkt. So stellt die neuroalgebraische Geometrie nicht nur theoretische Erkenntnisse zur Verfügung, sondern kann auch praktische Implikationen für das Design und Training besserer Modelle liefern. Ein weiterer spannender Aspekt ist die Analyse der Trainingsdynamik aus geometrischer Sicht.

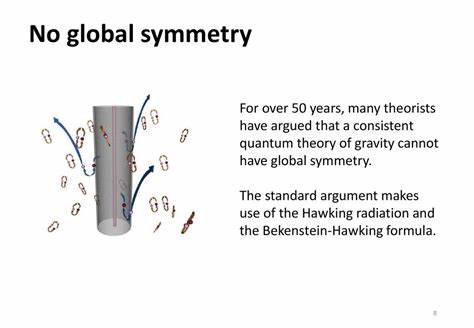

Der Raum der Parameter eines neuronalen Netzwerks lässt sich als geometrisches Objekt visualisieren. Durch die Algebra der zugrundeliegenden Varietäten lassen sich Erkenntnisse über Pfade des Gradientabstiegs, Flüsse und das Verhalten in der Nähe von Singularitäten gewinnen. Dies könnte helfen, optimierte Trainingsverfahren zu entwickeln oder den Mythos der Überparameterisierung besser zu verstehen. Die neuroalgebraische Geometrie steht nicht für sich allein, sondern bildet eine Brücke zwischen verschiedenen mathematischen Disziplinen und der modernen KI-Forschung. Zusätzlich zur algebraischen Geometrie tauchen Konzepte aus der Topologie, Varietätstheorie und konvexen Optimierung auf.

Dadurch erweitert sich der Werkzeugkasten für Forscher und ermöglicht eine ganzheitlichere Betrachtung der komplexen Landschaften von neuronalen Netzen. Neben den rein theoretischen Ansätzen existieren auch praktische Anwendungen dieser Forschung. So könnten neue Analyseverfahren zur Verbesserung der Sample-Komplexität beitragen. Die Sample-Komplexität gibt an, wie viele Datenpunkte benötigt werden, damit ein Modell mit hoher Wahrscheinlichkeit generalisiert. Die Fähigkeit, die Dimension und andere algebro-geometrische Eigenschaften der Funktionsräume zu bestimmen, erlaubt es, Vorhersagen über die erforderliche Datenmenge zu treffen.

Dies kann gerade in ressourcenbeschränkten Anwendungsszenarien von großem Nutzen sein. Der interdisziplinäre Charakter neuroalgebraischer Geometrie fordert eine enge Zusammenarbeit zwischen Mathematikern, Informatikern und Datenwissenschaftlern. Während algebraische Geometrie traditionell als abstrakte Theorie gilt, zeigen aktuelle Forschungsergebnisse, dass ihre Methoden essenziell sind, um die Qualität und Leistungsfähigkeit von Deep-Learning-Systemen zu verbessern. Das Förderprogramm der Simons Foundation und die stetig wachsende Zahl von Veröffentlichungen auf Plattformen wie arXiv belegen das zunehmende Interesse an diesem Gebiet. Bei Betrachtung der Geschichte zeigt sich, dass mathematische Studien rund um neuronale Netzwerke schon seit den 1990er Jahren angestrebt werden.

Die neuroalgebraische Geometrie stellt nun eine moderne Weiterentwicklung dar, die auf neuen theoretischen wie praktischen Fortschritten basiert. Insbesondere die Wahl der Aktivierungsfunktionen ist hierbei entscheidend: Während klassische Netzwerke oft nicht-polynomiale Aktivierungen verwenden, ermöglichen polynomiale Aktivierungen die Anwendung algebraischer Methoden und führen zu semi-algebraischen Strukturen, die besser mathematisch handhabbar sind. Das Ziel neuroalgebraischer Forschung ist es, eine „Wörterbuch“ zwischen Konzepten der algebraischen Geometrie und den Begriffen des Machine Learnings zu schaffen. So sollen Begriffe wie Varietätsdimension oder -singularität in ihrer Bedeutung für Machine Learning präzise definiert und nutzbar gemacht werden. Dies unterstützt die Identifikation von Engpässen, Limitierungen und Optimierungspotenzialen bei der Entwicklung neuer Deep-Learning-Architekturen.

Ein besonders herausfordernder Aspekt ist das Skalieren solcher mathematischer Methoden auf sehr große Modelle, wie sie in der Praxis häufig vorkommen. Viele moderne neuronale Netzwerke verfügen über Millionen bis Milliarden von Parametern, was eine direkte algebraische Analyse erschwert. Dennoch schaffen erste Ansätze, durch approximative Methoden und Beschränkungen auf Teilmodelle, wertvolle Einsichten. Mit zunehmender Rechenleistung und weiterentwickelten mathematischen Toolkits wird sich neuroalgebraische Geometrie vermutlich auch für diese großen Modelle als nützlich erweisen. Darüber hinaus eröffnet das Feld innovative Perspektiven für das Design neuer Netzwerke.

So könnten Algebra und Geometrie bei der Konstruktion von Architekturen helfen, die gezielt auf bestimmte Aufgaben zugeschnitten sind oder eine bessere Interpretierbarkeit bieten. Die Verknüpfung von geometrischen Eigenschaften mit der Lernfähigkeit ermöglicht auch die Entwicklung von Regularisierungsmethoden, die das Overfitting verhindern und die Stabilität während des Trainings erhöhen. Informiert man sich über die zunehmende Anzahl der wissenschaftlichen Publikationen und Konferenzbeiträge, wie dem bedeutenden Beitrag „Algebra Unveils Deep Learning – An Invitation to Neuroalgebraic Geometry“, wird klar, dass dieses Forschungsfeld dynamisch wächst und sich als eine Schlüsseltechnologie der Zukunft etablieren könnte. Forscher weltweit tragen dazu bei, die abstrakte Theorie in anwendbare Methoden umzusetzen. Neuroalgebraische Geometrie eröffnet somit eine völlig neue Dimension des Verständnisses neuronaler Netzwerke.

Sie ersetzt nicht die bewährten numerischen Techniken, sondern ergänzt sie durch rigide mathematische Strukturen und eröffnet Wege für neue innovative Ansätze in der Wissenschaft des maschinellen Lernens. Abschließend lässt sich sagen, dass die neuroalgebraische Geometrie eine Einladung zu einer spannenden Reise ist – an der Schnittstelle von reiner Mathematik und angewandter Informatik. Die Kombination aus algebraischer Strenge und praktischer Relevanz hat das Potenzial, die Entwicklung intelligenter Systeme grundlegend zu verändern und tieferes Verständnis für komplexe Lernprozesse zu schaffen. Für alle, die sich für die Zukunft von Deep Learning interessieren, ist es lohnenswert, diese Verknüpfung weiter zu verfolgen und aktiv zu erforschen.