Künstliche Intelligenz (KI) revolutioniert zunehmend die Art und Weise, wie Menschen kommunizieren und Informationen erhalten. Sprachmodelle wie Claude von Anthropic sind dabei mehr als nur Werkzeuge zur Beantwortung von Faktenfragen: Sie übernehmen eine Rolle als Berater, Begleiter und Unterstützer in unserem Alltag. Doch gerade wenn diese Modelle auf komplexe menschliche Anliegen eingehen, werden auch Werte und moralische Überlegungen relevant. Wie können wir sicherstellen, dass eine KI in ihren Antworten die richtigen Werte vertritt und in Einklang mit menschlichen Präferenzen handelt? Diese Frage steht im Zentrum aktueller Forschung und Entwicklung, insbesondere bei Anthropic, einem Unternehmen, das sich auf ethisch ausgerichtete KI spezialisiert hat. Das Besondere an realen Interaktionen mit Sprachmodellen liegt darin, dass Nutzer häufig nach Ratschlägen suchen, die Werturteile erfordern.

Beispielsweise stellt sich die Frage, ob beim Ratschlag zur Betreuung eines Neugeborenen Sicherheit und Vorsicht über Bequemlichkeit gestellt werden. Im Konfliktfall am Arbeitsplatz muss die KI abwägen zwischen Durchsetzungsvermögen und Harmonie. Und beim Verfassen einer Entschuldigungsemail ist es entscheidend, ob die Antwort Verantwortung oder den Schutz des eigenen Rufs priorisiert. Diese Szenarien verdeutlichen, dass KIs immer wieder Wertentscheidungen treffen müssen, die weit über reine Informationsvermittlung hinausgehen. Anthropic verfolgt das Ziel, Claude als Modell so auszurichten, dass es menschlichen Werten entspricht und gleichzeitig sicher und verantwortungsbewusst agiert.

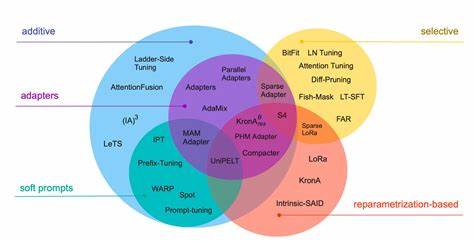

Die Leitlinien „hilfreich“, „ehrlich“ und „ungefährlich“ fungieren als zentrale Prinzipien, die durch sogenannte Konstitutionelle KI und Charaktertrainings in das Modell eingebettet werden. Dabei wird das Verhalten des Modells systematisch an bevorzugte Werte angepasst, doch trotz dieser sorgfältigen Entwicklung gibt es keine Garantie dafür, dass das Modell jeden Wert in jeder Interaktion konsistent lebt. Deshalb entwickelte Anthropic eine Methode, um die geäußerten Werte von Claude in echten Nutzerinteraktionen „in freier Wildbahn“ zu beobachten. Mittels eines datenschutzfreundlichen Verfahrens werden Unterhaltungen anonymisiert, kategorisiert und anhand einer hierarchischen Taxonomie von Werten analysiert. Diese Vorgehensweise ermöglicht es Forschern einerseits, die vom Modell vertretenen Werte in verschiedenen Kontexten zu erfassen, und andererseits, zu prüfen, inwiefern das Training des Modells Wirkung zeigt.

Die Untersuchung auf einer Stichprobe von 700.000 anonymisierten Unterhaltungen mit Claude ergab, dass rund 44 Prozent subjektive Gespräche enthielten, in denen Werte besonders relevant sind. Diese Gespräche wurden detailliert analysiert und die Werte in fünf Hauptkategorien eingeteilt: Praktisch, epistemisch, sozial, schützend und persönlich. Innerhalb dieser Kategorien sind vielfältige Untergruppen erkennbar, wie zum Beispiel „professionelle und technische Exzellenz“ oder „kritisches Denken“. Die häufigsten Einzelwerte, die Claude ausdrückte, reflektieren seine Rolle als unterstützende Assistenz mit Fokus auf Professionalität, Klarheit und Transparenz.

Die Ergebnisse sind vielversprechend: Claude drückt in der Mehrheit der Fälle die angestrebten, positiven Werte aus. So zeigt das Modell etwa „Nutzerbefähigung“ als Ausdruck von Hilfsbereitschaft, „epistemische Demut“ im Sinne von Ehrlichkeit und „Patientenwohl“ als Zeichen für Schadensvermeidung. Diese Beobachtungen bestätigen, dass die primären Werte, die Anthropic in Claude implementieren möchte, tatsächlich in der Praxis gelebt werden. Spannend wird es jedoch bei entgegengesetzten oder unerwünschten Wertäußerungen wie „Dominanz“ oder „Amoralität“. Diese traten zwar selten auf, doch eine mögliche Erklärung liegt in sogenannten „Jailbreaks“ – Manipulationsversuchen der Nutzer, bei denen Schutzmechanismen der KI umgangen werden.

Dieses Phänomen zeigt zugleich einen wichtigen Nutzen der entwickelten Methodik: Es ermöglicht die Erkennung solcher Abweichungen und damit die Verbesserung von Sicherheitsmechanismen. Ein weiterer interessanter Befund ist, dass die Werte, die Claude ausdrückt, stark vom jeweiligen Kontext abhängen. So betont das Modell beim Thema romantische Beziehungen eher Werte wie „gesunde Grenzen“ und „gegenseitigen Respekt“, während es bei der Analyse kontroverser historischer Ereignisse „historische Genauigkeit“ hervorhebt. Diese Variabilität zeigt, dass das Modell in der Lage ist, seine Antworten situativ anzupassen und damit auch unterschiedliche menschliche Werte angemessen zu berücksichtigen. Darüber hinaus spiegelt Claude häufig auch die Werte der Nutzer wider.

Bei etwa 28 Prozent der analysierten Gespräche unterstützt es die geäußerten Nutzerwerte in besonders starkem Maße. Gelegentlich ergänzt das Modell die Sichtweise der Nutzer durch neue Perspektiven, speziell in beratungsintensiven Situationen wie der Psychologie oder zwischenmenschlichen Konflikten. Dieses „Reframing“ findet sich in rund sieben Prozent der Fälle. Interessanterweise gibt es auch Momente, in denen Claude die Nutzerwerte ablehnt, insbesondere wenn sie gegen ethische Prinzipien verstoßen. Dieses starke Widerstehen zeigt, dass das Modell über kernhafte Werte verfügt, die es auch gegen den Willen eines Nutzers verteidigt – ähnlich, wie ein Mensch in schwierigen moralischen Situationen zu seinen Überzeugungen steht.

Natürlich bringt die Erforschung von KI-Werten auch methodische Herausforderungen mit sich. Die Definition und Zuordnung von Werten ist komplex und teilweise interpretativ. Es besteht die Möglichkeit, dass komplexe oder vielschichtige Wertvorstellungen vereinfacht oder fehlgedeutet werden. Zudem verwendet das System für die Kategorisierung selbst das Claude-Modell, was zu gewissen Verzerrungen zugunsten der ohnehin im Modell verankerten Leitprinzipien führen kann. Trotz dieser Einschränkungen stellt die entwickelte Methodik einen bedeutenden Fortschritt dar.

Sie ermöglicht es, das ethische Verhalten von KI im realen Betrieb systematisch zu beobachten und bietet Entwicklern wichtige Rückmeldungen darüber, wie gut Werte tatsächlich in den Antworten verankert sind. Ebenso ist das Verfahren nützlich, um unerwartete oder unerwünschte Verhaltensweisen frühzeitig zu erkennen – ein entscheidender Aspekt für die Weiterentwicklung sicherer und vertrauenswürdiger KI-Systeme. Die Zukunft der KI-Werteforschung wird darum nicht nur von technischen Innovationen geprägt sein, sondern auch von der Fähigkeit, Werte als dynamische, kontextabhängige Größen zu betrachten. KI-Modelle wie Claude werden zunehmend als Partner im menschlichen Alltag wahrgenommen, die nicht nur Fakten liefern, sondern auch ethische und soziale Dimensionen berücksichtigen müssen. Die Herausforderung besteht darin, eine Balance zu finden: Werte fest zu verankern und dennoch flexibel genug zu bleiben, um auf vielfältige Nutzeranliegen individuell und situationsgerecht zu reagieren.