Die rasante Entwicklung großer Sprachmodelle (LLMs) hat viele neue Möglichkeiten eröffnet, aber auch wesentliche Herausforderungen offenbart. Insbesondere die Art und Weise, wie wir Künstliche Intelligenz anweisen – durch sogenannte Prompts – zeigt derzeit Schwächen, die langfristig die Leistungsfähigkeit und Anpassungsfähigkeit der Systeme limitieren könnten. Im Zentrum dieser Problematik steht ein Mangel an explizitem, bearbeitbarem Gedächtnis, das die KI dazu befähigen würde, Wissen und Präferenzen flexibel zu speichern und anzupassen. Die Metapher der Sticky Notes, also der Haftnotizen, symbolisiert genau diese Idee: KI-Systeme sollen lernen, Kontext, Regeln und Fakten wie Menschen in einer dynamischen, nachvollziehbaren und anpassbaren Form zu verwalten, anstatt alles starr im Modell selbst zu hinterlegen. Große Sprachmodelle sind oft mit einer einzigen Herausforderung konfrontiert.

Sie müssen auf der Basis parametrischer Daten eine Vielzahl von Aufgaben lösen, ohne dass ihr Wissen nach dem Training direkt angepasst werden kann. Heutige Methoden beruhen entweder auf Pretraining oder auf Fine-Tuning. Beide Ansätze sind teuer, zeitaufwendig und wenig flexibel. Sie verbannen Wissen dauerhaft in eine schwarze Box, die kaum mehr veränderbar ist. Änderungen oder Erweiterungen des Wissens bedeuten oftmals das erneute Trainieren des gesamten Systems, was teuer und ineffizient ist.

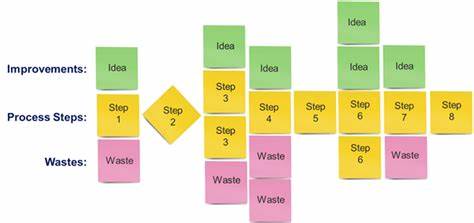

Gerade bei dynamischen Umgebungen, in denen Fakten sich verändern oder individuelle Präferenzen angepasst werden müssen, zeigt sich dieses Vorgehen als unpraktisch. Man kann sich das gut am Beispiel der Segelboot-Regattas vorstellen: Menschen notieren sich Hinweise wie Windmuster, Kompassrichtungen oder Crew-Vorlieben auf kleinen Haftnotizen oder direkt auf Masking Tape, das am Boot angebracht ist. Manche Notizen verlieren schnell an Bedeutung, andere werden Teil eines inneren Wissens, das in Entscheidungen einfließt. Diese drei Bereiche lassen sich in Fakten, Präferenzen und Regeln unterteilen. Der Mensch testet seine Notizen, adaptiert sie, verwirft und speichert sie schlussendlich instinktiv.

KI dagegen stapelt lineare Prompts aufeinander, bis diese wie überdimensionale Rezeptbücher wirken, die jeder neuen Herausforderung mit umfassenden Aneinanderreihungen von Instruktionen begegnen. Diese Herangehensweise ist unflexibel, ineffizient und schwer wartbar. Ein aktuelles Beispiel, das diese Problematik verdeutlicht, ist das Systemprompt von Anthropic's Claude, das beeindruckende 17.000 Wörter umfasst. Die Länge resultiert daraus, dass immer mehr Spezialfälle in die Prompt-Anweisungen gepackt werden, um Fehler zu vermeiden und gewünschte Verhaltensweisen zu erzwingen.

Diese Art der Duct-Tape-Lösung hilft nur kurzfristig. Sie führt zu wachsenden, schwer zu überblickenden Prompts, die mit der Zeit unhandlich werden und neue Probleme schaffen, statt sie zu lösen. Nutzer, vor allem in Startups, beobachten, wie ihre Prompts innerhalb weniger Monate von hunderten auf zehntausende Tokens wachsen, ohne dass das System an sich intelligenter wird. Die Zukunft der KI-Promptgestaltung liegt also nicht in immer längeren Texten, sondern in der Integration eines expliziten Gedächtnisses, vergleichbar mit einem digitalen Scratchpad, auf dem die KI relevante Informationen flexibel bearbeiten, überprüfen und aktualisieren kann. Diese Form des Speicherns ist:- explizit: das heißt nachvollziehbar und transparent,- editierbar: neue Informationen können hinzugefügt, alte angepasst oder gelöscht werden,- dynamisch: das Gedächtnis kann unterschiedliche Kontexte und zeitabhängige Änderungen berücksichtigen.

Diese Ansätze ermöglichen eine modulare, viel flexiblere Art des Lernens und der Wissensverwaltung, die näher an menschlichen Denkweisen liegt. Es gibt bereits erste funktionierende Beispiele solcher Konzepte. Die Plattform Cursor nutzt etwa sogenannte .cursorrules Dateien, die festlegen, wie sich der Code im Projekt entwickeln soll. So kann ein Entwickler beispielsweise angeben, dass er funktionale Komponenten bevorzugt, und diese Regel wird dann konsistent über das gesamte Projekt angewandt.

ChatGPT hat mit den sogenannten Saved Memories begonnen, Nutzerdetails und Präferenzen explizit zu speichern und über verschiedene Sitzungen hinweg abzurufen. Auch wenn diese Systeme noch in den Kinderschuhen stecken, zeigen sie, dass explizites Gedächtnis die KI-Leistungsfähigkeit maßgeblich verbessern kann. Die Einführung expliziter Gedächtnissysteme bringt allerdings technische Herausforderungen mit sich. Unterschiedliche Kontexte verlangen unterschiedliche Verhaltensweisen – eine Anweisung wie „sei prägnant“ mag in einem Chat mit einem Freund optimal sein, in einem rechtlichen Dokument jedoch unangebracht. Gedächtnis muss deshalb kontextsensitiv funktionieren und in der Lage sein, Regeln zu priorisieren oder zu deaktivieren.

Zudem ist eine „Vergessensfunktion“ notwendig: manche Daten verlieren mit der Zeit ihre Gültigkeit und sollten automatisch entfernt oder angepasst werden. Zudem braucht es eine Art Versionskontrolle, um die Entwicklung der gespeicherten Informationen nachvollziehen zu können. Diese Anforderungen sind technisch anspruchsvoll, aber keineswegs unlösbar und erinnern an organisatorische Herausforderungen in komplexen Unternehmen. Die Lösungen werden wohl durch iterative Prozesse entstehen, die sich auf Lean-Engineering-Prinzipien stützen. Die Vorteile eines solchen expliziten Speichersystems für KI sind vielfältig.

Eine klare und nachvollziehbare Audit-Trail erleichtert es, Entscheidungen und Empfehlungen der KI im Nachhinein zu bewerten. Unternehmen können schneller auf veränderte Anforderungen reagieren, indem sie das Wissensgedächtnis ihrer KI-Agenten anpassen, ohne das Modell neu zu trainieren. Dadurch kann ein und dasselbe KI-Modell für sehr unterschiedliche Einsatzbereiche eingesetzt werden. So kann es am Vormittag rechtliche Vertragsprüfungen optimieren und am Nachmittag Marketingtexte verfassen. Anwender freuen sich über einfachere individuelle Anpassungen, die etwa über das Austausch von Konfigurationsdateien möglich sind.

Das mindert die Abhängigkeit von großen Trainingsdurchläufen und macht KI dynamischer und kosteneffizienter. Die Vision einer KI-Zukunft mit Scratchpad-Gedächtnis ist keine Science-Fiction, sondern ein realistisches Szenario, das heute bereits Form annimmt. Die Herausforderung besteht darin, Systeme zu entwickeln, die eine saubere Trennung zwischen dem KI-Kernmodell und dem expliziten Gedächtnis schaffen. In Zukunft wird der Wettbewerb nicht länger davon bestimmt werden, wer das größte KI-Modell besitzt, sondern wer es schafft, das Wissen intelligent zu organisieren, zu archivieren und sinnvoll weiterzuentwickeln. Damit wird auch das Thema Vertrauen in KI-Systeme endlich greifbarer, da sie ihre Entscheidungen transparent und nachvollziehbar darstellen können.

Gleichzeitig sollten Entwickler und Unternehmen den Weg hin zu solch einer Architektur aktiv gestalten, denn sie eröffnet ganz neue Möglichkeiten der Zusammenarbeit zwischen Mensch und Maschine. Genau wie die Segelbootskipper ihre Notizen im Verlauf eines Rennens anpassen, wird auch KI lernen müssen, Wissen flexibel zu nutzen und zu verändern, um ihre Leistung im ständigen Dialog mit Nutzern oder der Umwelt zu optimieren. Der Wandel von starren, in sich geschlossenen Modellen zu offenen, lernfähigen Gedächtnissen ist ein entscheidender Entwicklungsschritt, um KI stabiler, menschennäher und effizienter zu machen. Zusammenfassend lässt sich sagen, dass die Zukunft der KI-Prompts explizitem, dynamischem und transparentem Gedächtnis gehört. Diese neue Herangehensweise wird nicht nur die Robustheit und Anpassungsfähigkeit großer Sprachmodelle verbessern, sondern genauso erst den Zugang zu einer breiten Palette von Spezialanwendungen ermöglichen, die heute noch undenkbar sind.

Da verschiedene Anbieter bereits an Prototypen arbeiten, wird es spannend sein zu beobachten, wer als Erster solche Systeme in den Alltag bringt und welche Innovationen daraus entstehen. Die Ära der Sticky Notes als digitales Scratchpad könnte der Wendepunkt sein, der den interaktiven Umgang mit KI grundlegend verändert und nachhaltiger gestaltet.