In der heutigen Softwareentwicklung stehen Entwickler vor der Herausforderung, immer komplexere Anwendungen in kürzerer Zeit zu erstellen. Dabei spielt der gezielte Einsatz von modernen KI-Technologien – allen voran Large Language Models (LLMs) – eine immer wichtigere Rolle. Ein anschauliches Beispiel für den erfolgreichen Einsatz solcher Modelle ist die Technik des sogenannten „Vibe Codings“, die in Verbindung mit einer durchdachten Strukturierung („Scaffolding“) eine effiziente Umsetzung auch mittelgroßer und komplexer Apps ermöglicht. Doch wie genau kann man diese Methoden praktisch anwenden und welche Erfolgsfaktoren gilt es zu beachten, um die Grenzen der derzeitigen KI-Modelle zu überwinden? Ein zentraler Problempunkt beim Einsatz von LLMs zeigt sich häufig darin, dass bei komplexen Aufgaben eine einmalige Eingabe („One-Shot-Prompt“) oft nicht zum gewünschten Ergebnis führt. Viele Entwickler haben bereits erlebt, wie unterschiedlichste KI-Systeme, ob cutting-edge Modelle wie Google Gemini, OpenAI GPT 4.

1 oder Sonnet 3.7, bei unerfahren eingereichten Anfragen ins Stolpern geraten. Selbst komplexe, aber klar definierte Anwendungen wie ein interaktives Lernspiel mit mathematischem Schwerpunkt – zum Beispiel ein Zahlenstrahl-Quiz mit dynamischer Zoom- und Pan-Funktion – können in einem einzigen Schritt nicht korrekt umgesetzt werden. Die KIs scheitern schon an grundlegenden Vorgaben wie einer einfachen Visualisierung. Aus dieser Erkenntnis heraus eröffnet sich ein Weg, der auf der Nutzung von „Scaffolding“ beruht, also dem gezielten Aufbau eines Gerüsts um das Vibe Coding herum, das die KI erst strukturiert anleitet und die Umsetzung in kleine, überprüfbare Schritte unterteilt.

Dieser strukturierte Prozess führt zu robusteren Ergebnissen und stellt sicher, dass der Entwickler stets die Kontrolle behält. Der Ausgangspunkt bei einem solchen Vorgehen ist eine klare, gut durchdachte Spezifikation. Anstelle sofort mit dem Code zu beginnen, empfiehlt es sich, eine ausführliche Unterhaltung mit dem LLM zu führen, um die Ziele, Funktionalitäten und Rahmenbedingungen der App genau zu definieren. Nur wenn die Anforderungen vollständig geklärt und verständlich abgebildet sind, kann die KI anschließend aus dieser Grundlage eine belastbare Spezifikation generieren. Dieser Dialog dient nicht nur dem besseren Verständnis, sondern ermöglicht auch das Erkennen von Unklarheiten und die gezielte Einbindung von Anforderungsanpassungen bereits vor der eigentlichen Implementierung.

Parallel zu dieser Spezifikation ist eine tiefgehende Recherche essentiell. Komplexe Anwendungen bringen oft Herausforderungen mit sich, die spezielles technisches Wissen erfordern. Die KI kann hier wiederum wertvolle Unterstützung leisten, indem sie Best Practices, relevante Dokumentationen der verwendeten Bibliotheken und Frameworks sowie mögliche Stolpersteine zusammenfasst. Diese fokussierten Recherchen sind eine ideale Grundlage für die nachfolgenden Entwicklungsschritte und sorgen für eine solide Basis. Mit der erforderlichen Hintergrundinformation in der Hand wird anschließend ein detaillierter Implementierungsplan formuliert.

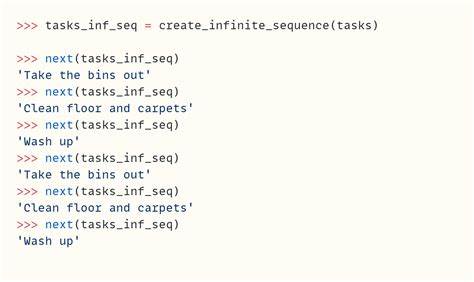

Auch dieser sollte von der KI unter Vorgabe erzeugt werden, wobei jedes einzelne Entwicklungsschritt klein, überschaubar und gut testbar sein muss. Dabei ist es wichtig, darauf zu achten, dass der Plan logisch strukturiert ist, mit sinnvollen Abhängigkeiten zwischen den Tasks und optimaler Reihenfolge, sodass ein schrittweises, iteratives Vorgehen möglich ist. Dieser Plan wird mehrfach überprüft, sowohl von vorne nach hinten als auch umgekehrt, um seine Konsistenz und Umsetzbarkeit sicherzustellen. Zudem findet hier eine technische Architekturprüfung statt, um zu vermeiden, dass unnötige Komplexität oder übertriebene Abstraktionen eingeführt werden, die den Entwicklungsprozess erschweren könnten. Der eigentliche Entwicklungsprozess besteht dann darin, Schritt für Schritt vorzugehen.

Jeder Schritt wird durch das KI-Modell im sogenannten Copilot-Agent-Modus (beispielsweise mit GPT 4.1) implementiert und anschließend umfassend getestet, bevor mit dem nächsten Schritt fortgefahren wird. Dieses Vorgehen stellt sicher, dass Fehler frühzeitig erkannt werden und sich nicht kumulieren können. Bei Problemen kann das gesamte Projektverzeichnis in den Kontext eines großen LLMs (wie Gemini 2.5 mit einer Million Token Kontextlänge) gegeben werden.

Dieses Modell kann daraufhin Fehler analysieren und Korrekturen vorschlagen, was die Fehlerbehebung erleichtert. Besonders bei der Erweiterung existierender Projekte empfiehlt sich, der KI den kompletten Quellcode als Kontext bereitzustellen. So kann sie die Struktur des Programms verstehen und gezielt auf den bestehenden Code aufbauen. Damit wird im Rahmen der Weiterentwicklung komplexer Features sichergestellt, dass neue Funktionalitäten harmonisch ins Gesamtbild passen und keine Inkonsistenzen entstehen. Ein wichtiger Aspekt dieses Verfahrens ist, dass es vor allem auf intelligentem Kontextaufbau und strukturiertem Prompting beruht.

Die KI wird dadurch befähigt, sinnvoll zu agieren und nicht nur fragmentarisch Code zu generieren. Klar ist jedoch auch, dass der Mensch weiterhin eine wichtige Rolle einnimmt – sei es in der Definitionsphase, bei der kritischen Prüfung der Implementierungsschritte oder bei der Abnahme der finalen Applikation. Allerdings wird deutlich, dass diese symbiotische Zusammenarbeit zwischen Entwickler und KI zukünftig immer selbstständiger und agentischer werden kann. Die Anwendung dieser Methode in der Praxis wurde am Beispiel einer Mathematik-Lern-App getestet, die Nutzern ermöglichte, Brüche und Zahlen richtig auf einem interaktiven Zahlenstrahl zu platzieren. Mit Zoom-, Pan- und kontextabhängiger Beschriftungslogik ausgestattet, konnte der Entwickler durch die beschriebene Herangehensweise eine vollständige, funktionale Version ohne einen einzigen handgeschriebenen Codeabschnitt erstellen – alles basierte auf der schrittweisen Anleitung und automatischen Implementierung durch das LLM.