Die Fähigkeit eines Roboters, die physikalischen Eigenschaften eines Objekts ohne optische Hilfsmittel präzise zu bestimmen, stellt einen bedeutenden Fortschritt in der Robotik dar. Forschende des Massachusetts Institute of Technology (MIT), Amazon Robotics und der University of British Columbia haben kürzlich eine innovative Methode vorgestellt, die es Robotern ermöglicht, allein über ihr haptisches Feedback - sprich durch das Anheben und Bewegen eines Objekts - dessen Gewicht, Weichheit und weitere relevante Eigenschaften zu erkennen. Dieser Ansatz, der die hauseigenen Sensoren eines Roboters nutzt, benötigt weder Kameras noch zusätzliche Messinstrumente, was ihn besonders in schwierigen Umgebungen äußerst nützlich macht.In der Praxis muss man sich nur einen Menschen vorstellen, der eine unbekannte Kiste aus einem dunklen Keller hebt und sie leicht schüttelt, um eine Vorstellung davon zu bekommen, was sich darin befindet. Ähnliches kann nun auch ein Roboter, der seine Gelenksensoren nutzt, um interne Signale zu erfassen und daraus Rückschlüsse auf das Objekt zu ziehen.

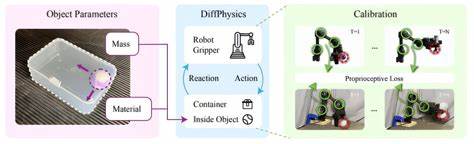

Dieses neue Verfahren, das auf differentiellen Simulationen basiert, kann innerhalb weniger Sekunden verlässliche Informationen über Masse und Beschaffenheit eines Gegenstands liefern.Das Besondere an dieser Methode ist der Verzicht auf externe Signalgeber und die Nutzung von propriozeptiven Daten, also solcher Daten, die von den eigenen Sensoren des Roboters stammen und seine Position sowie Bewegungen messen. In der Regel besitzen moderne Industrieroboter sogenannte Gelenk-Encoder, die Bewegungen und Kräfte an den Armen sekundengenau registrieren. Durch die präzise Analyse dieser Signale kann das System erkennen, wie schwer ein Objekt ist oder wie es sich bewegt und verformt – Eigenschaften, die im Alltag für einen Menschen oft intuitiv zu erfassen sind, für Maschinen aber lange eine Herausforderung darstellten.Ein Kernaspekt der Entwicklung ist die sogenannte differentiable Simulation, eine spezielle Computersimulation, die es ermöglicht, Veränderungen in den Eigenschaften eines Objekts abzuleiten und zu verstehen, wie sich diese auf die Bewegungen und Reaktionen des Roboters auswirken.

Diese Simulationen werden mit den tatsächlichen Roboterdaten abgeglichen, um die tatsächlichen Merkmale des Objekts zu bestimmen. Hierbei setzt das Team auf das Open-Source-Werkzeug Warp von NVIDIA, das schnelle Berechnungen ermöglicht und sich speziell für solche differenzierbaren Algorithmen eignet.Bereits jetzt zeigt sich, dass dieses Verfahren mit traditionellen, oft deutlich teureren Methoden zur Objekterkennung, beispielsweise solchen, die auf umfangreicher Computer-Vision basieren, durchaus mithalten kann. Besonders dort, wo Sichtsysteme eingeschränkt oder unbrauchbar sind – in dunklen Lagern, bei Trümmerbergungen nach Naturkatastrophen oder in Umgebungen mit schlechter Beleuchtung – bietet die Technik erhebliche Vorteile, da sie ausschließlich auf die internen Messungen des Roboters angewiesen ist. Das reduziert Komplettausstattung und Kosten und erhöht die Robustheit gegenüber externen Störeinflüssen.

Darüber hinaus punktet das System mit einer hohen Daten-Effizienz und benötigt nur kurze Erkundungsbewegungen, um zuverlässige Rückschlüsse zu ziehen. Während viele Lernmethoden in der Robotik große Datensätze und Trainingsphasen erfordern, genügt dem hier vorgestellten Algorithmus bereits die Beobachtung einer einzigen Bewegungssequenz, um präzise Angaben über das Objekt zu machen. Diese Fähigkeit macht den Ansatz besonders adaptiv und flexibel gegenüber neuen oder unerwarteten Objekten und Situationen.Die Forschung steckte noch am Anfang, doch die Vision der Wissenschaftler geht deutlich weiter. Langfristig wollen sie Robotern ermöglichen, eigenständig in der realen Welt mit Gegenständen zu interagieren, sie zu berühren, zu bewegen und dabei kontinuierlich neue Eigenschaften und Objekte zu lernen.

Dies könnte insbesondere Robotern der nächsten Generation zur Verfügung stehen, die in komplexen und dynamischen Umgebungen Aufgaben übernehmen sollen, etwa im Haushalt, in der Industrie oder in der Katastrophenhilfe.Aktuell konzentrieren sich die Forschenden darauf, das System weiter zu verbessern, indem sie es mit multimodalen Daten, wie etwa Bildern aus der Computer-Vision, kombinieren wollen. Diese Kombination könnte die Fähigkeiten der Roboter zur Objekterkennung noch weiter steigern und Synergieeffekte zwischen verschiedenen Sensorikmethoden schaffen. Zudem wird an der Integration mit weicheren, flexibleren Robotersystemen gearbeitet, die noch sensibler auf Berührungen reagieren können.Der Ansatz geht über die reine Gewichtserkennung hinaus und kann auf unterschiedliche physikalische Eigenschaften wie die Weichheit eines Materials, die Trägheitsmomente oder sogar die Viskosität von Flüssigkeiten innerhalb geschlossener Container angewendet werden.

Dies eröffnet spannende Perspektiven für Materialien- und Produktprüfung sowie für die Erkennung komplexer Objekttypen.Neben den robotischen Anwendungen ist das Verfahren auch für die Forschung in Simulation und Computergestütztem Design interessant, da es neue Möglichkeiten bietet, reale und simulierte Welten näher zusammenzubringen und digital möglichst genaue Nachbildungen echter Roboter-Objekt-Interaktionen zu erstellen.Insgesamt markieren diese Entwicklungen einen Meilenstein in der Robotikwelt, da sie die Fähigkeit von Maschinen, durch reine Berührung und Bewegung ihre Umwelt verstehen zu lernen, erheblich erweitern. Anstatt sich ausschließlich auf optische Daten zu verlassen, können Roboter nun immer mehr über die Welt begreifen, indem sie sie anfassen – ein Schritt, der uns menschliches Greifen und Erfühlen eventuell noch näher bringt.Die Kombination aus intelligenter Sensorik, physikalischer Simulation und lernfähigen Algorithmen führt zu einer neuen Generation von Robotern, die nicht mehr nur blind handeln, sondern ein tieferes Verständnis für die Objekte und Materialien entwickeln, mit denen sie agieren.