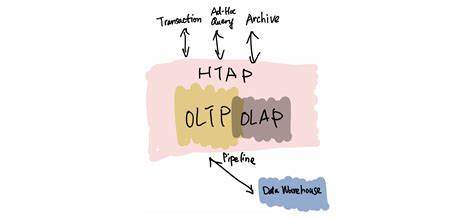

Hybrid Transactional and Analytical Processing, kurz HTAP, hat lange Zeit als die kommende Revolution im Bereich der Datenbanksysteme gegolten. Die Idee, operative Transaktionen und analytische Abfragen in einem einzigen System zu vereinen, versprach nicht nur eine Senkung der Komplexität im Datenmanagement, sondern auch schnellere Einsichten durch die Verarbeitung von Echtzeitdaten. Doch trotz großer Erwartungen und intensiver Forschung hat sich das Konzept der einheitlichen Datenbankarchitektur, das OLTP (Online Transaction Processing) und OLAP (Online Analytical Processing) zusammenbringen sollte, als in der Praxis schwieriger als gedacht erwiesen. Bereits in den 1970er Jahren waren die ersten Datenbanksysteme darauf ausgelegt, sowohl transaktionale als auch analytische Aufgaben zu erfüllen. Mit dem Fortschritt der Technologie und der wachsenden Komplexität von Unternehmensanwendungen wurde jedoch rasch klar, dass spezialisierte Systeme für diese unterschiedlichen Anwendungsbereiche einen effizienteren Ansatz darstellen.

Dies führte zur Trennung in spezialisierte OLTP-Systeme, die für schnelle Schreib- und Lesetransaktionen optimiert sind, und OLAP-Systeme, die für komplexe, umfangreiche Datenanalysen ausgelegt sind. Vor rund einem Jahrzehnt erlebte HTAP einen erneuten Aufschwung, als Technologien wie In-Memory-Datenbanken und schnelle Speicherlösungen ermöglichten, näher an der Idee eines gemeinsamen Systems zu arbeiten. Anbieter wie SingleStoreDB und TiDB positionierten sich als Vorreiter, die Hybridsysteme anboten, die operative Datenbanken und analytische Komponenten in einem System vereinten. Dabei stand die Vision im Mittelpunkt, dass Unternehmen nicht länger Daten zwischen verschiedenen Systemen synchronisieren müssten, was Zeit und Kosten sparte. Allerdings zeigte sich in der Praxis, dass die Verschmelzung von OLTP und OLAP auf einer Plattform mit erheblichen technischen Herausforderungen verbunden ist.

Die verschiedenen Anforderungen an Lese- und Schreibperformance, das Skalieren von Echtzeit-Daten mit komplexen Anfragen sowie der Bedarf an hohem Durchsatz führen schnell zu Ressourcenkonflikten. So belastete das gleichzeitige Ausführen analytischer Abfragen die Transaktionsverarbeitung und hemmte damit die Performance. Dies ist besonders kritisch, wenn es um geschäftskritische Anwendungen geht, bei denen Latenzzeiten und Verfügbarkeit eine zentrale Rolle spielen. Parallel zu diesen Herausforderungen hat die Cloud-Transformation das Bild der Datenarchitektur maßgeblich verändert. Anstatt monolithischer und eng gekoppelter Systeme setzen viele Unternehmen mittlerweile auf modulare Ansätze mit entkoppelter Speicherung und Verarbeitung.

Spezialisierte Cloud Data Warehouses wie Snowflake oder Google BigQuery haben sich als erfolgversprechende Systeme etabliert, die durch Trennung von Storage und Compute Skalierbarkeit und Kosteneffizienz ermöglichen. Diese Systeme konzentrieren sich ausschließlich auf analytische Workloads und überlassen transaktionale Datenbanken, wie etwa PostgreSQL, die Abwicklung der operativen Prozesse. Der Trend in modernen Datenarchitekturen geht hin zu einer Komposition mehrerer spezialisierter Systeme, die gemeinsam über Streaming-Pipelines, Data Lakes und Echtzeit-Query-Schichten orchestriert werden. So werden frische transaktionale Daten über Systeme wie Kafka oder andere Streaming-Technologien in Data Lakes auf Object Storage-Ebene geschrieben. Analysewerkzeuge und Engines wie Apache Spark oder Trino greifen dann auf diese Daten zu und ermöglichen die komplexe Auswertung.

Echtzeitsysteme wie ClickHouse oder Elasticsearch bieten zusätzlich Indizes und schnelle Datenzugriffe für spezielle Anwendungsfälle. Dieser Architekturansatz repräsentiert praktisch eine neue Variante von HTAP – nicht mehr als monolithische Konsolidierung, sondern als lose gekoppelte Komposition von spezialisierten Komponenten. Das zusätzliche Management dieser heterogenen Landschaft bringt eigene Herausforderungen mit sich, da es komplexe Datenpipelines, Datenkonsistenz und Latenzfragen zu bewältigen gilt. Viele Dateningenieure argumentieren jedoch, dass diese Modularität den heutigen Anforderungen an Skalierbarkeit und Flexibilität eher gerecht wird als die starren Systeme der HTAP-Vision. Die Debatte um HTAP ist damit keineswegs abgeschlossen.

Experten wie Thom Lawrence weisen darauf hin, dass der Traum von einer einzigen, einheitlichen Datenbasis mit SQL-Interface nach wie vor eine erstrebenswerte Endstation ist. Der Aufwand und die Komplexität des Aufbaus verteilter Systeme ist hoch, und viele Unternehmen verschwenden Ressourcen mit der ständigen Datenbewegung ohne unmittelbaren Mehrwert. Dennoch scheint der pragmatische Weg der Integration über mehrere Systeme der bevorzugte Ansatz zu sein, bis Technologieinnovationen neue Möglichkeiten eröffnen. Parallel dazu beobachten wir eine Renaissance klassischer Datenbanken wie PostgreSQL, die durch Erweiterungen und moderne Features zunehmend analytische Aufgaben unterstützen können und somit für kleinere Unternehmen oder Projekte einen praktischen Kompromiss darstellen. Es wird klar, dass eine starre Einteilung in transaktionale und analytische Systeme zunehmend an Bedeutung verliert und vieles von den individuellen Anforderungen des jeweiligen Anwendungsfalls abhängt.

Zudem ist die Weiterentwicklung der Hardware-Architekturen ein wesentlicher Faktor, der die Diskussion beeinflusst. Neue Speichertechnologien, schnellere Netzwerke und verteilte Computing-Modelle schaffen ganz neue Potenziale, aber auch zusätzliche Komplexitäten, die eine vollständige Fusion von OLTP und OLAP nicht automatisch vereinfachen. Das Spannungsfeld zwischen Ressourceneffizienz und Flexibilität bleibt bestehen. Insgesamt zeigt sich, dass HTAP zwar als Begriff und Konzept an Popularität eingebüßt hat, der Grundgedanke der Integration transaktionaler und analytischer Daten aber weiterhin relevant ist und in veränderter Form gelebt wird. Die modernen Datenökosysteme sind weniger monolithisch, sondern vielmehr modulare, orchestrierte Netzwerke aus Speziallösungen, die durch Streaming, Data Lakes und Echtzeit-Analysewerkzeuge miteinander verbunden sind.