Die Entwicklung von Large Language Models (LLMs) hat in den letzten Jahren die Art und Weise, wie wir mit Technologie interagieren, maßgeblich verändert. Unternehmen und Entwickler stehen jedoch immer wieder vor der Herausforderung, maßgeschneiderte und effiziente Prompts zu erstellen, um optimale Ergebnisse aus diesen Modellen herauszuholen. Dabei spielt das Testen und Bewerten unterschiedlicher Prompt-Varianten eine entscheidende Rolle. Genau hier setzt die neuartige OpenRouter API mit integrierter Prompt A/B Testing-Funktion an und bietet eine innovative Lösung für ein weitverbreitetes Problem in der KI-Entwicklung. Die manuelle Anpassung von Prompts und das subjektive Bewerten ihrer Wirksamkeit sind zeitintensive Prozesse, die häufig auf Einzelerfahrungen beruhen.

Entwickler verbringen oft viele Stunden damit, verschiedene Formulierungen und Strukturen zu testen, ohne belastbare Daten über die tatsächliche Wirkung auf Endnutzer zu haben. Das führt nicht selten zu ineffizienten oder gar überflüssigen Anpassungen. OpenRouter ermöglicht es hingegen, mehrere gleichzeitig laufende Prompts automatisch zu vergleichen und anhand von Nutzerfeedback oder anderen Metriken zu bewerten. So können schnell und objektiv diejenigen Varianten identifiziert werden, die tatsächlich die besten Resultate liefern. Die Technik des A/B Testings ist in der Softwareentwicklung und im Marketing längst bewährt.

Sie basiert auf dem Prinzip, zwei oder mehr Varianten parallel zu evaluieren und anhand klar definierter Kennzahlen zu entscheiden, welche optimal ist. Überträgt man dieses Verfahren auf die Prompt-Gestaltung von LLMs, erhält man einen systematischen, datengetriebenen Ansatz, um die Leistung von Sprachmodellen messbar zu verbessern. Diese Verbindung aus bewährten Methoden der Produktoptimierung und modernster KI-Technologie ist gerade für Entwickler und Unternehmen, die auf schnelle Iterationen und qualitatives Nutzererlebnis angewiesen sind, von unschätzbarem Wert. Die OpenRouter API bietet dabei eine praktische Schnittstelle, über die verschiedene Prompts integriert und getestet werden können. Jeder Prompt kann dynamisch zugewiesen und anschließend mit einem „gut“ oder „schlecht“ bewerteten Feedback aus dem Nutzerkreis versehen werden.

Aus den aggregierten Bewertungen lässt sich ablesen, welche Prompt-Variante die besten Reaktionen hervorruft. Auf Basis dieser Erkenntnisse kann die API stoppen, bestimmte effektive Prompts priorisieren und unperformante Varianten automatisch aussortieren. Das ermöglicht eine kontinuierliche Optimierung, ohne den Entwickler mit manuellem Aufwand zu belasten. Vor allem für produktive Umgebungen, in denen Sprachmodelle in Kundenservice, Content-Erstellung oder Chatbots eingesetzt werden, ist diese Funktionalität ein großer Gewinn. Unternehmen können auf Grundlage präziser Tests und Nutzerbewertungen bessere Entscheidung treffen.

Der Einsatz von OpenRouter fördert zudem die Skalierbarkeit von KI-gestützten Anwendungen, da Anpassungen automatisch und datenbasiert erfolgen. Neben der Effizienzsteigerung wird dadurch auch die Qualität der Interaktionen mit Endkunden merklich gesteigert. Ein wesentlicher Vorteil des Systems ist die Flexibilität und Erweiterbarkeit der OpenRouter Plattform. Entwickler können neue Prompts nach Belieben hinzufügen und so ihre Testbibliothek ständig erweitern. Dies unterstützt vor allem jene, die in dynamischen Umgebungen tätig sind und variierende Anforderungen haben.

Je nach Feedback können Varianten gezielt angepasst, ausgebaut oder komplett ersetzt werden. Dieser iterative Prozess stärkt die Innovationskraft und versetzt Teams in die Lage, schnell auf Trends oder veränderte Nutzerbedürfnisse zu reagieren. Gleichzeitig bietet OpenRouter die Option, das System mehrbenutzerfähig zu gestalten, mit Nutzerkonten und optionalem Abrechnungsmodell. Dadurch erschließt sich eine breitere Zielgruppe, die über einzelne Entwickler hinausgehen kann und in Teams oder Organisationen zusammenarbeitet. Durch das Teilen von Insights und Ergebnissen können gemeinsame Strategien entwickelt und Ressourcen sinnvoll gebündelt werden.

Ein gut organisierter Betrieb und Management von Prompts erhöht die Professionalität und erleichtert den Einsatz in Unternehmensstrukturen erheblich. Natürlich ist die Frage, ob ein Produkt wie OpenRouter mit spezialisiertem A/B Testing einen großen Markt bedient, für den Entwickler essenziell. Die moderne KI-Branche zeigt eine hohe Dynamik und einen stetig wachsenden Bedarf an Tools, die helfen, die Komplexität von LLM-Anwendungen überschaubar zu gestalten. Je mehr Unternehmen auf diese Technologie setzen, desto wichtiger wird es, ihre Modelle optimal zu konfigurieren und kontinuierlich zu verbessern. Die Ansätze von OpenRouter adressieren genau diese Herausforderungen und könnten sich langfristig als Standardlösung etablieren.

Darüber hinaus sprechen verschiedene Anwendungsfelder für einen wachsenden Bedarf an solch moderner Prompt-Optimierung. Im Content-Marketing erzielen präzise und überzeugende Texte eine höhere Nutzerbindung. Im Kundenservice ermöglichen exakte Prompts schnellere und treffendere Antworten. Im Bildungsbereich fördern individuell abgestimmte Dialoge den Lernerfolg. All diese Use Cases profitieren vom datengetriebenen Ansatz der A/B Tests, der zugleich Transparenz und Qualitätssicherung bietet.

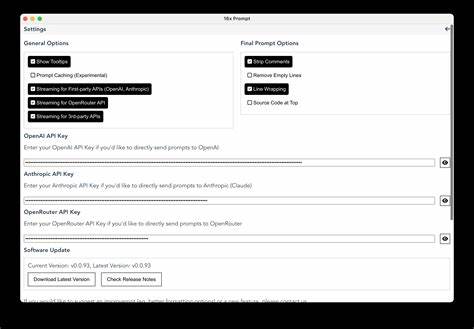

Ein möglicher Einwand betrifft die Nutzerfreundlichkeit und Integrationsfähigkeit der API. Für viele Entwickler ist es entscheidend, dass neue Tools problemlos in bestehende Workflows eingepasst werden können. OpenRouter scheint hier eine gut dokumentierte und flexible API bereitzustellen, die sich leicht anpassen lässt. Der Zeitgewinn durch automatisierte Tests und klaren Bewertungen überwiegt häufig den initialen Aufwand der Integration. Außerdem dürfte die kontinuierliche Weiterentwicklung der Plattform für stetige Verbesserungen sorgen.

Neben technischen Aspekten spielen auch ethische Überlegungen eine Rolle. Bei der automatischen Bewertung von Prompts sollte darauf geachtet werden, dass Feedback fair und nachvollziehbar verwendet wird. Manipulation oder Verzerrungen könnten die Ergebnisse verfälschen und den Nutzen einschränken. Eine transparente Dokumentation und möglicherweise zusätzliche Kontrollmechanismen würden hier für Vertrauen sorgen. Zusammenfassend adressiert OpenRouter mit seiner innovativen A/B Testing Funktion ein zentrales Bedürfnis in der KI-Community.

Die Möglichkeit, Prompts systematisch und datenbasiert zu optimieren, eröffnet neue Chancen, die Leistungsfähigkeit von LLMs nachhaltig zu verbessern. Dies unterstützt Entwickler, Unternehmen und Anwender dabei, bessere, genauere und nutzerorientierte Resultate zu erzielen. Die flexible API, der iterative Prozess und die Ausrichtung auf Nutzerfeedback sind wichtige Bausteine, die das Produkt zukunftsfähig machen. Wer also schon immer nach einer Lösung gesucht hat, um das zeitaufwändige Tippeln in der Prompt-Gestaltung mit belastbaren Daten zu ersetzen, findet in OpenRouter eine vielversprechende Antwort. Die Idee, eigene Bedürfnisfelder zu „scratchen“ und gleichzeitig eine breite Zielgruppe anzusprechen, zeigt, wie Nutzerfokus und Produktentwicklung Hand in Hand gehen können.

Die Nachfrage wird mit wachsender KI-Adoption sicherlich steigen, was den Schritt von einer einfachen Eigenlösung zu einer vollwertigen Plattform attraktiv macht. In einer Welt, in der Künstliche Intelligenz zunehmend an Bedeutung gewinnt, ist die Optimierung ihrer Schnittstellen - hier über Prompts - ein entscheidender Erfolgsfaktor. OpenRouter trifft mit A/B Testing den Nerv vieler Entwickler, die ihre Abläufe verbessern möchten. Wer heute auf der Suche nach einem effizienten, skalierbaren und anwenderfreundlichen Ansatz für Prompt-Management ist, sollte die Möglichkeiten und Perspektiven dieser API genauer betrachten.