Die öffentliche und wissenschaftliche Diskussion über Künstliche Allgemeine Intelligenz – kurz AGI – hat in den letzten Jahren enorm an Bedeutung gewonnen. Die Vorstellung, dass eine Maschine irgendwann genauso kompetent oder gar kompetenter als Menschen in einer Vielzahl von Aufgaben agieren könnte, weckt sowohl große Hoffnungen als auch Ängste. Doch ein weit verbreiteter Irrtum ist die Annahme, dass AGI ein klar definierbarer Meilenstein ist, dessen Erreichen plötzlich und dramatisch die Welt verändern wird. Diese Denkweise verdient eine kritische Hinterfragung. AGI ist kein plötzliches Ereignis, sondern eher ein kontinuierlicher Prozess, dessen Bedeutung sich erst im Verlauf der Zeit herauskristallisiert.

Dieser Text erläutert, warum AGI nicht als sprunghafter Meilenstein betrachtet werden sollte, welche Implikationen dies für Wirtschaft, Politik und Gesellschaft hat und warum eine differenzierte Betrachtung von Fähigkeiten und Macht im Kontext von AI unabdingbar ist. Zunächst muss die fundamentale These geklärt werden: Es gibt keine objektive, allgemein anerkannte Schwelle, die definieren würde, wann AGI wirklich erreicht ist. Hacker, Wissenschaftler und Organisationen definieren AGI oft unterschiedlich, sei es anhand menschlicher Leistungsfähigkeit, der Vielfalt der Aufgaben oder der Wirtschaftlichkeit der AI-Systeme. Doch obwohl es unzählige Definitionen gibt, wäre eine solche wichtige Errungenschaft in der Geschichte der Technik nicht so schwer zu erkennen wie oft angenommen. Bei Technologie-Meilensteinen früherer Epochen, wie etwa der Entwicklung der Kernwaffen, gab es klare, sofort sichtbare Zeichen – eine Explosion, die im wahrsten Sinne des Wortes alles veränderte.

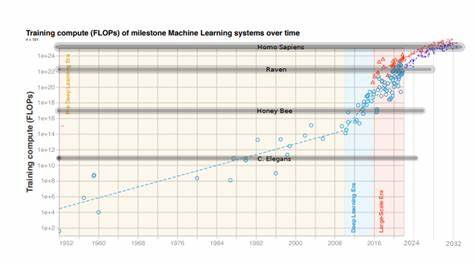

AGI dagegen hinterlässt kein solch eindeutiges Merkmal, sondern entwickelt sich schrittweise im Schatten, begleitet von stetigen Verbesserungen und einer langsamen aber kontinuierlichen Integration in unterschiedlichste Bereiche. Auch die Behauptung, AGI werde unmittelbar massive wirtschaftliche Umwälzungen bewirken, erscheint angesichts historischer Erfahrungen mit sogenannten general purpose technologies (GPTs) wie Elektrizität, dem Computer oder dem Internet nicht haltbar. Die tatsächlichen Auswirkungen solcher Technologien entfalten sich meist über Jahrzehnte und setzen die Überwindung zahlreicher soziotechnischer Hindernisse voraus. Die Entwicklung neuer AI-Modelle allein führt nicht automatisch zu deren sofortiger und breitflächiger Anwendung. Vielmehr sind ergänzende Innovationen in Bereichen wie Produktentwicklung, Ausbildung, Unternehmenskultur und Regulierung nötig, um eine tiefgreifende Diffusion zu gewährleisten.

In der Praxis bedeutet das, dass die breite Verbreitung leistungsfähiger AI-Lösungen einen langwierigen Prozess bezeichnet, der sich über menschliche Zeitmaßstäbe erstreckt, und keineswegs in wenigen Monaten oder Jahren realisiert werden kann. Diese Sichtweise relativiert auch die Angst vor plötzlicher Arbeitslosigkeit durch „Roboter“, die alle menschlichen Tätigkeiten übernehmen würden. Menschen passen sich an die Veränderungen an, entwickeln neue Fähigkeiten und verlagern ihre Tätigkeit auf Bereiche, die technologisch weniger leicht automatisierbar sind. Während bestimmte Jobs durch AI unterstützt oder ersetzt werden, entstehen gleichzeitig neue Tätigkeitsfelder, Arbeitsmodelle und Wirtschaftszweige. Die damit verbundene Transformation ist dadurch ein zyklischer Prozess und kein abruptes Ereignis mit singulärer Ursache.

Auch der vermeintliche geopolitische Wettlauf zwischen Staaten im Bereich AI, besonders zwischen USA und China, wird durch die Betrachtung von Diffusion und Innovationsökosystemen komplexer. Zwar kann ein Land temporär Vorteile bei Erfindungen oder technischen Neuerungen erringen, tatsächliche Dominanz erfordert aber die Fähigkeit, Technologie effektiv in Wirtschaft und Gesellschaft zu implementieren. Dies hängt von Faktoren wie Infrastruktur, Fachkräftemarkt, Digitalisierung und regulatorischem Umfeld ab. In der Realität gleichen sich AI-Kompetenzen und Technologien schnell an, aufgrund globaler Vernetzung und Wissensaustausch, wodurch ein nachhaltiger Vorsprung schwer zu halten ist. Der Fokus sollte daher weniger auf dem Rennen um die erste AGI liegen, sondern vielmehr auf dem Fördern und Gestalten einer effektiven, verantwortungsvollen Technologieverbreitung.

Ein weiterer wichtiger Aspekt ist die oft verwischte Unterscheidung zwischen den Fähigkeiten eines AI-Systems und der Macht, die es in einer realen Umgebung ausüben kann. Fähigkeiten beziehen sich auf das Potenzial eines Systems, bestimmte Aufgaben zu erfüllen, während Macht das tatsächliche Umsetzen dieser Fähigkeiten in der Welt beschreibt. Diese Macht ist stark abhängig von menschlichen Entscheidungen und der regulatorischen sowie sozialen Gestaltung der Umgebung. Ein AI-System könnte also theoretisch äußerst fähig sein, aber ohne Zugriffsrechte, Autonomie oder Kontrolle im realen Kontext sehr begrenzt in seiner Wirkung bleiben. Die Angst vor einem plötzlichen Kontrollverlust über AI und einer unkontrollierbaren Superintelligenz basiert oft auf einem generischen Gedankenexperiment über exponentielle Selbstverbesserung von AI-Systemen.

Tatsächlich zeigen aktuelle Entwicklungen jedoch, dass Fortschritte und Innovationen durch eine Vielzahl von Faktoren gebremst sind. Dazu zählen der Bedarf an großen Datenmengen, Finanzmitteln, Kollaborationen, realweltlichen Tests und die soziale Organisation von Forschung. Zwar können AI-Modelle als Hilfsmittel in der Forschung fungieren und diese effizienter gestalten, doch eine explosionsartige, unkontrollierbare Entwicklung scheint aufgrund der komplexen Rahmenbedingungen unwahrscheinlich. Wichtig ist es dennoch, Frühwarnsysteme und Monitoring zu implementieren, um potenzielle Risiken zu beobachten und angemessen zu reagieren. Auch die Frage, ob und wie man feststellen kann, dass AGI erreicht ist, bleibt ungelöst.

Während viele Definitionen auf der Verhaltensebene ansetzen, also an Benchmarks und Tests, zeigen praktische Erfahrungen, dass diese nicht zuverlässig auf reale Fähigkeiten oder den Einfluss im echten Arbeitskontext schließen lassen. AI-Systeme können in Tests oft gut abschneiden, während sie im Alltag versagen oder unsicher sind. Die Internationale Gemeinschaft der Forscher und Entwickler steht deshalb vor der Herausforderung, Klippen und Grenzen bei der Bewertung von AGI zu erkennen und nicht in eine unreflektierte Erwartungsblase zu verfallen. Für Unternehmen, Entwickler und politische Entscheidungsträger bedeutet die Erkenntnis, dass AGI kein abruptes Ereignis ist, eine Aufforderung zur Langfristigkeit und Vorsicht. Schnelles Überstürzen bei der Einführung von AI-Anwendungen läuft Gefahr, unbeabsichtigte Folgen hervorzurufen und die Akzeptanz zu untergraben.

Stattdessen sind sorgfältige Tests, eine tiefgehende Erfassung branchenspezifischer Anforderungen und eine schrittweise Integration essenziell, um tatsächlich den Nutzen von AI effizient und verantwortungsbewusst zu realisieren. Politisch sollten Mittel und Anstrengungen vor allem auf Förderung von Innovationen, Ausbildung und Regulierung gerichtet werden, die eine sichere und produktive Verbreitung von AI ermöglichen. Zusammenfassend lässt sich festhalten, dass AGI als konzeptioneller Meilenstein, der plötzliche Revolutionen auslöst, irreführend ist. Die wahre Herausforderung liegt in der langsamen, oft unspektakulären Diffusion der Technologie, die von sozialen, kulturellen, wirtschaftlichen und politischen Faktoren abhängt. Künstliche Intelligenz wird unsere Welt verändern, aber nicht als ein einzelner Moment des Umschwungs, sondern als ein Prozess, der sich über Jahre bis Jahrzehnte entfaltet.

Zu verstehen, dass AGI nicht das Ende oder der Anfang aller Dinge ist, sondern ein Teil eines größeren Wandels, ist für eine realistische Einschätzung, verantwortungsvolle Steuerung und nachhaltige Gestaltung der Zukunft unabdingbar.