Die jüngsten Fortschritte im Bereich der künstlichen Intelligenz (KI) und insbesondere bei großen Sprachmodellen (Large Language Models, LLMs) haben die Art und Weise revolutioniert, wie wir mit Computern interagieren. Modelle wie OpenAI's GPT, Meta's Llama oder Falcon sind in der Lage, hochkomplexe Aufgaben zu bewältigen, von der Textgenerierung über Übersetzungen bis hin zu komplexen Dialogen. Der Haken: Die meisten dieser Modelle erfordern immense Rechenleistung und sind meist nur über Cloud-Dienste zugänglich, was mit hohen Kosten und Datenschutzbedenken einhergeht. Hier setzt das innovative Projekt Petals an, das es ermöglicht, große Sprachmodelle in einem verteilten Netzwerk zu betreiben – und das BitTorrent-ähnlich. Dadurch wird die Nutzung großer KI-Modelle demokratisiert und für jedermann zugänglich gemacht, ohne in teure Hardware investieren zu müssen.

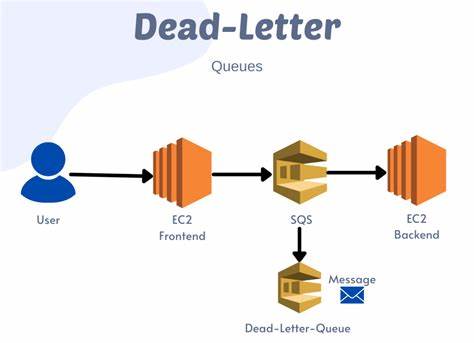

Petals ist ein verteiltes System, das es Nutzerinnen und Nutzern erlaubt, selbst große KI-Modelle wie Llama 3.1 mit bis zu 405 Milliarden Parametern, Mixtral, Falcon oder BLOOM mit mehreren Hundert Milliarden Parametern zu nutzen. Das Besondere ist, dass man nicht den kompletten Modellcode oder alle Gewichte lokal speichern oder verarbeiten muss. Stattdessen lädt jeder Teilnehmer einen Teil des Modells und verbindet sich mit einem Netzwerk von anderen Nutzern, die jeweils andere Teile bereitstellen. Dieses Prinzip erinnert stark an das File-Sharing-Protokoll BitTorrent, bei dem viele Teilnehmer gemeinsam Dateien verteilen und herunterladen.

So entsteht ein leistungsfähiges, dezentrales Rechen-Netzwerk, das auch komplexe Anfragen schnell bedienen kann. Durch dieses innovative Netzwerkmodell können KI-Anwendungen und Entwickler auf große LLMs zugreifen, ohne über High-End-Server oder teure Cloud-Dienste verfügen zu müssen. Es ist sogar möglich, Petals mit Consumer-Grafikkarten zu nutzen oder die kostenfreie Rechenleistung von Diensten wie Google Colab einzusetzen. Damit öffnet Petals neue Möglichkeiten insbesondere für Forschung, Bildung und kleine Unternehmen, die bislang von der Skalierung großer Modelle ausgeschlossen waren. Einer der großen Vorteile von Petals ist die Flexibilität.

Anders als bei klassischen LLM-APIs, bei denen die Nutzer oft an vordefinierte Schnittstellen und Modelle gebunden sind, bietet Petals die Möglichkeit, eigene Feinabstimmungen durchzuführen, individuelle Sampling-Methoden zu verwenden oder sogar benutzerdefinierte Pfade durch die Modelle zu explorieren. Dies ermöglicht eine tiefergehende Kontrolle und Anpassung, die besonders für wissenschaftliche Zwecke, maßgeschneiderte Anwendungen und kreative Experimente sehr wertvoll ist. Ein weiterer Pluspunkt von Petals ist die Geschwindigkeit bei der Inferenz. Trotz des verteilten Ansatzes erreichen die Modelle flüssige Antwortzeiten von bis zu 6 Tokens pro Sekunde bei Llama 2 (70 Milliarden Parameter) oder etwa 4 Tokens pro Sekunde beim Falcon-Modell mit 180 Milliarden Parametern. Das genügt vollkommen für den Betrieb interaktiver Chatbots und Anwendungen, bei denen ein schneller und natürlicher Dialog wichtig ist.

Die Kombination aus verteiltem System und lokal verfügbarer Rechenkapazität sorgt also dafür, dass die KI-Antworten angenehm zügig geliefert werden. Die Nutzung von Petals bietet zudem für Datenschutzbegeisterte große Vorteile. Da das Modell gemeinsam von einem Netzwerk verschiedener Teilnehmer betrieben wird, verbleiben die zugrunde liegenden Daten und Anfragen nicht ausschließlich bei externen Cloud-Anbietern. Dies kann helfen, sensible Daten und Informationen besser zu schützen und die Kontrolle über die eigene KI-Umgebung zu behalten. Insbesondere Unternehmen oder Anwender mit strengen Compliance-Vorgaben profitieren von dieser dezentralen Architektur.

Der Einsatz von Petals ist auch für die Community von großem Interesse. Da das Projekt offen und beteiligt ist, kann jeder mit einer GPU seine Rechenleistung beitragen und so aktiv Teil eines wachsenden Netzwerks werden. Dies wird aktuell auf Plattformen wie Discord organisiert, wo Entwickler und Nutzer sich austauschen, die Entwicklung verfolgen und zum Fortschritt beitragen können. Die aktive Community trägt dazu bei, Petals stetig zu verbessern, neue Modelle zu integrieren und innovative Nutzungsszenarien zu erschließen. Für Entwickler, die sich mit der Implementation oder dem feinen Tuning großer Modelle beschäftigen, stellt Petals eine spannende Alternative zu bisherigen Cloud-Anbietern dar.

Die Integration in bestehende PyTorch- oder Hugging Face-Transformers-Pipelines ermöglicht es, die gewohnte Programmierumgebung zu nutzen und dabei von der dezentralen Rechenleistung zu profitieren. So vereint Petals den Komfort klassischer API-Lösungen mit der Flexibilität individueller KI-Entwicklung. Die Möglichkeit, anspruchsvolle Sprachmodelle ohne große finanzielle Investitionen und Infrastruktur selbst einzusetzen, hat das Potenzial, die KI-Landschaft nachhaltig zu verändern. Neben Kosteneinsparungen verbessert Petals auch die Barrierefreiheit, denn Forscher und Entwickler aus dem akademischen Bereich oder Schwellenländern können so ohne teure Ressourcen an modernen KI-Experimenten teilnehmen. Dies fördert eine diversere und resilientere KI-Community und kann Innovationen beschleunigen.

Die technische Basis von Petals ist dabei ebenso spannend wie innovativ. Neben der intelligenten Verteilung der Modellgewichte und Rechenaufgaben spielt auch die effiziente Kommunikation zwischen den Knoten eine wichtige Rolle. Latenzzeiten werden minimiert, und so wird sichergestellt, dass das System trotz der Verteilung gut skaliert und zuverlässig funktioniert. Neben der Nutzung im Internet sind auch hybride Szenarien denkbar, bei denen Petals-Cluster beispielsweise in Firmennetzwerken oder universitären Rechenzentren betrieben werden. Zusammengefasst revolutioniert Petals die Art und Weise, wie große Sprachmodelle nutzbar gemacht werden.

Der BitTorrent-ähnliche verteilte Ansatz ermöglicht es, die immense Rechenleistung und Speicherkapazität von Modellen mit Hunderten von Milliarden Parametern über viele Teilnehmer zu verteilen. Damit verschiebt Petals die Grenzen von KI-Anwendungen hin zu mehr Zugänglichkeit, Transparenz und individuellem Einsatz. Wer heute mit großen Sprachmodellen experimentieren oder produktive KI-Anwendungen entwickeln möchte, findet in Petals eine spannende und innovative Möglichkeit, dies ohne große Investitionen zu tun. Besonders für Nutzer mit begrenzter Hardware oder solche, die besonderen Wert auf Datenschutz legen, ist es ein Schritt in die richtige Richtung. Die Kombination aus offener Entwicklung, aktiver Community und moderner Infrastruktur macht Petals zu einem Leuchtturmprojekt in der Welt der verteilten KI.

Sie können Petals bereits jetzt auf Plattformen wie Google Colab ausprobieren und sich in der GitHub-Dokumentation zum Projekt vertiefen. Mit wachsenden Nutzerzahlen und kontinuierlicher Verbesserung ist zu erwarten, dass Petals noch mehr Modelle und verbesserte Performance bieten wird. Die Vision einer breiten, gemeinschaftlich genutzten KI-Infrastruktur ist so greifbarer denn je. Die Zukunft der KI gehört verteilten Systemen wie Petals – leistungsfähig, flexibel und offen für alle.