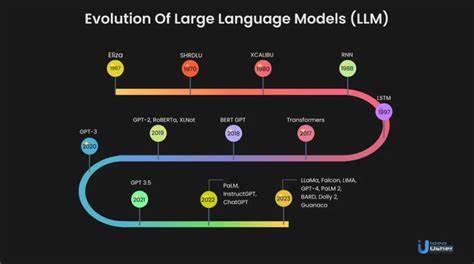

Die fundamentale Physik steht an einem besonderen Wendepunkt. Mit der rasanten Entwicklung von Künstlicher Intelligenz und insbesondere der sogenannten großen Sprachmodelle (Large Language Models, LLMs) eröffnen sich neue Möglichkeiten, die komplexesten Fragen unseres Universums besser zu verstehen. Lange Zeit galten LLMs vor allem als Werkzeuge zur Verarbeitung natürlicher Sprache etwa im Bereich des Kundenservice oder der Textgenerierung. Doch nun zeigen sich vielversprechende Anwendungen in der Physik, insbesondere in der Kosmologie, der Astrophysik und der Analyse von großen Datenmengen aus Experimenten und Simulationen. Dieses Potenzial folgt aus der Fähigkeit von LLMs, komplexe Korrelationen zu erkennen, Muster in Daten zu identifizieren und dabei auch Wissen aus unterschiedlichen Fachgebieten zu verknüpfen.

Ein herausragendes Beispiel für den Fortschritt der KI in der Physik ist das Modell Qwen2.5, ein großer Sprachtransformer, der erfolgreich auf quasi-out-of-domain Daten vortrainiert wurde und nun für spezifische physikalische Anwendungen angepasst wird. Die Integration solcher Modelle mit speziell entwickelten Systemen, wie sogenannten Connector-Netzwerken, ermöglicht es, einzigartige Aufgaben zu übernehmen, die zuvor als äußerst herausfordernd galten. Diese Kombination aus vortrainierten LLMs und maßgeschneiderten Architekturen wird als Lightcone LLM (L3M) bezeichnet. Hauptsächlich wird L3M eingesetzt, um 3D-Karten der großräumigen Struktur des Universums zu generieren und auszuwerten.

Dabei wird eine der größten Herausforderungen der Kosmologie adressiert, nämlich die Rekonstruktion der sogenannten Lichtkegel – sogenannte Lightcones –, die die Entwicklung der Materiestruktur im beobachtbaren Universum über Raum und Zeit hinweg beschreiben. Die Fähigkeit, Lichtkegel zu erzeugen oder berechnen, ist entscheidend für das Verstehen der Dynamik des Universums, des Einflusses von Dunkler Materie, Dunkler Energie und anderer fundamentaler Parameter. Die Anwendung von LLMs in diesem Kontext hebt sich deutlich gegenüber herkömmlichen Ansätzen ab. Traditionelle Methoden zur Analyse kosmologischer Daten sind oft auf spezialisierte neuronale Netze angewiesen, die generell nur für einen eng begrenzten Aufgabenbereich optimiert sind und eine begrenzte Flexibilität besitzen. Hingegen zeigt die Erfahrung mit dem Lightcone LLM, dass es nicht nur besser initialisiert ist – dank seiner vortrainierten Gewichte aus einer sehr breiten Datenbasis –, sondern auch vergleichsweise die Leistung dedizierter Netzwerke ähnlicher Größe übertrifft.

Die Implikationen dieser Entwicklungen sind vielschichtig. Für die Kosmologie bedeutet es, dass wir zukünftig tiefere und genauere Einblicke in die großräumige Verteilung der Materie und die zugrundeliegenden physikalischen Prozesse gewinnen können. Darüber hinaus öffnet sich ein neues Forschungsfeld für die fundamentale Physik, in dem KI nicht nur klassische Datenanalyse unterstützt, sondern interaktiv in der Modellbildung, Hypothesengenerierung und sogar in der Auswertung von Theorien selbst eingebunden wird. Ein weiterer wesentlicher Vorteil der Verwendung großer Sprachmodelle liegt in ihrer Fähigkeit, Wissen aus unterschiedlichen Quellen zusammenzuführen. Beispielsweise können sie Erkenntnisse aus experimentellen Daten, theoretischen Modellen und Simulationen miteinander kombinieren.

Dies ist besonders wertvoll in einem Bereich wie der fundamentalen Physik, wo interdisziplinäre Ansätze langfristig erfolgversprechend sind. Dabei ermöglichen LLMs eine Art Transferlernen, bei dem Modelle auf einer Aufgabe oder einem Datensatz vortrainiert und anschließend auf neue, oftmals out-of-domain Daten angewandt werden. Die Herausforderung und Chance zugleich besteht darin, diesen Transfer so effektiv zu gestalten, dass das Modell nicht nur an neue Daten angepasst wird, sondern auch seine ursprüngliche, generalisierte Fähigkeit bewahrt. Die Arbeit mit dem Qwen2.5 Modell ist ein prominentes Beispiel für gelungenes Transferlernen.

Es wird auf großen Textcorpora aus vielen Anwendungsbereichen vortrainiert und dann mit einer spezifischen Architektur für kosmologische Anwendungen verbunden. Dies eröffnet den Weg für einen neuen Paradigmenwechsel in der wissenschaftlichen Datenanalyse. Die Nutzung von LLMs wie Qwen2.5 birgt das Potenzial, auch experimentelle Daten zukünftiger Teleskope und Observatorien effizienter zu verarbeiten. Zum Beispiel bei der Analyse von Daten des Square Kilometre Array (SKA), dem weltweit größten Radioteleskopprojekt, das die detaillierte Kartierung der kosmischen Large-Scale Structure ermöglichen wird.

Hier sind die Datenmengen enorm, komplex und multidimensional, was traditionelle Analysemethoden an ihre Grenzen bringt. LLM-basierte Ansätze könnten jene Datenflut nicht nur bewältigen, sondern auch neue Erkenntnisse gewinnen, indem sie verborgene Zusammenhänge erkennen, die Menschen oder klassische Algorithmen übersehen. Zudem ist der Einsatz von KI in der fundamentalen Physik nicht auf die Kosmologie beschränkt. Viele Bereiche, von der Teilchenphysik über die Quantenfeldtheorie bis hin zur Astrophysik, könnten von der KI-gestützten Analyse und Generierung neuer Daten profitieren. Große Sprachmodelle bieten die Möglichkeit, komplexe experimentelle Konfigurationen zu verstehen, Simulationen schneller durchzuführen oder sogar neue theoretische Hypothesen zu formulieren.

Nicht zuletzt ermöglichen LLMs eine beschleunigte Kommunikation und Kollaboration innerhalb der Forschergemeinschaft. Indem sie komplexe Fachliteratur und große Datenmengen in verständliche Zusammenfassungen und Erklärungen übersetzen, erleichtern sie den Zugriff auf Wissen und fördern den wissenschaftlichen Austausch. Gleichzeitig stellen LLMs gewisse Herausforderungen dar. Die interpretierbare Ausgabe, Black-Box-Charakter und der Bedarf an umfangreichen Rechenressourcen sind Themen, die intensiv erforscht werden müssen. Darüber hinaus ist es essentiell, die Modelle kontinuierlich zu validieren und Fehlerquellen zu minimieren, besonders bei Anwendungen in der fundamentalen Physik, wo Genauigkeit und Verlässlichkeit oberste Priorität haben.

Insgesamt zeigt die Integration großer Sprachmodelle in fundamentale physikalische Fragestellungen ein enormes Potenzial und markiert möglicherweise einen bedeutenden Schritt in der wissenschaftlichen Methodik. Der Übergang von klassischen, spezialisierten Algorithmen hin zu flexibleren, vortrainierten Modellsystemen kann die Effizienz und Qualität der Forschung steigern. Besonders die interdisziplinäre Kombination aus fortschrittlicher KI und moderner Physik könnte neue Entdeckungen fördern, die unser Verständnis des Universums nachhaltig prägen. In den kommenden Jahren ist damit zu rechnen, dass die Entwicklung und Anwendung von LLMs in der Physik stark zunehmen wird. Neue Modelle werden speziell für wissenschaftliche Aufgaben optimiert, und die interaktive Zusammenarbeit zwischen Physikern und KI-Systemen wird zur Normalität.

Dies eröffnet eine Zukunft, in der Machine Learning und fundamentale Physik sich gegenseitig beflügeln – und damit vielleicht einige der tiefsten Geheimnisse unseres Kosmos entschlüsseln.