In der modernen IT-Landschaft gewinnt das Monitoring von Systemen zunehmend an Bedeutung. Im Zeitalter der digitalen Transformation ist es für Unternehmen unerlässlich geworden, ihre Infrastruktur, Anwendungen und Geschäftsprozesse kontinuierlich zu überwachen. Doch während Überwachung grundsätzlich unverzichtbar ist, bringt der Trend zu immer komplexeren und umfassenderen Observability-Stacks eine gravierende Gefahr mit sich: die Überwachungsfalle – oder auf Englisch „The Overmonitoring Trap“. Diese Falle zeigt sich darin, dass Unternehmen viel Zeit, Geld und Ressourcen in die Erfassung einer enormen Datenmenge investieren, ohne dabei den erhofften Nutzen zu erzielen. Statt die Zuverlässigkeit zu erhöhen, führt eine übermäßige Datensammlung und zu komplexe Überwachungssysteme häufig zu Kostenexplosionen, erhöhter Komplexität und Alarmmüdigkeit bei den verantwortlichen Teams.

Die Versuchung, möglichst viele Metriken, Logs und Traces gesammelt darzustellen, ist groß. Moderne Tools wie Prometheus, Grafana, ELK-Stacks oder spezialisierte Application Performance Monitoring-Dienste wie Datadog und New Relic erleichtern diesen Prozess immens. So wird schnell das gesamte System mit einer Vielzahl an Dashboards, KPIs und Alarmen ausgestattet. Doch genau darin liegt die Gefahr. Sobald die Überwachungslösungen so umfangreich sind, dass sie mehr Aufmerksamkeit als das eigentliche Produkt erfordern, entsteht ein Paradoxon.

Techniker werden nachts durch zahllose Fehlalarme geweckt, die zu keiner schnellen Problemlösung beitragen. Dashboards verwalten hunderte von Indikatoren, von denen viele kaum einen direkten Einfluss auf das Tagesgeschäft haben. Ergebnis ist nicht mehr Kontrolle und Zuverlässigkeit, sondern Überforderung und Ineffizienz. Ein sehr anschauliches Beispiel für die Überwachungsfalle lieferte das Startup Schedulicious. Dieses Unternehmen setzte zu Beginn bewusst auf einfache Mittel – eine Ruby-on-Rails-Anwendung, ein PostgreSQL-Datenbank und minimalistische CloudWatch-Metriken.

Die Anwendung war stabil und erfüllte die Anforderungen ihrer ersten Nutzer. Doch getrieben durch den Wunsch des CTOs, immer „am Puls der Zeit“ zu sein, wurde innerhalb weniger Monate ein extrem komplexes Observability-Set-up aufgebaut. Von einem Prometheus-Server mit hunderten individuellen Metriken über mehrere Grafana-Dashboards bis hin zu einer kompletten ELK-Stack-Infrastruktur für Logging sowie Jaeger für Distributed Tracing wurde alles implementiert – obwohl das System nur aus einem Monolithen bestand. Die Folgen waren dramatisch. Die Kosten für Infrastruktur explodierten, die Wartung der Überwachungslösungen beanspruchte dauerhaft mehrere Entwicklerstunden, und nahezu jeder Alarm bedeutete großen Aufwand oder Frust.

Das Team verbrachte mehr Zeit damit, den Monitoring-Datenstrom zu analysieren, als tatsächliche Verbesserungen am Produkt vorzunehmen. Dies gipfelte in einem Vorfall, bei dem ein simpler Verbindungslimit-Fehler in der Datenbank den Zugang der Nutzer blockierte. Hätte man sich bei der Überwachung auf einfache, wichtige Metriken konzentriert, wäre der Fehler deutlich schneller zu finden gewesen. Stattdessen ging wertvolle Zeit verloren – ein Sinnbild für die Überwachungsfalle in Reinform. Doch warum fällt gerade die IT-Branche so häufig in diese Falle? Zum einen spielt der Innovationsdruck und der Wunsch, mit modernen Technologien und Trends Schritt zu halten, eine große Rolle.

Wer heute auf Konferenzen hört, dass vollständige Distributed Tracing oder „Full Observability“ zum unverzichtbaren Standard gehören, will nicht als veraltet dastehen. Zusätzlich fördern Softwareanbieter und Tools das Bild, dass nur mit einer umfassenden Datenerfassung volle Kontrolle möglich ist. Diese Dynamik wird zu einer regelrechten Wettbewerbsspirale: Die Unternehmen messen sich daran, wer die „größten“ und „umfassendsten“ Monitoringlösungen einsetzt – oft ohne den Ursprung des Problems zu hinterfragen. Die tatsächlichen Kosten dieser Strategie sind vielfältig. Neben erheblichen Ausgaben für Infrastruktur und Services, welche die Speicherung und Verarbeitung großer Mengen von Metriken und Logs erfordern, entsteht eine immense Belastung für die Teams.

Das sogenannte Alert-Fatigue-Syndrom ist hierbei besonders problematisch. Wenn permanent Warnungen ausgegeben werden, die keine echten Probleme darstellen, verlieren Mitarbeiter schnell das Vertrauen in die Alarmierung. Wichtige Vorfälle werden übersehen oder nicht mit der nötigen Dringlichkeit behandelt. Dies führt nicht nur zu einem schlechteren Betrieb der Systeme, sondern erschwert auch die Bindung qualifizierter Fachkräfte, die sich von sinnlosen Störungen und Stress abwenden. Auch die kognitive Belastung für das Team steigt enorm.

Betriebsverantwortliche haben dutzende Dashboards vor sich, die in verschiedenster Weise konfiguriert sind. Die Analyse der Daten nimmt viel Zeit in Anspruch, und die Konzentration auf wirklich relevante Kennzahlen wird erschwert. Die Folge: Die Effektivität beim Erkennen von tatsächlichen Problemen sinkt. Proaktive Maßnahmen und gezieltes Troubleshooting geraten ins Hintertreffen. Die Lösung dieses Dilemmas liegt in einem bewussten, pragmatischen Monitoring-Ansatz.

Die Devise „Weniger ist mehr“ gewinnt hier eine absolute Priorität. Statt jedes Detail zu messen, sollten sich Teams auf essenzielle Systemmetriken konzentrieren, die den Gesundheitszustand der Anwendung und Infrastruktur tatsächlich abbilden und bei Problemen rasch reagieren können. Die bekannten „Four Golden Signals“ von Google sind hier eine bewährte Grundlage. Diese umfassen Latenz, Durchsatz (Traffic), Fehlerquote und Sättigung (z. B.

CPU, Speicher). Mit wenigen aussagekräftigen Kennzahlen lässt sich bereits ein sehr guter Überblick schaffen. Darüber hinaus ist es sinnvoll, auch geschäftsrelevante Metriken einzubeziehen, die den Nutzen für die Anwender und den wirtschaftlichen Erfolg abbilden. So können Conversion-Raten, aktive Nutzerzahlen oder wichtige Prozesskennzahlen direkt überwacht werden. Dies stellt einen klaren Bezug zum Geschäftserfolg her und sorgt für fokussierte Alarmierung.

Ein weiterer entscheidender Baustein ist ein wohlüberlegtes Alarmmanagement. Nicht jeder Anstieg einer Metrik muss unmittelbar eine Warnung auslösen. Kriterien für Alarme sollten sicherstellen, dass nur relevante, dringliche und für Menschen wirklich eingreifbare Situationen eine direkte Benachrichtigung auslösen. Automatische Remediationsmaßnahmen können helfen, viele Probleme ohne menschliches Zutun zu lösen, so dass nur bei echten Ausfällen oder Wiederholungsfehlern ein Alarm erfolgt. Dies reduziert die Anzahl von Fehlalarmen massiv und verbessert die Reaktionsfähigkeit.

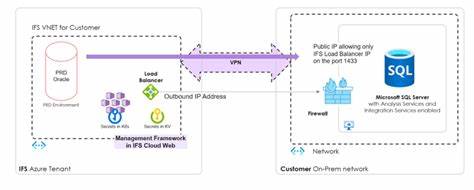

Für viele kleine und mittelgroße Anwendungen reicht eine reduzierte Metrikbasis und einfache Dashboards aus. Der Betrieb wird dadurch überschaubarer und günstiger. Die kontinuierliche Wartbarkeit der Monitoring-Lösungen wird gesichert und der Fokus verlagert sich zurück auf die Produktweiterentwicklung. Natürlich gibt es auch berechtigte Gründe für komplexere Monitoring-Setups. Sobald Systeme stark fragmentiert sind und viele Microservices miteinander kommunizieren, ist verteiltes Tracing durchaus sinnvoll und erleichtert das Auffinden von Fehlerquellen.

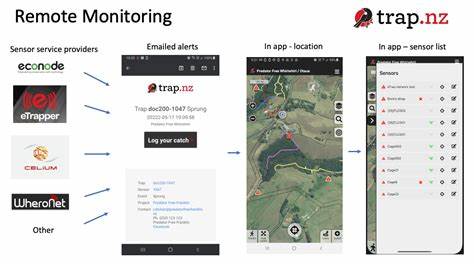

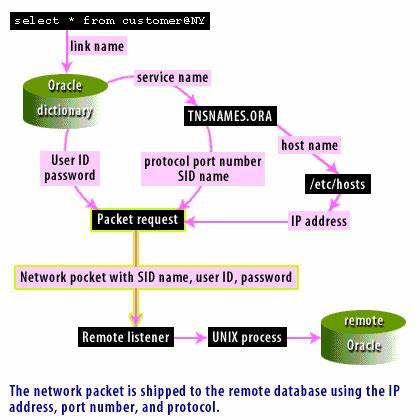

Ebenso kann in regulierten Branchen oder bei strengen Service-Level-Agreements eine detailliertere Überwachung erforderlich sein. Doch auch dann ist der Schlüssel ein bedarfsgerechter, inkrementeller Ausbau der Monitoring-Komplexität – nicht das blinde Übernehmen von Best Practices ohne eigene Analyse. Ein weiterer Gedanke ist die Nutzung von Cloud-eigenen oder managed Monitoring-Diensten. Diese Dienste entlasten die eigenen Teams im Umgang mit Storage, Skalierung und Infrastruktur und erlauben es, sich auf die wirklich kritischen Metriken zu konzentrieren. CloudWatch, Google Cloud Monitoring oder Azure Monitor bieten umfangreiche Grundfunktionalitäten, die für viele Unternehmen ausreichend sind.

Auch spezialisierte Managed-Logging-Services bieten eine einfache Alternative zum aufwendigen Selbstbetrieb von ELK-Stacks. Zusammenfassend ist die Beobachtung klar: Effizientes Monitoring lebt von Einfachheit und Fokus. Monitoring darf nicht zum Selbstzweck oder zusätzlichen Betriebsaufwand werden. Nur wer seine Überwachung an den tatsächlichen Bedürfnissen orientiert, vermeidet die Überwachungsfalle erfolgreich. Dabei sind pragmatische Maßnahmen, ein klares Zielbild und eine iterative Vorgehensweise entscheidend.

Am Ende sollte man sich stets die Frage stellen, welche Metriken wirklich etwas über die Gesundheit und Zuverlässigkeit des Systems aussagen, welche Alarme dringend menschliche Aufmerksamkeit erfordern und wie sich die gewonnenen Erkenntnisse konkret in der Weiterentwicklung des Produkts nutzen lassen. Weniger Daten, weniger Arbeitsbelastung und weniger Fehlalarme erhöhen die Qualität der Überwachung und helfen dabei, die Systeme tatsächlich einfach und zuverlässig am Laufen zu halten. Die Überwachungsfalle lohnt sich nicht – die einfache Überwachung dagegen schon.