In der sich rasant entwickelnden Welt der Künstlichen Intelligenz hat sich die Transformer-Architektur, insbesondere die GPT-Modelle, als revolutionärer Meilenstein erwiesen. Während viele dieser Modelle komplexe Strukturen und enorme Rechenressourcen erfordern, zeigt ein Projekt namens "gpt-go" eindrucksvoll, dass einfache und dennoch leistungsfähige KI-Lösungen mit überschaubarem Aufwand entwickelt werden können. Dieses Projekt realisiert ein einfaches GPT-Modell vollständig in der Programmiersprache Go und trainiert es auf den klassischen Texten von Jules Verne. Dadurch entsteht eine faszinierende Verbindung zwischen Literaturgeschichte und moderner Technologie, die in der Entwicklercommunity Aufmerksamkeit erregt. Das "gpt-go" Projekt folgt einem radikal minimalistischen Ansatz, der nicht darauf abzielt, mit den Hochleistungs-GPT-Varianten großer Unternehmen zu konkurrieren, sondern vielmehr die zugrundeliegenden Prinzipien und Mechanismen auf transparente Weise zugänglich zu machen.

Die Entscheidung, die Programmiersprache Go zu nutzen, ist dabei kein Zufall. Go ist bekannt für seine Effizienz, Lesbarkeit und leichte Parallelisierbarkeit, wodurch es besonders gut geeignet ist, neuronale Netzwerke ohne zusätzliche Bibliotheken oder komplexe Frameworks zu implementieren. Durch rein in Go geschriebenen Code ermöglicht "gpt-go" eine klare Nachverfolgbarkeit aller Algorithmen, was besonders für Lernzwecke ideal ist. Ein zentraler Aspekt dieses Projekts ist der Trainingsdatensatz, der ausschließlich aus den Werken von Jules Verne besteht, einem der berühmtesten Abenteuerschriftsteller des 19. Jahrhunderts.

Diese literarische Quelle verleiht dem Modell eine besondere stilistische Handschrift und macht die erzeugten Texte sowohl faszinierend als auch inhaltlich kohärent. Die Besonderheit liegt darin, dass das Modell, obwohl es einfach strukturiert ist und keine riesigen Datenmengen verarbeitet hat, dennoch in der Lage ist, ansprechende und in sich stimmige Textpassagen zu generieren, die an die erzählerische Welt von Jules Verne erinnern. Der Trainingsprozess ist dabei bemerkenswert effizient: Auf einem modernen Laptop, wie dem MacBook Air M3, benötigt das Training etwa 40 Minuten. Dies bedeutet, dass auch Hobby-Programmierer und KI-Enthusiasten ohne teure Hardware experimentieren und eigene Modelle entwickeln können. Das Projekt verzichtet bewusst auf komplizierte Elemente, die in professionellen KI-Modellen häufig eingesetzt werden.

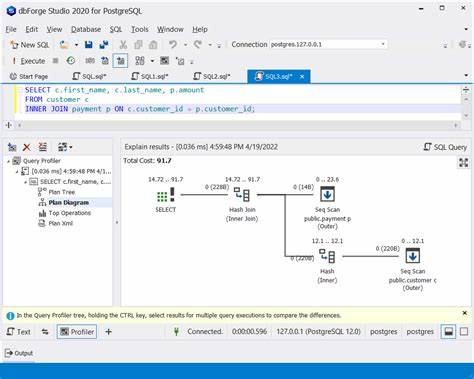

Beispielsweise wird auf die Verarbeitung von Batch-Daten verzichtet, um die Komplexität gering zu halten. Stattdessen wird das Modell mit 2D-Matrizen gearbeitet, was eine leichtere Verständlichkeit der zugrundeliegenden mathematischen Operationen ermöglicht. Ebenso wurde die Abhängigkeit von externen Bibliotheken wie gonum vermieden, obwohl diese eine bessere Performance bieten könnten. Das primäre Ziel ist es, die Konzepte klar und ohne unnötigen Ballast zu vermitteln. Die Architektur des Modells ist inzwischen über mehrere Entwicklungsstufen gewachsen, von einem einfachen Bigram-Modell über Multihead-Attention und Residual-Blocks bis hin zu einem vollwertigen kleinen Transformer.

Dies ermöglicht Einblicke in die Funktionsweise moderner NLP-Modelle Schritt für Schritt. Im Quellcode finden sich außerdem kommentierte Beispiele, die vom Aufbau einfacher Neuronen über die Bedeutung von Gewichtsmatrizen bis hin zur Implementierung eines Selbstaufmerksamkeitsmechanismus reichen. Zum Beispiel illustriert eine spezielle Dreiecksmatrix, wie bei der Selbstaufmerksamkeit so gesteuert wird, dass jedes Token nur vorherige Tokens beachten kann, um zukünftige Informationen zu vermeiden – ein Prinzip, das für das Textverständnis elementar ist. Durch das genaue Studieren des Projektes kann man nicht nur theoretisch, sondern auch praktisch verstehen, wie Transformer funktionieren, ohne in den undurchsichtigen Tiefen großer Frameworks zu versinken. Dieser praktische Zugang bietet mehrere Vorteile: Das Verständnis der Funktionsweise von GPT wird erleichtert und es wird deutlich, warum bestimmte Architekturelemente eingesetzt werden.

Entwickler können leicht experimentieren sowie Änderungen vornehmen und deren Auswirkungen direkt nachvollziehen. Der kreative Einsatz eines literarischen Korpus als Trainingsdatensatz ist ebenfalls ein interessantes Merkmal. Die Werke von Jules Verne bringen nicht nur eine gewisse poetische Eleganz in die generierten Texte, sondern zeigen auch, wie KI in die Welt der Kultur und Literatur integriert werden kann. Dies eröffnet Perspektiven für personalisierte Literaturgeneratoren oder interaktive Medien, die auf spezifischen sprachlichen Stilen basieren. Zusammenfassend steht "gpt-go" für eine neue Generation von KI-Experimenten, die auf Einfachheit, Transparenz und Bildung setzen.

Es beweist, dass auch ohne institutionelle Ressourcen und ohne hochkomplexe Infrastruktur sinnvolle und nützliche KI-Anwendungen realisiert werden können. Außerdem fördert es die Demokratisierung des Zugangs zu KI-Technologien, indem es sowohl Anfängern als auch Fortgeschrittenen ermöglicht, das Innenleben von GPT-Modellen zu erforschen und eigene Anwendungen zu entwickeln. Für Entwickler, Lehrende und Neugierige, die sich mit dem Thema künstliche Intelligenz und Natural Language Processing beschäftigen möchten, ist "gpt-go" eine unverzichtbare Ressource. Die Kombination aus minimalistischem Design, einem faszinierenden Trainingstext und der Authentizität des puren Go-Codes macht dieses Projekt einzigartig. Es liefert nicht nur technisches Wissen, sondern auch Inspiration, wie moderne KI verständlich und greifbar gemacht werden kann.

Wer daran interessiert ist, sich selbst Zugang zur Welt der Textgenerierung zu verschaffen, findet mit "gpt-go" eine ideale Plattform. Die Möglichkeit, das Modell einfach zu starten und selbst ein eigenes Trainingskorpus zu verwenden, bietet einen praktischen Einstieg in komplexe KI-Themen ohne langwierige Hürden. So verschmilzt hier die Vergangenheit literarischer Meisterwerke mit der Zukunft der Technologie – und zwar auf eine Art, die jeder nachvollziehen und mitgestalten kann. Damit eröffnet das "gpt-go"-Projekt spannende Perspektiven für die tägliche Arbeit von Entwicklern sowie für die Aus- und Weiterbildung im Bereich der künstlichen Intelligenz.

![Smart tunnel boring machine in China redefines underground construction [video]](/images/EE71234A-8D0A-469D-A3C2-92DEAC9C53BE)