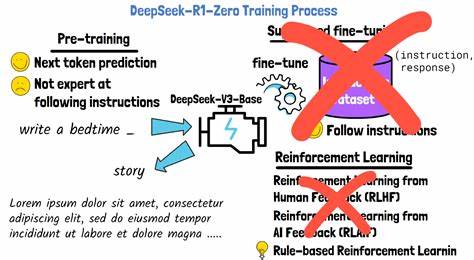

In den letzten Jahren hat der Einsatz von Reinforcement Learning (RL) in der Nachtrainierung großer Sprachmodelle (LLMs) zunehmend an Bedeutung gewonnen. Nach der Veröffentlichung von DeepSeek R1, das GRPO (Generative Reinforcement Policy Optimization) zur Feinabstimmung von LLMs einsetzte, wurde eine neue Welle der Begeisterung ausgelöst, die vor allem verbesserte Fähigkeiten im Bereich des logischen und mehrschrittigen Denkens hervorhob. Doch eine genauere Analyse zeigt, dass der Hype um RL in diesem Kontext nicht selten auf vereinfachenden strukturellen Annahmen beruht, die den Einsatz von RL-Methoden kritisch hinterfragen lassen. Die entscheidenden Fragen lauten: Sind diese Modelle tatsächlich ein Paradebeispiel für die Vorteile von RL oder handelt es sich hier um eine Art „RL in Namen nur“? Dieser Beitrag widmet sich dieser Thematik und beleuchtet die strukturellen Voraussetzungen, die den vermeintlichen Erfolg dieser Ansätze untermauern. Die erste fundamentale Annahme betrifft die Art und Weise, wie der Trainingsprozess des LLMs als Markov Decision Process (MDP) modelliert wird.

Hierbei werden die Zustände des MDPs schlichtweg als Konkatenation der Aktionen definiert. Konkret heißt das, dass der Kontext des Modells – also der von ihm bearbeitete Textabschnitt – als Zustand verstanden wird, während die Aktionen mit den Token identischgesetzt werden, die das Modell generiert. Diese Vereinfachung führt zu einem MDP, das in seiner Struktur stark degeneriert ist, da die Übergänge deterministisch aus den vergangenen Aktionen folgen und somit keine echte stochastische Dynamik enthalten. Dadurch reduziert sich die eigentliche Problemstellung auf eine Übertragung von Folge von Token, was einer klassischen sequentiellen Informationsverarbeitung ähnelt. Die zweite wichtige Annahme betrifft die Vergabe der Belohnung (Reward) entlang der Trajektorie von Zuständen und Aktionen.

Statt einer differenzierten oder zustandsbezogenen Belohnungsvergabe wird der Reward gleichmäßig über alle Zeitpunkte einer Sequenz verteilt. Das bedeutet, dass der gesamte Erfolg oder Misserfolg eines generierten Textabschnitts als eine statische Größe betrachtet wird, die auf jedes einzelne Token verteilt wird. Diese naive Belohnungsaufteilung wirkt sich stark auf die Lernmechanismen aus und verstärkt den Effekt, dass RL in diesem Kontext eher einem outcome-gesteuerten, überwachten Lernprozess entspricht. Zusammengefasst führen diese beiden strukturellen Annahmen dazu, dass der Einsatz von RL in der Feinabstimmung von LLMs oft nicht die Vorteile echter RL-Methoden ausspielt. Vielmehr gleicht der Prozess eher einer wiederholten, überwachten Feinjustierung, bei der positive und negative Beispiele den Lernprozess steuern.

Dies untermauern auch empirische Ergebnisse, die das Training von Modellen wie Qwen-2.5 auf Benchmarks wie GSM8K und Countdown betrachten. Hier zeigte sich, dass iterative überwachte Feinjustierung mit einer Mischung aus positiven und negativen Trainingsbeispielen vergleichbare Leistungen erzielt wie GRPO-basierte RL-Methoden. Ein weiterer interessanter Effekt der genannten strukturellen Annahmen ist die indirekte Förderung längerer Sequenzen von „intermediären Tokens“. Dies wird oft als Nutzen von RL für eine verbesserte Fähigkeit zur Erstellung längerer Denkketten interpretiert und medial als Fortschritt im Bereich des mehrstufigen logischen Denkens verkauft.

Die Analyse legt jedoch nahe, dass diese längeren Sequenzen weniger ein Ergebnis eines komplexen RL-Mechanismus sind als vielmehr ein direktes Produkt der zugrundeliegenden Modellierung und Belohnungsverteilung. Die Implikationen dieser Erkenntnisse sind weitreichend für die zukünftige Ausgestaltung von Trainingsmethoden und die Interpretation erzielter Verbesserungen bei LLMs. Während Reinforcement Learning zweifellos ein mächtiges Werkzeug sein kann, um KI-Systeme zu optimieren und deren Fähigkeit zu verbessern, komplexe Entscheidungsprobleme zu lösen, ist ein kritischer Blick auf die strukturellen Annahmen und deren Auswirkungen unerlässlich, um Überinterpretationen und Fehlschlüsse zu vermeiden. Außerdem wird deutlich, dass es wichtig ist, alternative Trainingsstrategien mit kontrollierten experimentellen Setting zu testen, die die Reinforcement Learning Paradigmen tatsächlich umfänglich ausnutzen und nicht nur als verkleidete Form des überwachten Lernens fungieren. Die methodische Herangehensweise in der Untersuchung zeigt damit auch einen allgemeinen Weg auf, wie die Community neu entstehende Modelle und Trainingsverfahren wissenschaftlich sauber validieren sollte.

In Zukunft könnten Konzepte wie differenziertere Zustands- und Aktionsdefinitionen, realistischere und dynamischere Belohnungsstrukturen oder erweiterte RL-Algorithmen besser zur Entfaltung der tatsächlichen Potenziale von RL in LLM-Trainingsumgebungen beitragen. Ein bloßer Transfer konventioneller MDP-Konzeptionen auf den Kontext von Sprachmodellen reicht hierfür nicht aus. Abschließend lässt sich festhalten, dass die Nutzung von Reinforcement Learning in der Nachtrainierung großer Sprachmodelle zwar großes Innovationspotenzial besitzt, die derzeitigen Ansätze aber häufig von zu stark vereinfachten strukturellen Annahmen geprägt sind. Diese führen dazu, dass der Prozess unter vielen Gesichtspunkten eher einem überwachten Lernen ähnelt und der Begriff „Reinforcement Learning“ in diesen Fällen eher nominal verwendet wird. Für eine nachhaltige Verbesserung der Trainingsmethoden ist eine fundierte Auseinandersetzung mit und Überprüfung dieser Annahmen sowie eine Weiterentwicklung der Modellierung notwendig.

Nur so kann das volle Potenzial von Reinforcement Learning für die Zukunft der künstlichen Intelligenz endlich entfaltet werden.