Die Integration von KI-Agenten in Echtwelt-Anwendungen stellt Entwickler vor immense Herausforderungen. Insbesondere dann, wenn die Systeme, mit denen diese Agenten interagieren, hochgradig anpassbar und individuell gestaltet sind. Nutzer definieren eigene Felder, unterschiedliche Datenformate und spezifische Validierungsregeln, was die zuverlässige Nutzung dieser Werkzeuge durch KI-Systeme erschwert. Ein typisches Beispiel ist der Unterschied zwischen Anwendungen wie Twitter, die standardisierte und feste Felder haben, und Plattformen wie Airtable oder HubSpot, bei denen jeder einzelne Nutzer seine eigenen Tabellen, Datensätze und Feldbezeichnungen definiert. Diese Vielfältigkeit ist sowohl eine Stärke als auch eine große Hürde für die Entwicklung robuster und verlässlicher KI-Agenten, die mit diesen Plattformen interagieren.

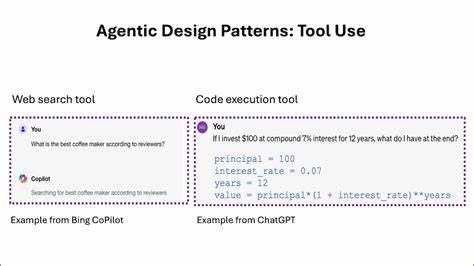

Der Umgang mit solchen stark benutzerdefinierten Tools macht deutlich, dass herkömmliche Entwicklungsansätze für APIs nicht mehr ausreichen. APIs sind klassischerweise für Entwickler gemacht, die Dokumentationen studieren, den Kontext verstehen und Fehler manuell beheben können. Für KI-Systeme jedoch, wie etwa große Sprachmodelle, die oft ohne umfassendes Vorwissen operieren und häufig Fehler machen, reichen diese traditionellen Muster nicht aus. Deshalb bedarf es einer völlig neuen Herangehensweise an das Design von Schnittstellen und deren Fehlerbehandlung. Die erste wesentliche Erkenntnis in der Entwicklung robuster agentischer Toolaufrufe ist, dass Fehlermeldungen für Menschen oft wenig hilfreich für KI-Systeme sind.

Klassische Fehlertexte wie „422 Unprocessable Entity: UNKNOWN_FIELD_NAME“ sind für Menschen mit Entwicklungs-Erfahrung verständlich, erfordern jedoch das Nachschlagen von Dokumentationen und manuelles Eingreifen. Für einen KI-Agenten hingegen sind sie uneindeutig und führen zu endlosen Fehlversuchen ohne gezielte Korrektur. Um dieses Problem zu lösen, wurden Fehler zurückgegeben, die nicht nur den Fehler benennen, sondern auch pädagogisch wirken: Sie wurden angereichert mit Hinweisen, alternativen Informationen und Beispieldaten. Im Fall eines unbekannten Feldnamens wird etwa die tatsächlich verfügbare Schemaübersicht der Datenbank nachgeladen und zusammen mit einem klaren Hinweis an den KI-Agenten zurückgegeben, sodass dieser erkennen kann, welche Feldnamen tatsächlich existieren und wie diese zu verwenden sind. Diese Art von „lernenden“ Fehlermeldungen ermöglicht es Laufzeitagenten, Fehler aktiv zu korrigieren und sich automatisch anzupassen.

Darüber hinaus wurde erkannt, dass proaktives Beobachten der Struktur eines Datensystems ein fundamentaler Schritt ist, bevor Änderungen vorgenommen werden. Anstatt blind zu versuchen, Daten zu aktualisieren oder anzulegen, können KI-Agenten zunächst eine Schemaabfrage durchführen, um sich einen vollständigen Überblick über Feldnamen, Datentypen, Auswahloptionen und Validierungsregeln zu verschaffen. Diese Vorab-Inspection entspricht dem OODA-Prinzip – beobachten, orientieren, entscheiden, handeln – aus der Luftfahrt und militärischen Führung und sorgt dafür, dass die KI-Agenten fundierte, kontextbewusste Entscheidungen treffen. Diese Praxis reduziert Fehler signifikant, erhöht die Zuverlässigkeit und lässt den gesamten Interaktionsprozess mit den Zielsystemen vorhersehbarer und effizienter verlaufen. Wichtig dabei ist, diese Beobachtung nicht als optional zu betrachten, sondern sie durch entsprechende Designmaßnahmen so zu verankern, dass das Modell sie auch konsequent nutzt.

Ein weiteres, zentrales Problem in der Arbeit mit KI-Agenten ist das sogenannte Halluzinieren: Die KI erfindet plausible aber fiktive Werte, etwa Datensatz-IDs oder Enum-Werte, die zwar syntaktisch korrekt erscheinen, aber in der Zielumgebung gar nicht existieren. Wenn solche halluzinierten Werte zur Aktualisierung oder Löschung von Datensätzen verwendet werden, führen sie zu Fehlern und enttäuschen Anwender. Eine innovative Lösung besteht darin, eine streng typisierte Ausführungsumgebung zu bauen, die die Erzeugung solcher Werte einschränkt. Dabei werden wichtige Werte wie Datensatz-IDs nicht als einfache Zeichenketten übergeben, sondern in speziell typisierten Objekten gekapselt, die nur durch konkrete API-Rückgaben erzeugt werden können. Der KI-Agent kann diese Objekte dann nicht willkürlich konstruieren, sondern nur aus validen, authentifizierten Quellen beziehen.

Dies ist gleichbedeutend mit der Einführung eines Typsystems für die Datenherkunft, das auch die Korrektheit und Integrität der Datenobjekte garantiert. Das Resultat ist eine erhebliche Reduktion von Fehlern durch halluzinierte Daten und eine deutlich verbesserte Robustheit in der agilen Interaktion von KI-Agenten mit komplexen, dynamischen Systemen. Diese drei Patterns – lernförderliche Fehlermeldungen, verbindliche Schema-Observation und typisierte Ausführungsumgebungen – markieren eine neue Designphilosophie für KI-unterstützte Werkzeuge. Sie sind grundlegend verschieden von traditionellen API-Designs, weil sie davon ausgehen, dass die Nutzer der Schnittstellen keine Experten sind, sondern fallible Agenten, die im Laufe der Interaktion lernen und sich anpassen müssen. Indem Fehler nicht nur gemeldet, sondern aktiv genutzt werden, um die KI zu einer besseren Handlung zu befähigen, schaffen Entwickler ein Ökosystem, in dem Agenten selbstständig robust agieren und sich verbessern können.

Diese Designansätze zeigen in der Praxis enorme Wirkung. In realen Einsatzszenarien gelingt es so, sehr komplexe Plattformen wie Airtable, HubSpot oder Notion mit ihren unzähligen, individuellen Nutzeranpassungen zuverlässig zu bedienen. KI-Agenten können eigenständig Datensätze durchsuchen, validieren und aktualisieren – und das über mehrere Schritte und verschiedene Systeme hinweg. Damit rückt eine Zukunft näher, in der KI-Agenten nicht mehr nur vereinzelte Routineaufgaben erledigen, sondern komplexe, benutzerindividuelle Workflows zuverlässig automatisieren können. Für Entwickler und Unternehmen, die KI-Agenten für komplexe Integrationen bauen möchten, sind diese Erkenntnisse von unschätzbarem Wert.

Sie bieten klare Handlungsempfehlungen für die Gestaltung von Schnittstellen und Prozessen. Zentral ist dabei der Gedanke, Werkzeuge nicht für erfahrene Entwickler, sondern für algorithmisch lernende, oft fehleranfällige Systemnutzer zu bauen. Dies bedeutet, Schnittstellen mit offenen, informativen Fehlern, aktiver Beobachtung und einem erweiterten Typensystem zu entwerfen. So werden KI-Agenten nicht durch einfache Hindernisse ausgebremst, sondern gezielt befähigt, sich verlässlich durch unübersichtliche Umgebungen zu navigieren. Die Methoden sind noch am Anfang ihrer Evolution, doch die Erfolge sprechen für sich.

Die kommenden Jahre werden zeigen, wie diese Prinzipien weiter verfeinert und ausgeweitet werden, um die Interaktion zwischen KI und der realen Welt immer nahtloser und effizienter zu gestalten. Die Zukunft gehört agentischen Tools, die nicht nur reagieren, sondern verstehen und intelligent handeln. Wer heute diese Patterns implementiert, legt den Grundstein für leistungsfähige, zuverlässige und autonom agierende KI-Anwendungen von morgen.