Die Entscheidung, eine Datenbanktechnologie im laufenden Betrieb zu wechseln, stellt für viele Unternehmen eine große Herausforderung dar. Insbesondere die Migration von CockroachDB zu Postgres gewinnt zunehmend an Bedeutung, da sich viele Firmen mit steigenden Kosten, Performance-Problemen und speziellen Anforderungen an Skalierbarkeit und Verfügbarkeit auseinandersetzen müssen. Die folgende Abhandlung beleuchtet die wesentlichen Beweggründe, Hindernisse und Erfolge bei einem solchen Wechsel und gibt praxisnahe Empfehlungen für eine erfolgreiche Umsetzung. CockroachDB wurde ursprünglich als verteilter SQL-Database-Cluster mit nahtloser horizontaler Skalierung entwickelt. Seine Stärken liegen in hoher Verfügbarkeit, automatischer Replikation über mehrere Regionen hinweg sowie einem SQL-kompatiblen Interface.

Besonders bei komplexen Multi-Region-Setups, die beispielsweise durch Datenschutzbestimmungen wie die DSGVO gefordert werden, ermöglicht CockroachDB eine verteilte Datenhaltung ohne großen administrativen Aufwand. Diese technischen Vorzüge waren für viele Unternehmen zu Beginn überzeugend genug, um CockroachDB als primäre Datenbank einzusetzen. Allerdings bringt die Nutzung einer verteilten Architektur auch deutliche Kostenimplikationen mit sich. Im Verlauf der Zeit stiegen bei einem Unternehmen wie Motion die Gebühren für CockroachDB auf das Fünffache, was in mittleren sechsstelligen Beträgen mündete. Das allein hat angesichts ausgebliebener Anforderungen an Datenlokalisierung und eines relativ einfachen Transaktionsmodells in einer einzelnen Region Zweifel an der Effizienz dieses Systems aufkommen lassen.

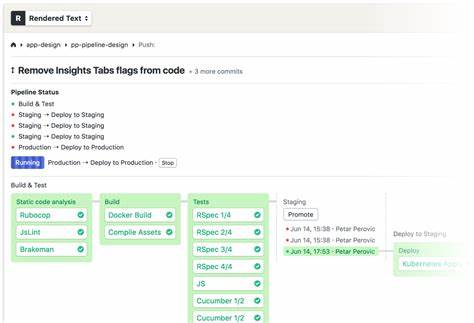

Die Frage, ob die uneingeschränkte Verteilbarkeit wirklich notwendig ist, rückte zunehmend in den Vordergrund. Neben den finanziellen Aspekten wurden technische Herausforderungen zur Belastungsprobe. Migrationen, die mit Tools wie Prisma ausgeführt wurden, führten zunehmend zu Zeitüberschreitungen. Die automatische Anwendung von Schemaänderungen wurde so zu einem operativen Engpass, der echten Stillstand verursachte. Entwickler sahen sich gezwungen, Datenbankänderungen manuell und sequentiell vorzunehmen, was den Deployment-Zyklus um Stunden verlängerte und das Risiko von Fehlern und Dateninkonsistenzen erhöhte.

Im Vergleich zeigte Postgres bei identischen Tests signifikante Vorteile. Schemaänderungen, die auf einer Datenbank mit identischer Datenmenge geprüft wurden, konnten dort oft in wenigen Sekunden erfolgreich durchgeführt werden. Diese Effizienz führte nicht nur zu einer operativen Entlastung, sondern stimulierte auch wieder einen gesunden Upgrade-Prozess der Datenbanksoftware, der zuvor durch die limitierende Performance beim CockroachDB-Einsatz ins Stocken geraten war. Die Auswirkungen der CockroachDB-Einschränkungen gingen über das reine Migrationsproblem hinaus. Auch ETL-Prozesse (Extract, Transform, Load) waren betroffen.

ETL-Schnittstellen, wie beispielsweise der Airbyte-Connector, befanden sich zum Teil noch in Alphastadien und waren mit Speicherlecks belastet. Dies führte zu häufigen Ausfällen und Performanceeinbußen in Datenintegrations-Workflows, die für Reporting, Analytics und weitere Verarbeitung unerlässlich sind. Die Frage der Abfrageperformance stellte sich differenziert dar. Einige spezielle Abfragen konnten dank des CockroachDB-Optimierers schneller als auf Postgres ausgeführt werden. Das lag daran, dass CockroachDB teilweise intelligenter Aggregationen und Scan-Operationen optimierte.

Doch dieses Optimierungsversprechen hielt nicht durchgängig. Gerade bei komplexeren, von ORM-Tools wie Prisma generierten SQL-Statements führte die Komplexität der Abfragen zu wesentlich schlechteren Ergebnissen auf CockroachDB. Das SQL konnte extrem kompliziert werden, mit vielen Joins und Unterabfragen, die bei CockroachDB häufig in Full Table Scans mündeten. In solchen Fällen übertraf Postgres die Performance um ein Vielfaches, zum Teil bis zum Zwanzigfachen. Auch aus UX-Sicht zeigten sich bei der Nutzung von CockroachDB einige unangenehme Aspekte.

Beispielsweise erschwerten falsche oder irreführende Empfehlungen zu Indizes das Monitoring und die Optimierung der DB. Probleme beim Abbrechen laufender, ressourcenintensiver Queries erschwerten den Alltag der Entwickler erheblich: Während sich Abfragen bei Postgres problemlos über SQL-Clients abbrechen ließen, erforderte das CockroachDB-Cluster aufwändige Eingriffe über die Konsole, deren Erfolg nicht garantiert war. Supportanfragen waren ebenfalls zeitraubend, was bei Problemen mit großer Wirkung besonders kritisch war. Zusätzlich traten technische Instabilitäten in der Netzwerkkommunikation auf, die sich auf alle Betriebsumgebungen auswirkten. Trotz regelmäßiger Bemühungen konnten Probleme wie DNS-Auflösungsfehler und unerklärliche Verbindungsabbrüche via Tailscale nicht vollständig eliminiert werden, was die Zuverlässigkeit des Systems in Frage stellte.

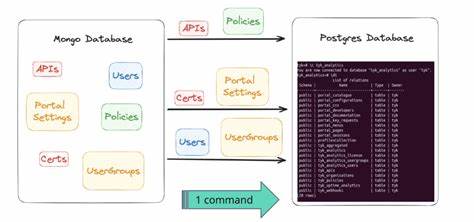

Die Migration selbst stellte eine komplexe Herausforderung dar. Bei Datenmengen im hohen zweistelligen Millionenbereich konnte keine praxistaugliche, stabile ETL-Lösung für CockroachDB genutzt werden. Deshalb wurde eine maßgeschneiderte ETL-Strategie entwickelt, bei der die komplette Datenbasis zunächst per Script ausgelesen und in CSV-Dateien zwischengespeichert wurde. Anschließend erfolgte jeweils eine parallele, gestreamte Übertragung der Daten in eine auf Postgres abgestimmte Umgebung. Dabei waren Kompatibilitätsunterschiede insbesondere in der Kodierung von JSON- und Array-Datenstrukturen zwischen CockroachDB und Postgres zu beachten und zu bereinigen.

Der finale Cutover wurde mit einem groß dimensionierten virtuellen Server durchgeführt, der den Datenbanktransfer in etwa 15 Minuten abschloss. Um potenzielle Fehlerquellen während der Umstellung zu minimieren, wurde ein geplanter Wartungsmodus aktiviert und der Traffic nach und nach wieder freigegeben. Die Dauer der Downtime war somit auf unter einer Stunde begrenzt – bei vollständiger Datenintegrität und Verfügbarkeit nach dem Umstieg. Die unmittelbaren Vorteile der Migration traten schnell zutage. Die aggregierten Antwortzeiten von Datenbankabfragen sanken um rund ein Drittel, was die Performance der gesamten Applikation maßgeblich verbesserte.

Die reichhaltige Toollandschaft der Postgres-Welt ermöglichte eine schnelle Identifikation weiterer Optimierungspotenziale, die wiederum in kurzer Zeit umgesetzt werden konnten. Gleichzeitig führte die Kostensituation zu nachhaltigen Einsparungen von über 100.000 US-Dollar jährlich, die sich mit weiter wachsendem Benutzeraufkommen und Datenvolumen noch deutlich verstärken dürften. Insgesamt zeigt die Erfahrung, dass die Wahl der richtigen Datenbanktechnologie nicht nur technische Faktoren berücksichtigen muss, sondern auch wirtschaftliche und operationelle Aspekte. Ein verteiltes System wie CockroachDB bietet viele Vorteile in spezifischen Szenarien, doch wenn diese Voraussetzungen nicht vorliegen, kann eine monolithische Lösung wie Postgres kosteneffizienter, performanter und wartungsfreundlicher sein.

Die Migration sollte dabei wohlüberlegt geplant und umgesetzt werden. Automatisierte Werkzeuge zur Migrationssteuerung, sorgfältige Tests auf realen Datenbeständen und eine schrittweise Einführung sorgen für hohe Ausfallsicherheit. Entwicklerteams sollten mit den Eigenheiten beider Systeme vertraut sein, um SQL-Statements, ORM-Generierung und Datenformate korrekt zu behandeln. Nicht zuletzt zeigt diese Fallstudie, dass es sich lohnt, pragmatisch auf Herausforderungen zu reagieren und bei steigenden Kosten und abnehmender Performance technische Alternativen offen zu evaluieren. Dank der großen und aktiven Community rund um Postgres sowie umfangreicher Analyse- und Monitoring-Tools ist der Weg frei für Unternehmen, mit Postgres als Datenbankkern effektiver und wirtschaftlicher zu arbeiten.

Wer sich für anspruchsvolle Datenbankmigrationen interessiert und gerne an der Schnittstelle von Skalierbarkeit, Performance und Kostenoptimierung arbeitet, findet in einem solchen Projekt eine spannende Herausforderung und die Chance, nachhaltigen Einfluss auf die technische Infrastruktur zu nehmen.