Mit dem fortlaufenden Aufstieg der künstlichen Intelligenz und insbesondere der großen Sprachmodelle (Large Language Models, LLMs) steigt auch der Bedarf an effizienten, skalierbaren und performanten Inferenzsystemen. Unternehmen und Forschungseinrichtungen suchen nach Lösungen, die nicht nur die enormen Rechenanforderungen moderner KI-Modelle bewältigen, sondern auch wirtschaftlich und betrieblich praktikabel sind. In diesem Kontext gewinnt ein innovativer Ansatz zunehmend an Bedeutung: das Kubernetes-native, hochleistungsfähige, verteilte LLM-Inferenz-Framework, repräsentiert durch das Projekt llm-d. Dieses Framework verspricht eine neue Ära der KI-Bereitstellung, die optimal auf die Herausforderungen großer Modelle zugeschnitten ist und dabei die Vorteile moderner Cloud- und Containertechnologien nutzt.Kubernetes ist als orchestrierende Plattform für Containerlösungen längst zum Standard in der Anwendungsbereitstellung avanciert.

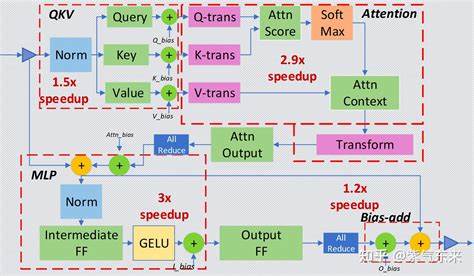

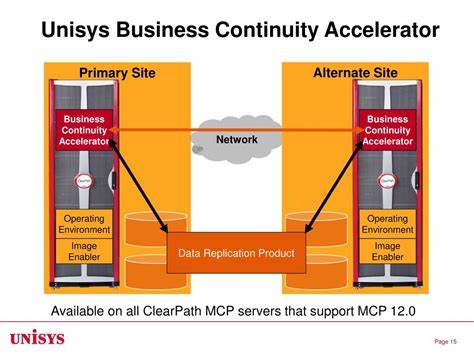

Seine Fähigkeit, Ressourcen effizient zu verwalten, Anwendungen automatisch zu skalieren und hochverfügbare Systeme zu ermöglichen, macht Kubernetes perfekt geeignet für anspruchsvolle KI-Workloads. Das llm-d Framework fügt sich hier nahtlos ein und schafft eine enge Verzahnung zwischen Kubernetes-native Betriebsmechanismen und den besonderen Anforderungen verteilter LLM-Inferenz.Ein Grundpfeiler von llm-d ist die Nutzung der zugrunde liegenden Open-Source-Technologie vLLM, welche speziell für schnelle und effiziente Inferenz großer Sprachemodelle entwickelt wurde. Dabei kommen ausgeklügelte Techniken wie KV-Cache-Aware-Routing oder disaggregierte Bereitstellung zum Einsatz, wodurch das Framework Lasten intelligent verteilt, die Pipeline der Modellabfragen optimiert und Ressourcenverschwendung minimiert. Durch die Integration solcher High-Performance-Methoden kann llm-d beeindruckende Antwortzeiten und Durchsatzwerte erzielen, die für produktive KI-Anwendungen unerlässlich sind.

Besonders hervorzuheben ist der modulare Aufbau von llm-d, der Flexibilität bei der Einrichtung und Konfiguration bietet. Unternehmen können die Komponenten nach Bedarf einsetzen, entweder als Komplettlösung oder indem sie einzelne Bausteine auswählen und anpassen. Dies erleichtert die Integration in bestehende Systeme und ermöglicht eine schrittweise Einführung verteilter Inferenzmechanismen. Ein zentrales Element ist der Inference Gateway (IGW), der als intelligenter Routing-Hub fungiert, Lastverteilung vornimmt und Telemetriedaten sammelt, um dynamisch auf Veränderungen von Anfragen und Ressourcen zu reagieren. Durch die Endpoint Picker Protocol (EPP)-basierte Steuerung können Nutzer eigene Strategien zur Lastverteilung implementieren, was eine maßgeschneiderte Performance-Optimierung erlaubt.

Der Aspekt der Disaggregated Serving ist für die Leistungsfähigkeit des Frameworks von großer Bedeutung. Hierbei werden Prozesse wie Prefill und Decode auf einzelne spezialisierte Serverinstanzen getrennt. Durch Hochgeschwindigkeitsverbindungen wie RDMA oder Infiniband kann llm-d die Kommunikation zwischen diesen Komponenten mit minimaler Latenz realisieren. Diese Trennung der einzelnen Verarbeitungsstufen ermöglicht eine bessere Skalierung, indem unterschiedliche Ressourcentypen gezielt eingesetzt werden können. So lässt sich etwa der Speicherbedarf für den Vorabbefüllungsprozess (Prefill), bei dem Kontextinformationen vorbereitet werden, unabhängig von der eigentlichen Generierung unterscheiden und optimieren.

Ein weiterer technischer Fortschritt liegt in der Nutzung von KV-Caching (Key-Value-Cache), der als hierarchischer Mechanismus entwickelt wurde, um Zwischenergebnisse der Modellvorhersagen effizient zu speichern und mehrfach zu verwenden. Dies reduziert redundant ausgeführte Berechnungsschritte drastisch und steigert die Verarbeitungsgeschwindigkeit. Zwischen unterschiedlichen Ebenen des Caches, etwa lokale Arbeitsspeicherpuffer, Festplatten oder externe Speicherlösungen wie LMCache, kann llm-d dynamisch entscheiden, wo Daten am effektivsten gehalten werden. Diese Cache-Hierarchie kann sowohl unabhängig (N/S, Nord-Süd) arbeiten als auch gemeinschaftlich (E/W, Ost-West), was unterschiedliche Betriebsmodi und Performance-Tuning ermöglicht.Ein besonders innovatives Feature ist das geplante Variant Autoscaling, das auf der Grundlage von Echtzeit-Telemetriedaten und Verkehrsanalysen die optimale Anzahl und Zusammenstellung von Modell-Instanzen berechnet.

Unterschiedliche Workload-Arten, Prioritäten bei der Anfragebehandlung und QoS-Anforderungen fließen in die Skalierungsentscheidung ein, um ressourcenschonend und effizient den Betrieb aufrechtzuerhalten. So kann das System automatisch auf wechselnden Bedarf reagieren, ohne dass manuelle Eingriffe oder Overprovisionierung notwendig sind. Das entspricht einer intelligenten Kosten-Nutzen-Optimierung, die sowohl Nutzerzufriedenheit als auch Wirtschaftlichkeit steigert.Die Offenheit und der Community-Charakter des llm-d Projekts spielen ebenfalls eine wichtige Rolle. Das unter Apache 2.

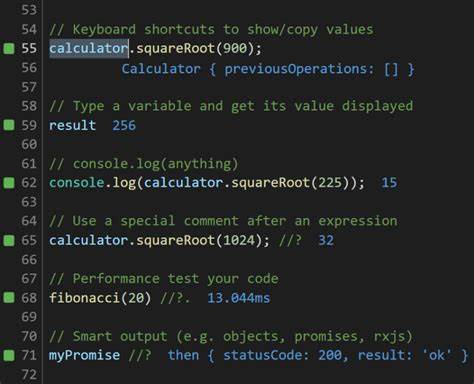

0 Lizenz verfügbare Framework wird von führenden Technikunternehmen wie CoreWeave, Google, IBM Research, NVIDIA und Red Hat unterstützt und entwickelt. Die Zusammenarbeit sorgt für eine schnelle Integration neuester Forschungsergebnisse und Technologien sowie für eine robuste Qualitätssicherung. Zudem bietet die aktive Community hilfreiche Ressourcen, regelmäßige Updates und direkte Support-Kanäle, was den Einstieg und die Weiterentwicklung erleichtert.Für Entwickler und Unternehmen, die erste Erfahrungen mit llm-d sammeln oder eigene Anpassungen vornehmen möchten, existieren umfangreiche Möglichkeiten. Das Projekt stellt diverse Komponenten bereit, die unabhängig voneinander entwickelt und genutzt werden können.

Über Helm Charts wird die Deployment-Komplexität minimiert, wodurch sich das LLM-Inferenzsystem schnell in Kubernetes-Umgebungen integrieren lässt. Die klare Trennung der Funktionen zwischen Scheduler, Cache Manager, Routing Sidecar und Modellservice erlaubt zudem eine präzise Konfiguration und Anpassung an individuelle Anforderungen.In Zeiten, in denen Generative KI-Lösungen rasant an Bedeutung gewinnen, sind schnelle und skalierbare Inferenzplattformen essenziell. llm-d präsentiert sich als zukunftsfähige Antwort auf diese Herausforderung, indem es den Brückenschlag zwischen modernster KI-Forschung und praxisnahen Betriebsumgebungen meistert. Die Kubernetes-native Architektur, gekoppelt mit hochspezialisierten Optimierungen, schafft eine Infrastruktur, die sich flexibel an verschiedenste Modelle, Hardware und Anwendungsfälle anpasst und so im professionellen Kontext höchsten Ansprüchen gerecht wird.

Zusammenfassend lässt sich sagen, dass das Kubernetes-native, hochperformante, verteilte LLM-Inferenzframework llm-d ein bedeutender Meilenstein im Bereich der KI-Dienstbereitstellung ist. Es verbindet fortschrittliche Technologien, offene Zusammenarbeit und pragmatische Nutzerorientierung zu einer ganzheitlichen Lösung. Wer nachhaltige Investitionen in KI-Infrastruktur tätigen möchte und Wert auf Effizienz, Skalierbarkeit sowie Anpassungsfähigkeit legt, findet hier eine bewährte und innovative Plattform, die ihm hilft, die Potenziale großer Sprachmodelle voll auszuschöpfen und zugleich Betriebskosten sowie Komplexität signifikant zu reduzieren.