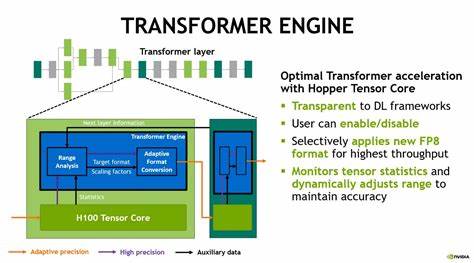

Die letzten Jahre waren geprägt von einer bemerkenswerten Revolution in der Welt der Künstlichen Intelligenz (KI). Besonders die Einführung der Transformer-Modelle mit dem berühmten Paper „Attention Is All You Need“ im Jahr 2017 hat die Entwicklung von Sprachmodellen und anderen KI-Anwendungen massiv vorangetrieben. Parallel dazu haben Grafikkarten, insbesondere GPUs von Herstellern wie NVIDIA, als Rechenplattformen für das Training und die Ausführung dieser Modelle eine zentrale Rolle eingenommen. Doch mit den sich wandelnden Anforderungen, den enormen Kosten für Rechenleistung und den immer größer werdenden Modellen stellt sich die Frage: Werden Transformer und GPUs innerhalb der nächsten zehn Jahre von grundlegend neuen Technologien und Konzepten ersetzt? Transformer als aktuelle Basis der KI Das Transformer-Modell hat sich aufgrund seiner Fähigkeit, große Datenmengen effizient zu verarbeiten und kontextbezogene Zusammenhänge herzustellen, zum Standard in der Sprachverarbeitung, Bildverarbeitung und anderen Bereichen entwickelt. Transformer-Architekturen nutzen die “Self-Attention”, um Beziehungen innerhalb von Daten zu erkennen, was sie flexibel und skalierbar macht.

So war es möglich, Large Language Models (LLMs) wie GPT, BERT, und deren Weiterentwicklungen zu kreieren, die in zahlreichen Anwendungen wie Chatbots, Übersetzungsdiensten und automatisierten Content-Generierungen im Einsatz sind. Allerdings bringt diese Technologie auch Herausforderungen mit sich. Die Skalierung von Modellen führt zu exponentiell steigenden Rechenanforderungen. Hier spielt die GPU eine entscheidende Rolle, da sie massiv parallele Berechnungen ermöglicht und so das Training und die Inferenz großer Modelle erst praktikabel macht. GPUs sind inzwischen das Rückgrad für KI-Anwendungen, doch die Kosten für Strom, Kühlung und Hardware werden immer höher und stellen eine wirtschaftliche Belastung dar.

Technologische Begrenzungen und die Suche nach Alternativen Obwohl Transformer und GPUs derzeit dominieren, gibt es eine wachsende Diskussion innerhalb der Fachwelt und der Entwicklergemeinschaft darüber, wie nachhaltig und zukunftsfähig diese Technologiekombination ist. Einige Stimmen argumentieren, dass Transformer bald an ihre Leistungsgrenzen stoßen könnten oder zumindest in ihrer derzeitigen Form ineffizient sein werden, wenn es darum geht, noch größere Modelle oder komplexere Aufgaben zu bewältigen. Eine mögliche Entwicklung ist, dass bestehende Transformer-Architekturen optimiert oder grundlegend verändert werden. Forscher experimentieren mit sparsamen Modellen, effizienteren Trainingsverfahren und alternativen Mechanismen zur Datenverarbeitung, die weniger Ressourcen benötigen. Es ist denkbar, dass wir in naher Zukunft neue Varianten oder völlig andere Modelltypen sehen werden, die diese Technik ablösen oder ergänzen.

Auf der Hardwareseite entwickeln sich Alternativen zu GPUs. ASICs (Application Specific Integrated Circuits) und spezialisierte Chips wie TPUs von Google gewinnen an Bedeutung, da sie speziell auf KI-Berechnungen zugeschnitten sind. Diese Hardware kann effizienter und kostengünstiger als traditionelle GPUs sein, ist aber weniger flexibel. Darüber hinaus wird an der Integration von quantenbasierten Komponenten geforscht, um Rechenleistung drastisch zu erhöhen und neue Berechnungsparadigmen zu ermöglichen. Die Rolle der Quantencomputer in der Zukunft der KI Eines der faszinierendsten Forschungsgebiete im Kontext der KI-Entwicklung sind Quantencomputer.

Quantenbits (Qubits) haben die theoretische Fähigkeit, mehrere Zustände gleichzeitig zu repräsentieren, was die parallele Verarbeitung komplexer Aufgaben immens beschleunigen könnte. Einige Experten vermuten, dass – sobald Quantencomputer in größerem Maßstab und zuverlässiger verfügbar sind – der klassische Bedarf an GPUs drastisch reduziert werden könnte. Momentan befindet sich die Quantentechnologie jedoch noch in einem frühen Entwicklungsstadium. Die Herausforderungen in der Stabilität, Fehlerkorrektur und Skalierbarkeit sind noch groß. Dennoch ist es denkbar, dass in einem Jahrzehnt erste Quantum-Hybrid-Systeme entstehen, die sowohl klassische GPUs als auch Quantenkomponenten nutzen, um einen Effizienzgewinn zu erzielen.

Neuartige KI-Architekturen und Paradigmenwechsel Neben der Hardware findet auch in der algorithmischen Landschaft ein ständiger Wandel statt. Einige Forscher sehen in sogenannten neuromorphen Chips, die das menschliche Gehirn nachahmen, einen möglichen Ersatz für herkömmliche Rechenplattformen. Diese Chips könnten deutlich effizienter arbeiten, da sie parallele und asynchrone Verarbeitung nutzen, ähnlich wie biologische Neuronen. Ebenso gibt es Bestrebungen, das Lernen und Verarbeiten von Daten außerhalb der derzeit vorherrschenden Deep-Learning-Paradigmen zu gestalten. Methoden aus dem Bereich der symbolischen KI, hybride Modelle, bei denen klassische regelbasierte Systeme mit neuronalen Netzwerken kombiniert werden, oder völlig neue Ansätze wie energieeffiziente optische Computer könnten das Gesicht der KI in Zukunft verändern.

Ökonomische und ökologische Auswirkungen Die Weiterentwicklung und Skalierung von KI-Modellen bringt nicht nur technologische Herausforderungen mit sich, sondern auch wirtschaftliche und ökologische. Die riesigen Rechenzentren, die für das Training von Modellen benötigt werden, verbrauchen große Mengen an Energie, was ökologische Bedenken hervorruft. Der Druck, umweltfreundlichere und ressourcenschonendere Lösungen zu finden, ist größer denn je. Daher könnten auch Nachhaltigkeitsaspekte ein wesentlicher Treiber für den Wandel sein. Unternehmen und Forschungseinrichtungen haben ein unmittelbares Interesse daran, effizientere Modelle und Hardware zu entwickeln, welche die Kosten und den Energieverbrauch senken.

Dies kann Innovationen in neuen Architekturen, neuen Algorithmen und alternativer Hardware stark beschleunigen. Fazit und Ausblick Die nächsten zehn Jahre versprechen, eine spannende Zeit für die KI-Entwicklung zu werden. Die Transformer-Architektur und GPU-basierte Hardware haben zweifellos eine Ära eingeleitet, die durch massive Fortschritte in Sprache, Bild und weiterer KI-Anwendungen geprägt ist. Doch die natürliche Entwicklung der Technologie, gepaart mit wirtschaftlichen, ökologischen und theoretischen Herausforderungen, wird höchstwahrscheinlich dazu führen, dass entweder alternative Modelle entstehen oder die Hardwarelandschaft sich grundlegend wandelt. Ob Quantencomputer, neuromorphe Systeme, spezialisierte Chips oder völlig neue Rechenparadigmen – Innovationen sind unabdingbar, um die stetig steigenden Anforderungen effizient zu erfüllen.

Die Frage, ob und wann Transformer und GPUs vollständig ersetzt werden, ist offen. Wahrscheinlicher ist, dass es eine Phase der Koexistenz und graduellen Ablösung geben wird, die von kontinuierlichen Fortschritten und Durchbrüchen in Forschung und Entwicklung geprägt ist. Für Unternehmen, Entwickler und Forschungseinrichtungen heißt dies, wachsam zu bleiben, Trends frühzeitig zu erkennen und flexibel auf Veränderungen zu reagieren. Die Investition in die Erforschung neuer Technologien parallel zur Optimierung bestehender Verfahren ist der Schlüssel, um im dynamischen Umfeld der KI auch in Zukunft erfolgreich zu sein.