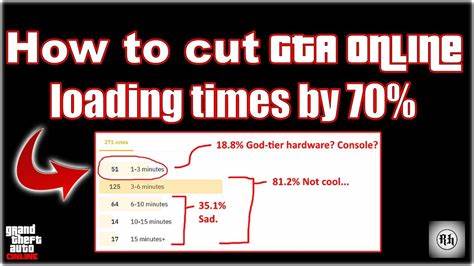

GTA Online ist bekannt für sein fesselndes Gameplay, aber ebenso berüchtigt für seine langen Ladezeiten, die Spielern seit Jahren Geduld abverlangen. Trotz zahlreicher Updates und Verbesserungen seit der Veröffentlichung vor über sieben Jahren, hat sich an der Dauer bis zum Einstieg in das Online-Erlebnis kaum etwas geändert. Die Frustration vieler Spieler ist nachvollziehbar, wenn Sie minutenlang vor einem Bildschirm verharren, während das Spiel im Hintergrund arbeitet. Doch wie kam es zu der Erkenntnis, dass fast drei Viertel dieser Ladezeit eingespart werden können? Der Weg zu einer über 70-prozentigen Verkürzung der Ladezeiten im Jahr 2021 ist eine spannende Reise durch die Tiefen der Spielmechanik und der Software-Architektur von GTA Online, die aufzeigt, wie ein scheinbar unveränderliches Problem doch lösbar ist. Die ersten Schritte begannen mit einer einfachen, aber wichtigen Nachfrage: Hat sich das Problem überhaupt verändert? War es vielleicht schon jemandem zuvor gelungen, die Ladezeiten deutlich zu verkürzen? Die Recherche förderte vor allem Anekdoten zutage, etwa die Behauptung, GTA Online sei so komplex, dass lange Ladezeiten unvermeidbar seien.

Erwähnt wurde auch die Peer-to-Peer-Netzwerkarchitektur des Spiels, die teils als ineffizient kritisiert wird. Einige Nutzer hatten kleine Tricks geteilt, um das Spiel schneller zu starten, wie das Überspringen des Rockstar-Logos, aber all diese Ansätze vermochten nur spärliche Verbesserungen von 10 bis 30 Sekunden zu erzielen, was im Gesamtbild wenig wirkte. Die Realität an einem typischen PC aus dem Jahr 2021 ließ den Autor jedoch noch erstaunter zurück. Während die Ladezeit für den Story-Modus mit rund einer Minute durchaus akzeptabel erschien, nahm das Laden von GTA Online nahezu sechs Minuten in Anspruch. Dieses massive Ungleichgewicht erweckte den Verdacht, dass hinter den Kulissen etwas fundamental schief lief – denn der Sprung vom Einzelspieler- zum Online-Modus sollte eigentlich nicht derart hohe Unterschiede verursachen.

Ein genauer Blick mit Standard-Tools wie dem Task Manager zeigte schnell, dass die CPU des Systems während der Ladephase nicht ausgelastet war wie erwartet – allerdings lief ein einzelner Prozess auf einer einzelnen CPU-Kernlast nahezu mit voller Kapazität über mehrere Minuten hinweg. Weder die Festplatte noch das Netzwerk erlebten währenddessen eine nennenswerte Auslastung, auch die GPU und der Arbeitsspeicher blieben weitestgehend unbeansprucht. Dies weckte den Verdacht, dass das Spiel an einem rechenintensiven, aber schlecht optimierten Bereich der Software festhing, vielleicht sogar an einem Fehler, der das gesamte System ausbremste. Solche Engpässe, die durch die Bindung an einen einzelnen CPU-Kern entstehen, sind in der heutigen Zeit ungewöhnlich, denn moderne Spiele nutzen in der Regel Multithreading, um die Rohleistung moderner Mehrkernprozessoren optimal zu nutzen. Eine erste Vermutung lag daher nahe: Die ältere Hardware, speziell AMD-Prozessoren mit vergleichsweise schwächerer Einzelkernperformance, könnten den Performance-Flaschenhals sein.

Doch das erklärte nur einen Teil des Problems, denn auch deutlich leistungsstärkere Systeme kämpften mit vergleichbar langen Ladezeiten. Das ließ die Vermutung aufkommen, dass das Problem tiefer in der Struktur der Software zu verorten ist. Der nächste Schritt bestand darin, eine geeignete Profiling-Methode einzusetzen, um den Flaschenhals im Software-Code zu identifizieren. Da es sich um eine geschlossene Quelle handelte und kein Zugang zum Quellcode bestand, kam eine Technik namens Stack Sampling zum Einsatz. Diese erstellt in festgelegten Intervallen Abbildungen des Programmstacks und ermöglicht auf diese Weise Rückschlüsse darüber, welche Funktionen besonders zeit- und ressourcenintensiv sind.

Obwohl die Auflösung dieses Werkzeugs bei weitem nicht microskopisch ist, reichte sie aus, um zwei Hauptproblembereiche ausfindig zu machen. Zur vertieften Analyse wurden disassemblierende Werkzeuge genutzt, um den maschinennahen Code zu untersuchen. Obwohl moderne Spiele typischerweise umfangreiche Schutzmechanismen gegen Reverse Engineering bereithalten, konnte durch gezieltes Auslesen und Dumping von Prozessen dennoch Einblick in die Abläufe gewonnen werden. Dabei zeigte sich ein überraschendes Bild: Das Spiel verbringt einen Großteil der Ladezeit mit dem Parsen einer zehn Megabyte großen JSON-Datei, die rund 63.000 Einträge aus einem sogenannten "Net Shop Catalog" enthält.

Diese Datei enthält alle möglichen Items und Upgrades, die in GTA Online erhältlich sind. Das Problem: Die Methode zur Verarbeitung dieser JSON-Datei basierte auf einer ineffizienten Kombination veralteter Funktionen wie sscanf und strlen. Konkret lag eine Ineffizienz darin, dass die strlen-Funktion mehrmals hintereinander auf große Strings angewandt wurde, was unnötigen Overhead verursachte. Der Einsatz dieser Funktionen in Kombination führte dazu, dass derselbe Speicherbereich mehrfach, aber unnötigerweise, gescannt wurde, was den Prozess stark verlangsamte. Doch nicht genug damit: Direkt im Anschluss an das Parsen führte das Spiel eine Überprüfung durch, ob jedes einzelne Element bereits in einer internen Liste vorhanden war.

Dabei wurde eine einfache, aber ineffiziente Struktur verwendet, die alle bisherigen Einträge linear durchsucht – eine Operation, deren Komplexität quadratisch mit der Anzahl der Elemente wächst. Bei 63.000 Einträgen führte dies zu fast 2 Milliarden Vergleichsoperationen, von denen die meisten überflüssig waren, da alle Einträge ohnehin eindeutig sind. Eine zeitgemäße Umsetzung mit einer echten Hashtabelle hätte diesen Vorgang erheblich beschleunigen können, auch gab es im Code sogar eine Funktion, die eine direkte Einfügung ohne Duplikatsprüfung erlaubte. Dass diese aber ignoriert wurde, ist ein klassischer Fall fehlender Optimierung.

Die Kombination aus ineffizientem JSON-Parsen und einer langsamen Duplikatsprüfung sorgte also für den größten Teil der langen Ladezeiten. Doch wie konnte man diese beiden gravierenden Fehler praktisch beheben? Eine kreative Lösung bestand darin, die strlen-Funktion zu hooken – also gezielt zu ersetzen – und dabei intelligente Zwischenspeicherungen zu nutzen. Anstelle einen großen String bei jeder Anfrage komplett neu zu vermessen, wurde der Bereich einmal gespeichert und bei weiteren gleichen oder überlappenden Abfragen direkt eine vorher berechnete Länge zurückgegeben. Diese Methode reduzierte den Aufwand massiv, ohne das Spielverhalten negativ zu beeinflussen. Die zweite Optimierung übersprang die langwierige Duplikatsprüfung vollständig und fügte die Items direkt ein, da bekannt war, dass keine doppelten Werte existieren.

Beide Maßnahmen zusammen führten zu einem beeindruckenden Rückgang der Ladezeiten von etwa sechs Minuten auf knapp unter zwei Minuten, eine Reduktion um fast 70 Prozent. Dieser Erfolg zeigte eindrucksvoll, wie selbst etablierte und komplexe Spiele durch gezielte Analyse und punktuelle Optimierungen spürbar verbessert werden können. Die zugrundeliegenden Fehler sind Beispiele für altbekannte Software-Schwachstellen, bei denen einfache Datenstrukturen und ineffizientes Parsing zu unerwarteter Langsamkeit führen können. Gerade bei Spiele-Updates, die regelmäßig Daten neu laden und verarbeiten müssen, sind solche Flaschenhälse entscheidend für die Nutzererfahrung. Interessanterweise zeigte die Reaktion des Entwicklers, Rockstar Games, nach Veröffentlichung der Analyse einen schnellen und offenen Umgang mit der Problematik.

Die vorgeschlagenen Verbesserungen wurden ernst genommen, und bereits kurze Zeit später erfolgte ein offizielles Update, das die Ladezeiten massiv verkürzte und die Spielerkundschaft entlastete. Zudem wurde der Autor der Analyse für seine Arbeit mit einer hohen Geldprämie ausgezeichnet – eine außergewöhnliche Anerkennung für eine nicht sicherheitsrelevante Entdeckung, die vor allem die Spielqualität verbesserte. Für Spieler bedeutet diese Entwicklung nicht nur kürzere Wartezeiten beim Einstieg in GTA Online, sondern auch, dass sich technische Innovation und Community-Engagement lohnen können. Für Entwickler und andere technische Interessierte liefert diese Erfolgsgeschichte wertvolle Einblicke in Optimierungsstrategien, insbesondere für Anwendungen, die mit großen Datensätzen und Ressourcenmanagement zu kämpfen haben. Zusammenfassend lässt sich sagen, dass die Ursachen für die langen Ladezeiten von GTA Online in einem altmodischen, ineffizienten Parser und einer überflüssigen, rechenintensiven Duplikatsprüfung lagen.

Durch intelligentes Hooking und das Überspringen unnötiger Operationen konnten die Ladezeiten um mehr als zwei Drittel verkürzt werden. Es zeigt sich, dass selbst komplexe, kommerzielle Spiele von klassischen Optimierungen profitieren können, wenn diese gezielt und mit dem nötigen technischem Know-how angegangen werden. Die Geschichte hat zudem eine ermutigende Botschaft: Selbst wenn eine schlechte Performance als unveränderlich gilt, sollte man nicht davor zurückschrecken, tief in die Materie einzutauchen, zu analysieren und Probleme dort anzugehen, wo sie entstehen. GTA Online ist ein Paradebeispiel dafür, dass es oft nicht die Hardware ist, die limitiert, sondern die Software selbst noch Spielraum für Verbesserungen bietet. Rockstar Games hat mit der angenommenen Herausforderung und dem schnellen Update einen wichtigen Schritt gemacht, die Spielerschaft zufriedenzustellen und die Grundlage für zukünftige Optimierungen zu legen.

Alle, die sich intensiver mit Ladezeiten, Game-Design oder Softwareoptimierung beschäftigen, können von diesem Fall lernen. Die Kombination aus profilbasiertem Debugging, disassembling, innovativem Hooking und einer fundierten Analyse führte zur Verbesserung eines langjährigen Problems. Gleichzeitig hat sich gezeigt, wie fruchtbar der Austausch zwischen Community und Entwickler sein kann – gemeinsam lässt sich viel bewegen.