Stable Diffusion hat die Landschaft der KI-gestützten Bildgenerierung nachhaltig verändert. Mit beeindruckender Genauigkeit und vielseitigen Einsatzmöglichkeiten inspiriert das Modell Künstler, Entwickler und Technologen gleichermaßen. Auf diesem innovativen Fundament aufbauend, hat ein Entwickler eine vollständige Neuimplementierung von Stable Diffusion 3.5 in purem PyTorch geschaffen. Dieses Projekt richtet sich vor allem an jene, die eine tiefgehende, strukturierte und nachvollziehbare Version des Modells suchen.

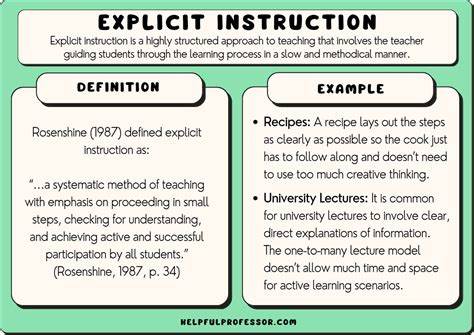

Doch was macht diese Reimplementierung so bahnbrechend und warum sollte man sich damit beschäftigen? Das Ziel des Entwicklerprojekts bestand darin, Stable Diffusion 3.5 mit möglichst wenigen Abhängigkeiten zu realisieren und dabei pure PyTorch zu verwenden. Dadurch wird der Code nicht nur portabel, sondern vor allem verständlich und flexibel für Anpassungen und Experimente. Der Fokus liegt klar auf Bildung, Forschergeist und einer praktischen Herangehensweise zur Vertiefung des Verständnisses komplexer KI-Modelle. Die Herausforderung bei der Neuimplementierung von Stable Diffusion liegt in der Komplexität des zugrundeliegenden neuronalen Netzwerks.

Stable Diffusion kombiniert Techniken wie Variational Autoencoders (VAE), Transformer-basierte Text-Encoder wie T5 und CLIP sowie innovative Diffusionsprozesse. Diese Komponenten wurden im Rahmen des Projekts in separaten Modulen implementiert. So existiert eine klare Trennung von Verantwortlichkeiten für besseres Codeverständnis und einfachere Weiterentwicklung. Das Herzstück der Neuimplementierung ist die Multi-Modal Diffusion Transformer Architektur, die für die Verbindung von Text und Bild verantwortlich ist. Hierbei kommt die innovative Joint Attention zum Einsatz, eine Weiterentwicklung der klassischen Attention-Mechanismen, die es erlaubt, Kontextinformationen beider Modalitäten effektiv miteinander zu verknüpfen.

Das Ergebnis ist eine äußerst realistische und kontextbezogene Bildsynthese, vergleichbar mit den neusten Forschungsergebnissen. Ein weiterer wichtiger Baustein ist der Flow-Matching Euler Scheduler, der die zeitgenaue Modellsteuerung während der Bildgenerierung übernimmt. Durch die präzise Lösung der Differentialgleichungen im Diffusionsprozess wird die Trainings- und Inferenzeffizienz erheblich gesteigert. Die Integration dieser Methode zeigt eine hohe Affinität zur mathematischen Modellierung und gleichzeitig zum praktischen Nutzen. Neben den Modellen wurde ebenfalls großer Wert auf die Umsetzung der Text-Encoder gelegt.

Das Projekt beinhaltet sowohl die Reimplementierung von T5 als auch von CLIP Encoder-Komponenten mit eigenen Tokenizern auf Basis von Byte-Pair-Encoding und Unigram-Algorithmen. Diese Sprachmodelle sind essentiell, um semantische Inhalte aus Eingabetexten genau zu erfassen und in den Bildgenerierungsprozess einzubeziehen. Das gesamte Repositorium zeigt sich sehr übersichtlich: Es umfasst wenige tausend Codezeilen, die vom Training bis zur Inferenz alle nötigen Schritte abbilden. Dadurch wird Stable Diffusion 3.5 von einem Blackbox-Modell zu einem offenen Lernobjekt, das sich hervorragend für Forschung und Experimentieren eignet.

Die minimalistische Herangehensweise macht das Projekt außerdem auf weniger leistungsstarken Rechnern zugänglich. Der modulare Aufbau sorgt zudem für maximale Flexibilität. So befinden sich die Bildgenerierungsmodelle, die Encoder der Textmodelle, der Scheduler sowie Hilfsfunktionen jeweils in eigenen Dateien. Diese klare Struktur erleichtert es Entwicklern, einzelne Bereiche anzupassen oder auf andere Aufgaben auszuweiten. Entwickler können etwa den Transformer durch speziellere Architekturen ersetzen oder alternative Scheduler integrieren.

Zudem werden im Projekt wichtige Metriken wie der Fréchet Inception Distance (FID) integriert. Diese Bewertungskriterien helfen dabei, die Güte der generierten Bilder objektiv zu bemessen und somit eine fundierte Vergleichsbasis zu schaffen. Das ist besonders in der Forschung wichtig, um Fortschritte nachvollziehbar zu dokumentieren und zu kommunizieren. Nicht zuletzt trägt das gesamte Projekt ein klares pädagogisches Versprechen. Es richtet sich an Forschende, Studierende und Hobbyprogrammierer, die hinter die Kulissen eines der aktuell modernsten Bildgenerierungsmodelle blicken und selbst lernen möchten, wie diese KI-Modelle funktionieren.

Alle Implementierungen sind unter einer frei zugänglichen MIT-Lizenz verfügbar und gewinnen stetig an Beliebtheit in der Open-Source-Community. Erwähnenswert ist auch die Verwendung des Euler-Schedulers. Dieser hebt sich von klassischer stochastischer Diffusion ab und repräsentiert eine effiziente Methode, um während der Bildsynthese das Rauschen schrittweise zu entfernen. Dadurch erzielt die Reimplementierung eine vergleichbare Bildqualität bei gleichzeitig reduzierten Laufzeiten. Gerade bei begrenzten Ressourcen ist das ein großer Vorteil.

Neben der technischen Tiefe überzeugt das Projekt durch seine einfache Handhabung. Interessierte Nutzer können das Repository leicht klonen, benötigte Abhängigkeiten mit wenigen Befehlen installieren und dank bereitgestellter Skripte direkt mit dem Training oder der Inferenz beginnen. Auch die Integration von Model-Checkpoints ist unkompliziert gelöst und wird über eine Authentifizierung an der Hugging Face Plattform geregelt. Die bewusste Entscheidung für die Programmiersprache Python und speziell PyTorch spiegelt die starke Community-Unterstützung und Verbreitung wider. PyTorch besticht durch eine intuitive API, dynamische Graphen und hervorragende Debugging-Möglichkeiten, was gerade bei so komplexen Modellen wie Stable Diffusion von großem Vorteil ist.

Zudem erleichtert die native CUDA-Unterstützung die Ausführung auf modernen GPUs erheblich. Insgesamt belegt diese neuartige Reimplementierung von Stable Diffusion 3.5 das Potenzial, komplexe KI-Modelle verständlich und zugänglich zu machen. Die Kombination aus minimalistisch gehaltenem Code, modularen Architekturen und modernen Diffusionsalgorithmen schafft eine einmalige Lernplattform sowie eine solide Basis für angehende Forschungsprojekte oder eigene Anwendungen. Die Zukunft der KI-gestützten Bildgenerierung ist spannend und dynamisch.