Die rasante Entwicklung der künstlichen Intelligenz hat die Nachfrage nach leistungsfähiger Rechenkapazität, insbesondere im Bereich der Grafikprozessoren (GPUs), dramatisch gesteigert. GPUs sind heute das Herzstück moderner KI-Anwendungen, da sie parallele Berechnungen effizienter durchführen können als herkömmliche CPUs. Zugleich wächst der Markt für GPU-basierte Cloud-Dienste und Inferenzplattformen rapide, da viele Unternehmen die hohen Investitions- und Betriebskosten für eigene KI-Infrastruktur vermeiden möchten. Diese Entwicklung prägt die Landschaft der GPU-Clouds maßgeblich und ermöglicht es unterschiedlichsten Nutzern, von Startups bis zu den größten Technologiekonzernen, die KI-Rechenleistung flexibel und skalierbar zu nutzen.\n\nIm Zentrum dieser Transformation stehen zwei Hauptansätze: Entweder mieten Unternehmen reine GPU-Rechenkapazität, die sie mit eigenen Modellen bespielen, oder sie greifen über ein umfassendes Dienstleistungsangebot auf vorgefertigte Inferenzplattformen zu, die das Hosting, die Verwaltung und Optimierung von Modellen übernehmen.

Beide Herangehensweisen haben eigene Vorteile und sprechen unterschiedliche Zielgruppen an. Während hyperskalierende Anbieter wie Microsoft Azure und Amazon Web Services (AWS) ein breites Spektrum an Services samt Software-Ökosystem anbieten, entstehen gleichzeitig spezialisierte GPU-Cloud-Dienstleister, die auf Kosteneffizienz, hohe GPU-Auslastung und niedrige Latenz fokussieren.\n\nDie größten Player auf dem Markt sind nach wie vor die Hyperscaler: Microsoft Azure, AWS und Google Cloud. Microsoft hat sich mit seiner frühen und umfangreichen Kollaboration mit OpenAI eine starke Position als führender AI-Compute-Provider erarbeitet. Azure bietet eine weitreichende Infrastruktur mit hunderten von Rechenzentren weltweit sowie maßgeschneiderte Hardwareoptimierungen, inklusive eigener Chipsätze und innovativer Kühlungslösungen.

Diese Vorteile kombiniert Microsoft mit einem ausgereiften Plattformangebot wie Azure ML und Azure OpenAI Services, wodurch Unternehmen ganzheitliche und sichere KI-Lösungen erhalten.\n\nAmazon verfolgt eine ähnliche Strategie, hat sich aber im Bereich KI-Infrastrukturen etwas später positioniert. AWS setzt stark auf eigene KI-Chips wie Inferentia und Trainium, die speziell für Inferenz- und Trainingsaufgaben in großen Sprachmodellen optimiert sind. Außerdem investiert Amazon intensiv in den Ausbau neuer Rechenzentren mit innovativen Energiequellen, etwa durch den Erwerb eines kernkraftbetriebenen Campus in Pennsylvania und nachhaltig betriebenen Projekten. Das Portfolio an Softwaretools mit Amazon SageMaker und AWS Bedrock rundet das Angebot für Entwickler und Unternehmen ab.

\n\nGoogle Cloud spielt ebenfalls eine wichtige Rolle, vor allem durch seine technische Expertise. Als Heimat des Transformer-Modells und Entwickler der Tensor Processing Units (TPUs) kann Google eine vertikal integrierte Lösung anbieten, die besonders bei groß angelegter Modellinferenz und Training punktet. TPUs sind in der aktuellen Version v5e und bieten im Vergleich zu herkömmlichen GPUs eindeutig Vorteile bei Energieeffizienz und Leistung. Der Marktanteil von Google Cloud wächst stetig, obwohl man im Vergleich zu den beiden Branchenführern noch etwas hinterherhinkt.\n\nNeben den großen Hyperscalern formieren sich auch spezialisierte Anbieter, sogenannte pure-play GPU Clouds, die sich auf AI-Workloads konzentrieren und mit schlankeren Architekturen und innovativen Geschäftsmodellen überzeugen.

CoreWeave ist ein leuchtendes Beispiel für einen solchen AI-Hyperscaler. Als kürzlich börsennotiertes Unternehmen mit starkem Wachstum bietet CoreWeave bare-metal GPU-Cluster, die auf minimaler Cloud-Komplexität, hoher Auslastung und erstklassiger Hardware basieren. Diese haben aufgrund der direkten Partnerbeziehung zu NVIDIA stets frühzeitigen Zugang zu neuster GPU-Hardware wie den H100- und H200-Modellen. Das erlaubt es CoreWeave, konkurrenzfähige Preise durchzusetzen und gleichzeitig hohe Margen zu sichern. Solche Unternehmen adressieren vor allem Kunden, die sehr performancekritische Anwendungen mit maximaler Effizienz realisieren wollen.

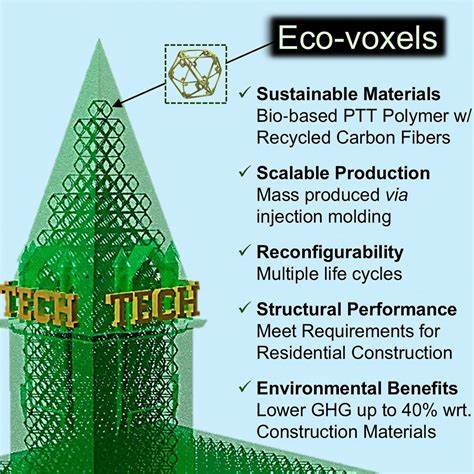

\n\nAndere Akteure wie Lambda Labs oder Crusoe Energy verfolgen abweichende Wege, spielen aber wichtige Rollen im Wettbewerb. Lambda konzentriert sich auf Entwickler und kleinere Unternehmen mit günstigen Preisen bei hochwertigen GPU-Instanzen, was den Zugang zu KI-Rechenleistung demokratisiert. Crusoe nutzt hingegen innovative Konzepte, indem es Abwärme und sonst ungenutztes Erdgas für nachhaltige Energieerzeugung verwendet, um die Betriebskosten dramatisch zu senken. Dies eröffnet vor allem bei großvolumigen Rechenanforderungen wirtschaftliche Vorteile.\n\nDarüber hinaus gibt es regionale und spezialisierte Clouds, die aus geopolitischen oder regulatorischen Gründen auf bestimmte Märkte fokussieren.

So dominiert Alibaba Cloud in China den Bereich GPU-Cloud-Dienste, dank tiefgreifender vertikaler Integration in E-Commerce, Zahlungsverkehr und Logistik, verbunden mit lokal entwickelter Hardware wie dem Hanguang 800-Chip. Auch Unternehmen wie Oracle Cloud Infrastructure positionieren sich als kosteneffiziente Alternative zu den Hyperscalern, insbesondere für Enterprise-Kunden, die günstige Bare-Metal-Cluster und großzügige Bandbreitenkonditionen suchen.\n\nNeben der Infrastruktur stellt sich zunehmend auch die Frage nach der Nutzerfreundlichkeit durch Plattformen, die AI Inferenz als Dienstleistung anbieten. Diese so genannten AI-Plattformen abstrahieren die Komplexität des Infrastrukturmanagements für Entwickler, die lediglich APIs nutzen möchten, um Modelle anzufragen. Bekannte Dienste wie Microsoft Foundry, Amazon Bedrock oder Google Vertex erlauben das einfache Hosting, Skalieren und Abrufen von Modellen, teilweise mit einem breiten Modelkatalog inklusive proprietärer und Open-Source-Modelle.

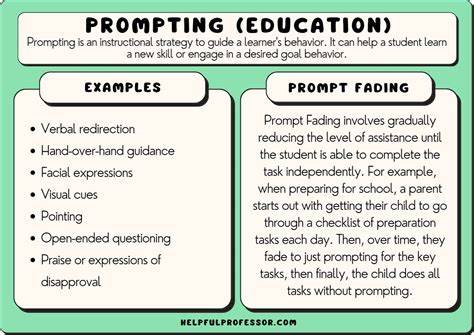

Ein großer Vorteil dieser Angebote ist die nutzungsbasierte Abrechnung, die Unternehmen davor schützt, für ungenutzte Kapazitäten zu bezahlen.\n\nEin weiteres wichtiges Unterscheidungsmerkmal ist das Angebot an Entwicklerwerkzeugen und Optimierungstechnologien. Moderne Plattformen bieten oft Funktionen wie automatische Modell-Feinabstimmung, Datensicherheit auf Enterprise-Level, Telemetrie und Monitoring, intelligente Ressourcenverwaltung und Verarbeitung großer Datenmengen. Firmen wie Together AI setzen dabei auf offene Ökosysteme, unterstützen eine Vielzahl von Open-Source-Modellen und liefern eine komplette Toolchain für Training und Produktion. Fireworks AI wiederum positioniert sich stark im Bereich Modularer KI, indem es Werkzeuge zur Orchestrierung von Modellen und Agenten bereitstellt, um komplexe Workflows effizient zu steuern.

\n\nNeben den etablierten Anbietern drängen auch innovative Chipspezialisten wie Groq und Cerebras auf den Markt. Ihre speziell entwickelten Beschleuniger versprechen extrem niedrige Latenzen und hohe Durchsätze. Allerdings konnten sie aufgrund hoher Einstiegskosten und spezifischer Anforderungen bislang nur begrenzt auf dem breiten Markt Fuß fassen. Deshalb setzen sie zunehmend auf eigenständige Cloud-Dienste oder Serverless-Inferenzlösungen, die direkt ihre Hardware optimal ausnutzen. Diese Strategie wird unterstützt durch Partnerschaften mit regionalen Industriekunden und Softwareanbietern.

\n\nNicht zuletzt sind die direkten Inferenz-APIs von KI-Labors mit eigenen großen Sprachmodellen, wie OpenAI, Anthropic oder Mistral, von großer Bedeutung. Diese Labore bieten eine einfache Anschlussschnittstelle, die schnell im Produktivbetrieb einsetzbar ist. Doch auf Dauer bevorzugen Kunden oft Plattformen mit mehr Flexibilität, um Vertragspartner zu wechseln und verschiedene Modelle parallel zu betreiben. Zudem verlangt der Unternehmenseinsatz Sicherheits-, Governance- und Compliance-Lösungen, die oft nur spezialisierte Anbieter mit breiter Infrastruktur leisten können.\n\nDie Landschaft der GPU-Clouds und AI-Inferenzplattformen zeigt somit eine bemerkenswerte Vielfalt, die vom hochintegrierten Hyperscaler über spezialisierte Pure-Play-Clouds bis hin zu Entwicklerfokussierten Plattformen und innovativen Chip-Herstellern reicht.

Diese Entwicklung ermöglicht es, die enorme Rechenintensität moderner KI-Modelle effizient zu bedienen und gleichzeitig den Zugang zu Rechenleistung breiter zu öffnen. Für Unternehmen und Entwickler ist es wichtig, die eigenen Anforderungen genau zu verstehen und die passende Infrastruktur- und Plattformstrategie zu wählen. Dabei spielen Kriterien wie Kostenstruktur, Leistungsangebot, Datensicherheit, Flexibilität und Support eine zentrale Rolle.\n\nIm konstant wachsenden Markt der KI-Rechenleistung versprechen neue Technologien wie Flüssigkühlung, nachhaltige Energieversorgung oder spezialisierte Inferenzoptimierungen erhebliche Effizienzgewinne. Gleichzeitig zeigen aufstrebende Unternehmen, dass neben den Giganten Raum für innovative Geschäftsmodelle und attraktive Nischen besteht.

Insgesamt gestaltet sich das Ökosystem rund um GPU-basierte Cloud-Dienste und Inferenzplattformen als dynamisch, wettbewerbsintensiv und technologisch tiefgründig – Merkmale, die den Fortschritt in der Künstlichen Intelligenz nachhaltig fördern und für die Zukunft neue Möglichkeiten eröffnen.