In den letzten Jahren hat sich Künstliche Intelligenz rasant weiterentwickelt und ist mittlerweile in vielen Bereichen unseres täglichen Lebens präsent. Insbesondere ChatGPT, ein auf KI basierender Chatbot von OpenAI, erfreut sich großer Beliebtheit. Während vermehrt über das Potenzial und die Nutzung solcher Tools diskutiert wird, gewinnt auch die Frage nach dem Energieverbrauch zunehmend an Bedeutung. Wie viel Strom verbraucht eigentlich eine durchschnittliche Anfrage an ChatGPT? Eine Erkenntnis, die jüngst vom OpenAI CEO Sam Altman veröffentlicht wurde, beziffert den Verbrauch auf etwa 0,34 Wattstunden pro Anfrage. Doch was bedeutet diese Zahl im größeren Kontext der Energienutzung moderner Technologien? Und wie vergleicht sich dieser Wert mit anderen digitalen Anwendungen? Um die Antwort zu finden, lohnt sich ein genauerer Blick auf die Hintergründe und Zahlen dieses Themas.

Der Energieverbrauch von KI-Systemen ist ein komplexes Thema, das lange Zeit von ungenauen Schätzungen und Spekulationen geprägt war. Verschiedene Studien hatten in der Vergangenheit teilweise stark voneinander abweichende Werte angegeben, die oftmals weit über dem tatsächlichen Verbrauch lagen. Dabei war die Herausforderung vor allem, die Vielzahl von Faktoren, die in das Energieprofil einer Anfrage einfließen, korrekt zu berücksichtigen. Der Betrieb von Rechenzentren, die physische Infrastruktur, das Training der Modelle sowie deren laufende Inferenz sind nur einige der Variablen, die bei der Kalkulation eine Rolle spielen. Wenn nun OpenAI von 0,34 Wh pro Anfrage spricht, handelt es sich dabei um eine durchschnittliche, gewichtete Zahl, die zahlreiche unterschiedliche Gewichtungen einbezieht – von einfachen Textabfragen bis hin zu komplexeren Anfragen, die mit Medieninhalten arbeiten.

Die Zahl von 0,34 Wattstunden mag zunächst abstrakt erscheinen, doch zur Veranschaulichung hilft es, diesen Energieverbrauch in relationale Größen zu überführen. Ein Watt ist die Einheit für Leistung, also Energie pro Zeiteinheit, während eine Wattstunde die Energiemenge beschreibt, die für eine Stunde bei einer Leistung von 1 Watt benötigt wird. 0,34 Wh entspricht also der Energiemenge, die eine kleine Glühbirne mit ungefähr 0,34 Watt Leistung innerhalb einer Stunde verbrauchen würde oder einem sehr kurzen Betrieb einer leistungsfähigen Lampe. Das bedeutet, dass eine einzelne ChatGPT-Anfrage vergleichsweise wenig Energie benötigt, insbesondere wenn man bedenkt, wie aufwendig die dahinterliegende Rechenleistung ist. Vergleicht man diese Werte mit einer einfachen Websuche, so spielt die Diskussion eine interessante Rolle.

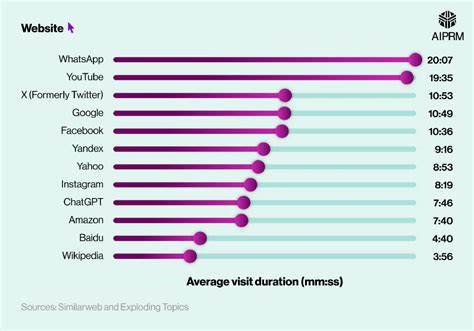

Ein Bericht von MIT und andere Untersuchungen stellen fest, dass eine Google-Suchanfrage etwa 0,0003 kWh beziehungsweise 0,3 Wh an Energie benötigen könnte. Das heißt, eine ChatGPT-Anfrage verbraucht ungefähr das Gleiche oder geringfügig mehr im Vergleich zu einer klassischen Suchanfrage – ein Wert, der in der Größenordnung vergleichbar ist. Dabei sollte man aber beachten, dass eine KI-Anfrage durch ihre komplexeren Modelle und Rechenprozesse in Echtzeit mit hohen Rechenzyklen verbunden ist. Die relativ geringe Differenz zeigt jedoch, dass die Befürchtungen über den immens hohen Energieverbrauch pro Anfrage häufig überschätzt werden. Trotz dieses vergleichsweise niedrigen Verbrauchs besteht kein Grund, die Umweltauswirkungen von KI-Systemen zu vernachlässigen.

Der wahre Energiebedarf entfaltet sich eher kolossal während der Trainingsphasen komplexer KI-Modelle. In diesen Trainingsphasen, in denen riesige Datenmengen verarbeitet und Modelle mit Millionen oder Milliarden von Parametern kalibriert werden, sind die Serverfarmen mit enormer Rechenleistung ausgelastet, was sehr hohe Anforderungen an den Stromverbrauch stellt. Dennoch sind diese Trainingsphasen keine kontinuierliche Aktivität, sondern finden in zeitlich begrenzten Intervallen statt, im Gegensatz zur anhaltenden Nutzung von Modellen in Echtzeit. Diskussionen um die Umweltverträglichkeit von KI drehen sich häufig nicht nur um den reinen Stromverbrauch, sondern auch um die Herkunft des eingesetzten Stroms. Wird der Energiebedarf durch erneuerbare Quellen gedeckt, sieht die Umweltbilanz deutlich besser aus als bei Nutzung fossiler Energieträger.

Große Technologieunternehmen, einschließlich OpenAI, setzen zunehmend auf grüne Energie und investieren in nachhaltige Rechenzentren, um ihren CO2-Fußabdruck zu reduzieren. Dies trägt maßgeblich dazu bei, den ökologischen Fußabdruck des Betriebes von KI-Services positiv zu beeinflussen. Die Debatte um den Energieverbrauch von KI-Systemen ist oft emotional und von Missverständnissen geprägt. Manche Stimmen warnen vor einer floodartigen Zunahme des Energieverbrauchs mit der immer stärkeren Verbreitung von KI-Agenten, die ständig online und bereit sind, Rückfragen zu beantworten. Diese Szenarien können tatsächlich zu einem signifikanten Anstieg des Gesamtenergiebedarfs führen, insbesondere wenn KI in großem Maßstab in Industrie und Alltag integriert wird.

Andererseits sorgen technische Fortschritte in der Hardware, wie spezialisierte KI-Chips und optimierte Algorithmen, für stetige Verbesserungen in der Effizienz. Die Kombination aus Nachfragereduktion, effizienter Hardwarenutzung und grüner Energieversorgung ist der Schlüssel zu einer nachhaltigen Entwicklung von KI-Technologien. Der öffentliche Diskurs sollte zudem die Nutzungsgewohnheiten und das Verhalten der Anwender nicht außer Acht lassen. Da eine einzelne Anfrage vergleichsweise wenig Energie benötigt, wird das Gesamtbild stark durch die Nutzerintensität geprägt. Wenn KI-Modelle einen Mehrwert bieten und Arbeitsprozesse vereinfachen, steigt die Anzahl der Anfragen rasch an.

Das unbedachte exzessive Verwenden könnte so die Vorteile in puncto Energieeffizienz wieder relativieren. Ein verantwortungsvoller Umgang und Bewusstsein für den Verbrauch sind daher auch bei Digitalisierung und KI-Anwendungen wichtig, um nachhaltige Nutzungsmuster zu fördern. Darüber hinaus ist es entscheidend, zwischen dem Energieverbrauch einzelner Interaktionen und der massiven Energieinvestition in die Entwicklungsphase zu unterscheiden. Die Produktionskosten in Form von Energie für das Training großer Modelle sind erheblich, nehmen aber im Produktivbetrieb, also bei der Beantwortung von Nutzeranfragen, eine geringere Rolle ein. Unternehmen arbeiten daher kontinuierlich daran, die Modelle nach dem Training so zu optimieren und zu verfeinern, dass der tägliche Betrieb möglichst energieeffizient abläuft.

Dadurch wird das energetische Verhältnis verbessert, was sich langfristig positiv auf den ökologischen Fußabdruck dieser Technologien auswirkt. Die Erkenntnis, dass eine Mittelwerteinschätzung von 0,34 Wh pro ChatGPT-Anfrage realistisch ist, hat auch Implikationen für die öffentliche Wahrnehmung von KI in Bezug auf Nachhaltigkeit. Sie hilft dabei, unbegründete Horrorszenarien zu entkräften und den Fokus auf die realen Herausforderungen zu lenken, die mit dem Ausbau von KI-Systemen einhergehen. Zugleich ist die Transparenz seitens Unternehmen wie OpenAI ein wichtiger Schritt, um Vertrauen zu schaffen und gesellschaftliche Akzeptanz für den Einsatz von KI-Technologien zu fördern. Insgesamt zeigt das Bild, dass Chatbots auf KI-Basis energieeffizienter sind als viele vermuten.

Sie verbrauchen deutlich weniger pro Anfrage als oft diskutiert wird und sind im Vergleich zu anderen digitalen Anwendungen eher moderat unterwegs. Dies bedeutet nicht, dass die Energiefrage trivialisiert werden sollte. Im Gegenteil, es bleibt essenziell, die Entwicklung hin zu nachhaltigen Technologien konsequent zu verfolgen und zu unterstützen. Dabei spielen sowohl technische Innovationen als auch innovative Geschäftsmodelle sowie politische Rahmenbedingungen eine Rolle. Schließlich lässt sich festhalten, dass die Diskussion um den Energieverbrauch von KI-gestützten Chatbots differenziert betrachtet werden muss.

Eine durchschnittliche ChatGPT-Anfrage mit ca. 0,34 Wh verdeutlicht, dass der Fokus eher auf den kumulativen Energieverbrauch und auf die Trainingsphasen großer Modelle gerichtet sein sollte als auf die einzelnen Abfragen. Um den ökologischen Fußabdruck des wachsenden KI-Sektors zu minimieren, sind technologische Weiterentwicklungen, eine Nutzung von nachhaltigem Strom und ein bewusster Umgang mit den Tools gleichermaßen von Bedeutung. Dadurch kann die Integration von KI in Gesellschaft, Wirtschaft und Alltag verantwortungsvoll gestaltet werden – zum Nutzen von Mensch und Umwelt.