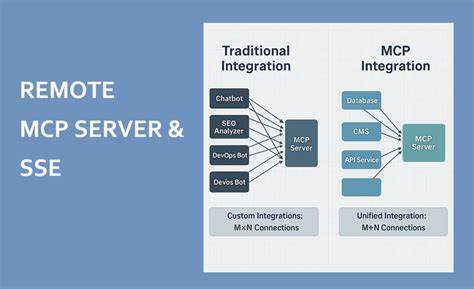

Die rasante Entwicklung serverloser Architekturen hat die Art und Weise verändert, wie Anwendungen heute skaliert und betrieben werden. Trotzdem stellen persistente Verbindungen, insbesondere über Server-Sent Events (SSE), Betreiber und Entwickler vor Herausforderungen. Die Open-Source-Veröffentlichung einer SSE Virtualisierungsschicht für Remote MCP Server bietet eine innovative Lösung für dieses Problem, indem sie zuverlässige SSE-Verbindungen mit einem On-Demand-Aufruf von Funktionen in einem performanten und kosteneffizienten System verbindet. Dieses Projekt, umgesetzt in Golang, stellt einen technologischen Fortschritt dar und adressiert sowohl technische Anforderungen als auch wirtschaftliche Aspekte moderner Cloud-Anwendungen. Die SSE Virtualisierungsschicht ermöglicht es, lang anhaltende Verbindungen zu Endgeräten aufrechtzuerhalten, ohne dabei die Ausführung serverloser Funktionen ständig laufen lassen zu müssen.

Das Ergebnis ist eine Trennung von Verbindungsmanagement und Funktionsausführung, die nicht nur die Systemlast reduziert, sondern auch die Betriebskosten signifikant senkt. Einer der zentralen Vorteile dieses Konzepts ist die Möglichkeit, serverlose Funktionen nur bei Bedarf zu starten. Somit müssen teure Rechenressourcen nicht dauerhaft vorgehalten werden. Die Architektur leistet dies durch eine intelligente Verwaltung der Verbindungen und Zustände auf Seiten des Servers mithilfe von Redis. Redis übernimmt dabei die zentrale Rolle der zustandsbehafteten Speicherung und ermöglicht effizientes Tracking aller aktiven Verbindungen und registrierter Funktionen.

Die innovative Nutzung von Redis bringt einen weiteren Vorteil: Hohe Verfügbarkeit und Skalierbarkeit werden zum integralen Bestandteil der Lösung. Die Kombination von Redis und Go gewährleistet eine hohe Performance und niedrige Latenz bei gleichzeitiger Kontrolle über Verbindungszustände. Ein weiterer Aspekt, der bei der SSE Virtualisierungsschicht hervorgehoben werden kann, ist die eingebaute Echtzeit-Überwachung. Dies umfasst die Überwachung des Systemzustands, Verbindungszahlen sowie Funktionsstatus. Entwickelnde und Betreiber verfügen so jederzeit über technisches Monitoring und Diagnosedaten, die präventiv für die Vermeidung von Ausfällen oder Degradierungen genutzt werden können.

Die Registrierung und Verwaltung von serverlosen Funktionen erfolgt dynamisch über eine REST-API, deren Endpunkte speziell für Administration und Client-Kommunikation ausgelegt sind. Somit lassen sich neue Funktionen unkompliziert hinzufügen und Funktionen bei Bedarf ansprechen. Die Integration in bestehende Ökosysteme ist durch das offene und standardisierte API-Design flexibel möglich. Die Nutzung ist auch für Entwickler:innen wenig aufwändig. Über eine einfache SSE-Verbindung auf Client-Seite können Nutzer sofort mit dem Streaming von Events beginnen.

Das Frontend profitiert von stabilen Verbindungen, bei denen automatische Heartbeats für Langlebigkeit sorgen und sich Fehler schnell erkennen lassen. Insbesondere im Kontext von Web-Browsern, mobilen Anwendungen oder IoT-Geräten zeigt sich der große Vorteil dieser Lösung: Keine Verbindungsabbrüche oder Verzögerungen bei der Datenübertragung. Die Skalierbarkeit des Systems wird durch die klare Trennung von Verbindungsverwaltung und Rechnerservice gefördert. Das bedeutet, dass die Anzahl der gleichzeitig geöffneten SSE-Verbindungen beliebig wachsen kann, während die Rechenlast flexibel auf Funkionsinstanzen verteilt wird. Die Funktionseinheiten selbst können auf verschiedenen Serverless-Plattformen laufen, wie AWS Lambda, Vercel oder Netlify, oder sogar auf eigenen APIs basieren.

Die Architektur dieses Projekts zeigt damit einen modernen Microservice-Ansatz, der mit hoher Flexibilität auf unterschiedliche Infrastrukturumgebungen angepasst werden kann. Die Pflege und Weiterentwicklung erfolgt offen im Rahmen eines MIT-lizensierten Open-Source-Projekts, was eine breite Teilnahme aus der Entwickler-Community ermöglicht. Die Open-Source-Komponente fördert nicht nur Transparenz, sondern sorgt auch dafür, dass Anpassungen schnell erreichbar und neue Features von der Community vorangetrieben werden können. Der Einsatz von Go als Programmiersprache gibt dem Projekt seine Performance-Vorteile, vor allem hinsichtlich der gleichzeitigen Verarbeitung vieler Verbindungen. Go ist bekannt für seine effiziente Goroutine-Architektur, die leichtgewichtige parallele Abläufe ermöglicht, und passt damit ideal zu einer hochskalierbaren SSE-Umgebung.

Die sorgfältige Trennung der Schichten, von der Client-Kommunikation über die Verbindungsverwaltung bis hin zu den dynamischen Serverless-Funktionen, macht das System nicht nur robust, sondern auch modular. Änderungen oder Erweiterungen können problemlos in einzelnen Komponenten umgesetzt werden, ohne dass das Gesamtsystem instabil wird. Die bereitgestellten API-Endpunkte ermöglichen eine intuitive Nutzung: Clients können eine SSE-Verbindung aufbauen, Funktionen dynamisch registrieren und Aufrufe starten, während Administratoren über spezielle Endpunkte Echtzeitinformationen und Statistiken abrufen können. Die Systemarchitektur sieht außerdem eine automatische Herzschlagüberwachung vor, die in regelmäßigen Abständen die Verbindungen überprüft. Dadurch wird sichergestellt, dass inaktive Verbindungen schnell erkannt und bereinigt werden, was die Ressourcen optimal nutzt.

Die Docker- und Docker-Compose-Integration sorgt für eine einfache Einrichtung und schnellen Start. Sowohl Entwickler als auch Betreiber profitieren von der containerisierten Bereitstellung, die eine schnell reproduzierbare Umgebung sowohl im lokalen Setup als auch in Cloud-Umgebungen garantiert. Die Kombination aus persistenter Verbindung, serverloser Funktionsausführung auf Abruf, flexibler Redis-gestützter Zustandsverwaltung und perfekter Überwachbarkeit macht diese SSE Virtualisierungsschicht zu einer wertvollen Lösung für moderne Echtzeitanwendungen. Gerade in Anwendungen, die hohe Anforderungen an Latenz und Verbindungsstabilität haben, wie beispielsweise Chat-Anwendungen, Echtzeit-Dashboards oder IoT-Kontrollzentralen, ermöglicht dieses System eine signifikante Optimierung der Performance und Betriebskosten. Die Trennung von Verbindung und Funktion sorgt zudem für eine verbesserte Fehlertoleranz, da etwaige Ausfälle der Serverless-Funktionen nicht automatisch einen Verbindungsverlust bedeuten.

Aus Sicht der Cloud-Kostenrechnung ist der Ansatz ebenso attraktiv. Da Funktionen nur bei tatsächlichem Bedarf aufgerufen werden, entfallen unnötige Rechenzyklen und somit teure Laufzeitkosten. Somit profitieren Unternehmen jeder Größe von einer effizienteren Cloud-Nutzung und vermeiden die klassischen Probleme dauerhafter Verbindungen in serverlosen Architekturen. Ein weiterer Vorteil ist die große Flexibilität hinsichtlich der Integration in bestehende Umgebungen. Die SSE Virtualisierungsschicht kann als Middleware agieren, die nahtlos zwischen Clients und heterogenen Funktionsservern vermittelt.

Dadurch ist eine stufenweise Migration von monolithischen Anwendungen zu modernen serverlosen Architekturen leichter realisierbar. Die Funktionsvielfalt ist durch das API-Design beliebig erweiterbar. Verschiedene Arten von Serverless-Services, egal ob einfache HTTP-Events oder komplexe Multi-Step-Funktionalitäten, können eingebunden und orchestriert werden. Das Projekt stellt damit auch eine technologische Plattform für weiterführende Use Cases dar, beispielsweise in Bereichen von Machine Learning Inferenz, komplexen Business-Workflows oder Echtzeitkommunikation. Insgesamt vereint die Open Source SSE Virtualisierungsschicht für Remote MCP Server technische Innovationskraft mit praktischer Anwendbarkeit.

Sie bietet Entwicklern moderne Werkzeuge, um langlebige Echtzeitverbindungen zuverlässig und skalierbar zu managen, während gleichzeitig Cloud-Ressourcen bestmöglich genutzt werden. Die zugrunde liegende Architektur öffnet Perspektiven für vielfältige Echtzeitlösungen, die bisher mit serverlosen Ansätzen nur schwer zu realisieren waren. Aufgrund der modularen Bauweise ist die SSE Virtualisierungsschicht eine spannende Grundlage für zahlreiche Projekte im Umfeld moderner Cloud-/Edge-Architekturen. Die Veröffentlichung unter einer MIT-Lizenz fördert darüber hinaus Innovation und Community-Engagement. Entwickler sind eingeladen, das Projekt auf GitHub zu nutzen, zu testen und mit eigenen Ideen zu bereichern.

Im Kern steht damit nicht nur eine technische Komponente, sondern auch eine offene Plattform, die gemeinsam weiterentwickelt wird. Die Zukunft serverloser Systeme wird so nicht nur von Skalierung und Einfachheit geprägt sein, sondern auch von einer klaren Trennung und Optimierung der einzelnen Systemkomponenten – wie das hier vorgestellte Projekt eindrucksvoll demonstriert.