Haskell gehört zu den beliebtesten funktionalen Programmiersprachen und beeindruckt durch seine deklarative Syntax, starke Typisierung und vor allem durch sein lazy Evaluation Modell. Dieses ermöglicht es, Berechnungen erst dann durchzuführen, wenn ihre Ergebnisse wirklich benötigt werden. Obwohl dieses Konzept viele Vorteile bietet, bringt es auch Herausforderungen mit sich, insbesondere im Bereich der Speicherverwaltung. Eines der häufigsten und zugleich komplexesten Probleme sind sogenannte Thunk-Lecks. Um nachhaltige und performante Haskell-Programme zu schreiben, ist es essentiell, die Anatomie dieser Problematik zu verstehen und gezielte Gegenmaßnahmen anzuwenden.

Unter einem Thunk versteht man in Haskell eine nicht-evaluierte Berechnungseinheit – im Prinzip eine Art verzögerte Ausdrücke, die erst ausgewertet werden, wenn ihr Wert tatsächlich gebraucht wird. Dies ist zentraler Bestandteil des Lazy-Loading-Prinzips. Doch wenn eine große Anzahl solcher Thunks während der Programmausführung aufgebaut, aber nicht rechtzeitig ausgewertet wird, entsteht ein Thunk-Leck. Die Folge sind übermäßiger Speicherverbrauch und mögliche Stack-Überläufe, was die Performance dramatisch verschlechtert und im schlimmsten Fall zum Absturz der Anwendung führen kann. Die Metapher von verpackten Geschenken, wie sie von Experten verwendet wird, hilft, das Problem anschaulich zu machen: Stellen Sie sich vor, jeder Thunk ist ein Geschenk, das eingepackt und noch nicht geöffnet ist.

Solange nur wenige Geschenke unberührt liegen, ist das kein Problem. Es wird kritisch, wenn sich unzählige Päckchen anhäufen und niemand sie auspackt – das entspricht der Speicherbelegung durch Thunks, die Speicher beanspruchen ohne ihren Wert beizutragen. Wichtig ist dabei, dass dieser Rückstau von verzögerten Berechnungen entsteht, wenn die Programme nicht genügend „eifrig“ sind, die Berechnungen rechtzeitig zu evaluieren. Nicht jeder Thunk ist jedoch schädlich. In vielen Fällen sind Thunks unvermeidbar und sogar nützlich, da sie Speicher sparen, indem sie nur bei Bedarf berechnet werden.

Das Problem tritt auf, wenn Thunks unnötig im Speicher verweilen. Dabei müssen einige Bedingungen erfüllt sein: Zum einen sollten die Thunks keine externen Verweise mehr haben, sodass bei Auswertung die Speicher freigegeben werden kann. Zum anderen darf die Auswertung nicht zu einer noch größeren, komplexeren Datenstruktur führen, da dies das Speicherproblem verschärfen würde. Schließlich sollten die Thunks auch notwendig sein; unnötige, zu früh erzeugte Thunks können ebenfalls zum Leck führen. Das Erkennen von Thunk-Lecks ist entscheidend für die Optimierung.

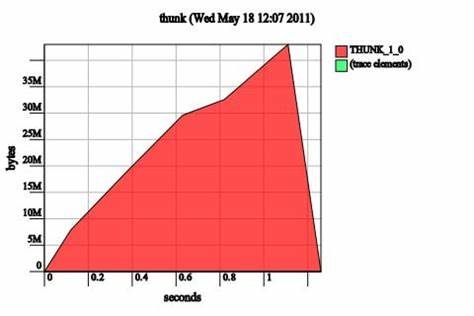

In der Praxis zeigt sich ein solches Leck durch einen ungewöhnlich hohen Speicherverbrauch oder Stack-Überläufe. Mithilfe von Heap-Analyse-Tools kann ein Blick auf die Speicherbelegung offenbaren, ob viele THUNK-Objekte im Speicher gehalten werden. Besonders hilfreich ist hier das Profiling mit dem RTS-Flag -hT, mit dem detaillierte Heap-Profile ohne Neu-Kompilierung erzeugt werden können. Ein dominanter THUNK-Anteil weist klar auf ein Thunk-Leck hin. Ein klassisches Beispiel ist eine naive Implementierung einer iterativen Funktion, bei der eine Zählvariable in Form eines Thunks akkumuliert wird.

Hier entsteht eine lange Kette von nicht ausgewerteten Berechnungen, die unnötig Speicher fesseln. Interessanterweise kann der GHC-Compiler bei Aktivierung von Optimierungen diesen Fall oft automatisch entschärfen, da primitive unboxte Datentypen wie Int# keine Thunks zulassen. Dennoch sollte man sich nicht allein auf Optimierungen verlassen, da komplexere Fälle problematisch sind. Ein wesentlich komplexeres Beispiel betrifft Funktionen, die Tupel verwenden, in denen Elemente erst spät ausgewertet werden dürfen, um semantische Korrektheit zu gewährleisten. In solchen Fällen treten Thunk-Lecks auch mit Optimierungen auf und können sogar zu Stack-Überläufen führen.

Der Grund liegt darin, dass die Verzögerung zu hohem Speicherverbrauch führt, weil thunks in Tupeln nicht strikt ausgewertet werden. Das Fixieren von Thunk-Lecks erfolgt idealerweise durch gezielte Einführung von Evaluation zum richtigen Zeitpunkt. Dies kann durch das Setzen von strikten Mustern mittels Bang-Patterns (!) erreicht werden, die dafür sorgen, dass Werte beim Durchlaufen der Funktion direkt ausgewertet werden und keine langen Ketten von Thunks entstehen. Jedoch funktioniert das nicht immer, gerade bei Tupeln reicht eine einfache strikte Bindung nicht aus, da Haskell „seq“ erst beim Mustermatch tiefer in die Struktur schaut. Eine effektive Strategie ist daher, Funktionen und insbesondere Hilfsfunktionen strikt zu machen.

Durch das Markieren der Parameter als strikt oder die Verwendung strikter Datentypen kann sichergestellt werden, dass keine unnötigen Thunks entstehen. Die Verwendung von unstrukturierten Tupelmustern sollte vermieden oder ergänzt werden, damit der Compiler Schachtelungen besser erkennen und optimieren kann. Darüber hinaus ist zu beachten, dass eine zu frühe Evaluation unter Umständen kontraproduktiv sein kann, besonders wenn die Berechnung sehr teuer oder gar unnötig ist. Die Kunst besteht darin, genau die richtige Balance zwischen zu viel Laziness und zu viel Striktheit zu finden, um das Speicherproblem zu minimieren ohne semantische Änderungen herbeizuführen oder unnötige Rechenzeit zu verursachen. Manche Entwickler greifen auch auf das Konzept von ‚deepseq‘ zurück, um komplexe verschachtelte Datenstrukturen vollständig zu evaluieren und damit Speicherlecks zu vermeiden.

Zwar kann diese Methode das Problem lösen, ist aber häufig mit einem deutlichen Mehraufwand verbunden. Daher empfehlen Experten, besser von Anfang an auf geeignete strikte Datentypen und Funktionsdefinitionen zu achten. Auch wenn der Haupteinsatzbereich von Thunk-Lecks bei einfachen Tupeln und Iterationsfunktionen liegt, ist das Problem in Haskell grundsätzlich viel weiter verbreitet. Andere Strukturen wie Records, benutzerdefinierte Datenkonstruktoren oder mutable Referenzen können auf ähnliche Weise Speicher einschließen, wenn sie nicht sorgfältig behandelt werden. Das Verständnis der dahinterliegenden Prinzipien hilft Entwicklern, diese Fallen frühzeitig zu erkennen und gezielt zu umgehen.

Die Herausforderung bei Thunk-Lecks ist oft nicht der eigentliche Fix, sondern das korrekte Diagnostizieren. Viele Entwickler verwechseln Thunk-Lecks mit anderen Arten von Speicherlecks, was die Suche nach der Ursache erschwert. Die charakteristische Speicherprofilierung mit dominanten THUNK-Anteilen hilft hier, um die Diagnose einzugrenzen. In der Praxis sollten Entwickler daher immer mit aktiver Speicherüberwachung arbeiten und ihre Programme regelmäßig mit Profiling-Werkzeugen untersuchen. Nur so lassen sich Thunks sichtbar machen, die zu einem späteren Zeitpunkt im Programm nicht mehr nötig sind, aber dennoch Speicher belegen.

Der GHC-Compiler bietet bereits viele Optimierungen, die automatisch Thunk-Lecks verhindern oder abschwächen. Dennoch ersetzen diese nicht das Wissen und die bewusste Programmgestaltung. Gerade bei großen und komplexen Anwendungen ist ein durchdachtes Speichermanagement unerlässlich. Zusammengefasst ist ein Thunk-Leck in Haskell die Folge von der Ansammlung zu vieler nicht ausgewerteter Berechnungen, die beim Öffnen evaluierter Ergebnisse einen enormen Teil des Heaps belegen. Die Ursachen liegen in mangelnder Striktheit, ineffizienter Datenstrukturhandhabung und fehlendem Bewusstsein für lazy Evaluation.

Dank moderner Werkzeuge und bewährter Programmierpraktiken lassen sich diese Herausforderungen jedoch gut meistern. Wer sich intensiver mit dem Thema beschäftigt, profitiert von einem tieferen Verständnis der Evaluationsstrategien in Haskell, der Verwendung strikter Typen, Muster und von Profiling-Techniken. Auf diese Weise wird es möglich, Speicherlecks effektiv zu vermeiden, Programme stabiler zu machen und die Vorteile von Haskells Lazy Evaluation voll auszuschöpfen.

![Unducted Jet Fans from MD81 [video]](/images/45FF3518-636E-4A10-85D9-EE143CAF8F69)