Systemdynamik (SD) ist eine bewährte Methode zur Modellierung komplexer Systeme, die Feedbackschleifen und dynamische Wechselwirkungen abbilden. Seit Jahrzehnten setzen Forscher und Praktiker auf visuelle Werkzeuge wie Stock-and-Flow-Diagramme, um Ursache-Wirkungs-Zusammenhänge verständlich zu machen. Diese Darstellungsmethode ist seit den Tagen der Overhead-Projektoren erfolgreich für Schulungen und Workshops, hat jedoch entscheidende Einschränkungen, wenn SD-Modelle in realen, operativen Umgebungen eingesetzt werden sollen. Die Herausforderung besteht darin, dass die Visualisierung diese Modelle als bloße Präsentationsmaterialien behandelt, statt als lebende, integrierte Infrastruktur. Dieser Artikel erläutert, warum die Zukunft der Systemdynamik klar in einer codezentrierten Herangehensweise liegt und wie Unternehmen dadurch nachhaltige Vorteile erzielen können.

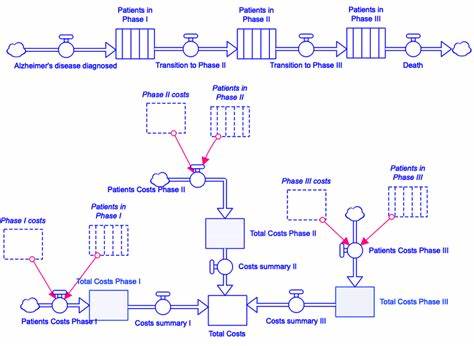

Die Grenzen von visuellen Modellierungswerkzeugen Traditionelle visuelle Werkzeuge zur Systemdynamik bieten eine intuitive Oberfläche, um Stock-and-Flow-Modelle und kausale Schleifen abzubilden. Sie sind insbesondere didaktisch wertvoll, weil sie komplexe Zusammenhänge verständlich machen. Doch ihre Stärke wird gleichzeitig zur Schwäche, sobald das Modell operationalisiert wird. Hinter einem einfachen Rechteck oder Pfeil verbirgt sich oft eine komplexe Gleichung, deren Auswirkungen auf das Gesamtsystem nicht immer sofort ersichtlich sind. Änderungen an einzelnen Elementen können unerwartete Nebeneffekte nach sich ziehen – ohne einen klaren Hinweis, woher diese resultieren.

Der Mangel an Nachvollziehbarkeit ist ein großes Problem. Screenshots oder grafische Dateiformate sind schwer zu vergleichen oder zu versionieren. Das bedeutet, dass die Zusammenarbeit im Team verkompliziert wird, weil parallele Änderungen oder Kritikschleifen auf Code-Ebene nicht möglich sind. Die Modelle werden sprichwörtlich zu Einzelkämpfern, ihre Dateien meist binär und zustandsbehaftet, was das Zusammenarbeiten und das Mergen von Änderungen nahezu unmöglich macht. Ein weiteres Problem ist die statische Natur der meist in solchen Tools eingebundenen Datensätze.

Wenn die zugrundeliegenden CSV-Dateien nicht aktualisiert werden oder die politischen Rahmenbedingungen sich ändern, driftet das Modell schnell vom aktuellen Zustand ab. Es existiert in der Regel keine automatisierte Teststrategie, die solche Inkonsistenzen erkennt und meldet. Die Wurzel aller dieser Probleme liegt darin, dass das Modell als eine Art visuelle Präsentation betrachtet wird und nicht als eine technische Infrastruktur, die in einen ganzheitlichen Entwicklungs- und Betriebsprozess eingebunden ist. Code als lebendiges System: Die Revolution der Modellierung Der radikale Wandel beginnt, wenn Systemdynamikmodelle nicht mehr als Grafik, sondern als Code geschrieben werden. Programmiersprachen wie Python mit ihrer breiten Akzeptanz und umfangreichen Datenökosystemen bieten ideale Voraussetzungen, um Modelle als lebendige Systeme zu implementieren.

Durch diesen Paradigmenwechsel entsteht ein neues soziales und technisches Vertragswerk. Versionierung und Nachverfolgbarkeit funktionieren genauso nahtlos wie bei herkömmlichem Anwendungscode. Alle Gleichungen, Parameter und Zeitreihen werden in Git gespeichert und können mit gängigen Tools wie Blame, Diff oder Rollback analysiert werden. Das fördert Transparenz und ermöglicht eine verlässliche Zusammenarbeit im Team, die visuelle Werkzeuge schlicht nicht leisten können. Durch kontinuierliche Integration (Continuous Integration, CI) können Modelle automatisiert getestet werden.

Beispielweise lässt sich bei jeder Änderung ein wichtiges Szenario automatisch neu berechnen. Wird dabei eine kritische Kennzahl, beispielsweise ein finanzieller KPI, verletzt, schlägt der Build fehl. Auf diese Weise sind Teams vor unbeabsichtigten Fehlern geschützt, noch bevor das Ergebnis weitere Entscheidungen beeinflusst. Aber der Code bringt noch weitere Vorteile mit sich. Kompositionen und Abstraktionen in Form von Funktionen erlauben es, beispielsweise SIR-Modelle oder Lagerketten als wiederverwendbare Bausteine zu erstellen.

Diese können einzeln getestet und weiterentwickelt werden – eine enorme Qualitätssteigerung im Vergleich zum kopieren und modifizieren von Diagrammen ohne Testbarkeit. Die Integration von Daten erfolgt nativer und robuster. SQL-Views, Echtzeit-Kafkaströme oder Dateiformate wie Parquet werden direkt in die Modellzustände eingelesen. Das ersetzt umständliche CSV-Importe und minimiert Fehlerquellen. Zudem ermöglichen moderne Observability-Tools eine lückenlose Überwachung der Modellläufe.

Indikatoren aus der Modellwelt lassen sich auf Dashboards neben den Monitoringdaten von IT-Systemen visualisieren. So werden Diskrepanzen zwischen Modellannahmen und der Realität frühzeitig erkannt. Die Modelllandschaft wird zu einem digitalen Zwilling, der skalierbar eingesetzt, überwacht und bei Bedarf zurückgerollt werden kann. Der Codezentrierte Systemdynamik-Stack: Eine technische Blaupause Diese Transformation erfordert eine Architektur, die auf offenen und bewährten Bausteinen aufbaut. Im Zentrum steht ein Modell- und Artefakt-Repository, das als Single Source of Truth für Gleichungen, Parameter, trainierte Surrogate und Metadaten dient.

Git-Repositories kombiniert mit Container-basierten Speicherlösungen oder Experiment-Trackern wie MLflow sorgen für Versionssicherheit und Nachvollziehbarkeit. Der Datenfabric umfasst zuverlässige Pipelines, die historische Daten ebenso wie Streaming-Signale in Warehouse- oder Lakehouse-Formate transportieren. Hier sind Verlässlichkeit und Wartbarkeit der Datenflüsse systemisch eingebaut – nicht bloß als ad-hoc Scripts. Eine föderierte Abfrageschicht sorgt dafür, dass Kalibrierungsdaten aus unterschiedlichen Datenspeichern (Postgres, BigQuery, DuckDB oder Trino) einheitlich und ortsunabhängig abgerufen werden können. Damit bleibt die Modelllogik unabhängig vom Speicherort der Daten.

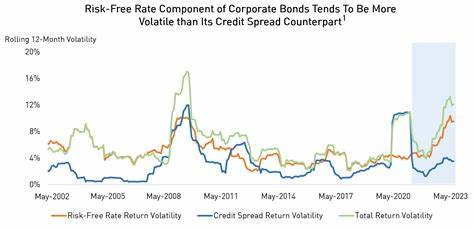

Der Simulationsruntime läuft auf optimierten Deterministischen oder stochastischen Solver-Lösungen, die in Python-Ökosystemen wie NumPy oder JAX realisiert sind. Für großangelegte Parameterstudien kommen parallelisierte Frameworks wie Dask oder Ray zum Einsatz. Exakte Reproduzierbarkeit wird durch klare Seedings geregelt. Zur Beschleunigung von großen Monte-Carlo-Simulationen wird auf neuartige Lernruntimes gesetzt, bei denen neuronale Surrogate oder Bayessche Modelle auf Basis von PyTorch oder JAX trainiert werden. Diese Modelle liegen direkt neben dem Basismodell und erlauben einen nahtlosen Vergleich.

Die Orchestrierung der Experimente übernimmt moderne Workflow-Engines wie Airflow, Prefect oder Argo. Sie steuern Ressourcen und speichern Artefakte, sodass die Historie von Analyseergebnissen jederzeit nachvollzogen werden kann. Transparenz und Monitoring werden durch Observability-Stacks sichergestellt, die OpenTelemetry, Prometheus und Alerting-Regeln miteinander verbinden. Dashboards zeigen IT-Metriken und Modellvariablen parallel an. Schließlich werden Visualisierungen und Schnittstellen durch generierte kausale Diagramme sowie Web-Frontends mit React oder Streamlit bereitgestellt.

APIs wie GraphQL ermöglichen es anderen Systemen, die Modelle anzusprechen und in Unternehmensprozesse einzubinden. Governance wird durch Git-basierte Prüfprozesse und Audit-Trails gesichert. Compliance-Anforderungen wie Sarbanes-Oxley werden automatisch durchgesetzt – eine bedeutende Erleichterung für Risikomanagement und interne Revision. Warum sowohl Modellierer als auch Organisationen profitieren Eine codezentrierte Systemdynamik schafft eine gemeinsame Realität für verschiedene Abteilungen wie Finance, Operations und Engineering. Wenn alle Beteiligten von denselben Daten, Parametern und Versionsständen ausgehen, verlagern sich Diskussionen weg von unübersichtlichen Screenshots hin zu faktischen Parametereinblicken.

Die Dynamik in Unternehmen wird erhöht, da Änderungen beispielsweise in der Nachschublogik sofort und automatisiert getestet werden können und rasch Auswirkungen zeigen. Entwickler-Pipelines ermöglichen es, neue Szenarien über Nacht in Staging-Umgebungen einzuspielen, sodass Entscheidungen zeitnah getroffen werden können. In puncto Governance und Transparenz entspricht jeder Modelllauf einer nachvollziehbaren Änderung mit gespeicherter Historie. Auditoren können die Modellentwicklung nachvollziehen, Revisionen sind einfacher denn je. Die computergestützte Infrastruktur erlaubt enorme Skalierung, sodass zehntausende Simulationen parallel ausgeführt werden können.

Das bedeutet, dass Sensitivitätsanalysen und Policies schneller umgesetzt werden – statt mehrere Tage oder Wochen dauert die Durchführung nur noch Minuten oder eine Kaffeepause. Ein Aufruf zur Transformation Bislang gibt es noch keine fertigen, schlüsselfertigen codezentrierten Systemdynamikplattformen als Kommerzprodukt. Die Herausforderung ist, etablierte Open-Source-Komponenten zu einer robusten Pipeline zusammenzufügen und durch Software-Engineering-Prinzipien Systemdynamik nativ in moderne Entwicklungsprozesse einzubringen. Visuelle Werkzeuge bleiben weiterhin essenziell für die ersten Skizzen, das Whiteboarding und die Einarbeitung neuer Anwender. Doch sobald es um die Steuerung komplexer, evolutionärer Systeme geht, die mehrere Teams und Bereiche umfassen, ist Code die einzige Sprache, die Bestand hat.

Die volle Kraft der Systemdynamik wird erst dann sichtbar, wenn sich Feedbackschleifen genauso kompilieren, committen und deployen lassen wie Software. Die Modellierung wird damit vom bloßen ’Slide‘ zur lebendigen, strategischen Grundlage für Entscheidungen und Steuerung. In einer immer komplexer werdenden Welt ist die codezentrierte Systemdynamik kein Luxus, sondern eine Notwendigkeit, um nachhaltige und belastbare Modelle zu etablieren, die nicht nur die Realität abbilden, sondern aktiv mitgestalten und steuern können.