In der heutigen datengetriebenen Welt ist die Wahl der richtigen Datenbanklösung entscheidend für den Erfolg von Softwareprojekten und Unternehmen. Viele Organisationen stehen vor der Herausforderung, skalierbare und zugleich kosteneffiziente Datenbanken zu betreiben, die den Anforderungen moderner Anwendungen gerecht werden. Ein aktueller Trend zeigt, dass Unternehmen, die ursprünglich auf hochverteilte Datenbanksysteme wie CockroachDB gesetzt haben, zunehmend auf relationales Datenbankmanagement mit PostgreSQL umsteigen. Die Gründe für diesen Wechsel sind vielfältig und spiegeln sowohl technische als auch betriebswirtschaftliche Überlegungen wider. CockroachDB gilt als verteilte SQL-Datenbank mit dem Vorteil horizontaler Skalierung und besonders hoher Verfügbarkeit, was insbesondere für Multi-Region-Setups von Bedeutung ist.

Gerade wenn gesetzliche Regelungen wie die Datenschutzgrundverordnung (GDPR) eine Datenlokalisierung notwendig machen, erscheint ein verteiltes System wie CockroachDB auf den ersten Blick unverzichtbar. Doch die Realität im Alltag sieht oft differenzierter aus. Viele Unternehmen, wie am Beispiel eines Softwareunternehmens erkennbar, nutzen CockroachDB in einer Single-Region-Umgebung mit überwiegend transaktionalen, einfachen Abfragen. In solchen Fällen kann die Komplexität und der hohe Kostenaufwand eines verteilten Systems überproportional wirken. Ein wesentlicher Punkt, der zur Migration von CockroachDB zu PostgreSQL motivierte, waren steigende Betriebskosten.

Während CockroachDB für kleine Datenvolumina durchaus praktikabel scheint, explodierten im konkreten Beispiel die Kosten innerhalb weniger Jahre, sodass sie mit 5-facher Steigerung in den mittleren sechsstelligen Bereich kletterten. Zudem zeigten sich bei zunehmender Datenbankgröße Schwächen in der Verwaltung und Durchführung von Datenbankmigrationen. Mit wachsendem Datenvolumen wurde die Migration über das Object-Relational-Mapping (ORM) Werkzeug Prisma zunehmend problematisch, denn Timeout-Fehler beim Anwenden von Migrationskripten führten zu erheblichen Verzögerungen und arbeitsintensiven manuellen Nacharbeiten direkt in der Datenbank. Im direkten Vergleich zeigte sich, dass vergleichbare Migrationen auf PostgreSQL nur Sekunden dauerten. Diese Performance-Unterschiede resultierten nicht nur in schnelleren Deployment-Zyklen, sondern verfügten auch unmittelbar über positive Auswirkungen auf die Entwicklerproduktivität und sorgten für weniger betriebliche Risiken.

Das wiederholt auftretende Timeout-Problem bei CockroachDB hatte zudem zur Folge, dass nicht einmal CockroachDB-Versionen einfach aktualisiert werden konnten, was die Langzeitwartbarkeit erschwerte. Auch beim Datenimport und der Datenintegration im Rahmen von ETL-Prozessen (Extract-Transform-Load) zeigte sich CockroachDB als weniger robust. Das Fehlen ausgereifter ETL-Tools, die nativ CockroachDB unterstützen, führte in der Praxis zu instabilen und fehleranfälligen Abläufen, wie etwa immer wieder auftretende Memory-Leaks bei Connectoren. Im Gegensatz dazu bietet PostgreSQL ein deutlich breiteres und bewährtes Ökosystem an Lösungen für den Datenimport und die Replikation. Ein weiterer Aspekt, der den Umstieg auf PostgreSQL begünstigte, waren signifikante Unterschiede bei der Abfrageperformance.

CockroachDB besitzt zwar einen sehr ausgefeilten Query-Optimizer, der in Einzelfällen Abfragen schneller als PostgreSQL ausführen kann. Doch in vielen praxisrelevanten Abfragen – insbesondere in Kombination mit ORM-generiertem SQL – zeigte PostgreSQL deutliche Vorteile, die teilweise die Ausführung um den Faktor zwanzig beschleunigten. Die Komplexität der automatisch generierten Abfragen, oft mit zahlreichen Joins und verschachtelten Bedingungen, führte in CockroachDB häufig zu ineffizienten vollständigen Tabellenscans, während PostgreSQL diese wesentlich eleganter optimierte. Darüber hinaus gab es im CockroachDB-Umfeld Probleme im Benutzererlebnis für Entwickler und Administratoren. Die öffentliche Management-Oberfläche zeigte beispielsweise indices als ungenutzt an, obwohl sie aktiv verwendet wurden.

Das kann für Entwickler verwirrend sein und fehlerhafte Entscheidungen bezüglich der Datenbankoptimierung fördern. Das Abbrechen laufender Anfragen in CockroachDB gestaltete sich ebenfalls als schwierig und fehleranfällig. Während in PostgreSQL die Abbruchfunktionalität üblicherweise problemlos und schnell verfügbar ist, musste für CockroachDB oft der Umweg über die Web-Konsole beziehungsweise die manuelle Administration in Angriff genommen werden. Schließlich führten auch infrastrukturelle Probleme dazu, dass der Betrieb von CockroachDB nicht frei von Störungen war. Immer wiederkehrende Verbindungsprobleme, verursacht durch VPC- (Virtual Private Cloud) und Netzwerkverbindungsprobleme, waren nicht vollständig lösbar und traten sowohl in produktiven Umgebungen als auch in der Entwicklung oder beim Continuous Integration (CI) auf.

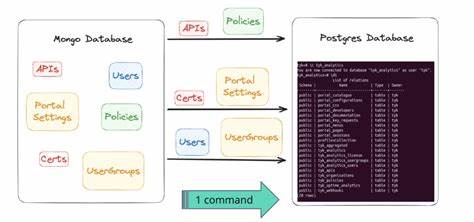

Vergleichbare Probleme traten mit PostgreSQL nicht auf und führten zu einer stabileren und vorhersehbaren Betriebsumgebung. Die eigentliche Migration erwies sich trotz der vielen Herausforderungen als technisch machbar und ließ sich mit einem eigens entwickelten ETL-Mechanismus erfüllen. Interessanterweise führte die Migration auch zur Beschäftigung mit neuen Technologien wie Bun, einer schnell wachsenden JavaScript-Laufzeitumgebung, mit der der Datenexport und -import orchestriert wurde. Dabei musste unter anderem die differierende Byte-Kodierung von JSON- und Array-Datentypen zwischen den beiden Systemen berücksichtigt werden, was eine individuelle Nachbearbeitung der Daten im Migrationsprozess erforderlich machte. Durch den Einsatz einer leistungsstarken virtuellen Maschine und sorgfältiges Vorgehen im Wartungsmodus konnte der umfangreiche Datenbestand von über 100 Millionen Datensätzen produktiv in nur rund 15 Minuten migriert werden.

Dieses Downtime-Fenster wurde bewusst auf knapp eine Stunde ausgeweitet, um die Betriebssicherheit zu maximieren, ist jedoch theoretisch auch deutlich kürzer realisierbar gewesen. Die unmittelbaren Folgen des Wechsels auf PostgreSQL waren sicht- und messbar. Anfragen wurden im Durchschnitt um ein Drittel schneller verarbeitet, nachdem die Datenbank umgestellt und erste Query-Optimierungen mittels spezialisierter Tools wie PGAnalyze vorgenommen wurden. Zusätzlich resultierte der Wegfall der hohen CockroachDB-Kosten in substantiellen Einsparungen von über 110.000 US-Dollar jährlich – eine enorme Summe, die vor allem im Kontext weiter wachsenden Nutzer- und Datenvolumens an Bedeutung gewinnen dürfte.

Zusammenfassend lässt sich sagen, dass der Umstieg von einem verteilten Datenbanksystem wie CockroachDB hin zu PostgreSQL für viele Unternehmen eine attraktive Option darstellt, insbesondere wenn die Anforderungen keine strenge Multi-Region-Datenhaltung erfordern. Die Vorteile liegen insbesondere in einer höheren Performance bei Migrationen und Abfragen, stabileren und einfacheren Betriebsszenarien sowie deutlich geringeren laufenden Kosten. Das breite PostgreSQL-Ökosystem sowie die große Community sorgen für eine hohe Innovationskraft und umfassende Unterstützung bei Problemen. Für Entwickler und technische Entscheider, die vor der Wahl zwischen komplexen verteilten Systemen und bewährten relationalen Datenbanken stehen, bietet die Erfahrung aus realen Migrationen wertvolle Hinweise. Ein schlanker Ansatz mit PostgreSQL ist häufig ausreichend und effizient – und kann gleichzeitig Betrieb und Weiterentwicklung spürbar erleichtern.

Unternehmen, die auf der Suche nach Lösungen für ihre Dateninfrastruktur sind, sollten die spezifischen Anwendungsfälle, das erwartete Datenvolumen sowie den geplanten geografischen Einsatz genau analysieren. Die Praxis zeigt, dass auch vermeintliche Vorteilssysteme wie CockroachDB ihre Grenzen haben und ein als altbekannt geltendes System wie PostgreSQL oft die bessere Wahl darstellen kann. Ferner spricht der Migrationsprozess auch für eine iterative, gut vorbereitete Vorgehensweise, die neben der reinen technischen Umsetzung auch ausgiebige Tests, Datenvalidierung und schrittweise Wiederinbetriebnahme umfasst. Die Erfahrung beweist, dass eine durchdachte Migration nicht zwangsläufig mit langen Ausfallzeiten einhergehen muss, sondern im Gegenteil erhebliche Verbesserungen in allen relevanten Dimensionen der Datenbanknutzung ermöglicht.