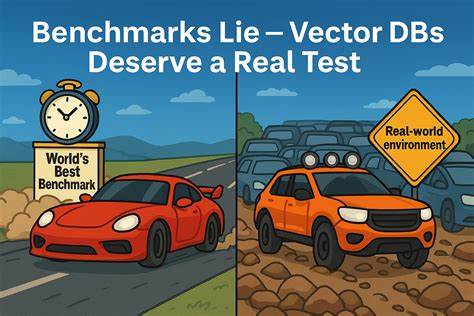

Die rasante Entwicklung von Künstlicher Intelligenz und datengetriebenen Anwendungen hat die Bedeutung von Vektordatenbanken erheblich gesteigert. Diese speziellen Datenbanken ermöglichen effiziente Ähnlichkeitssuchen in großen, hochdimensionalen Datensätzen, wie sie etwa bei Sprach-, Bild- oder Textverarbeitungsmodellen entstehen. Doch trotz des großen Potenzials, das Vektordatenbanken bieten, zeigt sich in der Praxis häufig ein Problem: Konventionelle Benchmarks, die als Entscheidungsgrundlage für die Auswahl einer Datenbank dienen, spiegeln nicht die tatsächliche Leistung unter realen Bedingungen wider. Warum Benchmarks bei Vektordatenbanken irreführend sind und welche Alternativen es gibt, ist Thema dieses Beitrags. Ein zentraler Kritikpunkt an klassischen Benchmarks ist ihre künstliche Testumgebung.

In der Regel messen diese Tests die Performance einer Datenbank erst nachdem sämtliche Daten eingespielt und Indizes vollständig erstellt wurden. Das entspricht jedoch kaum den Bedingungen in produktiven Systemen, wo kontinuierlich neue Daten hinzukommen und Indizes fortlaufend aktualisiert werden müssen. Das Problem: In der Realität lässt sich das System nicht einfach „pausieren“, um einen vollständigen Neuaufbau der Indizes durchzuführen – etwas, das viele Benchmarks voraussetzen. In Produktionsumgebungen herrscht permanenter Datenfluss und gleichzeitige Abfragen. Systeme müssen also nicht nur schnelle Antworten liefern, sondern auch Dauerbelastungen standhalten und dynamisch reagieren können.

Ein Beispiel verdeutlicht dieses Dilemma: Elastisearch kann zwar beeindruckende Abfragezeiten von wenigen Millisekunden vorweisen. Dahinter verbirgt sich jedoch die Tatsache, dass die Indexoptimierung bei großen Datenmengen Stunden – in Einzelfällen sogar über 20 Stunden – beanspruchen kann. Ein solcher Zeitaufwand ist in einem kontinuierlich arbeitenden KI-System untragbar. Denn es entsteht ein Konflikt zwischen Leistung im Labor und der Alltagstauglichkeit im Betrieb. Der Anbieter Milvus berichtet aus erster Hand, dass viele Vektordatenbanken bei Proof of Concept Tests zwar in Laborszenarien glänzen, aber in realen Produktionssituationen durchfielen.

Die Performance bricht dort ein, wo kontinuierliche Datenaufnahme, komplexe Abfragefilter und hohe gleichzeitige Nutzerzahlen die Systeme fordern. Für Unternehmen kann diese Diskrepanz kostspielige Infrastrukturprobleme, verzögerte Projektfortschritte und letztlich das Scheitern von KI-Initiativen bedeuten. Aus diesem Grund entstand VDBBench, ein Open-Source-Benchmark speziell für Vektordatenbanken, der auf realitätsnahe Testmethoden setzt. Anstatt künstliche Szenarien und veraltete Datensätze zu verwenden, simuliert VDBBench produktionsnahe Arbeitslasten mit kontinuierlicher Datenaufnahme, komplexer Filterung und parallelen Abfragen. So werden Belastungsspitzen, Ausreißer bei Latenzen sowie nachhaltige Verarbeitungskapazitäten sichtbar gemacht – Faktoren, die im echten Betrieb entscheidend sind.

Eine fundamentale Schwäche vieler etablierter Benchmarks ist der Einsatz veralteter und nicht repräsentativer Datensätze wie SIFT oder GloVe. Diese liefern zwar überschaubare Vektoren mit niedriger Dimensionalität, sind aber weit entfernt von den hochdimensionalen Einbettungen moderner KI-Modelle. Aktuelle Embedding-Modelle aus dem Hause OpenAI, Cohere oder udever erzeugen Vektoren mit Größen zwischen 768 und über 3000 Dimensionen, die deutlich komplexere Rechenoperationen erfordern. Auch die Wahl der Metriken wird kritisch hinterfragt. Viele Benchmarks fokussieren sich auf Durchschnittswerte bei Latenz oder maximale Anfragen pro Sekunde (QPS).

Diese sogenannten Vanity Metrics sind oftmals wenig aussagekräftig, da sie weder Spitzenlasten erfassen noch die Nutzererfahrung bei Ausreißern abbilden. In produktiven AI-Anwendungen ist es hingegen essenziell, die sogenannte Tail-Latenz zu kennen – also die Zeiten, in denen 95% oder 99% der Anfragen schneller bedient werden. Nur so lassen sich verlässliche Erwartungen formulieren. Das Szenario, das Benchmarks testen, ist häufig zu einfach gestaltet. Meist wird eine einzige Abfrageart nach vollendetem Datenimport bewertet.

Die Realität in produktiven Vektordatenbanken ist jedoch viel komplexer: Abfragen erfolgen gleichzeitig mit dauerhaften Datenupdates. Anwender filtern innerhalb umfangreicher Korpora und stellen unterschiedlichste, teilweise verschachtelte Selektionsbedingungen. Nur ein Benchmark, der diese vielfältigen Parameter modelliert, gibt ein aussagekräftiges Bild der Leistungsfähigkeit ab. VDBBench greift dieses Problem an und bietet eine Benchmark-Pipeline, die Datensätze moderner KI-Anwendungen verwendet, darunter Wikipedia-Textkorpora, medizinische Fragestellungen (BioASQ), große Web-Sammlungen (C4) und weitere domain-spezifische Daten. Das erlaubt maßgeschneiderte Tests für unterschiedliche Anwendungsfälle von Retrieval-Augmented Generation bis hin zu spezialisierten Wissensdatenbanken.

Neben Datenvielfalt liegt ein weiterer Fokus auf realitätsnaher Leistungsbewertung. VDBBench misst systematische Metriken wie P95- und P99-Latenz unter Serien- und Konkurrentlast. Damit lässt sich nicht nur die maximale Leistung, sondern auch Stabilität und Antwortsicherheit in Spitzenzeiten beurteilen. Ebenso bindet der Benchmark den Recall ein, um zu prüfen, ob Performancegewinn nicht auf Kosten der Ergebnisqualität geht. Die Trennung von Serientests und parallelen Tests spiegelt unterschiedliche Nutzungsmuster wider.

Serielle Abfragen simulieren Szenarien mit geringer Last, zum Beispiel praktisch ungestörte Operationen. Paralleltests erzeugen dagegen gleichzeitige Anfragen, wie sie in stark frequentierten Systemen vorkommen. Durch synchronisierte Starts mehrerer Prozessstränge versucht VDBBench, Rechenressourcenkonflikte und Warteschlangenbildung realistisch abzubilden. Eine Innovation von VDBBench ist die Berücksichtigung von Filteroperationen, die in produktiven Anwendungen unverzichtbar sind. Filterung nach Produktattributen, Metadaten oder anderen Kriterien beeinflusst Abfragezeiten maßgeblich.

Filterselektivität spielt dabei eine große Rolle: Je genauer der Filter, desto kleiner die Datenmenge und desto schneller die Antwort. Gleichzeitig erzeugt eine hohe Komplexität im Filterlogikprozess zusätzlichen Rechenaufwand. VDBBench analysiert diese Mischung ausführlich, was bei vielen früheren Benchmarks schlicht unterging. Doch nicht nur statische Szenarien werden abgebildet – auch Streaming-Tests gehören zum Portfolio. Sie messen die Performance einer Vektordatenbank beim simultanen Einfügen von neuen Daten während laufender Abfragen.

Vor allem bei Echtzeitanwendungen ist dies ein entscheidendes Kriterium, da viele Systeme ohne Pause aktualisierte Informationen handhaben müssen. VDBBench sorgt durch reproduzierbare Belastungen und kontrollierte Einfügegeschwindigkeiten dafür, dass Ergebnisse vergleichbar bleiben. Diese Art von Tests hebt wichtige Aspekte hervor, die klassische Benchmarks ignorieren. Zum Beispiel erfordert die Indexoptimierung oft lange Zeiträume, die Einfluss auf die wahrgenommene Gesamtsystemperformance nehmen. Einige Datenbanken maximieren zwar die langfristige Abfragegeschwindigkeit, büßen dafür aber bei der Zeit bis zum ersten nutzbaren Ergebnis enorm ein.

Gerade in Start- und Updatephasen ist eine schnelle Reaktionsfähigkeit aber unerlässlich. Die Vorteile von realitätsnahen Benchmarks gehen über valide Vergleichbarkeit hinaus. Sie fördern auch die Weiterentwicklung von Vektordatenbanken, indem sie aufdecken, wo Defizite unter Produktionsbedingungen auftreten. So können Entwickler gezielt Optimierungen in Indexaufbau, Speicherverwaltung oder Abfrageverarbeitung vornehmen. Außerdem erhöhen sie das Vertrauen von Unternehmen bei Investitionsentscheidungen.

![Hash Collisions and the Birthday Paradox [video]](/images/107D1194-52B5-40F2-BA92-98373B789CD5)