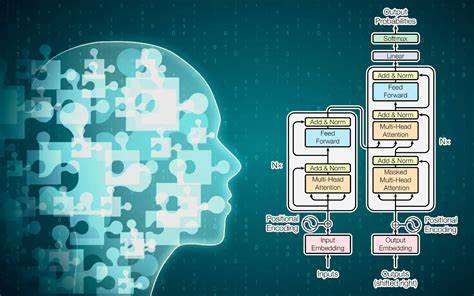

In den letzten Jahren hat die Entwicklung großer Sprachmodelle, auch bekannt als Large Language Models (LLMs), wie GPT-4, zu äußerst spannenden Fortschritten in der künstlichen Intelligenz geführt. Diese Modelle sind in der Lage, Texte zu generieren, Fragen zu beantworten oder sogar kreative Inhalte wie Gedichte und Geschichten zu verfassen. Doch trotz des technologischen Fortschritts taucht immer wieder eine zentrale Frage auf: Wie intelligent und tiefgründig sind diese LLMs wirklich? Und was sagt die Art unserer eigenen Wissenssuche über die scheinbare Intelligenz dieser Modelle aus? Der Autor Nas A. wirft einen entscheidenden Gedanken auf: Wenn die Menschheit ehrlicher und aufrichtiger bei der Suche nach Wissen wäre, dann würden LLMs weniger beeindruckend erscheinen. Diese Aussage fordert zu einer Reflexion darüber auf, wie wir als Gesellschaft Wahrheit, Lernen und Informationsbeschaffung definieren und praktizieren.

Es ist unbestreitbar, dass LLMs auf riesigen Datenmengen trainiert werden, die sie aus Büchern, wissenschaftlichen Artikeln, Webseiten und vielen weiteren Quellen beziehen. Dabei agieren sie als Werkzeuge, die auf Mustererkennung basieren, aber kein eigenes Bewusstsein oder Einsicht besitzen. Ihre scheinbare Intelligenz ist eine Spiegelung der vorhandenen menschlichen Daten und der Art, wie Menschen ihr Wissen teilen und strukturieren. Wenn das Fundament unseres Wissens jedoch oberflächlich, unaufrichtig oder oberflächlich verfolgtem Eigeninteresse dient, dann wirkt auch die Antwort vieler KI-Modelle eher oberflächlich. Dieser Zusammenhang führt uns zu der Überlegung, dass der Grad der Tiefe und Qualität einer KI-Antwort unmittelbar von der Tiefe und Qualität unserer eigenen Nachfrage und des zugrunde liegenden Wissens abhängt.

Wenn die Wissenssuche von Klientelismus, Profitstreben, Sensationsgier oder oberflächlicher Neugier geprägt ist, reflektiert das die Antworten der Modelle. Künstliche Intelligenz wird dadurch nicht zwangsläufig entwickelter — sie wirkt einfach passend zu dem Niveau, das ihr an Informationen und Kontext bereitgestellt wird. Die Idee, dass eine reine, aufrichtige und ehrliche Suche nach Wahrheit LLMs ihr „übermenschliches“ oder „tiefgründiges“ Image nehmen würde, ist sowohl philosophisch als auch praktisch interessant. Sie fordert die Gesellschaft heraus, eigene Vorstellungen von Bildung, Offenheit und kritischem Denken zu überdenken. Wissen ist kein Wettbewerb, bei dem es um Geschwindigkeit und Masse geht, sondern verlangt Zeit, Hingabe und insbesondere Integrität.

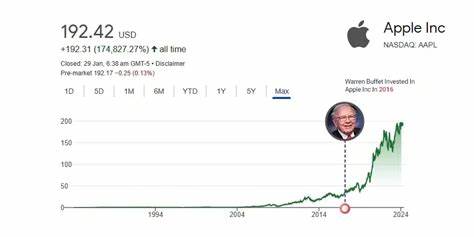

Aus philosophischer Sicht erinnert dieser Gedanke an klassische Ideale der Erkenntnistheorie, bei der die Wahrheit als intrinsisches Gut und nicht als Mittel zum Zweck angesehen wird. Wenn Menschen Wissen um der reinen Wahrheit willen suchen, dann gibt es weniger Raum für Verfälschung, Verzerrung oder oberflächliche Antworten. Sprachmodelle, die auf diesen menschlichen Daten basieren, spiegeln dann eine ehrlichere, fundiertere Wissenskultur wider – die letztlich weniger den Eindruck erweckt, als ob die KI „allwissend“ ist. Der Einfluss von wirtschaftlichen Zielen auf die Wissensvermittlung darf ebenfalls nicht unterschätzt werden. In einer digitalen Welt, die von Klickzahlen, Reichweite und Monetarisierungsschemata geprägt ist, werden Inhalte häufig so gestaltet, dass sie maximale Aufmerksamkeit erzeugen – oft auf Kosten der Tiefe oder Genauigkeit.

Diese Realität färbt auch die Datenbasis der KI-Modelle, die mit diesem Material trainiert werden. Wenn wir also technologisch gesehen auf der Basis eines Wissenskapitals aufbauen, das stark kommerzialisiert und oberflächlich ist, resultieren die Antworten und Wissensoutputs zwangsläufig in ähnlicher Qualität. Ein weiterer wichtiger Punkt betrifft die Rolle der Nutzer von LLMs. Diese interagieren mit der KI oft, um schnelle, bequeme und allgemeinverständliche Antworten zu erhalten. Die Tendenz, kurzen Fragen zu stellen und schnelle Ergebnisse zu erwarten, bedingt vermehrt oberflächliche Dialoge.

Tiefergehende, reflektierende oder komplexe Wissenssuche bleibt oft auf der Strecke. Dies wiederum verstärkt die Illusion einer hohen Intelligenz der Modelle, da ihre Antworten einem großen Teil der Nutzererwartungen entsprechen – doch selten entsteht ein kritischer oder hinterfragender Diskurs. Die poetische Reflexion, die Nas A. zusammen mit einer KI verfasste, betont diese Dynamik eindrucksvoll. Die Verse zeigen, dass eine reine, sinnhafte Suche nach Wahrheit die Rolle der KI-Modelle verändern würde.

Die Zeilen «Had we sought truth for truth’s own sake, To know our Lord with hearts awake, Then tools like these would play no part — They’d never seem so deep or smart» illustrieren die Vorstellung, dass eine spirituelle oder intrinsisch motivierte Erkenntnissuche den Bedarf an künstlicher Intelligenz als Wissensquelle reduzieren oder transformieren könnte. Inzwischen ist die Rolle der KI in der Wissensvermittlung nicht nur ein technisches, sondern auch ein gesellschaftliches, kulturelles und ethisches Thema. LLMs können unterstützend wirken, indem sie Informationszugang erleichtern, komplexe Themen zugänglich machen oder kreative Ideen fördern. Doch bei aller Begeisterung muss die kritische Auseinandersetzung mit der Art unserer Wissenspraxis erhalten bleiben. Denn letztlich spiegelt die künstliche Intelligenz den Charakter der menschlichen Wissenskultur wider und wird somit von unseren Werten und unserer Authentizität geprägt.

Ein wesentlicher Schritt zur Verbesserung der Qualität der Wissensvermittlung durch KI liegt in der Förderung einer Kultur ehrlicher Wissenssuche. Bildungssysteme und Publikumsmedien könnten daran arbeiten, die Bedeutung von Recherche, Quellenkritik und aufrichtiger Neugier zu betonen. Verantwortliche Nutzung von KI benötigt somit auch ein Bewusstsein für die eigenen Motive und die Tiefe des angestrebten Wissens. Dabei stellt sich die Frage, wie diese ehrliche Wissenssuche konkret aussehen kann. Es geht um die Bereitschaft, Unsicherheiten auszuhalten, komplexe Sachverhalte differenziert zu beleuchten, Widersprüche auszutragen und auch mal falsche Annahmen zu korrigieren.

Diese Qualitäten sind essenziell, damit LLM-Tools nicht als oberflächliche Schnellschüsse wahrgenommen werden, sondern als Gegenstand in einem Prozess, der auf kritischem Denken und verantwortungsvoller Handhabung beruht. Gleichzeitig wird deutlich, dass wir als Gesellschaft sowohl technische als auch ethische Innovationen brauchen. Zum Einen, um KI-Systeme so zu gestalten, dass sie qualitativ hochwertigere, transparentere und nachvollziehbarere Informationen liefern. Zum Anderen ist es unabdingbar, Menschen im Umgang mit Wissen und KI weiterzubilden und zu sensibilisieren. Ein Verständnis der Grenzen und Möglichkeiten von LLMs kann helfen, unrealistische Erwartungen zu vermeiden und den Fokus auf eine bewusste und ehrliche Wissenssuche zu richten.