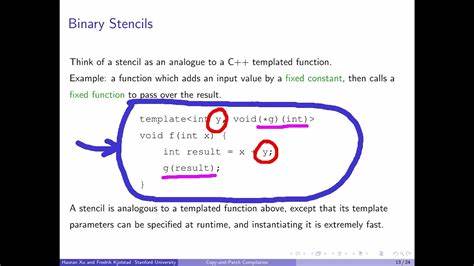

Die Welt der Compilerentwicklung ist ein faszinierendes und zugleich komplexes Feld, in dem sich ständig neue Techniken und Ansätze herausbilden, um den Prozess der Programmübersetzung effizienter, schneller und fehlerfreier zu gestalten. Eine dieser neueren Methoden, die viel Aufmerksamkeit erregt hat, ist die Copy-and-Patch-Compilation. Um diese Technik besser zu verstehen, lohnt es sich, einen genaueren Blick auf ein konkretes, ausgearbeitetes Beispiel zu werfen und die Prinzipien dahinter zu entwirren. Copy-and-Patch-Compilation ist ein innovativer Ansatz, der darauf abzielt, die Codegenerierung in einem Compiler durch die Verwendung vorgefertigter Codeausschnitte – so genannter „Stencils“ – zu beschleunigen und zu optimieren. Dabei wird der Compiler so gestaltet, dass er kleine, hochoptimierte Codefragmente generiert, die mit Platzhaltern (Holes) ausgestattet sind.

Diese werden später zur Kompilierzeit mit den tatsächlich benötigten Werten gefüllt. Durch dieses Verfahren kann man im Grunde genommen wiederverwendbare Codebausteine erzeugen, die flexibel zusammengesetzt und angepasst werden können, ohne den Compiler selbst komplett neu übersetzen zu müssen. Eine der Herausforderungen bei der Implementierung dieser Technik liegt in der Gewährleistung verlässlicher Stellen in den Code-Stencils, an denen die Daten sicher und effizient eingefügt werden können. Eine einfache, aber ineffiziente Möglichkeit wäre es, die Werte über Funktionsaufrufe einzuschleusen, was jedoch zu unnötigem Overhead führt. Stattdessen verfolgt das Copy-and-Patch-Verfahren den etwas raffinierteren Weg, mit externen Variablen zu arbeiten, die vom Compiler als Platzhalter erfasst werden.

Diese Variablen generieren sogenannte Relokationen im Objektfile, die dann während der Codegenerierung durch direkte Werte ersetzt werden können. Auf diese Weise kann ein weiterentwickeltes System entstehen, das nicht auf häufige Speicherzugriffe oder Funktionsaufrufe angewiesen ist, sondern die Daten gezielt und performant in den Code einfügt. Ein weiterer wichtiger Aspekt dieser Methode ist der Einsatz einer ungewöhnlichen Aufruf-Konvention, inspiriert von der Glasgow Haskell Compiler-Konvention (GHC). Die Besonderheit dieses Ansatzes ist, dass keine callee-save Register gepflegt werden müssen. Stattdessen wird als Argument an jede Funktion eine sogenannte Continuation übergeben, also eine Fortsetzungsfunktion, die am Ende der aktuellen Funktion tail-call-optimiert aufgerufen wird.

Dies bedeutet, dass auf Register-Speicherung verzichtet werden kann und stattdessen die Werte direkt in Registern weitergereicht werden. Das Ergebnis ist nicht nur ein schnellerer, sondern auch ein kompakterer Maschinencode mit weniger unnötigen Sprüngen oder Registerbewegungen. Die praktische Umsetzung der Copy-and-Patch-Technik kann durch ein beispielhaftes Projekt verdeutlicht werden, bei dem ein Ausdruck wie a = (b + c + f * g) * (d + 3) evaluiert wird. Zunächst erfolgt eine einfache Tokenisierung und ein simuliertes Parsen, um die Struktur des Ausdrucks als abstrakten Syntaxbaum (AST) darzustellen. Anschließend wird dieser Baum in eine post-order-Traversierung umgewandelt, was bedeutet, dass zunächst die Blätter (also die Operanden) besucht werden, bevor die inneren Knoten (Operationen) abgearbeitet werden.

Für jeden Knoten des Baums wird dann der passende Code-Snippet aus den vorgefertigten Stencils aufgerufen. Die Besonderheit hierbei ist, dass jeder Snippet je nach Anzahl der aktuell gehaltenen Werte auf dem virtuellen Register-Stack mit unterschiedlichen Varianten existiert, gekennzeichnet durch eine Zahl mit Unterstrich im Namen. Diese Zahl bestimmt, wie viele Registerwerte unverändert durchgereicht werden müssen. Durch diese intelligente Verwaltung der Register ist es möglich, dass der Code sehr effizient bleibt und keine unnötigen Zwischenspeicherungen entstehen. Das Endergebnis ist eine präzise Folge von Funktionen wie load und add, die den Ausdruck in gut optimiertem Assemblercode übersetzen.

Durch die Kombination aus tail-call optimierten Continuations, direkter Registerübergabe und durchdachter Relokation der Platzhalter entstehen Maschinencodes, die in ihrer Qualität vergleichbar mit manuell optimiertem Code sind. Dabei bleibt der Aufwand, den Compiler von Grund auf neu zu schreiben oder alle möglichen Kombinationen im Vorfeld per Hand zu kodieren, gering. Ein kritischer Aspekt bei der Verwendung von Copy-and-Patch ist die Handhabung der Adressierung. Viele Compiler, besonders im x86-64-Bereich, gehen davon aus, dass Funktionsaufrufe und Verweise auf eine Adresse innerhalb einer Distanz von zwei Gigabyte liegen müssen. Um dies zu umgehen und die volle 64-Bit-Adressierung erlauben zu können, wird häufig das so genannte medium oder large Memory Model eingesetzt.

Das führt zwar zu etwas mehr Aufwand bei den generierten Befehlen, dafür ist man jedoch nicht auf die 2GB-Begrenzung angewiesen und kann beliebige Adressen als Parameter in die Stencils einschleusen. Darüber hinaus gibt es technische Herausforderungen bei der Verwendung bestimmter C++ oder LLVM-Features. So kann etwa der GHC-Calling-Convention nicht direkt in C-Code spezifiziert werden. Eine praktische Lösung bietet hier der Umweg über das Erzeugen eines LLVM-IR Intermediate Files (.ll), in dem gezielt Annotations und Attribute wie [[musttail]] hinzugefügt werden, bevor der finale Objektcode durch clang kompiliert wird.

Ebenso dient der seltene __vectorcall als Platzhalter im C, um später in der IR-Datei in die ghccc-Calling-Convention umgewandelt zu werden. Trotz aller Vorteile und der scheinbaren Eleganz von Copy-and-Patch-Compilation gibt es offen gebliebene Fragestellungen. Beispielsweise ist die Frage, wann genau Stack-Spills erforderlich werden, also das Zwischenspeichern von Registerinhalten auf den Stack, wenn nicht mehr genügend Register zur Verfügung stehen. Die ursprüngliche Arbeit zu diesem Thema spricht davon, dass bei zu vielen live Werten ein spezieller Permutationsprozess nötig ist, um Varianten ohne Stack-Spills zu erzeugen. Andererseits zeigen Tests, dass moderne Compiler dieses Problem teilweise durch internes Management der Register über Speicher und shuffling lösen.

Dennoch bleibt dieser Aspekt ein aktives Forschungs- und Entwicklungsfeld. Aus praktischer Sicht zeigt sich beim betrachteten Beispielcode, dass die generierte Assemblerausgabe klar, prägnant und ohne überflüssige Sprünge ist. Die Berechnung entspricht in etwa einem optimierten -O0-Level Compileroutput, ist dabei aber wesentlich einfacher automatisierbar und kann für mehr Komplexität skaliert werden. Die Codequalität profitiert von Clangs Fähigkeit zur optimalen Registerauswahl und Instruktionscodierung, während der Copy-and-Patch-Ansatz die Flexibilität und Wiederverwendbarkeit der Codefragmente erhöht. Zukunftsweisend könnte diese Technik durch Erweiterungen der Matching-Strategien weiter verbessert werden.

So stellt sich etwa die Frage, wie sich größere Muster, die komplexere Kontrollstrukturen umfassen – beispielsweise bedingte Anweisungen oder ganze Funktionsblöcke – durch Stencils abdecken lassen. In der Theorie ähnelt dies der Problematik, den längsten passenden Substring in einem Text zu finden, was auf ausgeklügelte Suchalgorithmen hinweist. Eine optimale Implementierung dieses Matching-Prozesses würde den Kompilationsprozess weiter beschleunigen und noch effizientere generierte Codes ermöglichen. Für Entwickler und Compiler-Enthusiasten bietet Copy-and-Patch-Compilation einen faszinierenden Einblick in die Möglichkeiten moderner Low-Level-Optimierungsmethoden. Die Kombination aus bewährten Compilertechniken und unkonventionellen Calling-Conventions schafft ein Arbeitsmodell, das sowohl schnell zu generieren als auch performant in der Ausführung ist.

Gerade im Vergleich zu traditionellen JIT-Compiler-Ansätzen, die oft auf eine Vielzahl von push/pop-Operationen und Funktionsaufrufen setzen, eröffnet Copy-and-Patch eine elegante Alternative ohne den exorbitanten Overhead. Abschließend lässt sich sagen, dass diese Methode einigen der langgehegten Träume von Entwicklergenerationen gerecht werden könnte – nämlich, dass kompakte Compilerprojekte genauso schnell wie frühe Turbo Pascal-Compiler laufen können, aber mit dem Funktionsumfang und Leistungsvermögen moderner Hard- und Software. Auch wenn Copy-and-Patch-Compilation noch nicht breit kommerziell eingesetzt wird und es noch offene Fragen zu klären gibt, stellt sie einen vielversprechenden Schritt in Richtung evolutionärer Compilertechnik mit klaren Vorteilen bei Geschwindigkeit, Anpassbarkeit und Codequalität dar. Die Weiterentwicklung und praktische Erprobung dieses Konzepts kann zukünftig die Art verändern, wie wir Compiler entwerfen und optimieren. Der Einsatz von kleinen, anpassbaren Code-Stencils, kombiniert mit der Tail-Call-Optimierung und differenzierter Registerverwaltung, könnte nicht nur die Kompilierungszeiten senken, sondern auch die Architektur von JITs und interpretierten Sprachen revolutionieren.

So bleibt Copy-and-Patch-Compilation ein spannendes Forschungsgebiet, dessen Potential und Nutzen in der Praxis sicherlich noch vielfach erprobt und diskutiert werden wird.