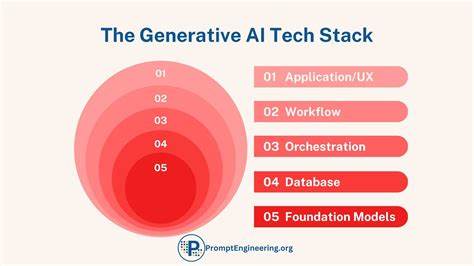

Die rasante Entwicklung der Künstlichen Intelligenz (KI) hat eine neue Fachdisziplin hervorgebracht, die sich zunehmend im Fokus von Unternehmen und Entwicklern befindet: das AI Engineering. Während das maschinelle Lernen bereits seit einigen Jahren etabliert ist, formt sich das AI Engineering als spezialisierter Bereich heraus, der sich vor allem auf die Anwendung und Integration großer KI-Modelle konzentriert. Das Erforschen und Verstehen des AI Engineering Stacks ist dabei entscheidend, um die Komplexität moderner KI-Anwendungen zu meistern und den Herausforderungen der Branche effektiv zu begegnen. Der AI Engineering Stack setzt sich aus drei wesentlichen Schichten zusammen, die gemeinsam das Fundament jeder KI-Anwendung bilden. An der Spitze steht die Anwendungsentwicklung, gefolgt von der Modellentwicklung und abschließend der Infrastruktur.

Diese hierarchische Struktur ermöglicht es Entwicklern, gezielt an den jeweiligen Ebenen zu arbeiten und so optimierte Lösungen zu schaffen. Die Anwendungsentwicklung bildet die Schnittstelle zwischen den KI-Modellen und den Endnutzern. In den letzten Jahren hat sie die größte Innovationsdynamik erfahren, nicht zuletzt durch die Verfügbarkeit von sogenannten Foundation Models, also vortrainierten Basis-KI-Modellen. Der Fokus liegt dabei neben der Gestaltung intuitiver Benutzeroberflächen auf dem sorgfältigen Entwurf von Prompts – also Eingaben, die die KI steuern – und einer rigorosen Evaluierung der KI-Ausgaben. Diese Evaluation ist besonders anspruchsvoll, da KI-Modelle oft offenere, weniger vorhersagbare Antworten generieren als klassische ML-Modelle.

Die richtige Gestaltung der Schnittstellen und des Nutzererlebnisses ist daher maßgeblich für den Erfolg einer KI-Anwendung. Die zweite Schicht, die Modellentwicklung, bleibt das klassische Kerngebiet des Machine Learning Engineerings, erweitert jedoch durch die neuen Anforderungen von Foundation Models. Hier geht es um die Auswahl und Anpassung der Modelle, um das Training und insbesondere das Feintuning vortrainierter Modelle, das Dataset-Engineering und die Optimierung der Inferenz. Während im traditionellen ML häufig Modelle von Grund auf neu erstellt werden mussten, setzt das AI Engineering stark auf die Wiederverwendung und Anpassung bereits trainierter Modelle. Feintuning ermöglicht es, die großen Modelle gezielt auf spezifische Aufgaben zuzuschneiden, was jedoch mehr technisches Know-how und Ressourcen erfordert als die bloße Anpassung über Prompts.

Ein weiterer Aspekt in diesem Bereich ist die Bedeutung von qualitativ hochwertigen und gut annotierten Datensätzen. Da viele Foundation Models mit unstrukturierten Daten arbeiten, ist die Datenaufbereitung komplexer als bisher. Neben der Datensäuberung und -repräsentation gewinnt die Sensitivitätskontrolle an Bedeutung, um beispielsweise unerwünschte, toxische oder vertrauliche Inhalte aus den Daten zu filtern. Daten werden hierbei nicht nur als Trainingsgrundlage gesehen, sondern als ein strategischer Wettbewerbsvorteil, der über den Erfolg spezieller KI-Anwendungen entscheidet. Am unteren Ende des Stacks befindet sich die Infrastruktur.

Trotz der vielen Neuerungen in den oberen Schichten stehen hier bewährte Konzepte wie das Management von Rechenressourcen, das Modell-Serving und das Monitoring im Mittelpunkt. Die Skalierung von KI-Anwendungen erfordert jedoch zunehmend ausgefeiltere Lösungen, vor allem angesichts der enormen Rechenanforderungen großer KI-Modelle. Das effiziente Management von GPU-Clustern, die Optimierung der Antwortzeiten im Nutzererlebnis und die Kosteneffizienz der Bereitstellung sind heute Kernfragen im AI Engineering. Die Abgrenzung zwischen AI Engineering und traditionellem Machine Learning Engineering ist ein weiterer wichtiger Punkt. Während ML Engineering umfangreiche Kenntnisse in Modellarchitekturen, Optimierungsalgorithmen und datengetriebenem Training benötigt, liegt der Schwerpunkt im AI Engineering stärker auf der Anwendung und Anpassung vorhandener Foundation Models.

Insbesondere die Optimierung der Inferenzprozesse und die Evaluierung der Modelle im konkreten Anwendungskontext gewinnen an Bedeutung, da die KI-Modelle verschiedenartig und oft sehr groß sind. Speziell die offene und oft unvorhersehbare Ausgabe von Modellen wie großen Sprachmodellen stellt Entwickler vor bedeutende Herausforderungen hinsichtlich der Bewertung. Anders als bei klassischen ML-Aufgaben, bei denen Ergebnisse vergleichsweise einfach anhand festgelegter Metriken beurteilt werden können, muss im AI Engineering ein tieferes Verständnis für den Einsatzkontext und die Nutzerbedürfnisse aufgebaut werden. Zudem haben sich Anpassungstechniken wie Prompt Engineering etabliert, welche mit wenig Datenaufwand Anpassungen ermöglichen, wohingegen Feintuning mit Modellgewichtsanpassung tiefere und performantere Anpassungen erlaubt. Die veränderten Anforderungen im AI Engineering führen auch zu einer Evolution der Entwicklerrollen.

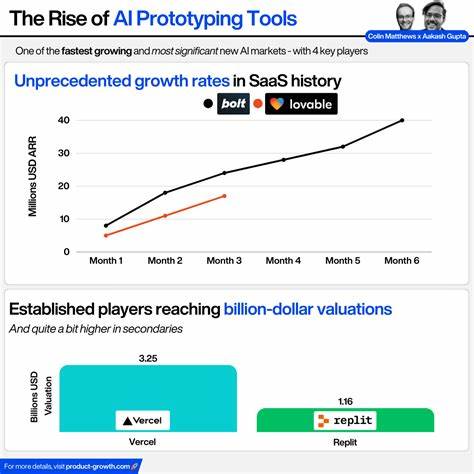

Während traditionell ML-Ingenieure vor allem Python-basiert arbeiteten, treten verstärkt Entwickler mit Full-Stack- oder Web-Entwicklungsfähigkeiten in den Vordergrund. Die Möglichkeit, prototypische Anwendungen schnell zu entwickeln, zu testen und zu iterieren, ist entscheidend, um Innovationszyklen zu verkürzen und sich am Markt zu behaupten. Dieser Wandel zeigt sich auch in der Art der AI-Schnittstellen. Anwendungen sind heute nicht mehr auf spezialisierte Geräte oder Plattformen beschränkt. Vielmehr entstehen vielfältige Interaktionsformen von klassischen Web-Apps über Browsererweiterungen bis hin zu Chatbots in Kommunikationsplattformen wie Slack oder Discord.

Diese Vielfalt stellt hohe Anforderungen an das UI/UX-Design und eröffnet gleichzeitig neue Wege für das Sammeln von Nutzerfeedback. Das Sammeln und die Auswertung von Nutzerfeedback wird durch die neuen AI-Interfaces zugleich leichter und komplexer. Die natürliche Sprachinteraktion erlaubt umfangreiches Feedback in Echtzeit, das jedoch intelligent analysiert und in Verbesserungen der Modelle und Anwendungen übersetzt werden muss. Entsprechend gewinnen Techniken zur automatisierten Auswertung und Integration dieses Feedbacks an Bedeutung. Im Kontext der gesamten Entwicklung von AI Engineering zeigt sich, dass viele bewährte Prinzipien des Machine Learning weiterhin Gültigkeit besitzen.

Beispielsweise bleibt das systematische Experimentieren, etwa durch Anpassung von Parametern oder Vergleich verschiedener Modelle essenziell. Ebenso ist die Verknüpfung von technischen Kennzahlen und geschäftlichen Zielen nach wie vor ein wichtiger Erfolgsfaktor. Dennoch entstehen mit der Verfügbarkeit großer vortrainierter Modelle völlig neue Möglichkeiten und zugleich auch neue Herausforderungen. Neben technischen Fragen wie der Effizienz oder Skalierbarkeit rücken ethische und gesellschaftliche Fragestellungen immer mehr in den Vordergrund. Die Herkunft der Trainingsdaten, mögliche Verzerrungen der Modelle, Datenschutz und die sichere Integration in bestehende Systeme gehören zu den vorrangig zu behandelnden Themen.

Die Zukunft des AI Engineering ist geprägt von einer dynamischen Weiterentwicklung auf vielen Ebenen. Neue Modellarchitekturen, verbesserte Adaptionsmethoden und innovative Interfaces werden die Art und Weise, wie KI in Software integriert wird, weiter verändern. Gleichzeitig steigen die Erwartungen der Nutzer an Qualität, Geschwindigkeit und Zuverlässigkeit von KI-Anwendungen stetig. Das erfordert neben technischem Know-how auch ein tiefes Verständnis von Produktentwicklung und Nutzerverhalten. Das Aufkommen von AI Engineering als eigenständiger Berufsfeld spiegelt die zunehmende Bedeutung und Komplexität dieses Bereichs wider.

Unternehmen investieren gezielt in Fachkräfte, die sowohl technische tiefgehende Kenntnisse mitbringen als auch die Fähigkeit besitzen, KI in konkrete Business-Anwendungen zu überführen. Die Nachfrage übersteigt dabei oft das aktuelle Angebot, was den Fachkräftemangel verstärkt. Um als Entwickler in diesem Bereich erfolgreich zu sein, empfiehlt sich neben der Auseinandersetzung mit den Grundlagen des Machine Learnings vor allem die intensive Beschäftigung mit Foundation Models, deren Adaptionswerkzeugen und den Prinzipien der Anwendungsentwicklung im KI-Kontext. Die Fähigkeit, schnell Prototypen zu entwickeln und iterativ zu verbessern, steht heute im Mittelpunkt. Zusammenfassend ist der AI Engineering Stack ein integratives Modell, das den gesamten Weg vom Modell bis zur Anwendung abdeckt.

Er zeigt, dass erfolgreiche KI-Anwendungen nicht allein von der Modellqualität abhängen, sondern von einem komplexen Zusammenspiel aus Daten, Infrastruktur, Entwicklung und Bedienbarkeit. Das Verständnis dieser Zusammenhänge ist entscheidend, um die Potenziale der Künstlichen Intelligenz nachhaltig zu nutzen. Mit der ständigen Weiterentwicklung der Technologien und Methoden bleibt AI Engineering ein faszinierendes und äußerst dynamisches Gebiet. Für Unternehmen und Entwickler gleichermaßen bietet es die Möglichkeit, an der Spitze der technologischen Innovation zu stehen und die Zukunft der Softwareentwicklung maßgeblich mitzugestalten.