In einer Ära, in der Informationen in rasanter Geschwindigkeit generiert und genutzt werden, stellt die effiziente Verarbeitung großer Datensätze einen entscheidenden Wettbewerbsvorteil dar. Besonders im Unternehmensbereich sind detaillierte und aktuelle Firmendaten von unschätzbarem Wert für Analysten, Investoren und Wirtschaftsexperten. Brasilien, mit seiner Vielzahl an registrierten Unternehmen, stellt hierbei eine einzigartige Gelegenheit dar – sein offenes Firmenregister umfasst riesige Mengen an Daten, die jedoch aufgrund ihrer Größe und Komplexität schwer zugänglich und bearbeitbar sind. Ein innovatives Projekt, das sich zum Ziel gesetzt hat, diese Herausforderung zu bewältigen, zeichnet sich aktuell durch seine modular aufgebaute Pipeline aus, die das 85GB umfassende brasilianische CNPJ-Datenregister effizient verarbeitet und somit wertvolle Daten nutzbar macht. Die zentrale Problematik bei der Nutzung großer Datensätze wie dem brasilianischen Firmenregister liegt in der Datenmenge, die täglich wächst und von herkömmlichen Mitteln oft nicht bewältigt werden kann.

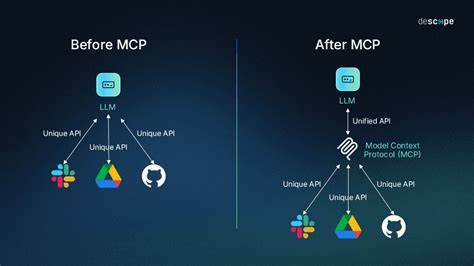

Das brasilianische System umfasst über 60 Millionen Unternehmen und stellt regelmäßige Updates bereit, doch ohne geeignete Werkzeuge wirken diese Rohdaten wie ein undurchdringliches Labyrinth. Genau hier setzt die entwickelte Datenpipeline an: Sie bietet nicht nur einen strukturierten Zugangsweg zu den Daten, sondern optimiert auch Speicher- und Verarbeitungsvorgänge durch intelligente Strategieanpassungen und leistungsfähige bulk-Operationen. Der modulare Aufbau der Pipeline schafft klare Verantwortlichkeiten und ermöglicht gleichzeitig eine flexible Integration unterschiedlicher Datenbanksysteme. Momentan ist PostgreSQL vollständig unterstützt, mit Möglichkeiten, auch andere Systeme wie MySQL, BigQuery oder SQLite einzubinden. Diese Architektur erlaubt es sowohl Entwicklern als auch Data Scientists, maßgeschneiderte Lösungen zu entwickeln, die auf die jeweiligen Anforderungen abgestimmt sind, sei es hinsichtlich Datenvolumen, Verarbeitungszeit oder Ressourcenverfügbarkeit.

Die intelligente Prozessautomatisierung stellt sicher, dass Download- und Verarbeitungsschritte optimal ablaufen. Beispielsweise können Daten parallel heruntergeladen werden, was den Gesamtprozess enorm beschleunigt, ohne dabei die Systemressourcen zu überlasten. Dabei wird stets darauf geachtet, bereits verarbeitete Dateien zu markieren und so doppelte Bearbeitungen zu vermeiden. Dieses Feature ist essenziell, da die Daten monatlich aktualisiert werden und eine effiziente Wiederholung der Pipeline notwendig macht, um immer mit den aktuellsten Informationen zu arbeiten. Neben der technischen Finesse wurde auch auf Benutzerfreundlichkeit großer Wert gelegt.

Ein interaktives Setup sowie die Möglichkeit, die Konfiguration über Umgebungsvariablen zu steuern, erleichtern den Einstieg enorm. Für viele Nutzer ist es zudem praktisch, dass die gesamte Verarbeitung auch mittels Docker-Containern ausgeführt werden kann. Das garantiert eine einfache Bereitstellung, Skalierbarkeit und Plattformunabhängigkeit. Für Forscher und Analysten bietet das Projekt zudem vorgefertigte Datensätze, beispielsweise die komplette Sammlung von Unternehmensdaten aus São Paulo, welche über 3 Millionen aktive Firmen umfasst. Diese Daten können direkt als Parquet-Dateien heruntergeladen und in Python-basierten Analyseumgebungen nahtlos verarbeitet werden.

Die Bereitstellung solcher Exportmöglichkeiten ist ein enormer Mehrwert und erweitert das Anwendungsspektrum enorm, da Anwender so schnell zu verwertbaren Erkenntnissen gelangen und individuelle Auswertungen vornehmen können. Die Performance der Pipeline beeindruckt vor allem durch ihre Skalierbarkeit. Auf einem einfachen VPS mit 4 GB RAM kann die gesamte Pipeline innerhalb von etwa sechs Stunden ablaufen, während leistungsstarke Server mit 16 GB Arbeitsspeicher dies auf rund zwei Stunden reduzieren. High-End-Systeme mit 64 GB RAM oder mehr schaffen die Verarbeitung sogar in circa einer Stunde. Diese Flexibilität ermöglicht es sowohl kleinen Teams als auch großen Unternehmen, das Projekt an ihre Hardwarekapazitäten anzupassen und dennoch effiziente Ergebnisse zu erzielen.

Der Anwendungsbereich ist vielfältig: Von der Marktanalyse über die Erkennung von Branchentrends bis hin zur Prüfung von Geschäftspartnern und Wettbewerbern profitieren unterschiedliche Nutzergruppen von dem einfachen Zugang zu aktuellen Firmendaten. Mit Hilfe der im System integrierten Filtermechanismen lassen sich Daten nach Bundesstaaten, Unternehmensgröße oder Wirtschaftszweigen (CNAE) eingrenzen, was die gezielte Analyse bestimmter Wirtschaftsbereiche erleichtert. Neben den technischen Aspekten zeichnet sich das Projekt auch durch seine hohe Transparenz und die Open-Source-Philosophie aus. Der Quellcode ist öffentlich auf GitHub verfügbar, was eine breite Mitwirkung fördert und die Weiterentwicklung durch die Community ermöglicht. Das stärkt nicht nur das Vertrauen der Anwender, sondern sorgt auch für eine stetige Verbesserung der Pipeline und eine schnelle Anpassung an neue Anforderungen.

Interessant ist zudem der regelmäßige Aktualisierungszyklus: Da das brasilianische Firmenregister monatlich aktualisiert wird, können Nutzer die Pipeline so einzurichten, dass sie automatisiert zum Beispiel über Cron-Jobs an bestimmten Tagen läuft. So wird sichergestellt, dass die verwendeten Unternehmensdaten stets aktuell sind und als Grundlage für fundierte Entscheidungen dienen. Trotz der beeindruckenden Funktionalität sind einige Herausforderungen zu beachten. Große Datenmengen erfordern entsprechend dimensionierte Hardware, insbesondere für Arbeitsspeicher und Festplattenkapazitäten. Zudem sollten Nutzer mit grundlegenden Kenntnissen in Datenverarbeitung und Datenbanken ausgestattet sein, um die Pipeline effektiv einzusetzen und individuell anpassen zu können.

Für viele Unternehmen und Forschungseinrichtungen ist dies jedoch kein Hindernis, denn die Vorteile der automatisierten und effizienten Datenverarbeitung überwiegen klar. Abschließend lässt sich sagen, dass das Projekt zur Verarbeitung des brasilianischen Firmenregisters einen bedeutenden Schritt in Richtung demokratisierter und zugänglicher Unternehmensdaten darstellt. Durch die Verbindung technischer Innovation mit Nutzerorientierung wird die enorme Datenmenge zu einem wertvollen Rohstoff für Wirtschaft, Forschung und Analyse. Wer bisher vor der Komplexität der Daten zurückschreckte, findet hier eine durchdachte Lösung, die den Einstieg vereinfacht und spannende neue Erkenntnisse ermöglicht.