Attention-Mechanismen haben sich in den letzten Jahren als revolutionäre Technologie im Bereich des maschinellen Lernens etabliert. Insbesondere in der natürlichen Sprachverarbeitung, Computer Vision und anderen Bereichen der künstlichen Intelligenz haben sie maßgeblich zum Durchbruch von leistungsfähigen Modellen wie den Transformer-basierten Architekturen beigetragen. Diese Mechanismen ermöglichen es Modellen, relevante Teile einer Eingabesequenz dynamisch zu gewichten, um kontextuelle Beziehungen optimal zu berücksichtigen. Die Implementierung von Attention, insbesondere von Selbstaufmerksamkeit oder Self-Attention, ist dabei ein zentraler Baustein moderner neuronaler Netzwerke. In den folgenden Abschnitten wird die Implementierung von Attention in reiner Python- und Numpy-Syntax detailliert und verständlich erläutert, wodurch ein tieferes Verständnis der zugrundeliegenden mathematischen Konzepte und der Dimensionen gewonnen wird.

Grundlegend basiert die Self-Attention auf einer Eingabesequenz von Token, die in Form einer zweidimensionalen Matrix mit der Form (N, D) vorliegt. Hier steht N für die Anzahl der Tokens in der Sequenz und D für die Tiefe des Embedding, also die Zahl der Merkmale, mit denen jedes Token repräsentiert wird. Klassischerweise kann D Werte wie 512 oder höher annehmen, je nach Modellgröße. Die Aufmerksamkeit wird über drei gewichtete Matrizen realisiert, die jeweils Schlüssel (Keys), Abfragen (Queries) und Werte (Values) transformieren, bezeichnet als Wk, Wq und Wv. In der einfachsten Variante haben alle diese Matrizen die Dimension (D, HS), wobei HS die Größe des einzelnen Attention Heads angibt.

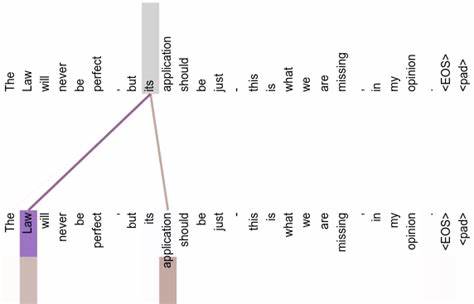

Die Aufmerksamkeit entsteht durch die Berechnung von Abfragen und Schlüsseln, gefolgt von deren Skalarprodukt, das skaliert und anschließend mittels Softmax normalisiert wird, um eine Gewichtungsmatrix zu erhalten. Diese Gewichtungen werden dann auf die Werte angewendet, um den finalen Output der Aufmerksamkeitsschicht zu erhalten. Dieses Prinzip ermöglicht einem Modell, für jedes Token in der Sequenz flexibel zu bestimmen, wie stark es auf andere Tokens Bezug nehmen soll. Die Skalierung des Skalarprodukts mit der Wurzel aus HS ist essenziell, um numerische Instabilitäten bei hohen Dimensionsgrößen zu vermeiden. Für die reibungslose praktische Umsetzung ist dabei eine Softmax-Funktion, die über die letzte Dimension eines Arrays operiert, zentral.

Diese wird typischerweise durch Abziehen des Maximalwerts der jeweiligen Zeile für numerische Stabilität optimiert. Die selbst entwickelte Funktion hierfür kann auf mehrdimensionale Arrays angewandt werden und sorgt dafür, dass die Summe der Werte entlang der Softmax-Achse 1 ergibt. Während die einfachste Form der Self-Attention auf einzelnen Sequenzen ohne Batch-Verarbeitung funktioniert und mit 2D-Arrays umgeht, ist der Einsatz in realen Szenarien meist batching-orientiert. Somit ist der Eingangstensor eine 3D-Matrix der Form (B, N, D), wobei B die Batchgröße darstellt. Die Implementierung skaliert elegant durch effiziente Matrixmultiplikationen mit Numpys Broadcasting-Prinzipien und erfordert nur geringe Anpassungen.

Insbesondere die Transpositionsfunktion wird hier durch das Umsortieren der letzten beiden Achsen ersetzt, um den Batch-Dimensionen Rechnung zu tragen. Der Output bleibt dabei in der Form (B, N, HS). Diese batched Version lässt sich zudem problemlos auch auf einzelne Sequenzen anwenden, sodass eine einheitliche Funktion zur Verfügung steht. Ein großer Fortschritt in der letzten Dekade war die Einführung von Multi-Head-Attention. Während ein einzelner Head nur eine bestimmte Aspekt der Eingabe betrachtet, ermöglichen mehrere parallele Heads eine diversifizierte Betrachtung unterschiedlicher kontextueller Zusammenhänge.

Jeder Head besitzt seine eigenen Parameter, also eigene Wq, Wk und Wv Matrizen. Die Outputs aller Heads werden entlang der letzten Dimension zusammengefügt, wodurch ein Matrix mit der Dimension (B, N, NH * HS) entsteht. Ein abschließender linearer Layer projiziert dieses Ergebnis zurück auf die Ausgangsdimension (B, N, D). Das erlaubt es dem Modell, komplexere und differenziertere Zusammenspiele aus den Eingabedaten zu lernen. Die praktische Umsetzung erfolgt häufig durch eine Schleife über alle Heads oder durch eine hochgradige Parallelisierung, bei der eine zusätzliche Dimension für die Heads eingeführt wird.

Die Maskierung, insbesondere die sogenannte „causale“ oder „masked“ Self-Attention, spielt eine wichtige Rolle in autoregressiven Modellen. Hierbei wird verhindert, dass ein Token auf zukünftige Tokens in der Sequenz zugreift, was im Training zu unerwünschtem „Spicken“ führen könnte. Technisch erfolgt dies durch Multiplikation mit einer unteren Dreiecksmatrix oder durch Setzen der Werte oberhalb der Diagonalen auf negative Unendlichkeit vor der Softmax-Anwendung. Diese Maske sorgt dafür, dass die Aufmerksamkeit sich strikt nur auf vergangene oder aktuelle Tokens fokussiert. Neben Self-Attention gibt es auch Cross-Attention, die häufig im Decoder von Sprachmodellen zum Einsatz kommt.

Hierbei wird eine Sequenz, die die Abfrage bildet, gegen eine andere Sequenz, die Schlüssel und Werte liefert, abgeglichen. Dies ermöglicht beispielsweise, in einem Übersetzungsmodell, dass ein Decoder-Token nicht nur sich selbst, sondern auch auf Encoder-Outputs zugreifen kann. Die Implementierung ist ähnlich der von Self-Attention, jedoch mit unterschiedlichen Sequenzlängen für Queries und Keys/Values. Ein erhebliches Optimierungs- und Effizienzpotenzial liegt in der Vectorisierung des Multi-Head-Ansatzes. Anstatt Listen von Gewichtsmatrizen zu verwenden, werden alle Köpfe in einer einzigen großen Matrix zusammengefasst.

Daraus ergibt sich eine Matrix der Dimension (D, 3 * D), die alle Q-, K- und V-Gewichte gebündelt enthält. Dies erlaubt eine einzelne Matrixmultiplikation, gefolgt von einem Aufteilen in die Teilbereiche. Werden die Tensoren anschließend angemessen umgeformt und transponiert, kann die gesamte Berechnung parallel für alle Heads durchgeführt werden. Dies verkürzt die Laufzeit und spart Speicherzugriffe – bei GPUs oder TPUs ist das ein wesentlicher Vorteil. Solche Implementierungen nutzen häufig Numpys reshape- und transpose-Funktionen, um die Daten effizient umzustrukturieren.

Wer sich über alternatives Notationsverlangen ärgert, findet häufig in wissenschaftlichen Arbeiten die sogenannte Einsum-Notation („einsum“), die komplexe Tensoroperationen kompakt und verständlich ausdrückt. Im Kontext von Attention erleichtert einsum die Umsetzung von Batch-Multiplikationen mit mehreren Dimensionen und sorgt für eine übersichtliche, performante Berechnung. Die Bedeutung von Attention für moderne KI-Modelle liegt nicht nur in der Technik, sondern auch in der Flexibilität und der Fähigkeit, selbst komplexe Abhängigkeiten in Eingabedaten zu erfassen. Die Parallelisierungsmöglichkeiten sowie der modulare Aufbau von Transfomer-Architekturen ermöglichen eine beispiellose Skalierbarkeit. Für Entwickler und Forschende ist das Verstehen und effektive Implementieren von Attention der Schlüssel zu besseren Modellen und neuartigen Ansätzen.

Die vorgestellten Codebeispiele bieten einen praxisnahen Einstieg, der sowohl die Grundlagen als auch fortgeschrittene Varianten wie Maskierung, Multi-Head-Mechanismen und Cross-Attention abdeckt. Dabei steht die Transparenz der Dimensionsveränderungen im Fokus – das ist zentral für Debugging und Erweiterbarkeit. Wer diese Grundlagen gemeistert hat, kann problemlos weitere Features ergänzen, wie zum Beispiel Bias-Terme, Dropout oder Layer-Normalisierung, wie sie in modernen Implementierungen üblich sind. Insgesamt zeigt sich, dass die Implementierung von Attention mit Python und Numpy trotz ihrer mathematischen Komplexität zugänglich bleibt. Durch die klaren Dimensionen und einfache lineare Algebra lassen sich leistungsfähige Mechanismen nicht nur verstehen, sondern auch gezielt anpassen.

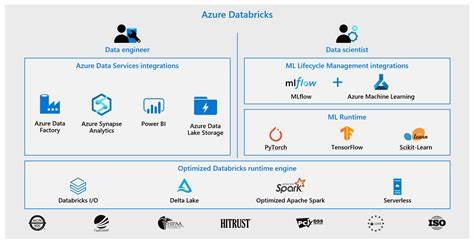

Das ist besonders wertvoll in Forschungsprojekten oder beim Entwickeln maßgeschneiderter Modelle, bei denen Klarheit und Kontrolle vorgefertigter Libraries von Vorteil sind. Für Interessierte empfiehlt es sich, die vorgestellten Konzepte weiter mit echten Daten und in Verbindung mit Deep-Learning-Frameworks wie TensorFlow oder PyTorch zu vertiefen. Hier ergänzen sich die leichte Bedienbarkeit moderner Tools mit dem tiefgreifenden Verständnis der Kernmechanismen, das Numpy-Implementierungen vermitteln.